Recevoir la visite des moteurs de recherche, c'est bien. Pour être sûr qu'ils visitent les bonnes pages, c'est mieux. Certaines bonnes pratiques permettent d’optimiser rapidement ce processus.

Les robots d'exploration n'ont pas une minute à perdre. Sur chaque site, ils visitent non seulement les nouvelles pages mais également des anciennes. Et le passage des robots est essentiel car, explique Alexis Mouton, directeur de la mission SEO de l'agence de référencement Clustaar, "une page qui n'est pas explorée régulièrement n'a aucune chance de se positionner de manière durable". Cependant, les robots consacrent à chaque site un temps limité, appelé "budget d'analyse", lui-même dépendant de la popularité du site. Pas question pour eux, dans ces conditions, de parcourir chaque fois l'intégralité des pages. Voici comment les guider vers les meilleures pages d'un site.

1. Trouver les pages qui gaspillent le budget d'analyse

Parmi toutes les pages explorées par les robots d'exploration sur un site, il faut d'abord identifier celles qui font perdre du temps et affaiblissent les performances du référencement. "La nouvelle console de recherche Google est également un outil d'optimisation du budget d'analyse, car elle fournit de plus en plus d'informations complètes sur l'indexation", explique Alexis Mouton, qui l'utilise quotidiennement pour analyser l'analyse de ses clients. Dans l'onglet "Couverture", Google présente le nombre de pages "exclues", c'est-à-dire explorées et non indexées. Dans le tableau sous ce graphique, les raisons pour lesquelles ces pages sont exclues donnent un premier angle d'analyse et une idée du volume de pages en jeu: balises canoniques manquantes entre deux pages de contenu identique, présence de la balise

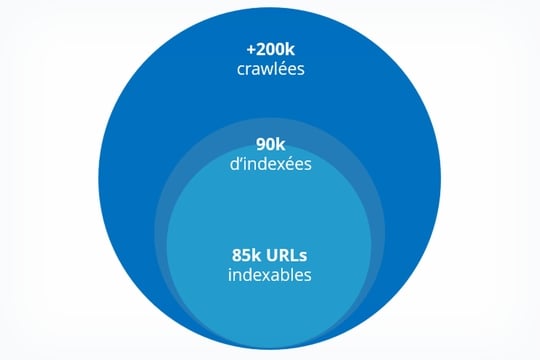

Vous devez consulter l’analyse du journal pour connaître le volume exact du budget d’exploration perdu. Céline Mazouffre, consultante pour l’agence de conseil en stratégie et marketing Resoneo, rappelle que les robots de Google reconnaissent deux signes: l’adresse IP commençant par 66.249 et un agent utilisateur «googlebot». Il est recommandé d'isoler les journaux connectés au moteur de recherche pour observer d'une part le volume de pages explorées, pour le comparer au nombre de pages du site, d'autre part l'importance des pages explorées. Cette analyse permet de savoir quel pourcentage du site est vraiment crawlé, quelles pages clés du référencement ne bénéficient pas des visites des moteurs et de la faute de quelles pages, ce qui ne devrait pas faire perdre du temps aux robots.

Ces informations vous permettent de savoir si l'optimisation de l'analyse doit constituer une priorité pour le site. "L'idéal, rarement atteint, est de faire en sorte que les moteurs parcourent des pages stratégiques à 100%", nuance Céline Mazouffre. "Les seuils nous permettent de définir l’urgence de ce travail: 85% des pages d’exploration sont bonnes, moins de 70% est moyenne et moins de 25%, c’est très mauvais et il faut beaucoup réagir rapidement".

2. Dirigez les robots vers les bonnes pages

Il y a deux façons d'optimiser l'analyse. La première consiste à diriger les robots vers les pages stratégiques pour le référencement. "Les robots des moteurs de recherche doivent accéder aux pages intéressantes en moins de trois clics", explique Céline Mazouffre. "Pour optimiser le nombre de clics, la page d'accueil doit revenir aux pages de catégories et à toutes les pages de produits en moins de deux clics, ce qui est réalisable avec un bon système de pagination dichotomique. Il s’agit donc de réduire le nombre de pages. permettant de faire apparaître certains en masquant les autres de manière dynamique en fonction des clics de l'utilisateur).

Le maillage interne facilite le voyage du robot sur le site. Si une page reçoit plus de liens que d'autres, le robot est plus susceptible de tomber régulièrement dessus. Le référent doit donc s'assurer que les pages vers lesquelles pointent le plus de liens internes sont les pages les plus importantes.

3. Éloignez les robots des pages pour ne pas les indexer

La deuxième façon d'optimiser l'analyse consiste à éloigner les robots des pages non importantes pour le référencement. Le tag

Plus surprenant, la méthode pratiquée par Céline Mazouffre consiste à utiliser des liens en JavaScript vers les pages que les robots ne devraient pas visiter. Les moteurs de recherche ne peuvent pas les suivre s'ils sont intégrés à un événement JavaScript, tel qu'un clic, par exemple. Dans le cas d’une refonte du site, le consultant recommande même de conserver les pages non indexées dans JS dynamique. Pas besoin de les passer en pré-rendu et non seulement ils seront très ergonomiques, mais en plus, avec un maillage adapté, ils ne seront ni explorés, ni indexés. "Cette méthode est très efficace pour compléter un fichier robots.txt", conclut-elle.