La deuxième partie de notre article intitulée «Guide de bonnes pratiques Robots.txt + exemples» explique comment configurer votre nouveau fichier robots.txt.

Si vous ne savez pas comment créer votre propre fichier robots.txt ou si vous ne le connaissez pas, consultez la première partie de cette série d'articles, «Guide de bonnes pratiques Robots.txt + exemples”Où vous pourrez apprendre les tenants et les aboutissants de ce qu’est un fichier robots.txt et comment le configurer correctement. Même si vous êtes dans le jeu de référencement depuis un certain temps, l'article propose un excellent cours de mise à jour.

Comment ajouter un fichier robots.txt sur votre site

Un fichier Robots.txt est généralement stocké à la racine de votre site Web pour le trouver. Par exemple, si votre site était https://www.mysite.com, votre fichier robots.txt se trouverait ici: https://www.mysite.com/robots.txt. En plaçant le fichier dans le dossier principal ou le répertoire racine de votre site, vous pourrez alors contrôler l’exploration de toutes les URL du domaine https://www.mysite.com.

Il est également important de savoir qu'un fichier robots.txt est sensible à la casse. Assurez-vous de nommer le fichier «robots.txt» et non quelque chose comme Robots.txt, ROBOTS.TXT, robots.TXT ou toute autre variante en majuscule.

Pourquoi un fichier robots.txt est important

Un fichier Robots.txt n’est qu’un fichier texte brut, mais ce fichier texte «brut» est extrêmement important car il est utilisé pour permettre aux moteurs de recherche de savoir exactement où ils peuvent et ne peuvent pas aller sur votre site. C'est pourquoi il s'agit d'une partie extrêmement importante de votre site Web.

Une fois que vous avez ajouté votre nouveau fichier robots.txt sur votre site ou que vous apportez simplement des mises à jour à votre fichier robots.txt actuel, il est important de le tester pour vous assurer qu'il fonctionne comme vous le souhaitez.

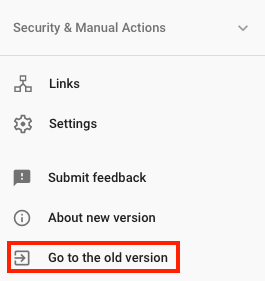

Bien qu'il existe de nombreux sites et différents outils que vous pouvez utiliser pour tester votre fichier robots.txt, vous pouvez toujours utiliser le testeur de fichier robots.txt de Google dans l'ancienne version de Search Console. Connectez-vous simplement au site de votre site. Console de recherche, faites défiler vers le bas de la page et cliquez sur → Aller à l'ancienne version

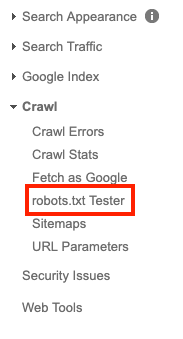

Puis cliquez sur Crawl → testeur robots.txt

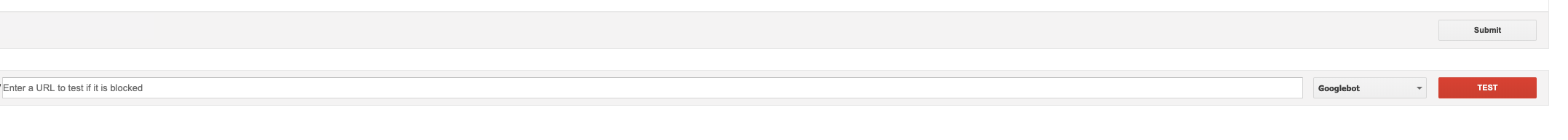

À partir de là, vous pourrez tester le fichier robots.txt de votre site en ajoutant le code de votre fichier à la zone de texte, puis en cliquant sur le bouton "tester".

À partir de là, vous pourrez tester le fichier robots.txt de votre site en ajoutant le code de votre fichier à la zone de texte, puis en cliquant sur le bouton "tester".

Si tout se passe bien, le bouton de test rouge doit maintenant être vert et passer à «Autorisé». Une fois que cela se produit, cela signifie que votre nouveau fichier robots.txt créé ou modifié est valide. Vous pouvez maintenant télécharger votre fichier robots.txt dans le répertoire racine de votre site.

Mise à jour de Google vers les normes de fichier robots.txt à compter du 1er septembre

Google récemment annoncé des modifications sont apportées à la manière dont Google comprend certaines des directives non prises en charge dans votre fichier robots.txt.

À compter du 1er septembre, Google cessera de prendre en charge les règles non prises en charge et non publiées dans le protocole d'exclusion des robots. Cela signifie que Google ne prendra plus en charge les fichiers robots.txt avec la directive noindex indiquée dans le fichier.

Si vous avez utilisé la directive noindex dans votre fichier robots.txt par le passé pour contrôler l'analyse, vous pouvez utiliser un certain nombre d'options alternatives:

Noindex dans les balises Meta des robots: ces deux balises sont prises en charge dans les en-têtes de réponse HTTP et en HTML. Cependant, la directive noindex est le moyen le plus efficace de supprimer les URL de l'index lorsque l'analyse est autorisée.

Codes d'état HTTP 404 et 410

Ces deux codes d'état signifient que la page n'existe pas, ce qui supprime les URL renvoyant ce code à partir de l'index de Google une fois qu'elles ont été analysées et traitées.

Mot de passe de protection

L'ajout d'une protection par mot de passe est un excellent moyen d'empêcher Google de voir et d'explorer entièrement les pages de votre site ou de votre site (en pensant à une version dev du site) Le fait de masquer une page derrière un identifiant le supprimera généralement de l'index de Google, car elle ne le peut pas. pour remplir les informations requises pour avancer pour voir ce qui se cache derrière la connexion. Vous pouvez utiliser le balisage de contenu Abonnement et paywalled pour ce type de contenu, mais c’est un tout autre sujet pour une autre fois.

Interdire dans le fichier robots.txt

Les moteurs de recherche ne peuvent indexer que les pages dont ils ont connaissance (ils peuvent trouver et explorer). Par conséquent, si vous bloquez l’analyse de la page ou des pages, son contenu ne sera généralement pas indexé. Il est important de se rappeler que Google peut toujours trouver et indexer ces pages, en renvoyant d'autres pages vers celles-ci.

Outil de suppression d'URL de la console de recherche

le outil de suppression de console de recherche vous permet de supprimer rapidement et temporairement une URL des résultats de recherche de Google. Nous disons temporairement car cette option n’est valable que pour environ 90 jours. Après cela, votre URL peut à nouveau apparaître dans les résultats de recherche de Google.

Pour que votre déménagement soit permanent, vous devrez suivre les étapes mentionnées ci-dessus.

- Bloquer l'accès au contenu (nécessitant un mot de passe)

- Ajouter une balise META noindex

- Créer un code de statut 404 ou 410 http

Conclusion

Faire de petites modifications peut parfois avoir de grandes répercussions sur le référencement de vos sites. L'utilisation d'un fichier robots.txt est l'une de ces modifications qui peuvent faire toute la différence.

N'oubliez pas que votre fichier robots.txt doit être chargé à la racine de votre site et doit s'appeler «robots.txt» pour pouvoir être trouvé. Ce petit fichier texte est indispensable pour tous les sites Web. Ajouter un fichier robots.txt au dossier racine de votre site est un processus très simple.

J'espère que cet article vous a aidé à apprendre comment ajouter un fichier robots.txt à votre site, ainsi que l'importance d'en avoir un. Si vous souhaitez en savoir plus sur les fichiers robots.txt et que vous ne l’avez pas encore fait, vous pouvez lire la première partie de cette série d’articles "Guide de bonnes pratiques Robots.txt + exemples. "

Quelle est votre expérience dans la création de fichiers robots.txt?

Michael McManus est responsable de la pratique des médias gagnés (SEO) chez iProspect.

Lecture connexe

Un PWA est un site Web compatible avec les appareils mobiles qui se comporte comme une application mais n’a pas besoin d’être téléchargé pour être utilisé. Études de cas de Starbucks et de Forbes incluses.

Qu'est-ce qu'un contenu en double? Quelles mesures pouvez-vous prendre pour vous assurer que cela n'entrave pas vos efforts de référencement? En appuyant sur les questions de SEO répondu.

Si vous vous souciez de savoir où et comment vous apparaissez sur les moteurs de recherche, Google Search Console et ses mises à jour vous intéresseront beaucoup.