Les outils Bing pour les webmasters sont actualisés avec un nouveau design et de nouvelles fonctionnalités

Bing en est aux premières étapes du déploiement d’une version modernisée des outils Bing pour les webmasters.

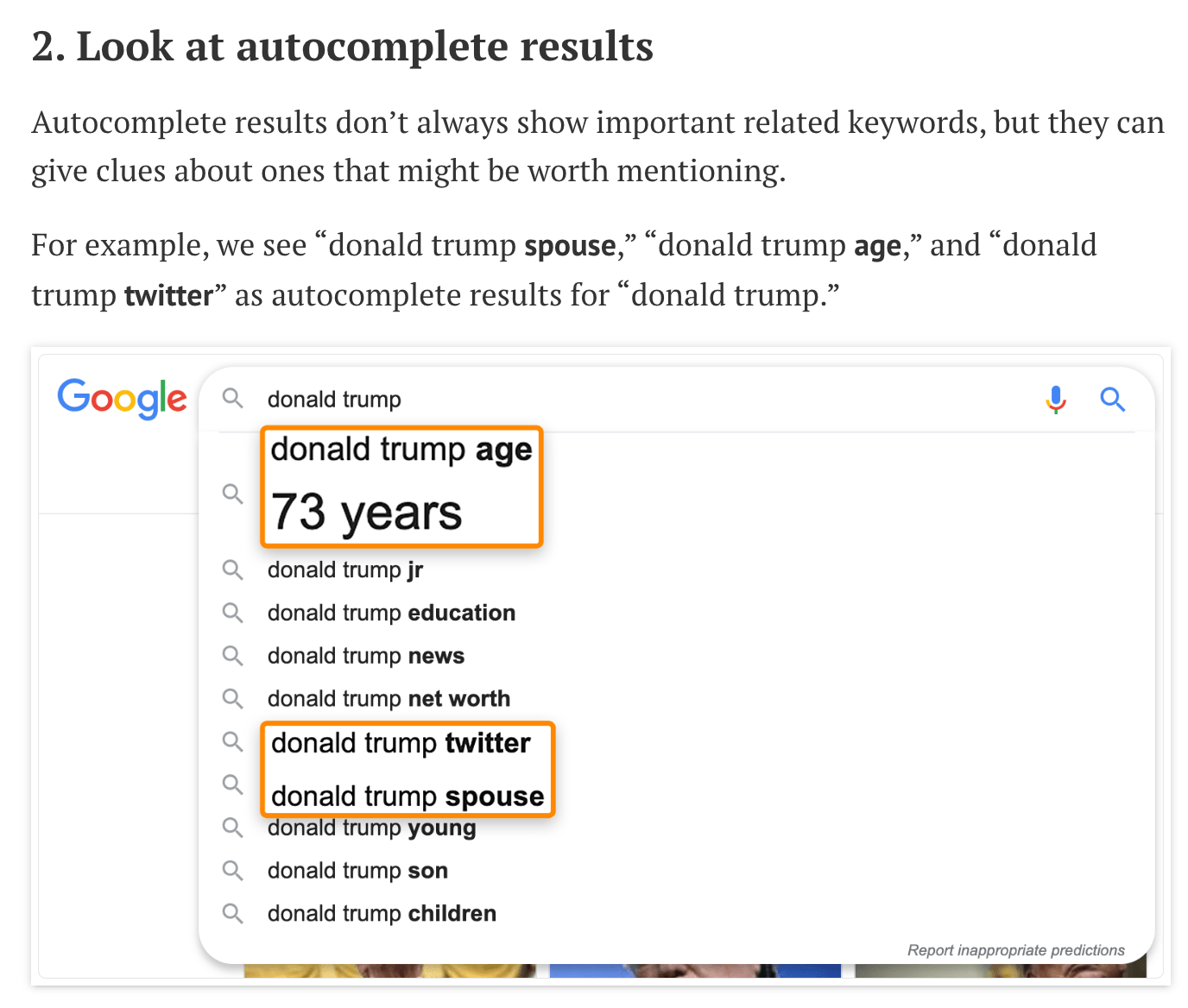

Les premiers outils Bing pour les webmasters seront disponibles pour tous les utilisateurs d’ici la première semaine de mars.

Dans une annonce, la société a déclaré que l’actualisation des outils Bing pour les webmasters répondait aux critiques selon lesquelles l’interface actuelle était «lente et obsolète».

«Au cours des derniers mois, l’écosystème des webmasters a appris que l’interface utilisateur de Bing Webmaster Tools est lente et obsolète. Nous avons pris en compte vos contributions et travaillons à la modernisation des outils. Aujourd’hui, nous sommes ravis d’annoncer la première itération du portail Bing Webmaster Tools actualisé. »

Les nouveaux outils pour les webmasters de Bing offrent une expérience utilisateur repensée qui est compatible avec les appareils mobiles et de bureau. Le magasin de données principal a également été mis à jour pour améliorer la vitesse d’extraction des données.

«Le portail actualisé est en cours de construction avec les principes clés de – garder la conception Nettoyeur et Sensible avec plus rapide et plus Actionnable outils. »

La première version des nouveaux outils pour les webmasters de Bing comprend les 3 fonctionnalités clés suivantes:

- Rapport sur les backlinks: Le rapport actuel sur les liens entrants est en cours d’intégration avec l’outil de désaveu pour créer le nouveau rapport sur les backlinks.

- Performances de recherche: Le rapport sur le trafic de page actuel et les mots clés de recherche sont en cours d’intégration pour créer le nouveau rapport sur les performances de recherche.

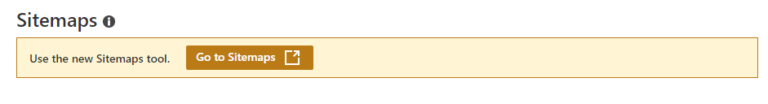

- Sitemaps: Une version actualisée du portail actuel des plans de site.

Au cours des prochains mois, toutes les fonctionnalités des outils Bing pour les webmasters seront déplacées vers la nouvelle version. Les utilisateurs pourront utiliser les deux versions pendant la période de transition.

Les utilisateurs doivent se familiariser avec les outils Bing Webmaster actualisés le plus tôt possible, car les fonctionnalités seront supprimées de la version actuelle dès qu’elles seront déplacées vers la nouvelle version.

La nouvelle version des outils Bing pour les webmasters est accessible en ouvrant les rapports Sitemaps, Liens entrants, Trafic de page ou Mots-clés de recherche et en cliquant sur le lien pour ouvrir le nouveau portail.

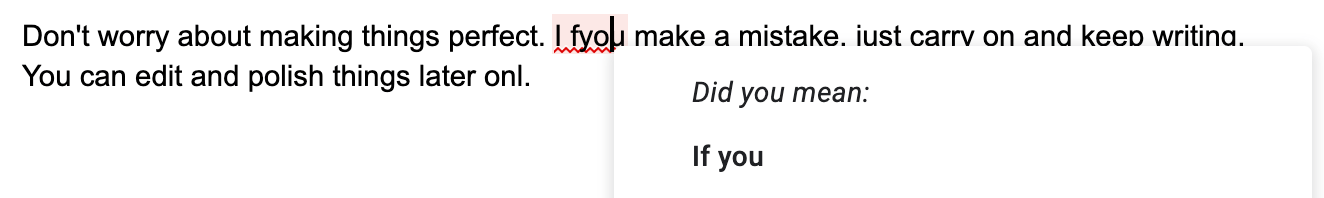

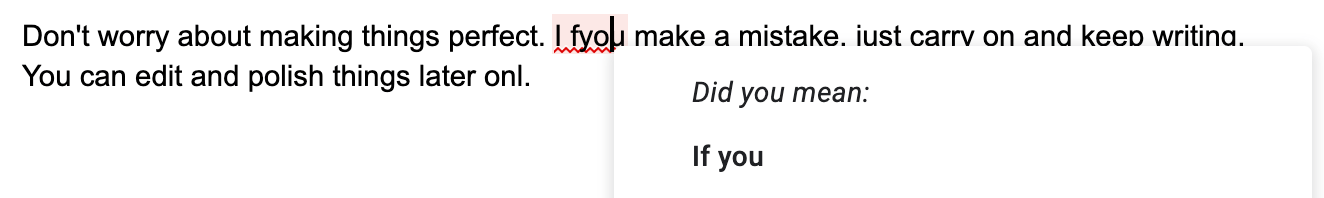

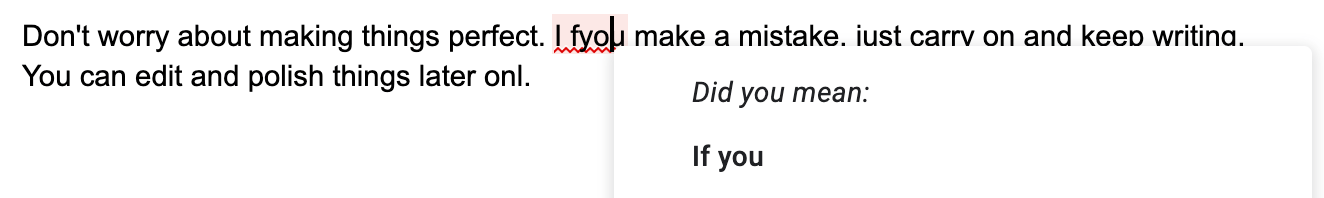

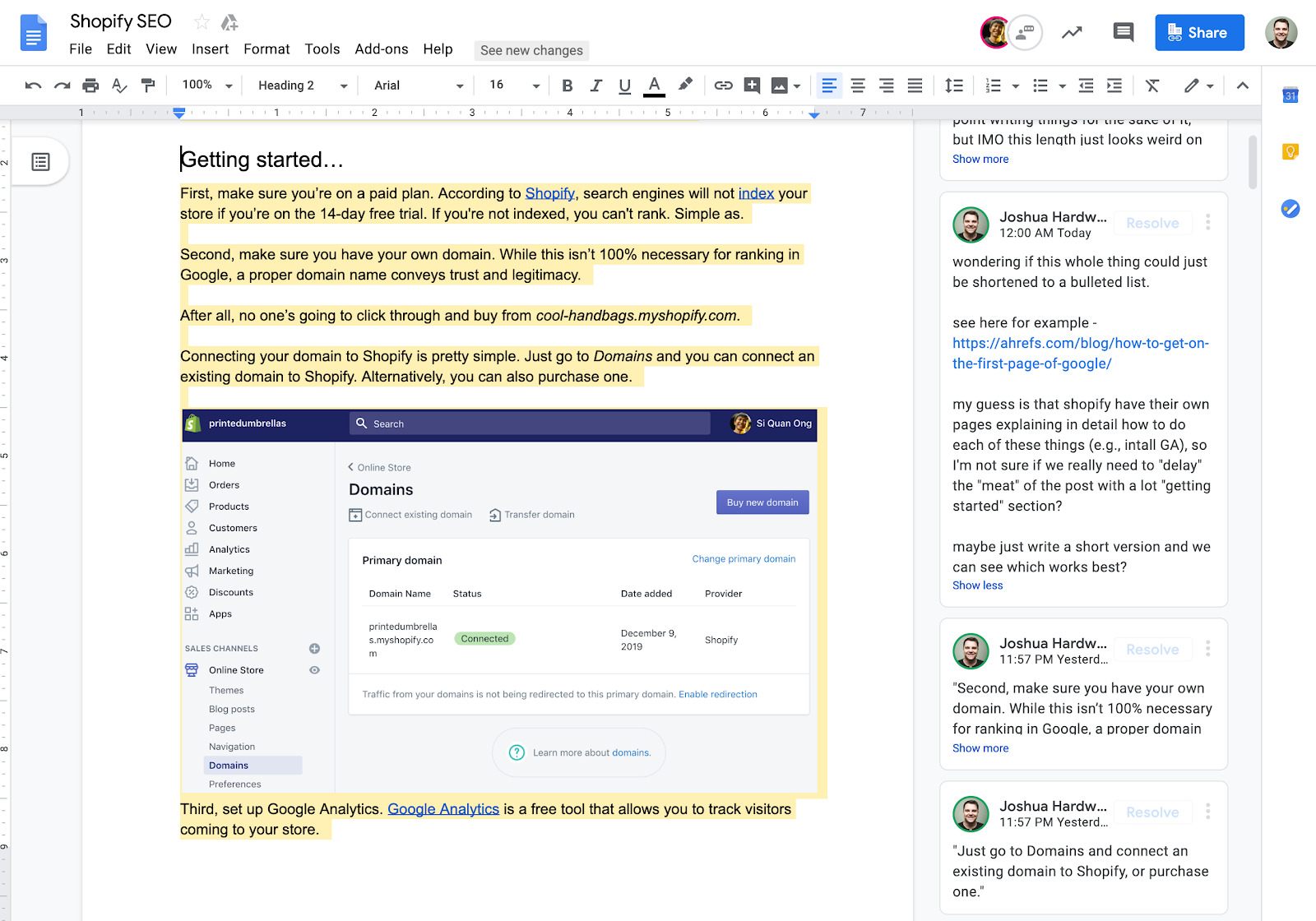

Par exemple, voici à quoi ressemble le lien lorsque vous consultez le rapport sur les sitemaps dans l’interface actuelle:

La source: Bing

6 tactiques SEO universelles • Yoast

Après avoir obtenu sa maîtrise en art et culture visuelle, Melina a travaillé dans le secteur culturel, éditant et écrivant toutes sortes de textes. Elle aime appliquer ses compétences en écriture et son sens du détail dans l’équipe du blog de Yoast.

Les choses bougent toujours dans le monde du référencement. Google met régulièrement à jour son algorithme et la concurrence n’est jamais loin derrière. Donc, si vous n’êtes pas sûr des dernières bonnes pratiques, ne serait-il pas agréable d’avoir une liste d’améliorations SEO intemporelles sur lesquelles se concentrer? Nous pensions que ça pourrait l’être! Armez-vous de ces tactiques SEO intemporelles et vous ne vous tromperez jamais.

1. Restez du côté de la lumière

Si vous cherchez désespérément des résultats rapides, vous pourriez être tenté d’utiliser des tactiques SEO Blackhat. Et bien non! N’achetez jamais de liens, essayez de tromper les moteurs de recherche ou les visiteurs avec des redirections ou des liens de spam sur d’autres sites. Cela peut fonctionner pendant un court moment, mais les moteurs de recherche découragent activement ce genre de chose, donc cela se retourne toujours à la fin et nuit à votre classement. Vous ne voulez pas que ces astuces ou ces liens achetés reviennent vous hanter, n’est-ce pas?

Chez Yoast, nous préconisons le référencement holistique, ce qui signifie que vous devez être le meilleur résultat! Offrez à vos visiteurs un contenu de haute qualité, une expérience utilisateur exceptionnelle et un site Web sécurisé et techniquement supérieur. Cela peut prendre plus de temps et d’efforts, mais c’est beaucoup plus durable à long terme. Prenons l’exemple de la création de liens: abordé de manière holistique, vous produisez un contenu de qualité que les gens vouloir partager. Vous pouvez ensuite contacter les sites Web pertinents pour voir s’ils envisagent de créer un lien vers vous. Les liens que vous obtiendrez de cette façon seront beaucoup plus précieux que n’importe quel lien que vous pouvez acheter. Alors faites un effort supplémentaire et restez du côté léger du référencement. Votre site Web en bénéficiera à long terme.

2. Optimisez la vitesse de votre site

En SEO, plus vite c’est mieux. Nous sommes assez confiants que ce sera toujours le cas, car les gens s’attendent à ce que le contenu leur soit servi rapidement. Personne n’aime attendre, même pendant une fraction de seconde. Il est donc toujours avantageux d’investir du temps pour améliorer la vitesse de votre site.

Il existe plusieurs façons d’accélérer votre site WordPress. Nous ne pouvons pas tous les couvrir dans cet article, mais un bon début est d’installer un plugin de mise en cache. Cela conserve les parties statiques de votre site enregistrées sur votre serveur et sert aux utilisateurs ces pages HTML plus légères au lieu de traiter les scripts PHP WordPress relativement gourmands en ressources. Des plugins de mise en cache gratuits et payants sont disponibles et peuvent accélérer considérablement votre site.

Lire la suite: Améliorer la vitesse du site: outils et suggestions »

Les images sont un autre facteur qui est souvent négligé lorsque les gens créent leur site Web. Les grandes images haute définition prendront beaucoup de temps à charger, tandis que la plupart du temps, une image de résolution inférieure fera l’affaire. Prenez toujours le temps de redimensionner vos images à l’aide d’un plugin d’optimisation d’image.

Et un dernier conseil d’optimisation de la vitesse: si vos visiteurs viennent du monde entier, il peut être utile d’utiliser un CDN (ou Content Delivery Network). Il dirigera les visiteurs vers les serveurs les plus proches de leur emplacement, améliorant ainsi considérablement les temps de chargement.

3. Travailler sur un excellent contenu

Autre astuce SEO intemporelle: ne transigez pas sur la qualité de votre contenu. Créez le contenu de la meilleure qualité possible et examinez-le et améliorez-le de manière cohérente dans la mesure du possible. Le référencement ne consiste pas seulement à améliorer votre site Web, il s’agit également de battre la concurrence. Dans de nombreux cas, cela signifie que le contenu qui est seulement «assez bon» ne suffira tout simplement pas. Vous devez démontrer votre expertise et vous démarquer de la foule. Cela signifie un gros investissement de temps et d’efforts; effectuer des recherches sur votre sujet, votre public et ce qu’il recherche.

Continuez à lire: il ne suffit pas d’écrire du contenu, vous devez publier des ressources »

Il se peut que vous ne puissiez pas toujours le faire immédiatement, c’est pourquoi vous devez continuer à améliorer vos articles, afin qu’ils deviennent des ressources précieuses pour votre public. Comment? Eh bien, tout dépend de votre sujet et de ce que vous essayez de réaliser. C’est toujours une bonne idée de vous demander si votre il vous serait possible de répondre aux questions en visitant vos pages, et si elles correspondent à ce que vous voyez dans les résultats de recherche. Ces prochains conseils vous aideront également à améliorer la qualité globale de votre contenu.

4. Gardez votre public à l’esprit

Que le but de votre site Web soit de vous aider à vendre votre produit ou d’attirer des abonnés pour vos articles de blog, vous ne réussirez que si vous vous concentrez sur ce que votre public veut et a besoin. Cela ne changera pas, car les moteurs de recherche visent toujours à donner aux utilisateurs ce qu’ils recherchent. Cela est évident à partir de l’importance croissante de l’intention de recherche, donc faire de la recherche par mot clé sans d’abord considérer l’intention de recherche n’est plus une option. Offrez-vous vraiment aux internautes ce qu’ils recherchent lorsqu’ils saisissent leur terme de recherche – votre mot clé? Sont-ils à la recherche d’informations ou pour agir, et de quoi ont-ils besoin de vous? Examinez attentivement les résultats de recherche de vos mots clés pour répondre à ces questions.

Il y a une autre raison de vraiment se concentrer sur les besoins de votre public: la compétition pour attirer l’attention des gens est féroce. Les utilisateurs peuvent donc être pointilleux et ils veulent savoir si vous pouvez résoudre leur problème ou ce qu’ils retireront de la lecture de votre blog. Ils ne se soucient pas beaucoup de votre jargon lié au produit, ni pourquoi vous voulez qu’ils lisent votre article de blog. Alors, ne négligez pas le point de vue de votre visiteur dans votre copie SEO. Cela inclut également de ne pas écrire trop de «je» dans votre contenu. Faites-en votre utilisateur, pas vous-même!

Poursuivez votre lecture: engager votre audience en ligne: 8 conseils pratiques »

5. Améliorez votre structure de liaison interne

C’est toujours une bonne idée de permettre aux moteurs de recherche d’explorer facilement votre site afin de déterminer les articles les plus importants et d’aider vos utilisateurs à trouver ce qu’ils recherchent. C’est pourquoi vous ne pouvez pas vous tromper en améliorant votre structure de liens internes. Assurez-vous que vos articles les plus importants contiennent également les liens les plus internes pointant vers eux. Et n’oubliez pas d’ajouter des liens vers vos articles les plus récents, pour éviter le contenu orphelin. Il est essentiel de s’assurer que les liens sont pertinents dans le contexte d’une publication ou qu’ils n’auront de sens ni pour le moteur de recherche ni pour l’utilisateur.

6. Gardez votre contenu bien entretenu

Un dernier conseil SEO intemporel: rester au top de la maintenance de votre contenu est toujours payant. Non seulement vous vous épargnerez l’effort de nettoyer une charge de messages en une seule fois, mais votre contenu restera également frais et pertinent. Les moteurs de recherche et les utilisateurs aiment ça! De plus, le suivi de votre contenu et des sujets qu’il couvre vous permet d’éviter la cannibalisation des mots clés. Et, vous ne voulez pas compromettre vos propres chances de classement en proposant trop de contenu similaire et concurrentiel.

Bien sûr, le nettoyage n’est généralement pas la tâche préférée des gens, c’est donc plus facile à dire qu’à faire. Cela aide à aborder les choses de manière systématique. Effectuez une recherche sur le site pour l’un de vos mots clés les plus importants et voyez ce qui se présente. Les articles se chevauchent-ils et devez-vous tout conserver? Comment fonctionnent les pages? Vous verrez probablement certains articles qui peuvent être supprimés ou fusionnés. Faire cela régulièrement permet de rester au courant des choses.

SEO intemporel: soyez le meilleur résultat!

En fin de compte, ces conseils SEO intemporels se résument à la même chose: si vous voulez classer, vous devez vous efforcer d’être le meilleur résultat. Les moteurs de recherche peuvent changer leurs algorithmes, mais ils veulent finalement offrir à leurs utilisateurs ce qu’ils recherchent: un contenu de haute qualité qui est à jour et diffusé sur un site Web à chargement rapide sans trucs sales. Cela peut sembler beaucoup de travail, mais au moins c’est un objectif clair sur lequel travailler, non? Alors, allons-y!

Continuez à lire: WordPress SEO: le guide définitif »

17 conseils de marketing de contenu exploitables pour plus de trafic

Ceci est une liste de actionnable conseils de marketing de contenu.

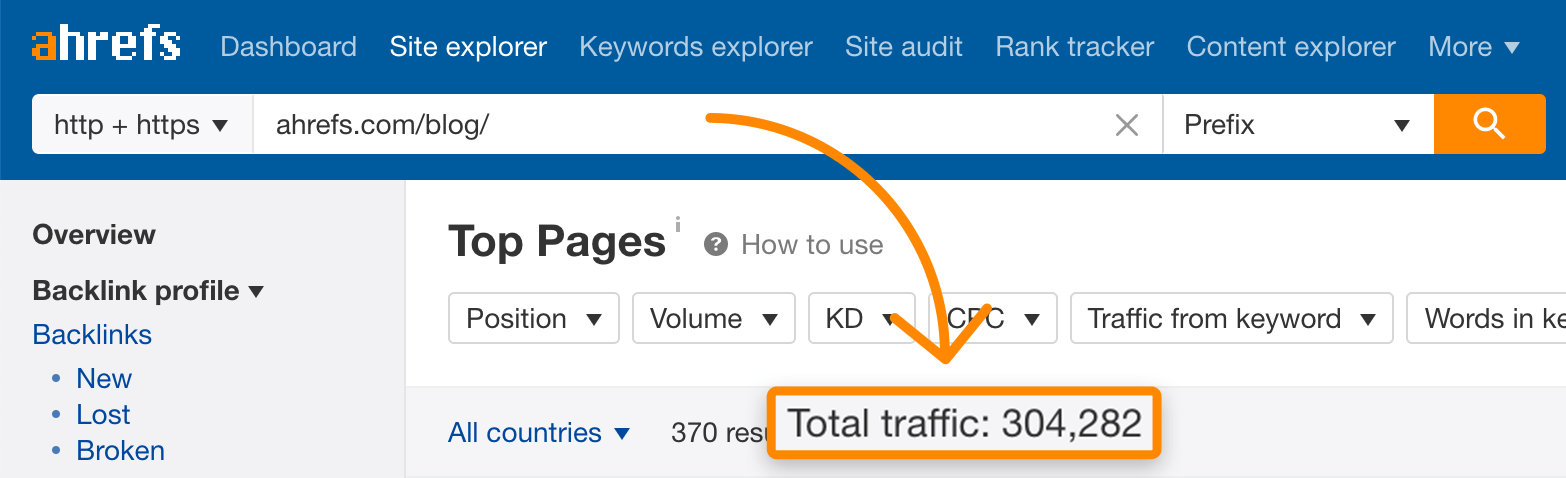

En fait, ces mêmes stratégies ont contribué à faire passer mon blog à 304 265 visites mensuelles:

Donc, si vous voulez plus de trafic pour chaque élément de contenu que vous publiez, vous allez adorer cette liste de conseils, de techniques et de stratégies.

Commençons.

1. Publier des publications «X contre Y»

Les messages «X contre Y» sont des messages comme:

- « Convertkit contre MailChimp »

- « Paleo contre Keto »

- « UberEats vs Postmates »

Et les messages «X contre Y» sont un excellent moyen d’obtenir plus de trafic vers votre site.

Pourquoi?

Premier, Les mots clés X et Y n’ont pas beaucoup de concurrence SEO.

Par exemple, j’ai récemment publié un article optimisé autour du mot clé « Ahrefs vs. SEMRush ».

Effectivement, cette page a basculé au sommet de Google en quelques semaines.

Seconde, les personnes qui recherchent des mots clés « X contre Y » ont tendance à être assez avancées.

Pensez-y de cette façon:

Quelqu’un qui cherche « Ahrefs vs SEMRush » connaît déjà le SEO. Ils recherchent simplement le meilleur outil.

C’est pourquoi les CPC sur les mots clés « X vs Y » ont tendance à être très élevés.

2. Lien vers les profils sociaux dans les e-mails de sensibilisation

C’est un moyen FACILE d’obtenir plus de réponses à vos e-mails de sensibilisation.

Tout ce que vous avez à faire est d’ajouter des liens vers vos profils sociaux dans votre signature.

Sérieusement. C’est ça.

Et il y a des données pour étayer cela.

Quand nous avons fait équipe avec Pitchbox pour analyser plus de 10 millions d’e-mails de sensibilisation, nous avons découvert que les liens de profil social augmentaient les taux de réponse jusqu’à 23,4%.

Nos données ont également montré que l’ajout d’un lien vers votre profil Instagram semble faire la plus grande différence.

Ce qui nous amène à…

3. Utilisez l’outil Animalz Revive

J’ai augmenté mon trafic organique de 260% simplement en mettant à jour et en relançant un ancien poste.

La question est:

Comment savez-vous sur quels postes travailler en premier?

Entrez: Le (gratuit) Outil Animalz Revive.

Cet outil utilise votre Google Analytics pour trouver les pages avec la plus grande baisse de trafic.

Lorsque vous trouvez une page qui tombe, vous avez deux options:

Vous pouvez réorganiser et relancer le post comme s’il était tout nouveau.

Par exemple, nous mettons à jour et relançons notre «Guide du référencement cette année» en novembre de chaque année.

Ou, vous pouvez tranquillement mettre à jour votre contenu. En fait, l’année dernière, nous avons remis à notre guide de publication d’invités une mise à jour indispensable.

Et cette mise à jour unique a augmenté le trafic des moteurs de recherche vers cette page de 17,68%.

4. Essayez la formule PBC

Les introductions de vos articles de blog sont ÉNORMES.

Après tout, ils sont la première chose que les gens voient lorsqu’ils atterrissent sur votre message.

Malheureusement, la plupart des introductions aux articles de blog sont beaucoup trop longues.

Eh bien, j’ai récemment développé une courte formule d’introduction d’articles de blog qui fonctionne à merveille.

Je l’appelle: «La formule PBC».

Voici la ventilation complète.

D’abord, vous rapidement Aperçu de quoi parle votre message.

Ensuite, vous listez un tas de Avantages que quelqu’un obtiendra de la lecture de votre message.

Enfin, couronnez les choses avec un Appel à l’action.

C’est tout ce qu’on peut en dire.

5. Publiez des «Power Posts»

Lorsque nous nous sommes associés à BuzzSumo pour analyser près d’un milliard d’articles, une conclusion s’est démarquée:

Un très petit nombre de «Power Posts» alimentent la majorité du partage social en ligne.

Nos données ont montré que 1,3% des articles publiés sont responsables de 50% des parts des réseaux sociaux.

J’appelle ces articles très performants «Power Posts».

Pour être clair:

Il n’y a pas de formule pour créer du contenu qui sera partagé comme un fou.

(S’il y en avait, tout le monde le ferait 😀)

Mais lorsque vous publiez des Power Posts épiques, vous augmentez les chances que les gens partagent vos contenus.

Par exemple, nous avons récemment publié un Power Post intitulé: «Comment rédiger un article de blog: le guide définitif».

Ce poste a pris 50 heures de travail.

- 20 heures pour rédiger le message

- 15 heures pour concevoir des illustrations et des visuels

- 10 heures pour prendre et modifier des captures d’écran

- 5 heures pour coder et assembler la page

Mais à la fin, ce travail acharné a porté ses fruits.

Notre Power Post a attiré 10 555 visiteurs au cours de la première semaine seulement.

Et une bonne partie de ces visiteurs provenaient de toutes les actions que nous avons obtenues sur Twitter, Facebook et LinkedIn.

En fait, cette seule page a 5369 parts sociales au total.

6. Écrivez sur les sujets tendances

Avouons-le:

La plupart des sujets sont SUPER compétitifs.

Par exemple, prenez un mot-clé super niche comme « check-up du site seo ».

Selon Ahrefs, ce mot-clé n’obtient que 90 recherches par mois.

Et il a un score de difficulté de mot-clé de 86.

C’est la même histoire avec la plupart des sujets de nos jours.

Au moment où vous écrivez un article sur quelque chose, il y a déjà des centaines (voire des milliers) de messages sur ce sujet.

Quelle est la solution?

Écrivez sur des sujets tendances.

Les sujets tendances sont des sujets populaires qui ne sont pas (encore) super compétitifs.

Et si vous voulez trouver des sujets tendances, je vous recommande de consulter un outil gratuit appelé ExplodingTopics.com.

Cet outil répertorie les sujets qui se développent rapidement dans 29 catégories différentes.

De cette façon, vous pouvez vous lancer sur ces sujets avant qu’ils ne décollent vraiment.

7. Inclure du contenu natif avec des partages sociaux

«Partager votre contenu sur les réseaux sociaux» était auparavant une astuce de marketing de contenu utile.

Plus maintenant.

Aujourd’hui, la plupart des algorithmes de médias sociaux (comme Facebook) enterrer les publications qui renvoient les utilisateurs de leur plateforme.

Bien qu’il n’y ait aucun moyen de contourner complètement cela, j’ai récemment trouvé une petite échappatoire qui aide:

Publiez du contenu natif avec votre lien.

Par exemple, mes publications sur les réseaux sociaux n’étaient autrefois que le titre de mon blog et un lien.

Et ces messages seraient enterrés.

Aujourd’hui, j’écris un peu de contenu natif pour accompagner le post.

Ce contenu natif donne aux algorithmes de médias sociaux ce qu’il veut (contenu original et engagement).

Et une fois que le message commence à se répandre sur la plate-forme, vous obtenez ce que vous voulez (plus de trafic vers votre message).

Par exemple, cette publication sur LinkedIn a généré plus de 41 000 vues.

Et cela est principalement dû au fait que la publication n’était pas seulement un lien vers mon site.

Mon message avait un peu de contenu précieux pour accompagner mon lien.

8. Utilisez des poteaux de cadenas

Vous avez peut-être remarqué ces messages grisés dans le fil du blog Backlinko.

En interne, nous appelons ces «postes de cadenas».

Ce sont des articles de blog normaux auxquels seuls les abonnés aux e-mails Backlinko peuvent accéder.

Et lorsque quelqu’un clique sur un message de cadenas, une petite fenêtre apparaît pour demander son e-mail.

Et bien qu’il soit encore tôt, ceux-ci semblent très bien fonctionner.

En fait, ce Padlock Post a attiré jusqu’à présent 1 614 abonnés au courrier électronique.

Pas mal.

9. Inclure un mot-clé dans votre URL

Les URL riches en mots clés ne sont pas uniquement destinées au référencement sur la page.

(Bien qu’ils aident certainement à cela aussi).

En fin de compte, l’inclusion d’un mot clé dans votre URL peut augmenter votre taux de clics organique jusqu’à 45%.

Je dois souligner quelque chose:

Il n’est pas nécessaire que votre URL soit une correspondance 1: 1 pour le mot clé recherché par quelqu’un.

Tant que le texte de votre URL est similaire au mot clé, vous obtiendrez généralement un bon boost CTR.

Par exemple, il y a quelques mois, j’ai publié un article intitulé: «17 façons d’améliorer le classement SEO».

Mon mot clé cible pour ce poste est: « Améliorer les classements SEO ».

Même si mon URL ne contient pas ce terme exact, il est assez proche.

10. Ajoutez plus de coupes à votre contenu vidéo

Les gens veulent des vidéos qui bougent RAPIDEMENT.

C’est quelque chose avec lequel j’ai eu du mal quand j’ai commencé à tourner des vidéos.

Je voulais que mes vidéos soient «naturelles». J’ai donc filmé des vidéos YouTube entières avec seulement une ou deux coupes.

Et cela a fait bouger mes vidéos SUPER lentement. Mes vidéos étaient pleines de « umms », « aaahs » et « you know » qui ont ralenti les choses.

Aujourd’hui, mes vidéos ont 80 à 100 coupes chacune.

De cette façon, chaque vidéo se déplace à un rythme super rapide.

Ce qui aide ma rétention d’audience à rester agréable et élevée.

11. Écrivez des titres plus longs

Vous voulez obtenir plus de partages sociaux de votre contenu?

Essayez d’écrire des titres plus longs.

L’étude BuzzSumo que j’ai mentionnée plus tôt a révélé que des titres plus longs sont fortement corrélés à des niveaux élevés de partage social.

Cela était vrai lorsque nous avons mesuré la longueur du titre en termes de nombre de mots:

Et le nombre de caractères:

Nous avons constaté que les gros titres génèrent en moyenne 76% d’actions en plus vs titres courts.

Par exemple, ce titre de l’un de nos messages est de 15 mots.

Ce qui a peut-être aidé ce poste à accumuler 2036 actions.

12. Optimiser autour de mots-clés inexploités

La plupart des outils de recherche de mots clés ont le même problème:

Ils montrent à tout le monde exactement le même ensemble de mots clés!

Et s’il existait un moyen de trouver des mots clés inexploités que vos concurrents n’ont pas encore trouvés?

Eh bien, il y en a.

Voici comment procéder:

Connectez-vous d’abord à Google Keyword Planner.

Cliquez ensuite sur l’onglet «Commencer par un site Web».

Et accédez à la page d’accueil d’un concurrent…

… Ou un article de blog.

Et l’outil va scanner la page pour trouver des idées de mots clés

Des idées que la plupart des gens ne voient pas.

Très cool.

13. Utiliser des modèles de publication de blog

Les modèles peuvent vraiment vous aider à développer votre marketing de contenu.

Par exemple, chaque fois que je commence un nouveau message, je n’ouvre pas un document Google vierge.

Au lieu de cela, je travaille à partir de l’un de nos modèles de publication de blog éprouvés.

Par exemple, lorsque je m’assois pour écrire une étude de cas, j’utilise ce classeur PDF pour m’aider à obtenir les parties importantes sur papier.

Ensuite, je transfère cela vers un document Google et commence à écrire.

En fait, travailler à partir d’un ensemble de modèles nous a aidés à augmenter notre calendrier de publication. Nous avions l’habitude de publier un nouveau message une fois par mois. Maintenant, nous publions un nouveau message toutes les 2 semaines.

14. Utilisez des titres émotionnels

Selon notre analyse de 5 millions de résultats de recherche Google, les titres qui ont du punch émotionnel obtiennent plus de clics.

Cela dit:

Il est possible que vos titres soient TROP émotionnels.

Cette même étude a révélé que les titres avec « Power Words » avaient un inférieur CTR.

Je recommande donc d’utiliser des titres qui ont un certain sentiment émotionnel. Mais si vous allez trop loin, votre CTR peut commencer à souffrir.

Par exemple, ce titre est émotionnel. Mais ce n’est pas «clickbaity».

15. Optimiser autour des mots clés de la marque

Les «mots clés de la marque» sont exactement comme ils sonnent:

Ce sont des mots clés optimisés autour marques et produits.

Voici un exemple de l’un de nos articles optimisé autour d’un mot clé de marque.

Alors: pourquoi optimiser le contenu de votre blog autour des mots clés de marque?

Parce qu’ils ne sont généralement PAS compétitifs.

Par exemple, prenez un mot-clé comme «BuzzSumo».

Selon Ahrefs, ce mot-clé fait 49 000 recherches par mois. Et il a aussi un CPC décent.

Malgré ces chiffres impressionnants, la difficulté du mot clé sur ce terme est seulement 13.

L’inconvénient des mots clés de marque est que vous ne serez jamais classé n ° 1 sur Google pour ce terme.

Et selon les SERPs pour ce mot-clé de marque, vous ne pourrez peut-être pas casser le top 3.

Par exemple, nous avons publié ce guide sur la Google Search Console l’année dernière.

Et étant donné que les 5 premiers résultats sont toutes des pages Google.com, le n ° 6 est à peu près aussi élevé que cette page ne se classera jamais.

Malgré cela, ce message attire toujours 1 126 visiteurs par mois de Google.

16. Racontez des histoires pertinentes dans les vidéos YouTube

L’un des points forts de YouTube est qu’il s’agit d’un média très personnel.

Contrairement à un article de blog, quelqu’un vous regarde réellement livrer votre message.

Ce qui en fait l’endroit idéal pour baisser la garde. Et révélez quelques détails personnels sur vous-même.

Par exemple, j’essaie d’inclure une petite histoire de 30 à 60 secondes dans chacune de mes vidéos YouTube.

La plupart de ces histoires racontent comment je me suis initialement débattu avec le sujet que je couvre dans cette vidéo.

De cette façon, je ne viens pas comme certains le savent.

Cela montre que, comme tout le monde, j’ai dû apprendre des choses par essais et erreurs.

Tant que ces histoires sont courtes et se rapportent à votre sujet, vous constaterez que votre public les appréciera.

17. Écrivez des descriptions méta convaincantes

Non, Google n’utilise pas la balise meta description pour comprendre le contenu de votre page.

Mais les utilisateurs utilisent votre description pour déterminer le résultat sur lequel cliquer.

Maintenant:

La copie dans votre balise META dépendra beaucoup de la page.

Mais voici un modèle qui a tendance à bien fonctionner:

Et voici un exemple de ce modèle en action.

Bonus n ° 1: inversez l’ingénierie de vos concurrents

Il y a une place pour l’originalité.

Et la pensée créative.

Mais il y a aussi une place pour copier directement ce que font vos concurrents.

Et vous n’avez pas besoin non plus de leur mot de passe Google Analytics.

En fait, il existe de nombreux outils de marketing de contenu impressionnants qui vous montreront ce qui fonctionne déjà pour quelqu’un d’autre.

Si votre objectif principal est de créer des liens, Détaillé.com vous montre d’où proviennent les meilleurs blogs de presque tous les créneaux.

Et si vous souhaitez voir le contenu le plus partagé d’un site spécifique, BuzzSumo est l’outil qu’il vous faut.

Ou peut-être que vous voulez voir les pages d’un site qui génèrent le plus de trafic organique. Eh bien, Ahrefs peut vous connecter avec cette information.

Bonus # 2: Créer des pages de statistiques

Les pages de statistiques sont un excellent moyen de créer des backlinks sans avoir besoin de faire beaucoup de sensibilisation.

Voici pourquoi:

Les pages de statistiques sont optimisées autour de « [Topic] + Mots clés « Statistiques ».

Et qui a tendance à rechercher « [Topic] + Statistiques « Stats »?

C’est vrai: blogueurs et journalistes!

Et lorsqu’ils utilisent l’une de vos statistiques dans leur article, ils renvoient généralement vers votre page de statistiques.

Par exemple, nous avons publié cette liste de statistiques de marketing par e-mail il y a quelques mois.

Et il a rapidement atteint la première page des mots clés recherchés par les blogueurs et les journalistes (comme «statistiques de marketing par e-mail»).

Ce qui l’a aidé à trouver des liens solides, comme celui-ci:

Agréable.

Qu’est-ce que tu penses?

Maintenant, je voudrais vous remettre les choses:

Quel conseil de marketing de contenu de cette liste était votre préféré?

Ou peut-être avez-vous une astuce que je n’ai pas couverte ici.

Quoi qu’il en soit, faites le moi savoir et laissez un commentaire ci-dessous.

Qu’est-ce que le contenu SEO? Comment écrire du contenu qui se classe

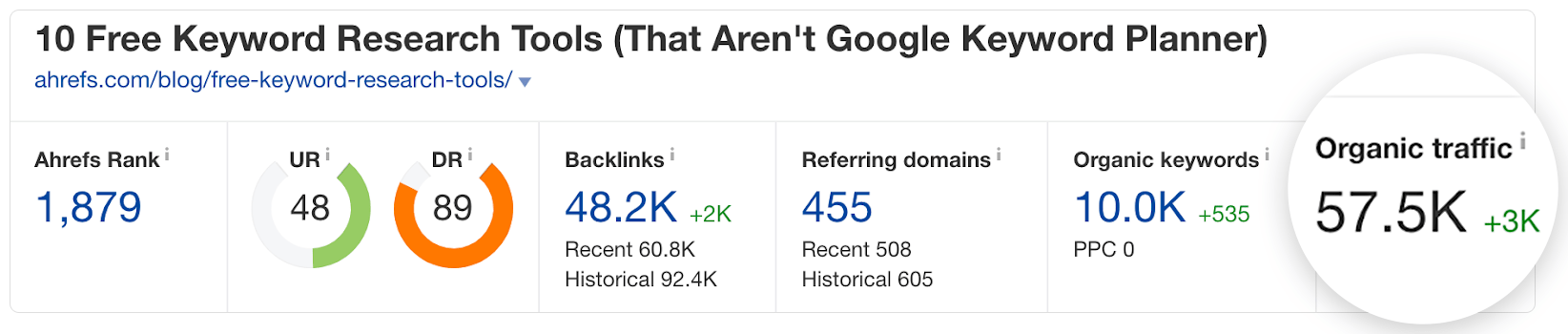

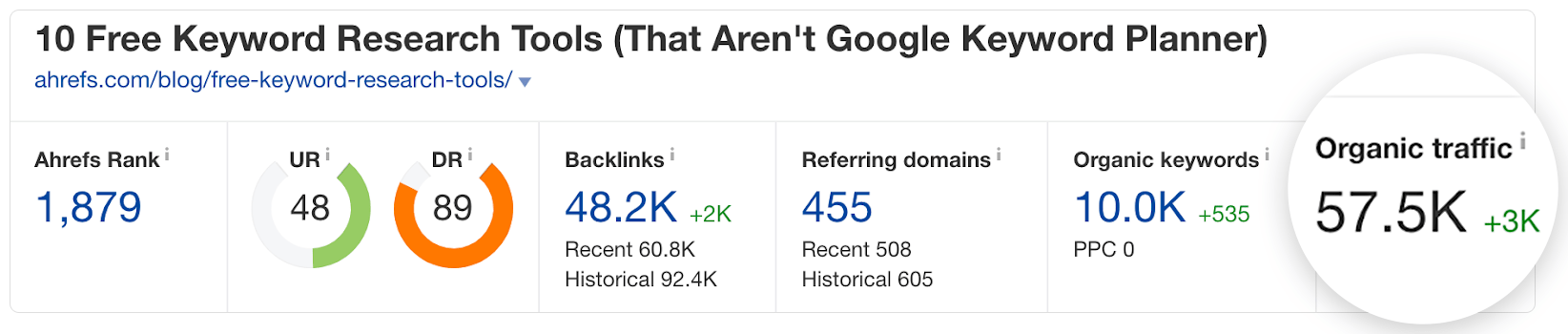

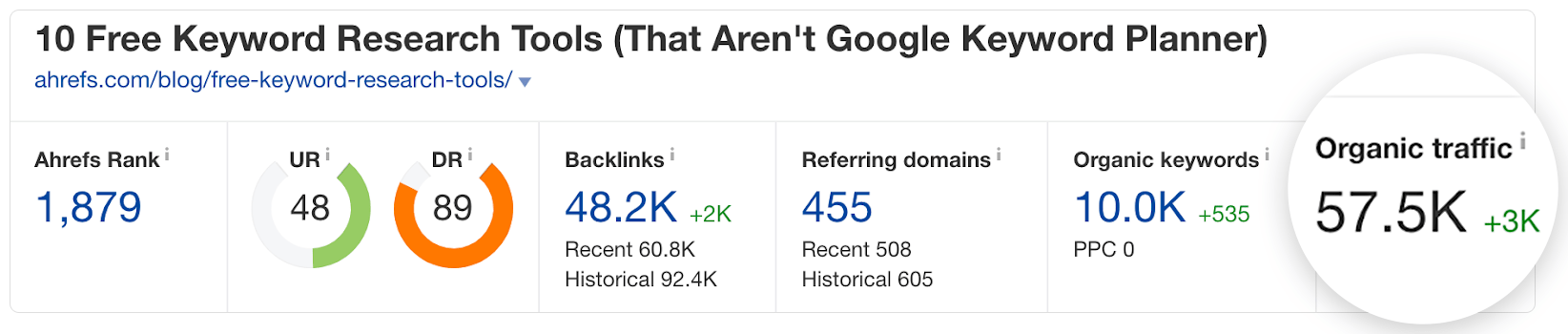

Au cours des 12 derniers mois, nous avons publié 79 pièces de « SEO contenu »sur le blog Ahrefs. 96% d’entre eux se classent dans Google et obtiennent du trafic organique mois après mois.

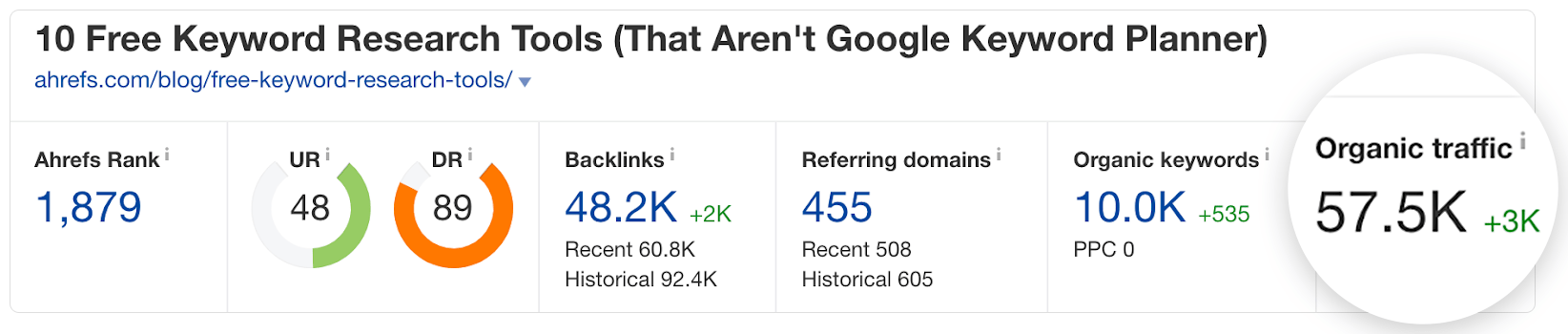

Un article se classe même pour 10 000 mots clés et obtient plus de 57 000 visites organiques mensuelles:

Comment avons-nous fait cela? En adoptant une approche SEO de notre contenu.

Dans ce guide, nous allons parcourir le processus en 8 étapes que nous utilisons pour écrire du contenu classé.

Mais d’abord, les bases…

SEO le contenu est, tout simplement, un contenu conçu pour être classé dans les moteurs de recherche comme Google.

Vous pourriez penser que tout le contenu est SEO contenu, mais ce n’est pas le cas. Par exemple, nous avons beaucoup d’études sur notre blog, et la plupart d’entre eux obtiennent peu ou pas de trafic organique.

Est-ce à dire que ces messages ont échoué?

Pas du tout. Nous avons publié ces articles pour apporter de nouvelles perspectives au SEO communauté — ne pas se classer dans Google.

Il est également important de noter que tout type de contenu peut être « SEO contenu »: pages produits, pages de destination, outils interactifs et même vidéos. Mais quand la plupart des gens parlent de « SEO contenu « , ils parlent de billets de blog.

C’est pour cette raison que nous allons nous concentrer sur ce guide.

Mais avant de parler de la façon d’écrire des messages de ce rang, assurez-vous de comprendre pourquoi ce type de SEO le contenu compte.

Peu importe ce que fait votre entreprise, vous ne pouvez générer qu’un trafic organique important vers vos «pages d’argent».

Par exemple, nous avons cinq pages de destination, une pour chacune de nos principales SEO outils:

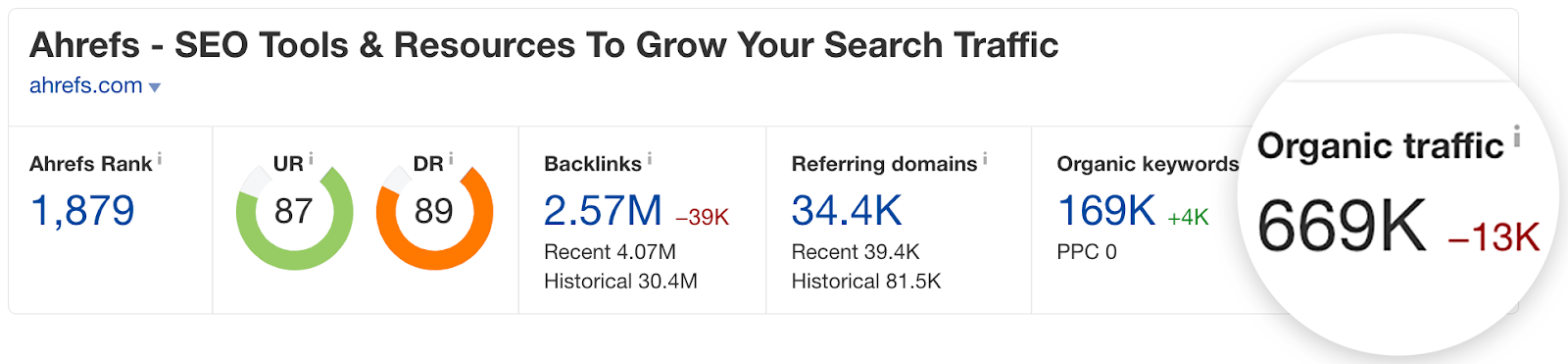

Au total, ces pages reçoivent environ 25 000 visites mensuelles grâce à la recherche naturelle, et nous nous classons parmi les cinq premiers pour tous nos principaux mots clés:

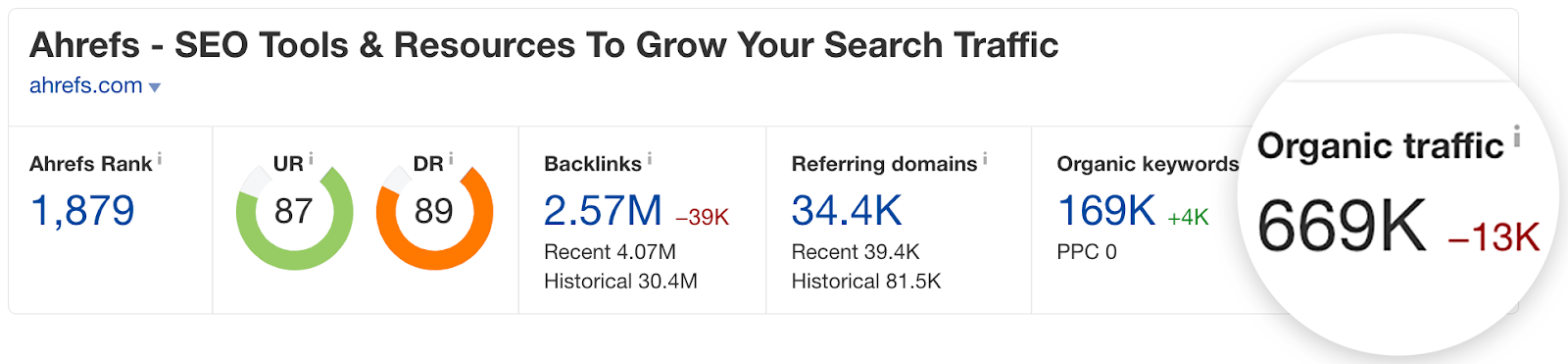

Mais, ces pages représentent moins de 4% du trafic de recherche sur notre site:

Nous recevons actuellement environ 669 000 visites organiques mensuelles sur notre site Web, dont le trafic vers nos pages de destination ne représente que ~ 4%.

Comment? Parce que nous avons également écrit des centaines de morceaux de SEO contenu pour notre blog.

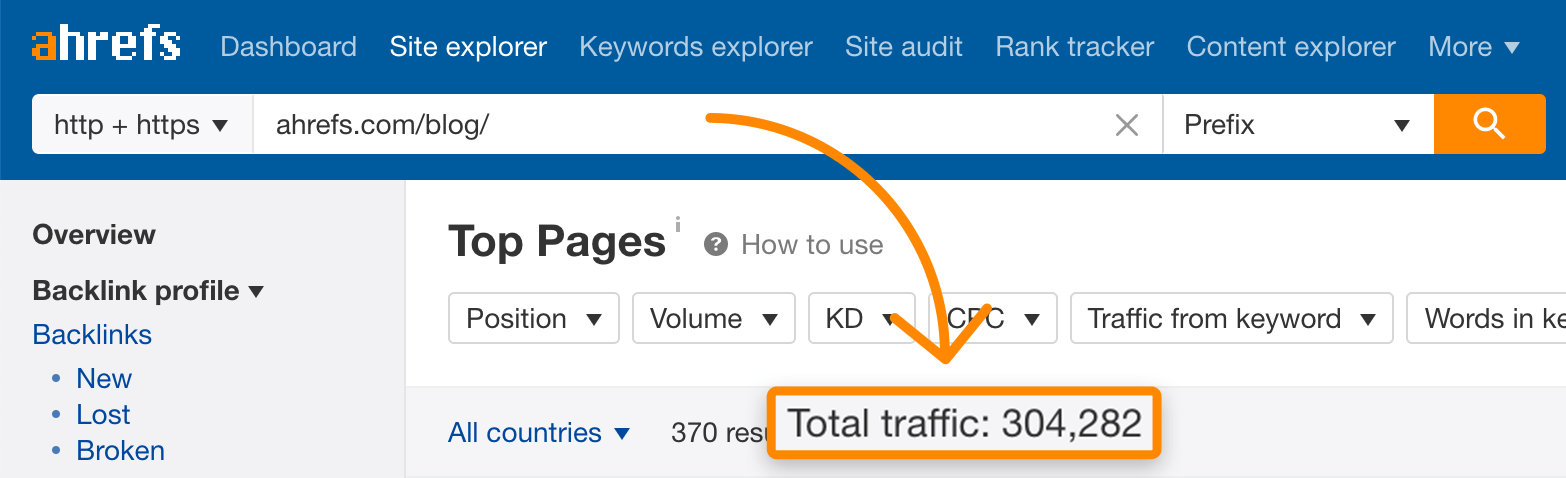

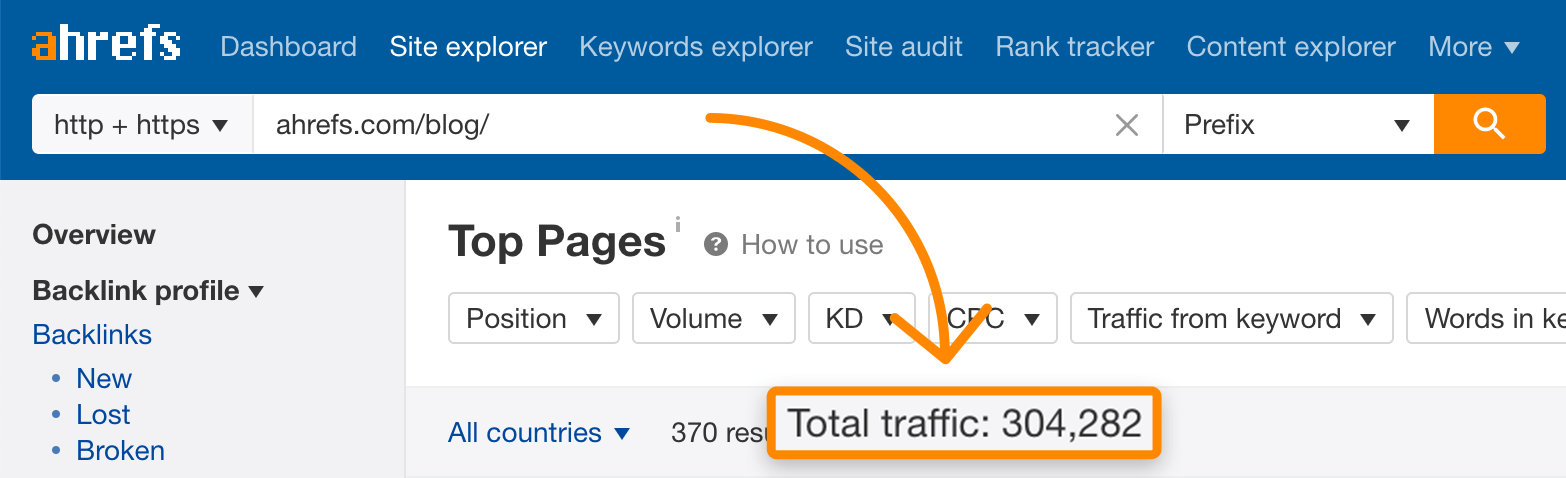

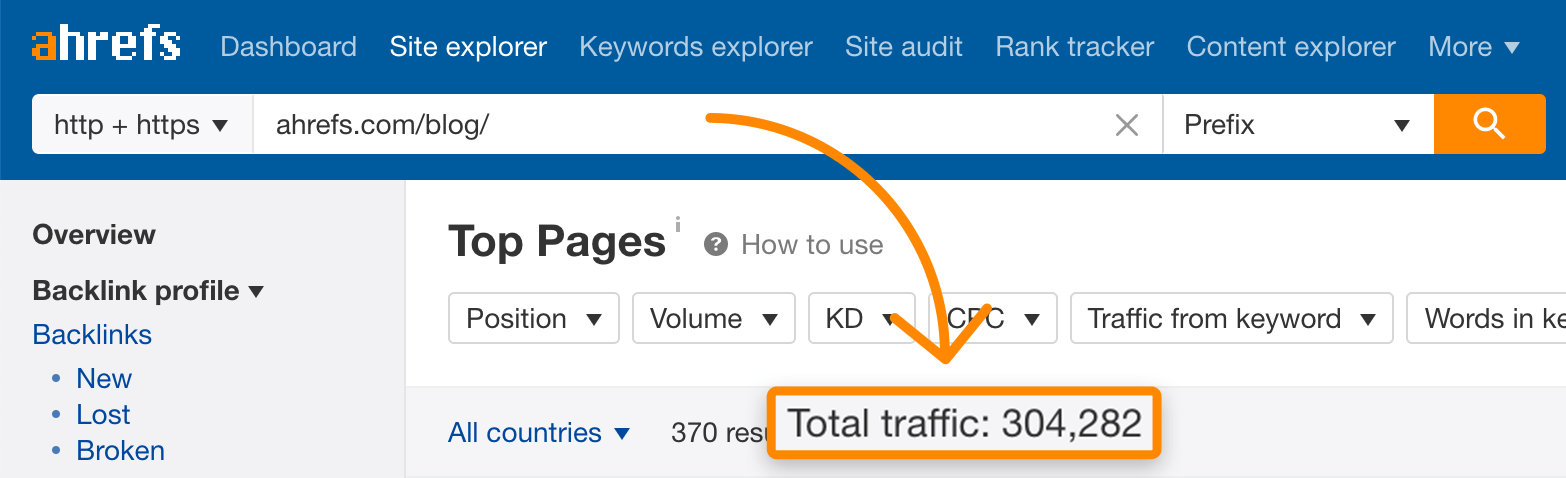

Au total, ces publications reçoivent plus de 300 000 visites mensuelles uniquement grâce à la recherche organique:

Si nous ne le faisions pas, nous laisserions beaucoup d’argent sur la table parce que les clients potentiels ne recherchent pas toujours directement nos produits.

Beaucoup recherchent simplement une solution à un problème que nos outils peuvent résoudre.

Par exemple, nous avons un outil de recherche compétitif appelé Site Explorer. Il permet notamment de voir qui établit un lien vers un site Web ou une page Web.

Mais les clients potentiels ne savent peut-être pas que nous proposons ce produit et recherchent plutôt quelque chose comme «qui établit un lien vers mon site Web».

Nous avons donc décidé d’écrire un blog à ce sujet:

L’écriture « SEO contenu « comme celui-ci est important car il attire plus de clients potentiels sur notre site.

Ça a du sens?

Bien. Maintenant, parlons de la façon d’écrire ces trucs.

Tous les articles de blog ne sont pas SEO contenu, et le fait de consacrer votre cœur et votre âme à votre contenu ne garantit pas le classement et le trafic.

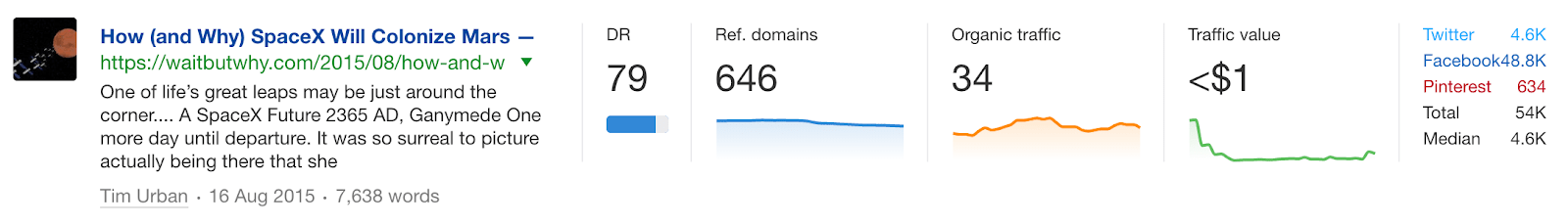

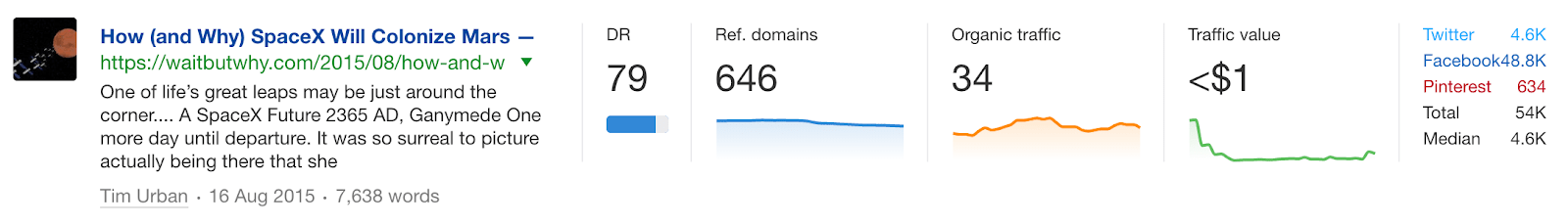

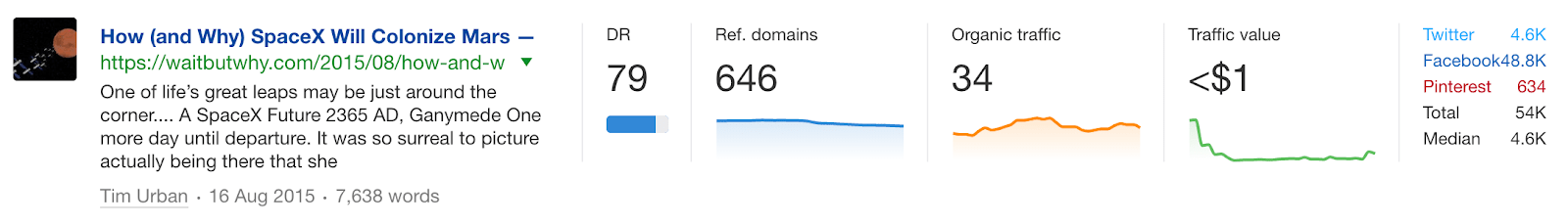

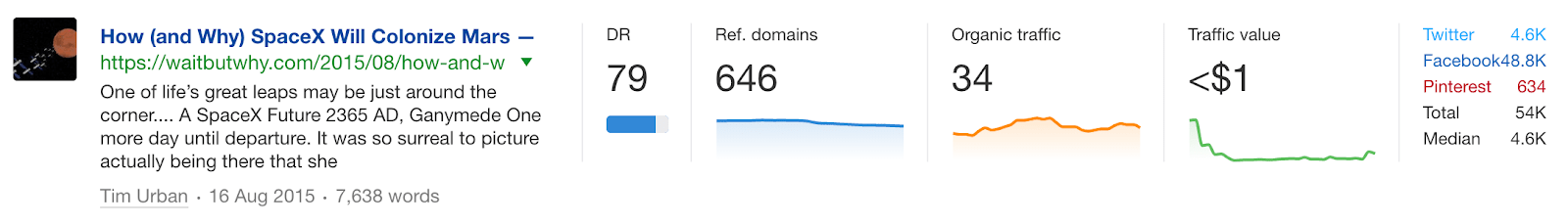

Regardez simplement les statistiques de l’un de mes articles de blog préférés:

Il fait 7 600 mots, a été partagé plus de 50 000 fois, a des illustrations fantastiques et est très bien écrit. C’est un chef-d’œuvre.

Mais regardez à nouveau le trafic généré par les moteurs de recherche:

34. Mesquin. Visites. Un mois.

Donc, si vous voulez que votre publication génère du trafic organique, vous devez l’écrire autour d’un SEO cadre.

Quel est ce cadre? Cela ressemble à ceci:

- Trouver un sujet éprouvé

- Analyser l’intention de recherche

- Écrivez un plan

- Rédiger un brouillon

- Modifier votre brouillon

- Rendez votre contenu visuellement attrayant

- Rédigez un titre et une description convaincants

- Téléchargez votre message

Passons en revue chacune de ces étapes plus en détail.

1. Trouvez un sujet éprouvé

Avant même de penser à mettre du stylo sur papier, vous devez trouver un sujet pertinent avec un «potentiel de trafic».

Pour ce faire, réfléchissez aux grands sujets que vos clients potentiels pourraient rechercher.

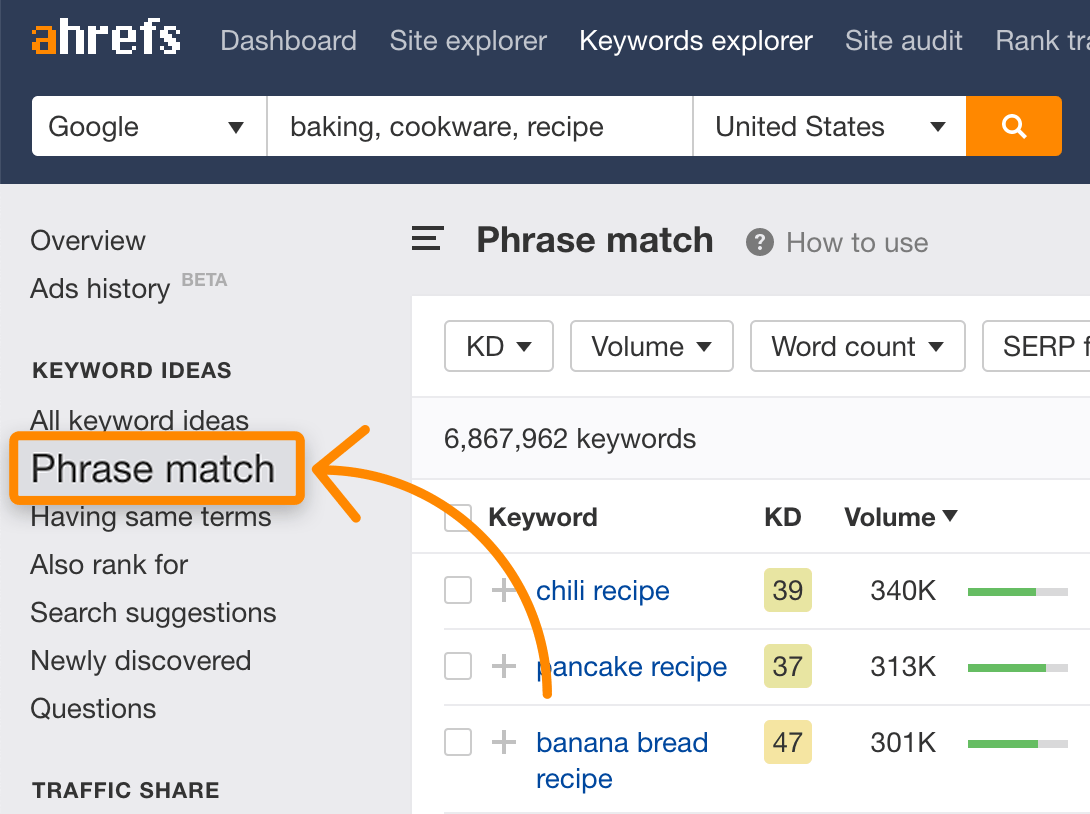

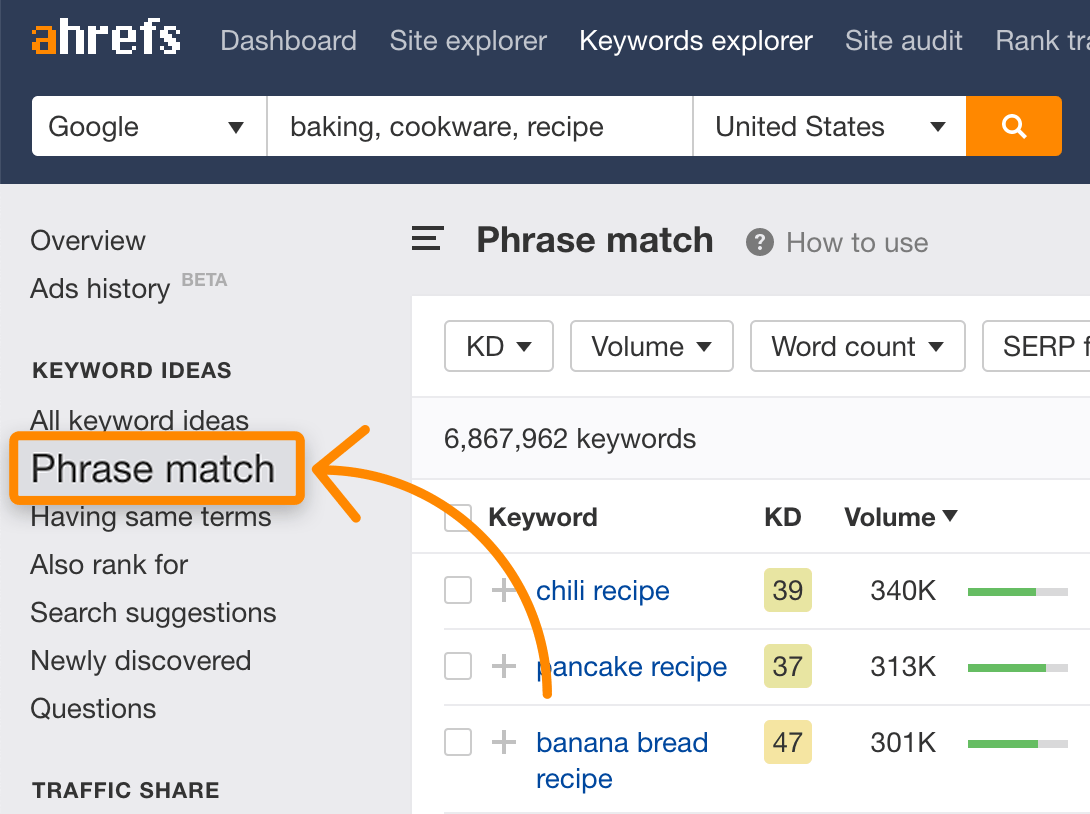

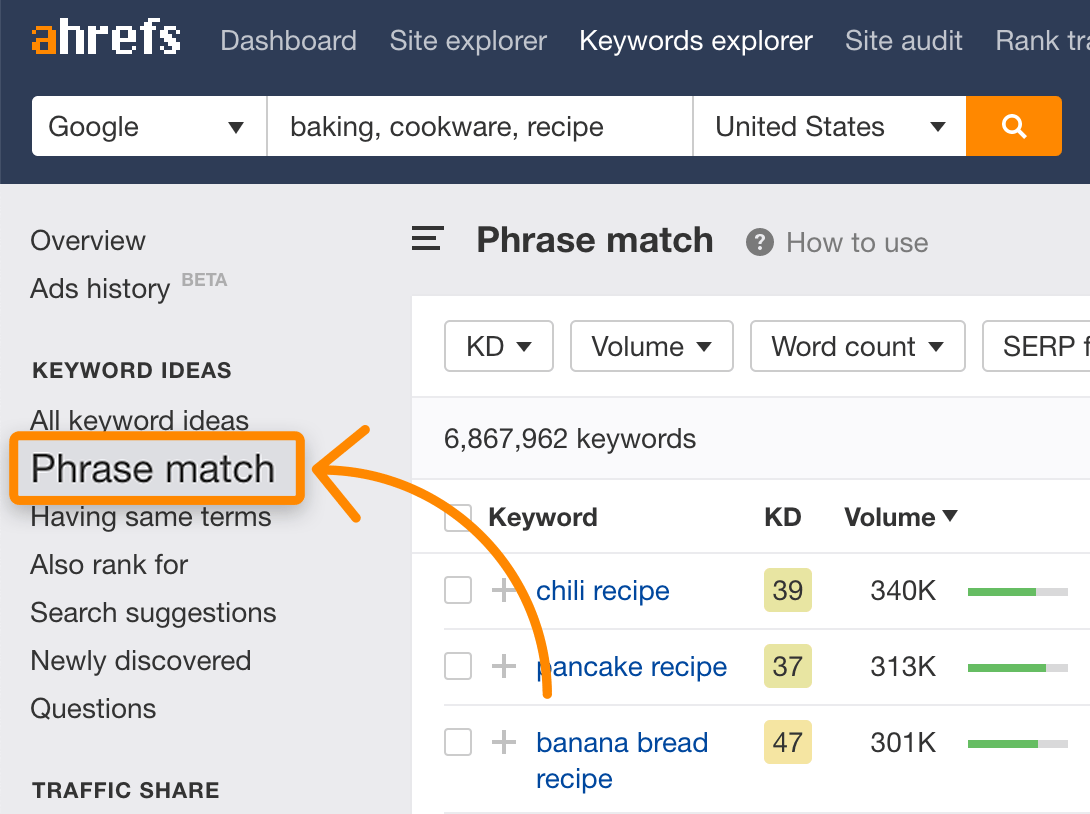

Si vous vendez des pâtisseries en ligne, cela peut être recettes pour les produits de boulangerie, ustensiles de cuisine des avis ou d’autres choses liées à cuisson.

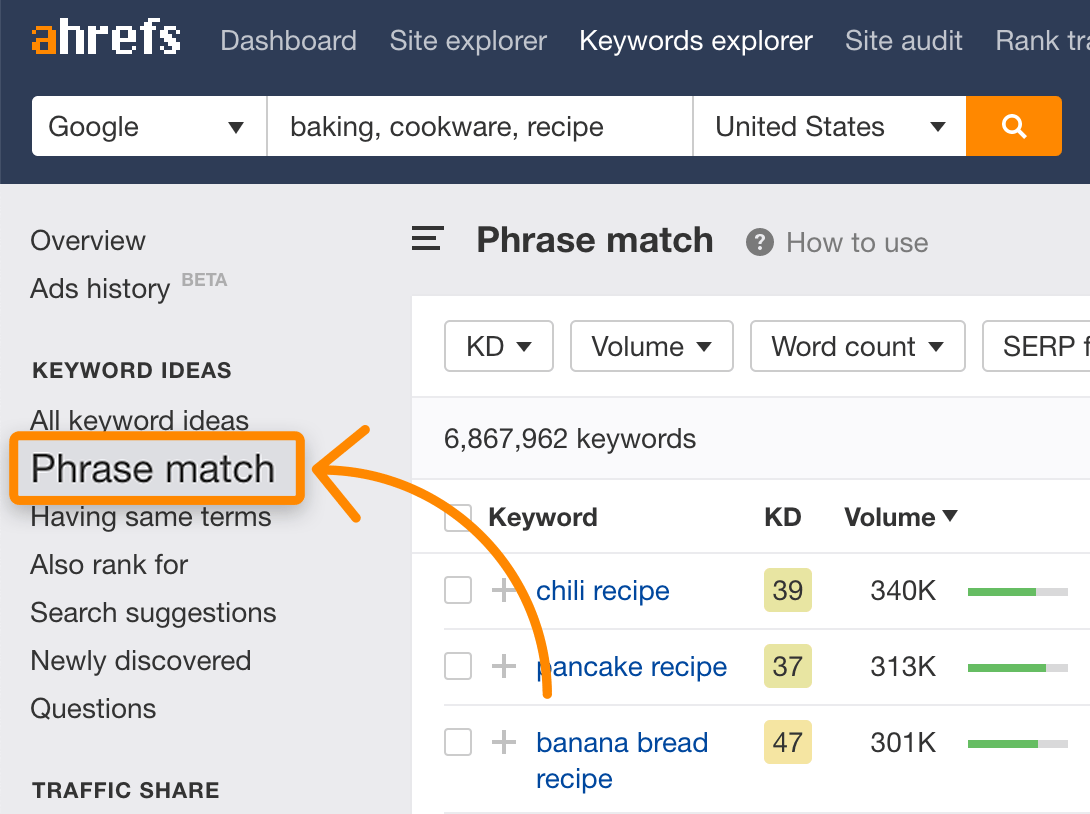

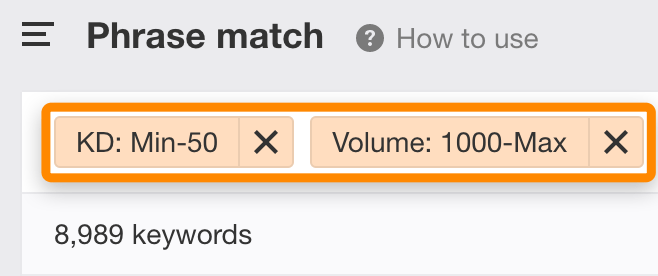

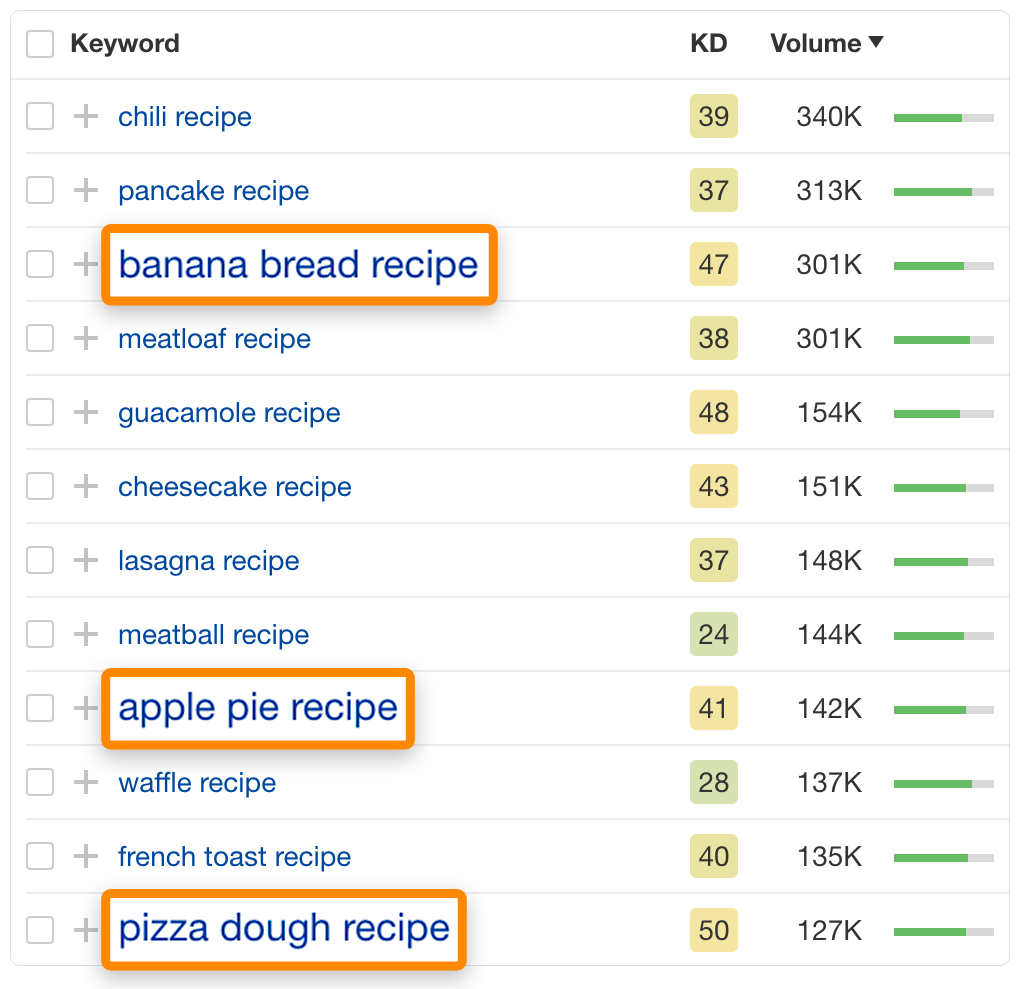

À partir de là, recherchez ces sujets généraux dans l’explorateur de mots-clés d’Ahrefs, puis consultez le rapport « Correspondance de phrases » pour voir des idées de mots clés:

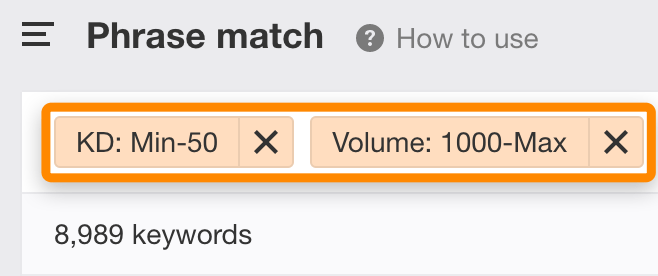

Parce que cela nous donne beaucoup d’idées de mots clés (près de sept millions dans ce cas!), Filtrons les mots clés compétitifs super-compétitifs et ceux qui ont peu ou pas de volume de recherche.

Tout de suite, nous voyons de bonnes idées de sujets comme la recette de pain aux bananes, la recette de tarte aux pommes et la recette de pâte à pizza, chacune avec des tonnes de recherches mensuelles.

Mais voici le problème avec le volume de recherche: il peut être trompeur.

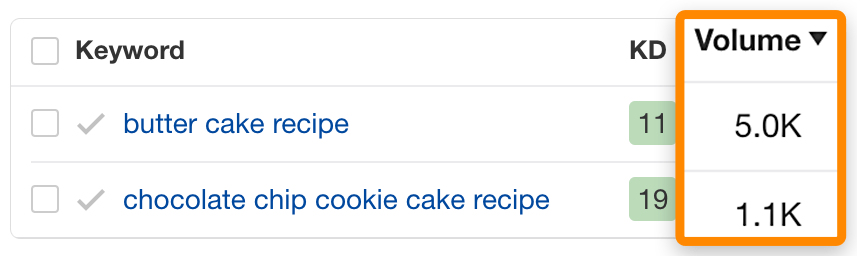

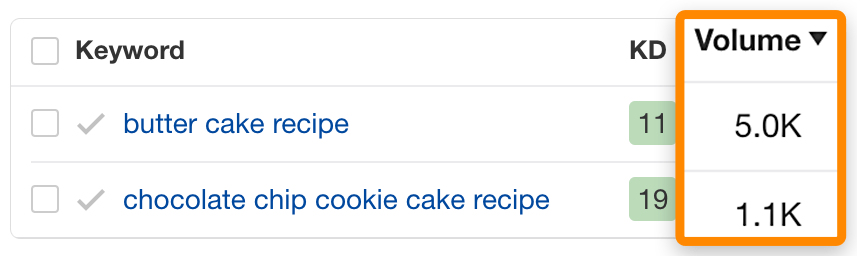

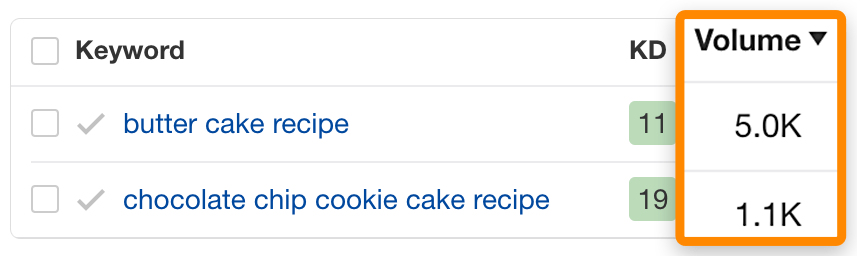

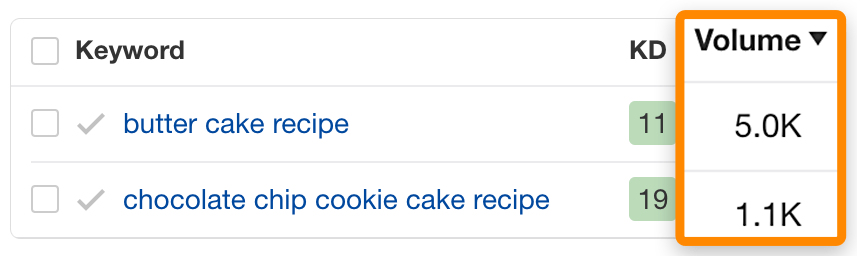

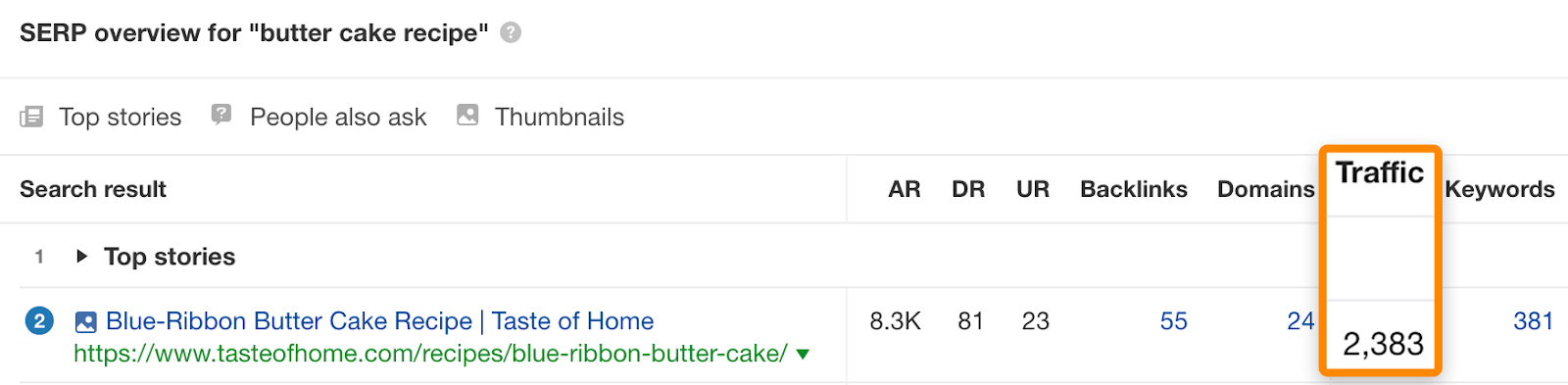

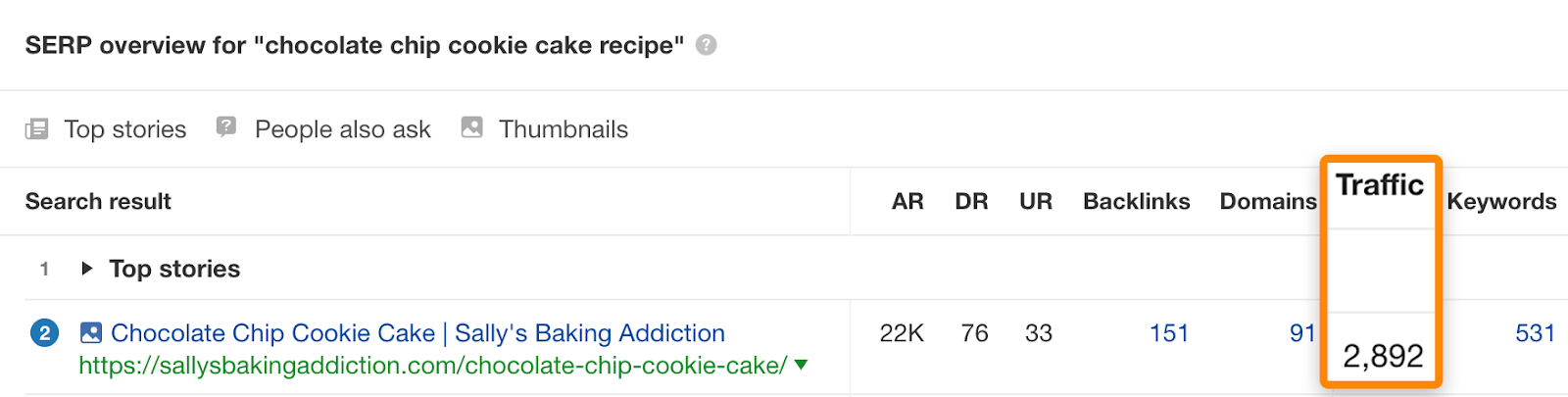

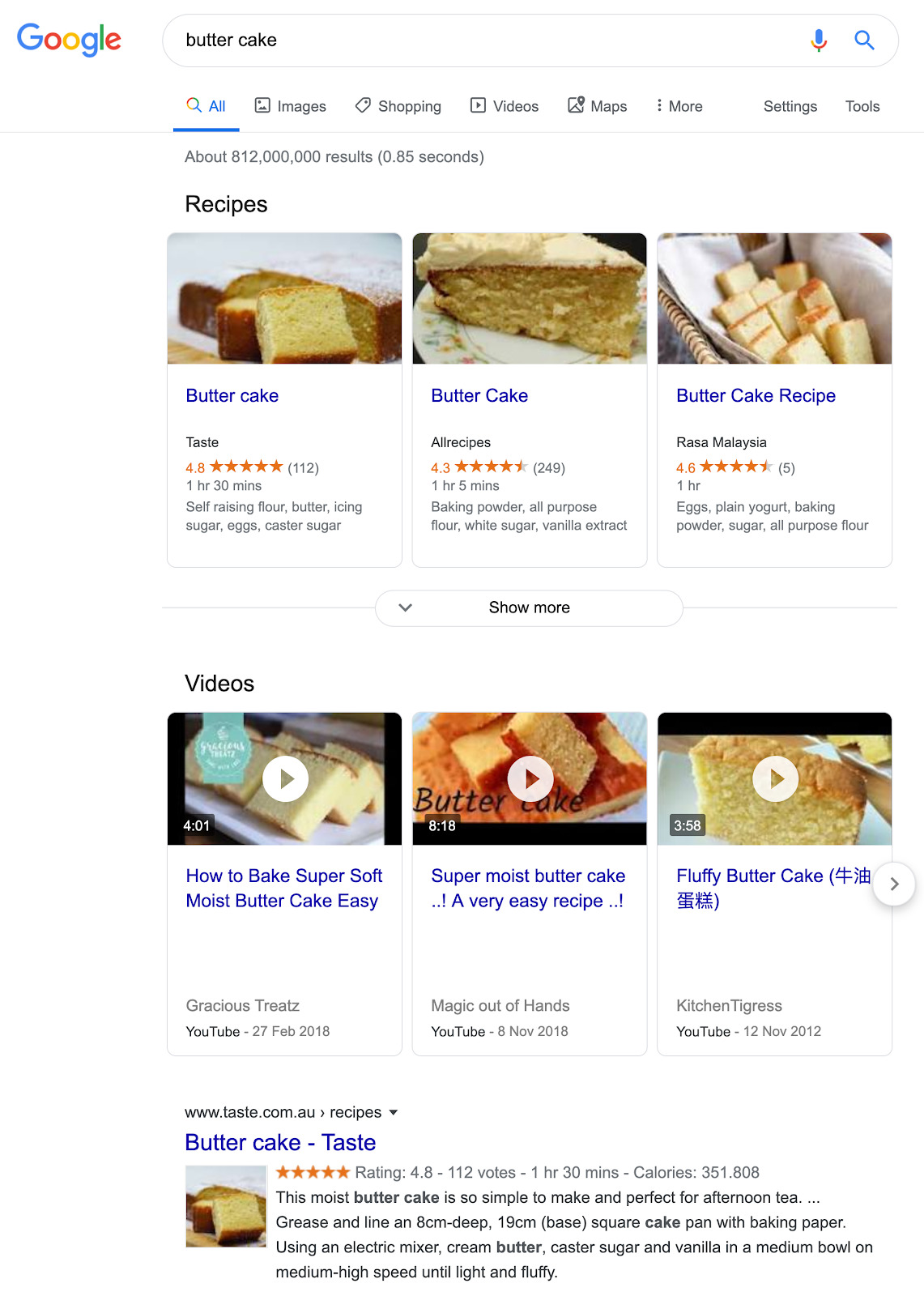

Par exemple, jetez un œil aux volumes de recherche pour ces deux mots clés:

Parce que « recette de gâteau au beurre » a presque cinq fois plus de recherches que « recette de gâteau aux biscuits aux pépites de chocolat », vous vous attendez à ce que ce sujet ait le plus de potentiel de trafic.

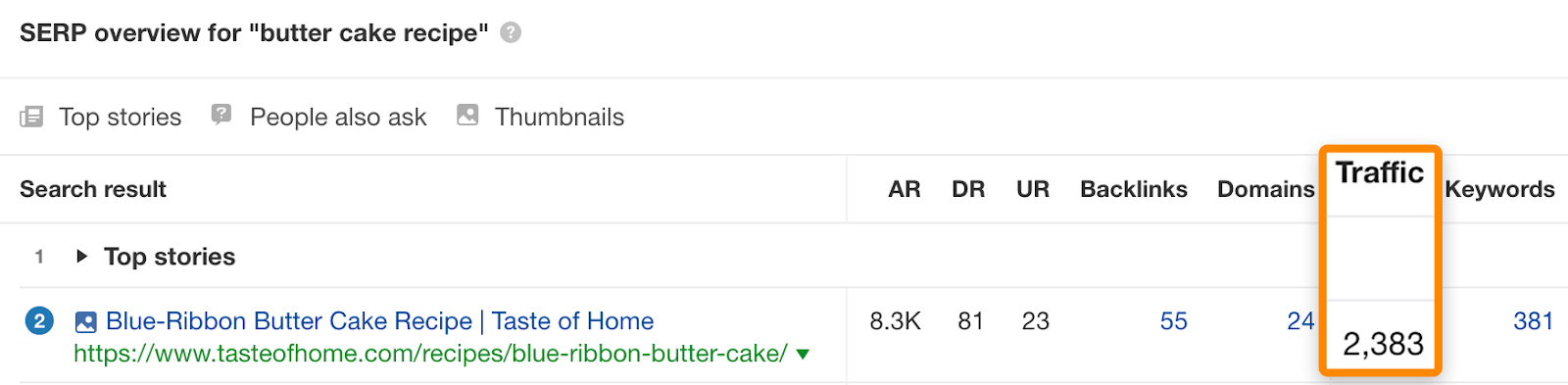

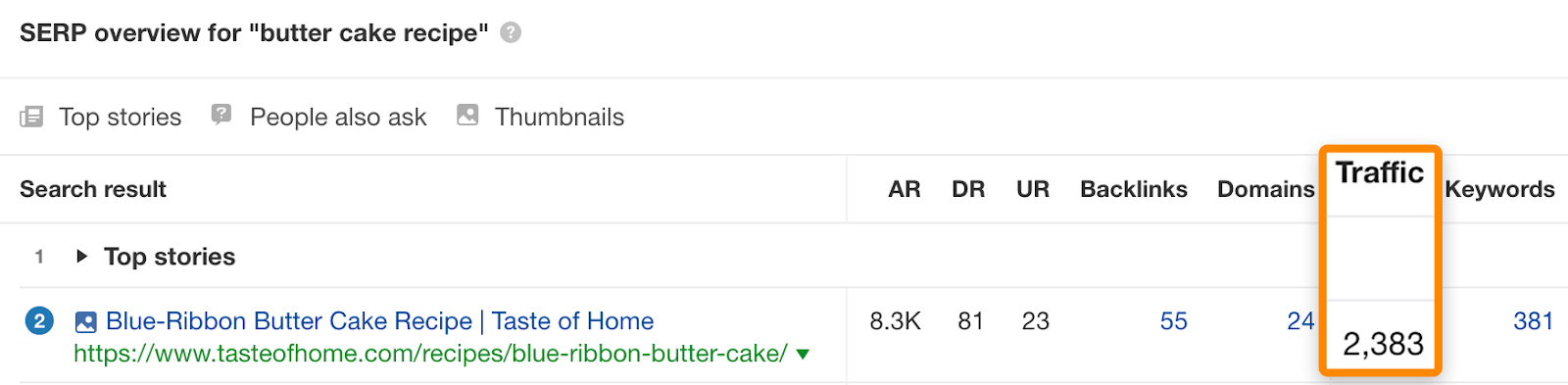

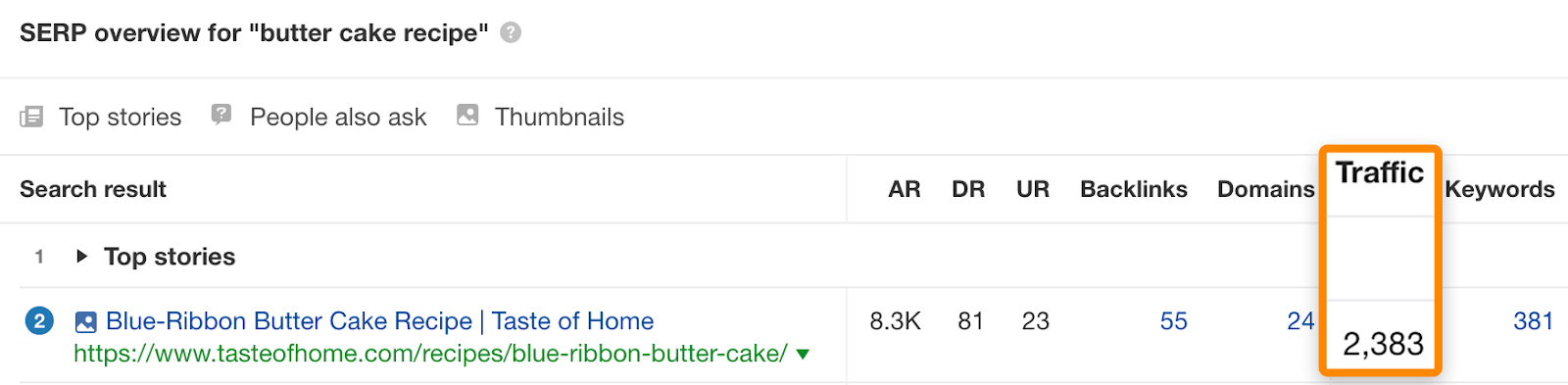

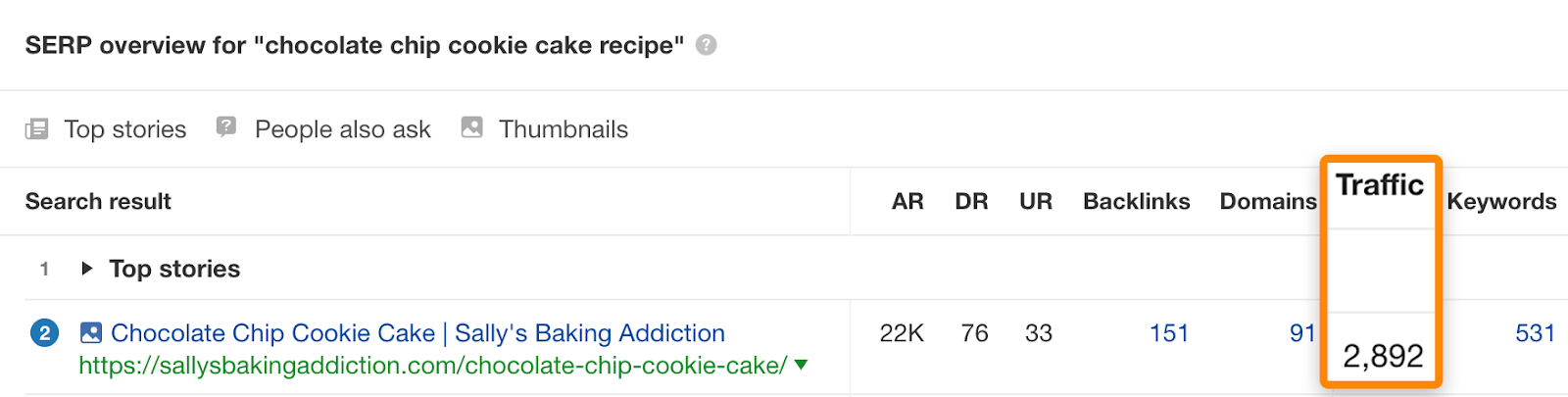

Cependant, si nous regardons la page de premier rang, nous voyons qu’elle obtient environ 2383 NOUS visites d’un mois de recherche organique….

… Tandis que la page la mieux classée de la «recette de gâteau aux biscuits aux pépites de chocolat» en offre plus:

Cela se produit parce que la page la mieux classée se classe pour – et obtient du trafic – davantage de requêtes.

Donc, avant de vous fixer sur un sujet, regardez toujours le trafic estimé vers la page de premier rang pour avoir une meilleure idée du vrai potentiel de trafic.

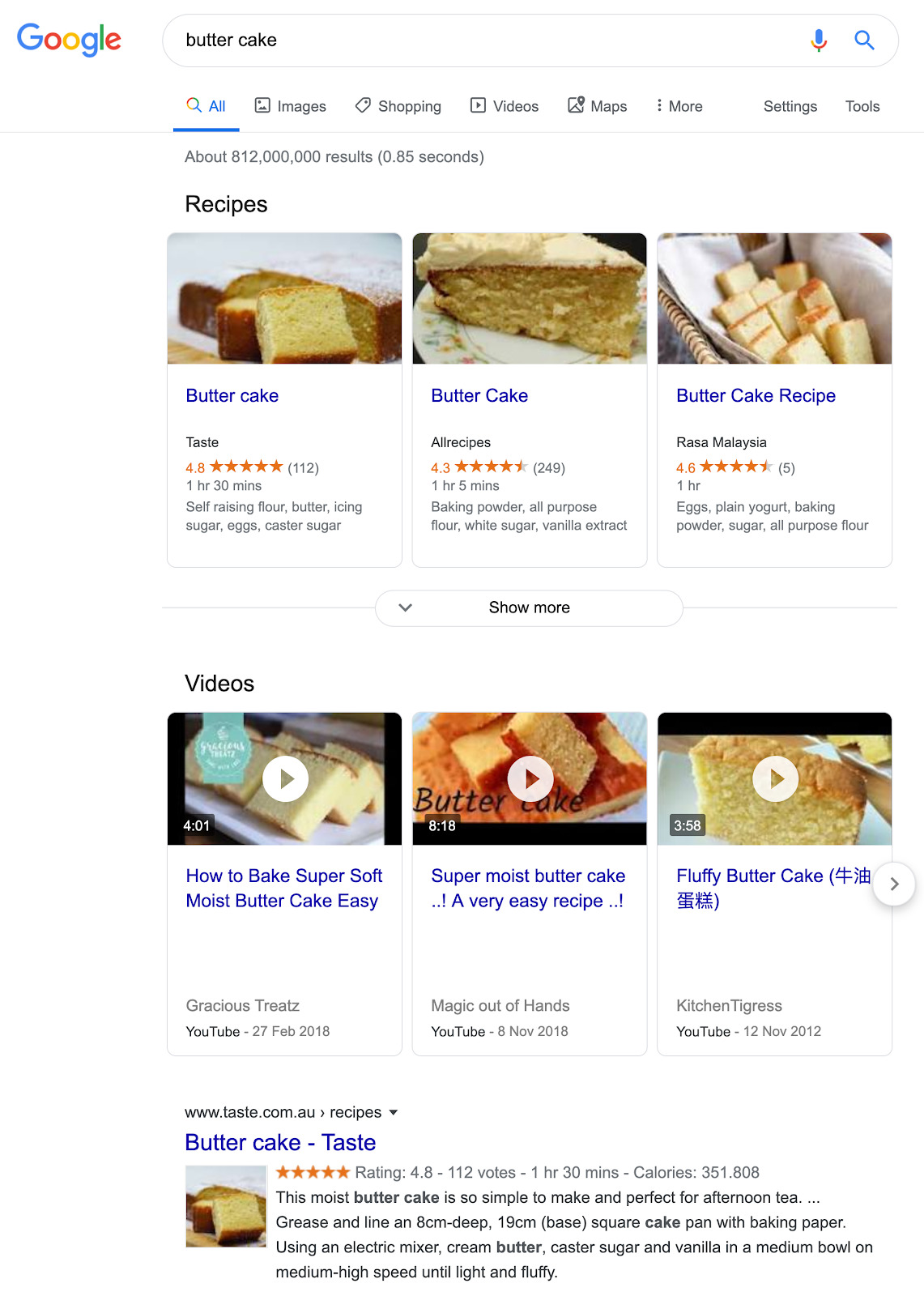

2. Analyser l’intention de recherche

Les moteurs de recherche comme Google ont investi des milliards de dollars pour comprendre la véritable intention des recherches.

C’est ainsi qu’ils peuvent renvoyer des résultats pertinents, même pour des requêtes vagues.

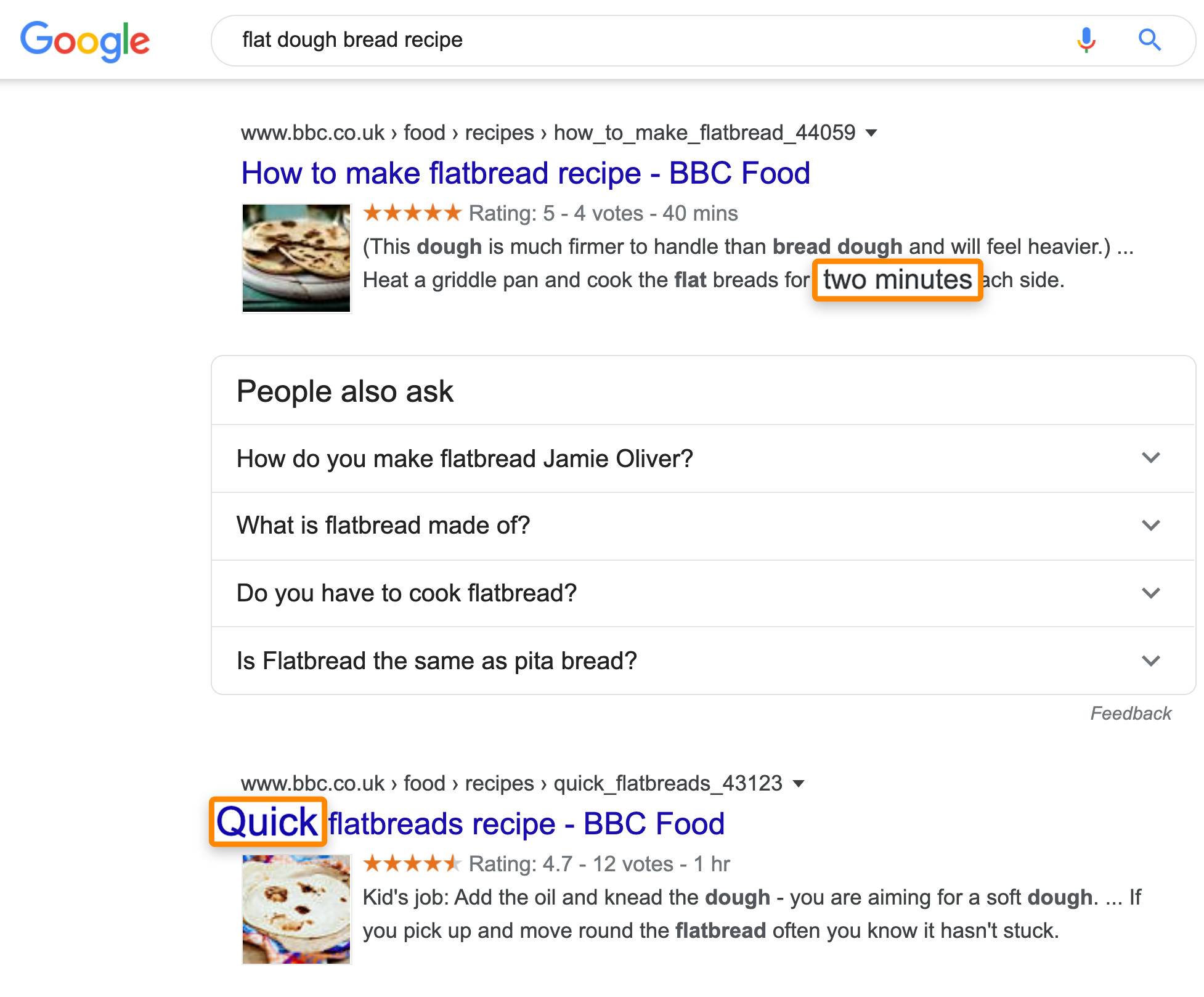

Google sait que je recherche une recette, bien qu’il ne l’ait pas spécifié dans la requête elle-même.

Si vous écrivez SEO contenu, cela est important, car s’il ne correspond pas à l’intention de recherche, vos chances de classement sont minces.

Mais, comment pouvez-vous comprendre l’intention de recherche?

La réponse est de tirer des indices des meilleurs résultats en analysant ce que nous appelons les trois C de l’intention de recherche.

Ceux-ci sont:

Type de contenu

S’agit-il des articles de blog des pages les mieux classées, des pages produits, des pages de catégorie, des pages de destination ou autre chose?

S’ils ne sont pas principalement des articles de blog, revenez à la première étape et choisissez un sujet différent.

Format de contenu

Quel type de poste se classe? S’agit-il de procédures, d’articles de style liste, d’articles d’opinion, d’articles de presse, d’autre chose?

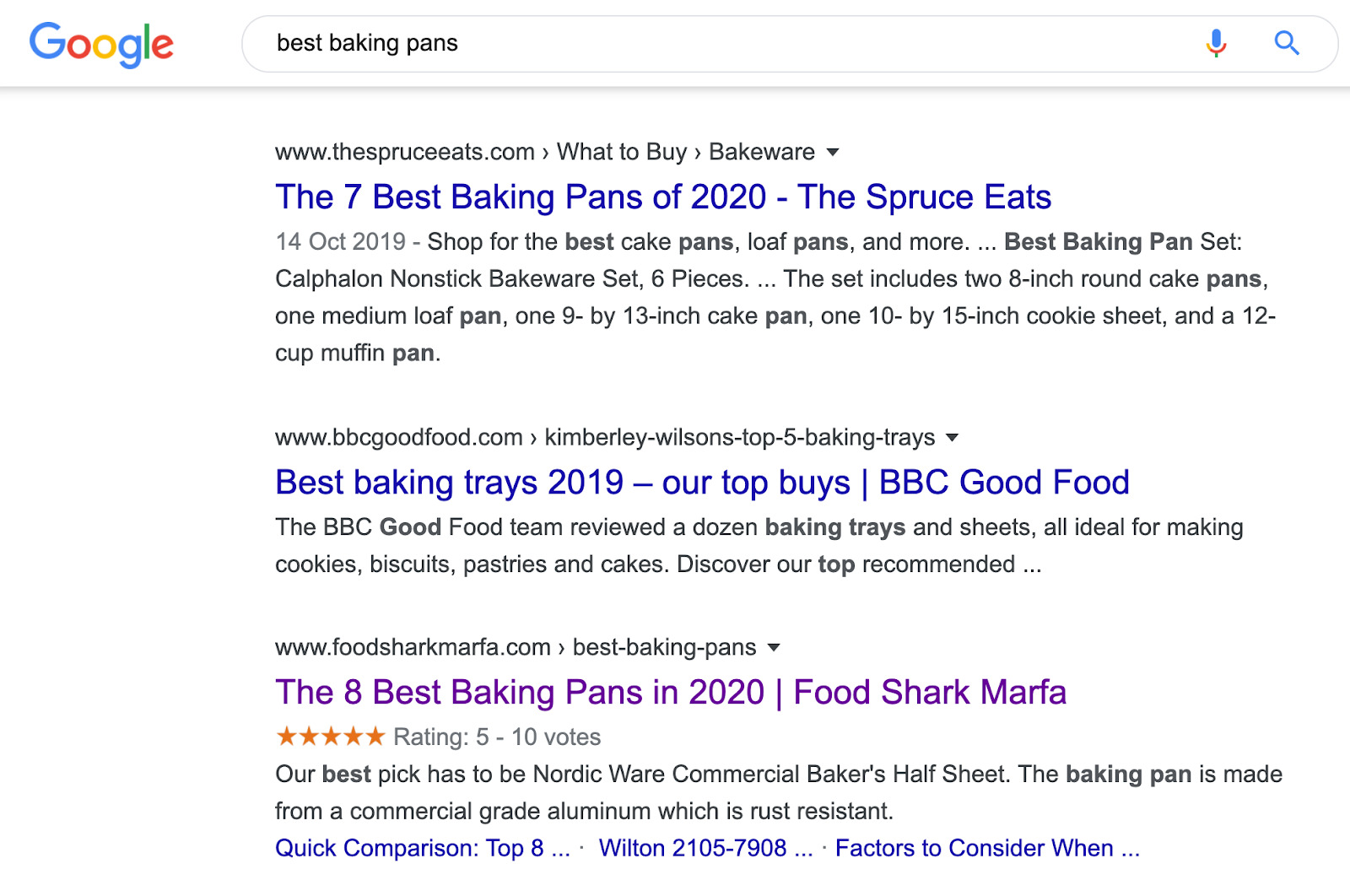

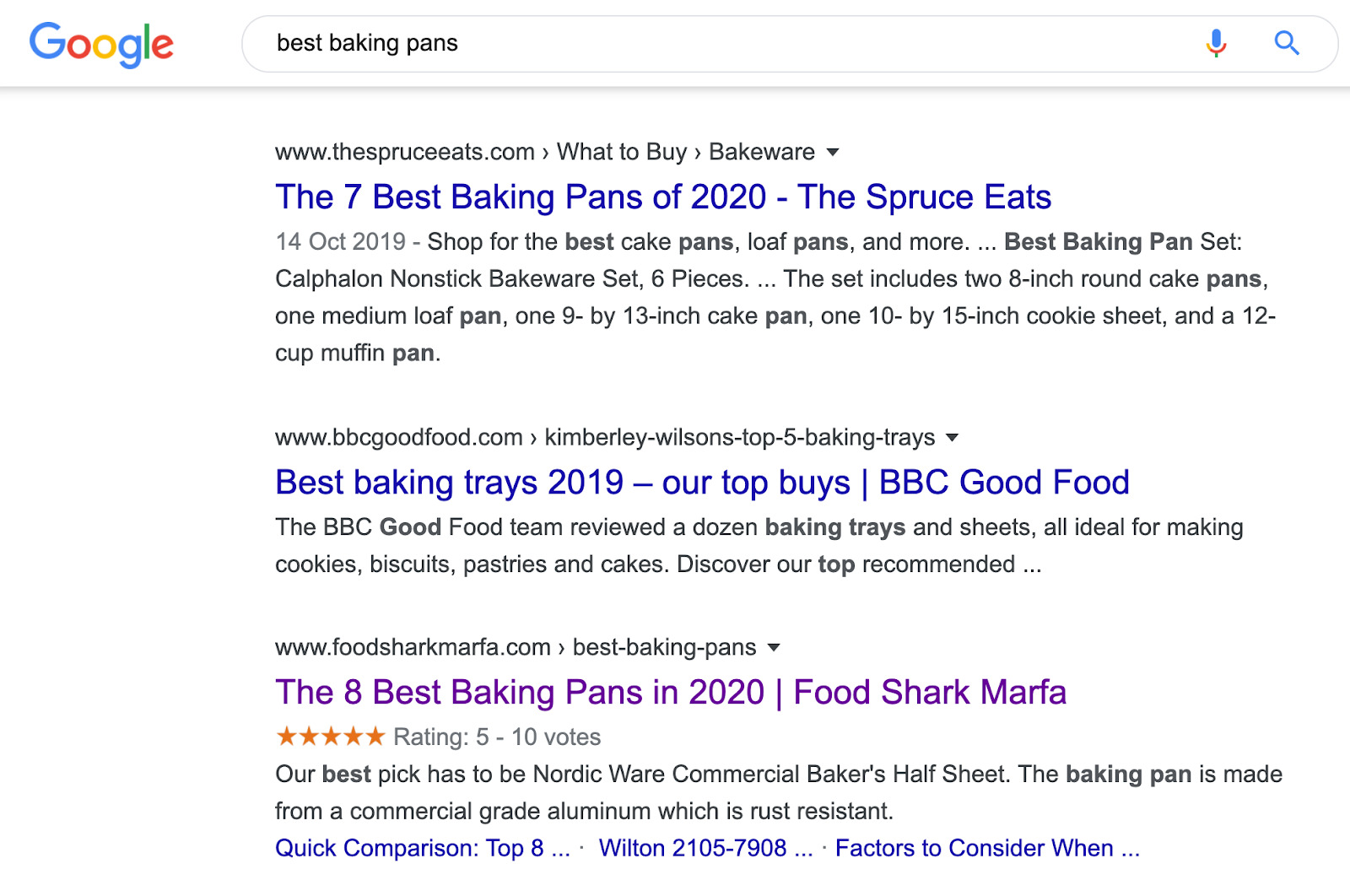

Pour les «meilleures casseroles», ce sont toutes des listes:

Angle de contenu

Regardez les titres des pages pour en savoir plus sur le type de personne recherchant cela. Sont-ils débutants ou experts? Que valorisent-ils? Sont-ils à la recherche d’une solution rapide ou de quelque chose de plus approfondi?

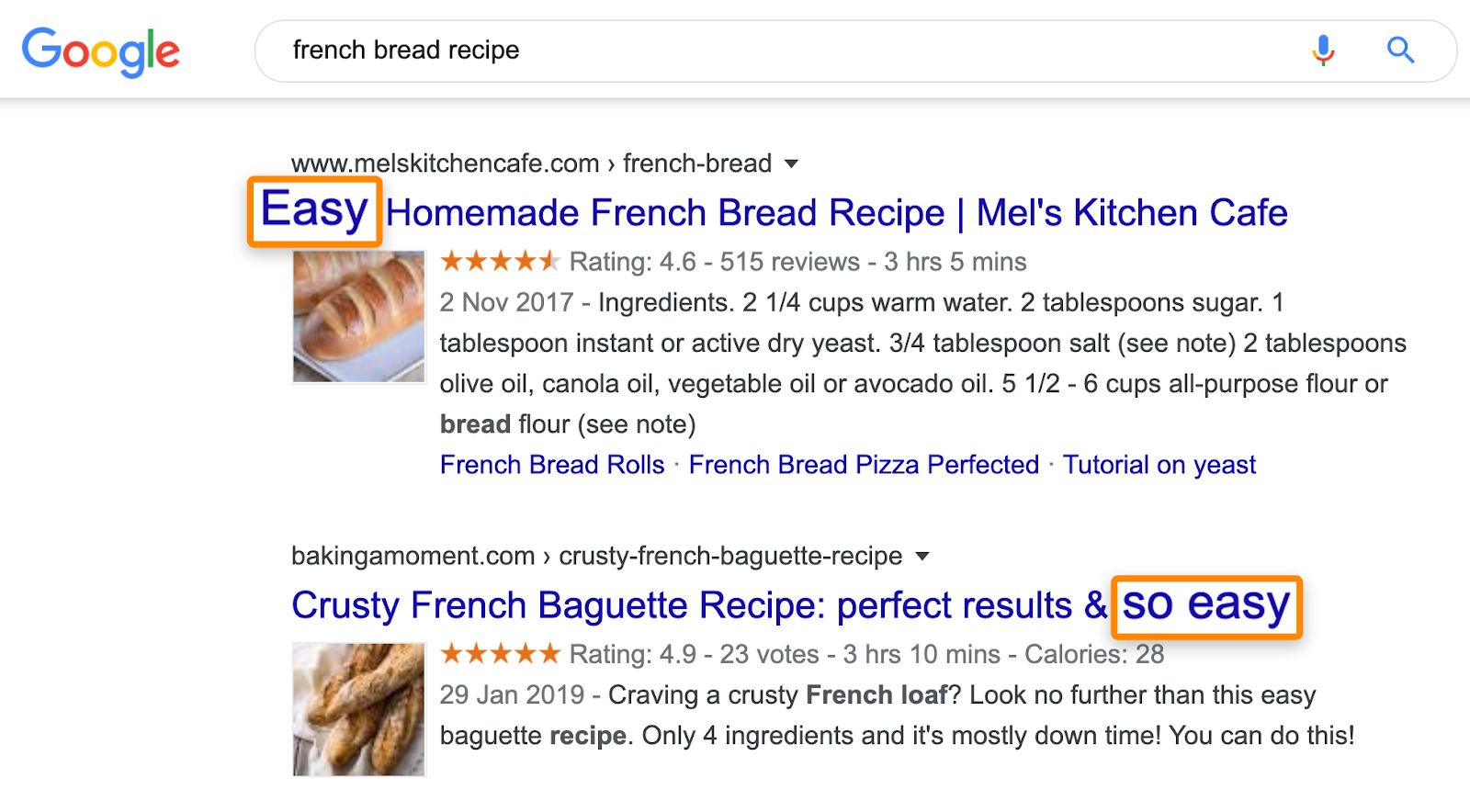

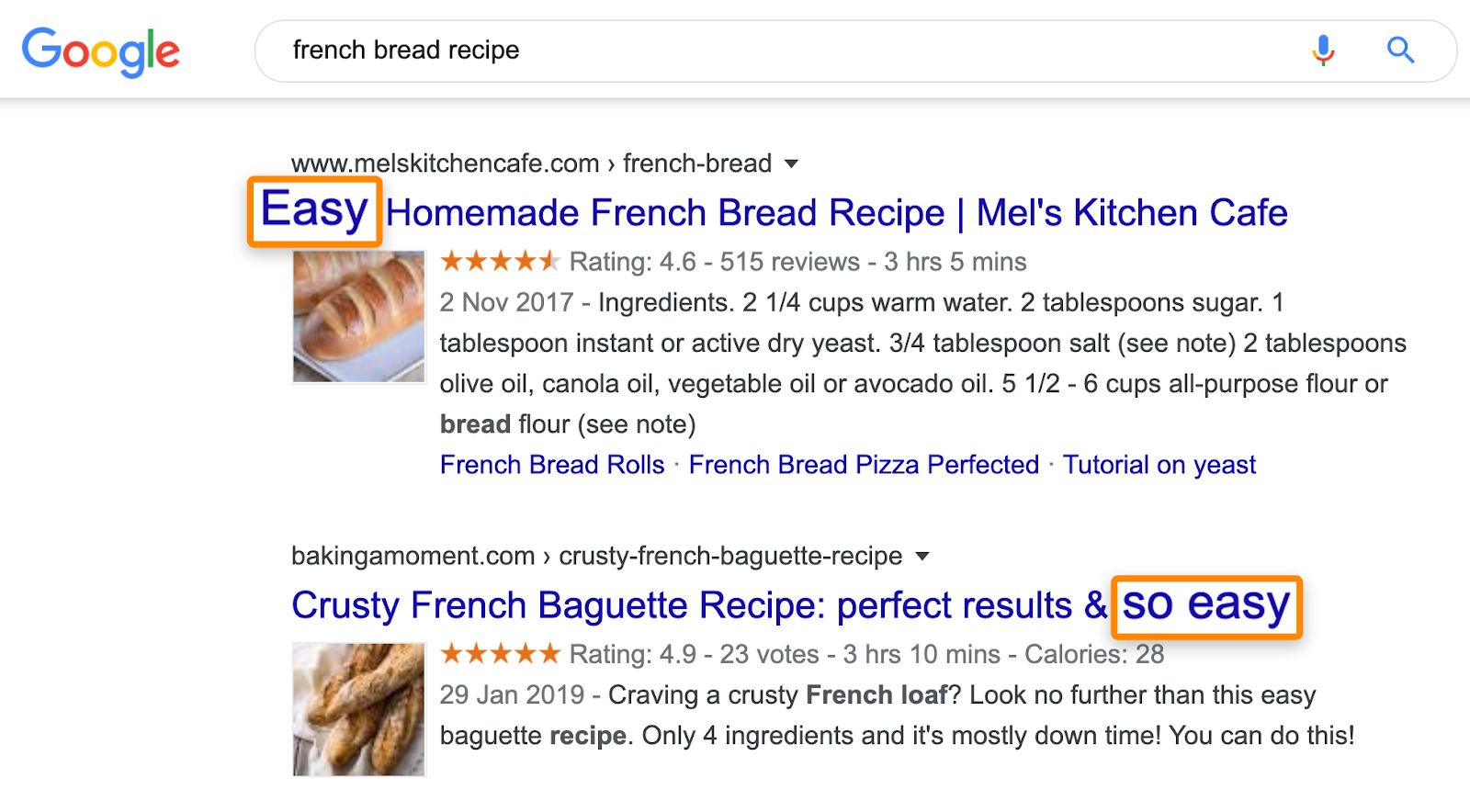

Par exemple, la plupart des pages classées pour «recette de pain français» expliquent à quel point la recette est simple:

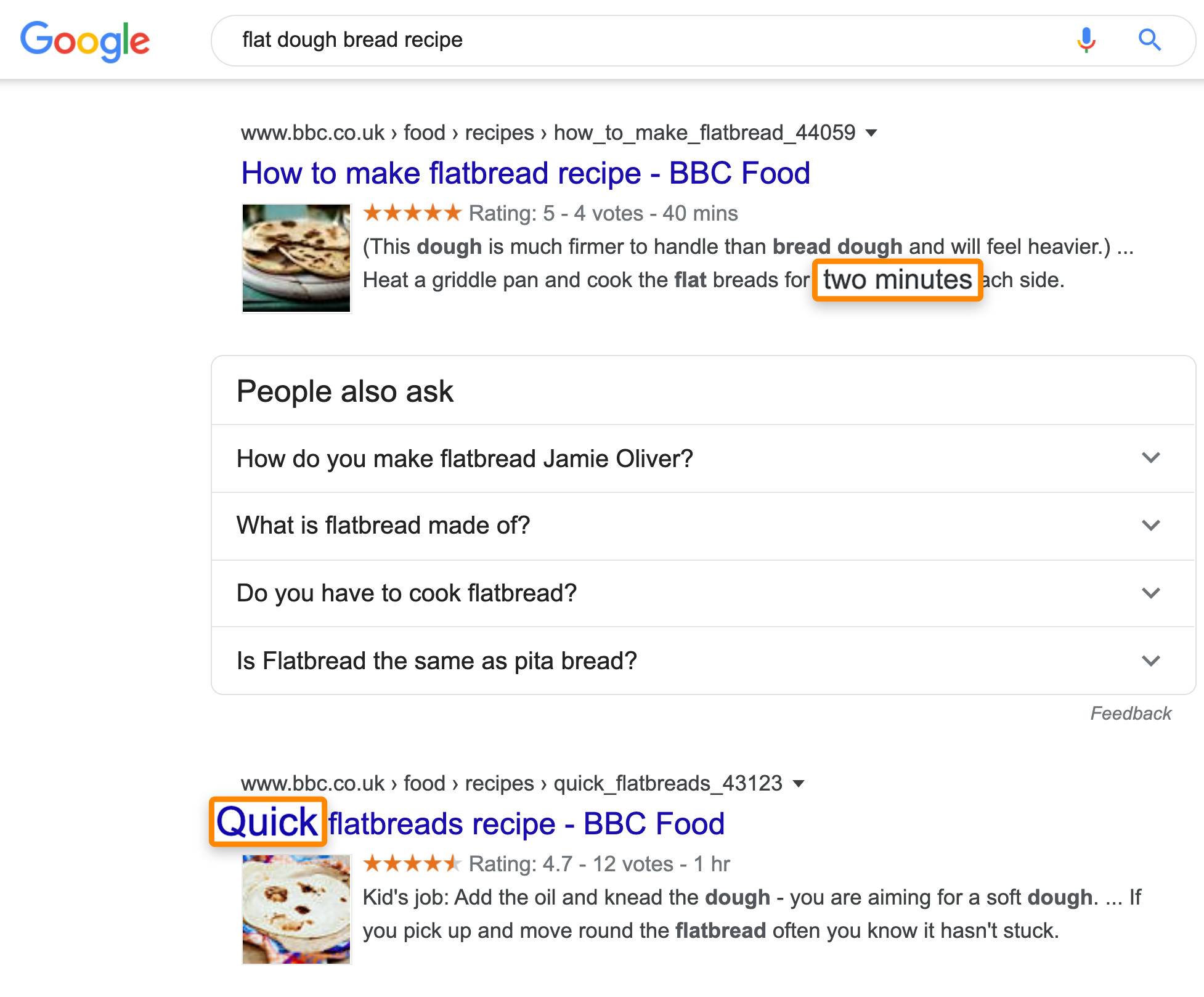

Pour la recette du pain plat, la vitesse semble être ce qui plaît aux chercheurs:

Lecture recommandée: Intention de recherche: le «facteur de classement» négligé que vous devriez optimiser en 2019

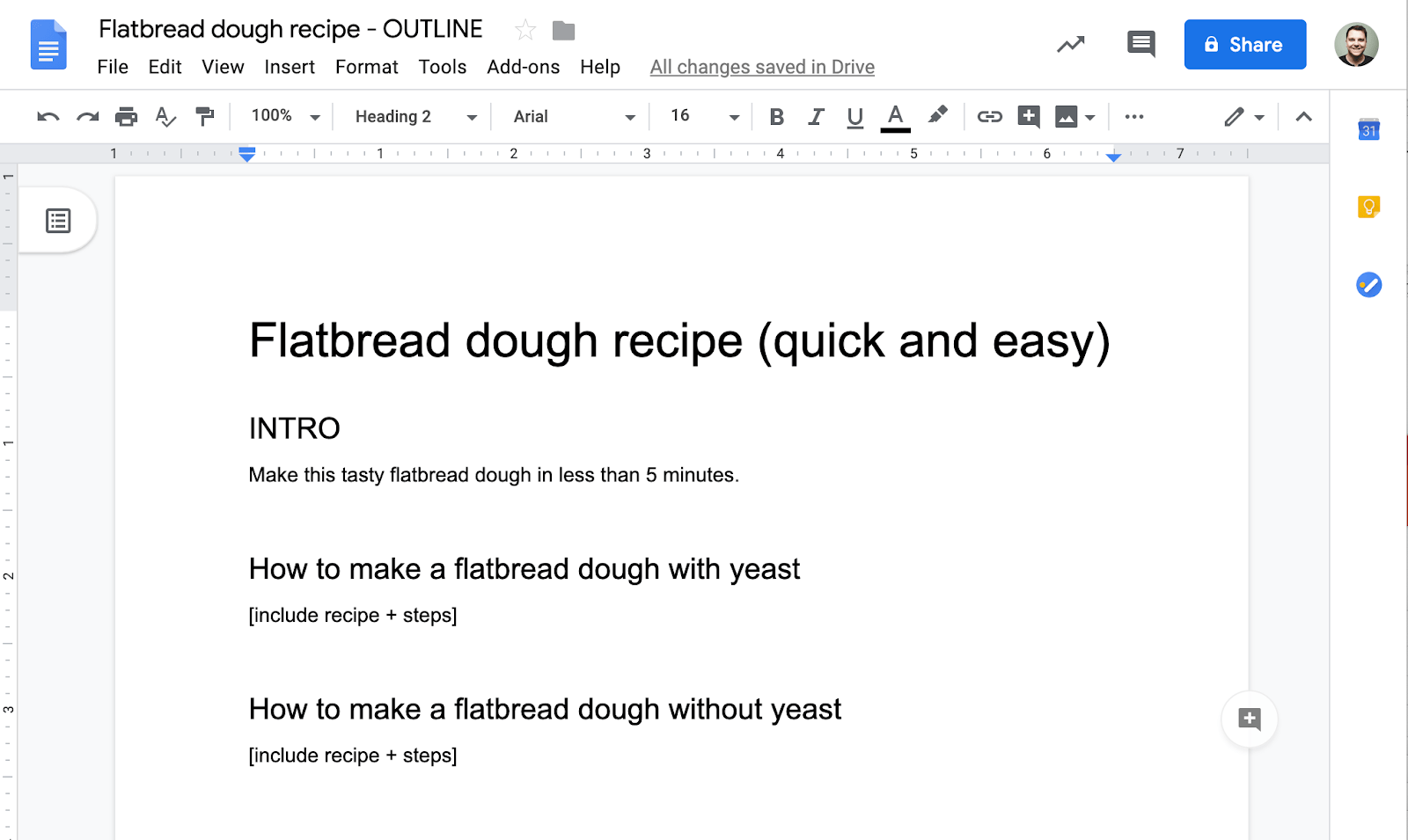

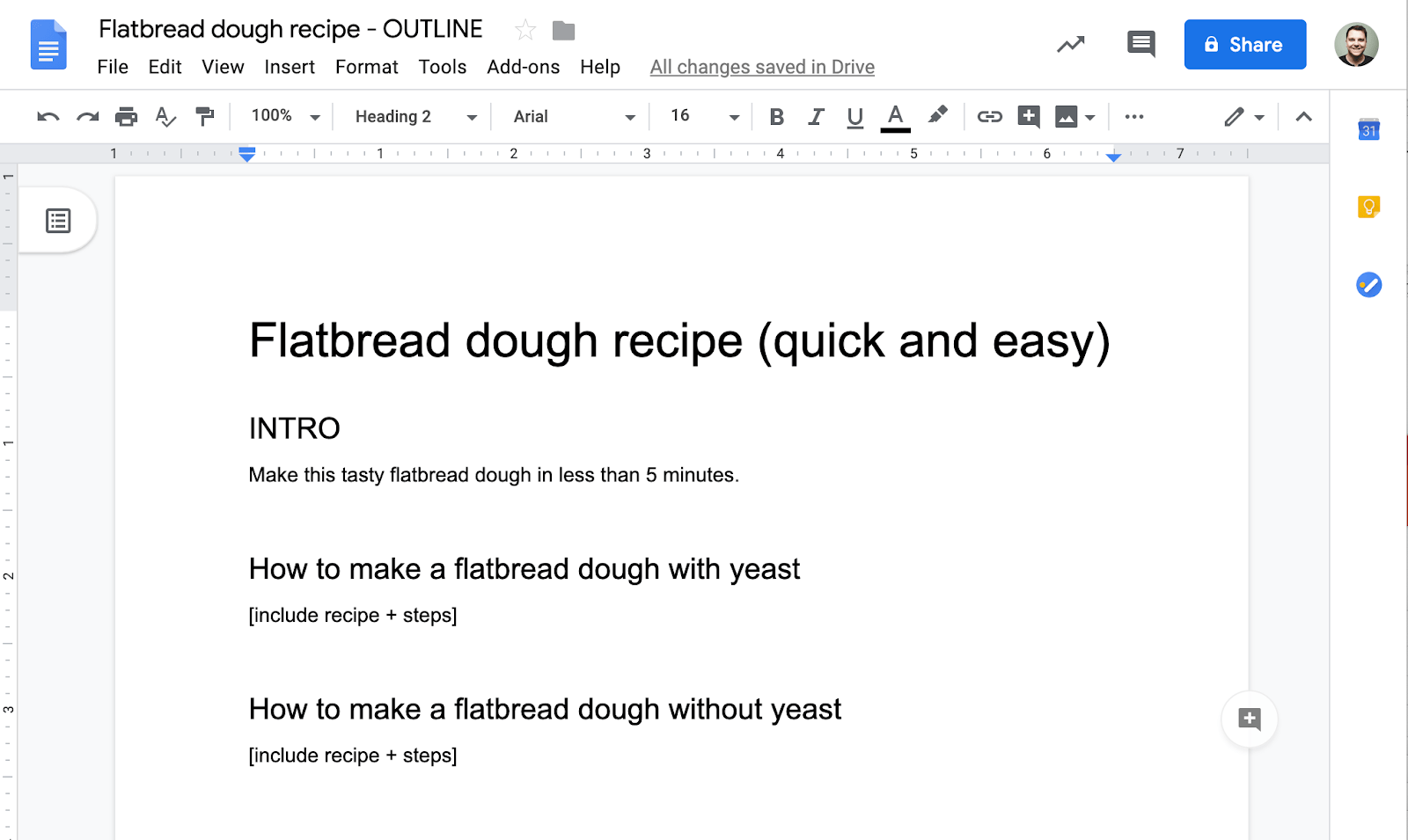

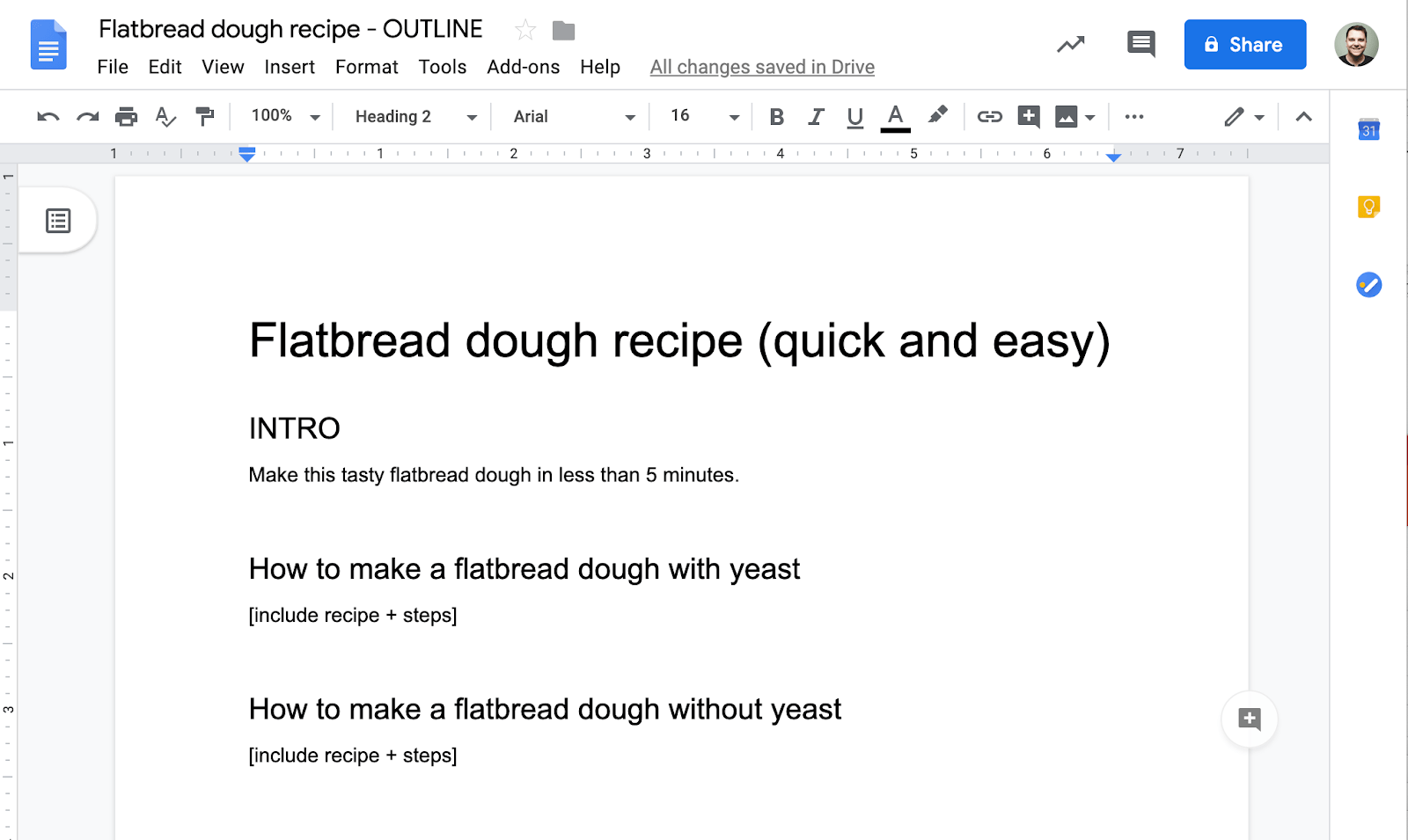

3. Rédigez un plan basé sur les données

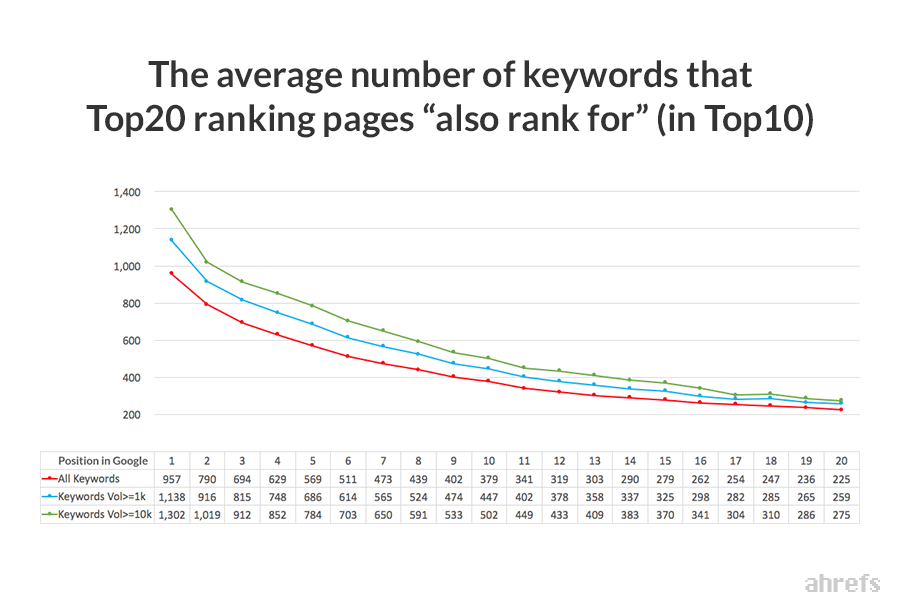

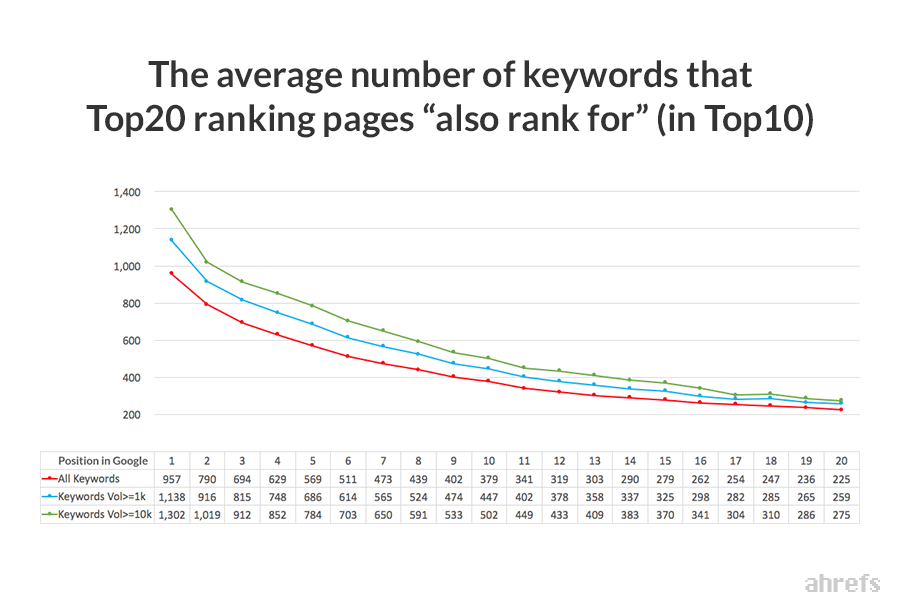

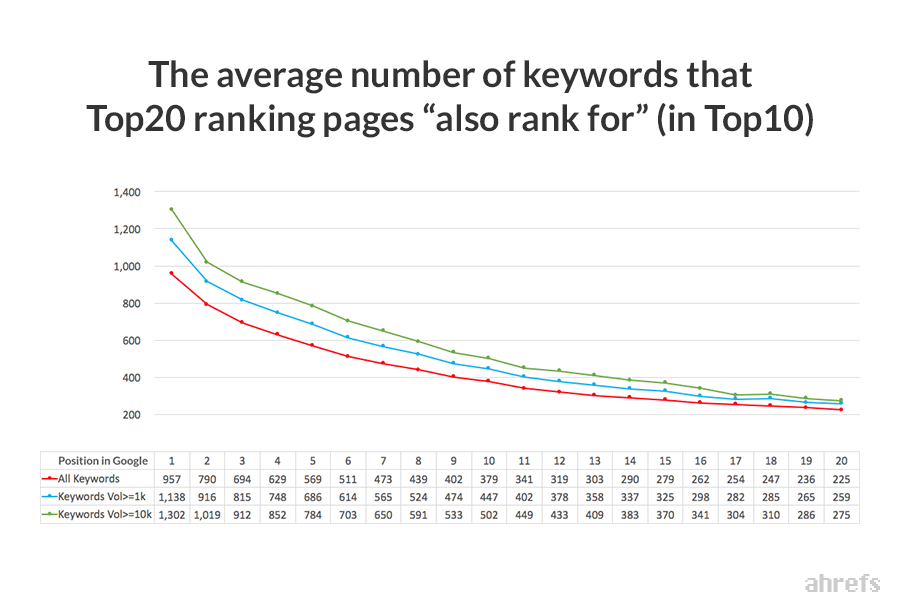

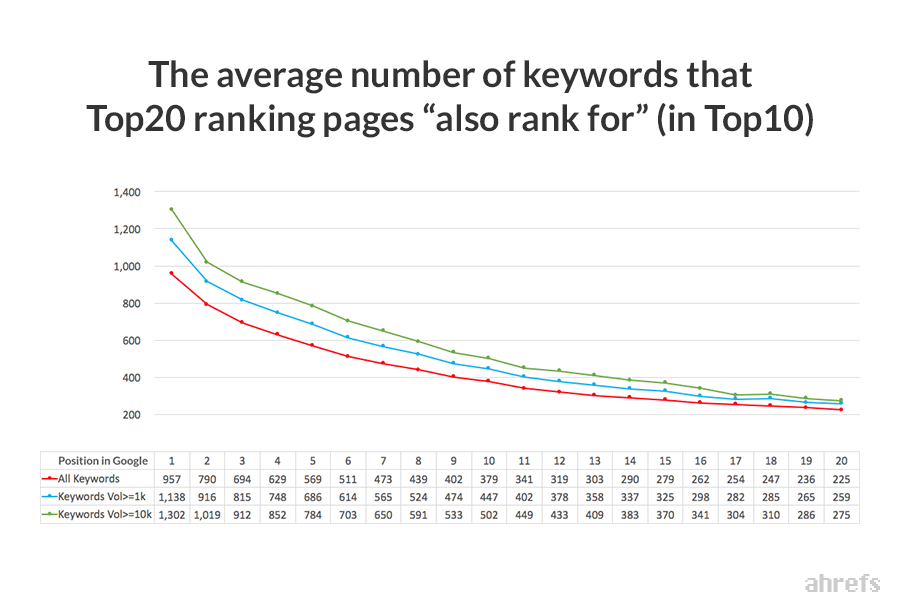

La page de premier rang moyenne se classe pour près de 1 000 autres mots clés pertinents dans le top 10.

Pour cette raison, il est utile de savoir pour quels autres mots-clés les pages les mieux classées se classent également lors de la création de votre plan. Vous pouvez donc également les classer.

Comment pouvez-vous les trouver?

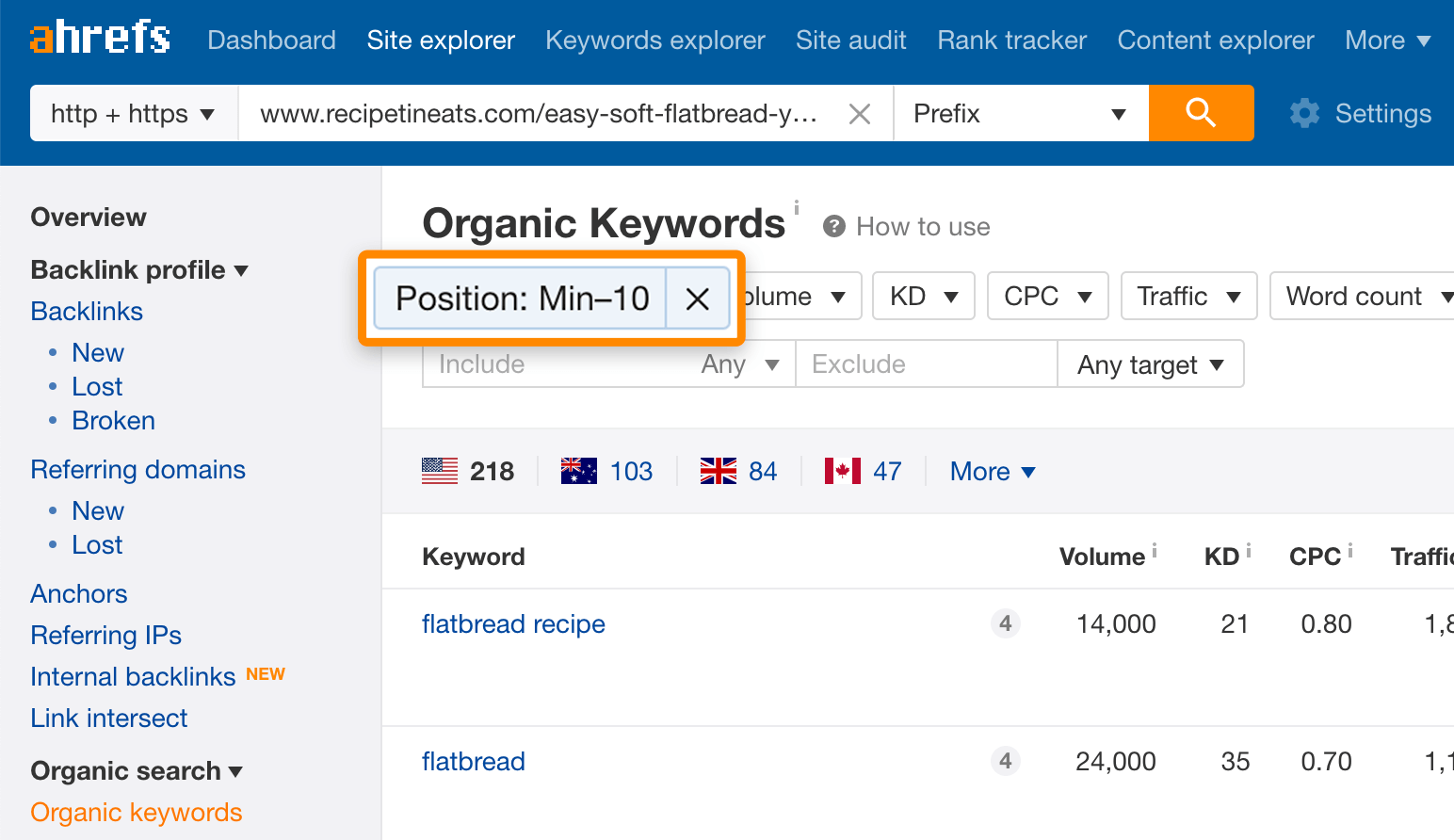

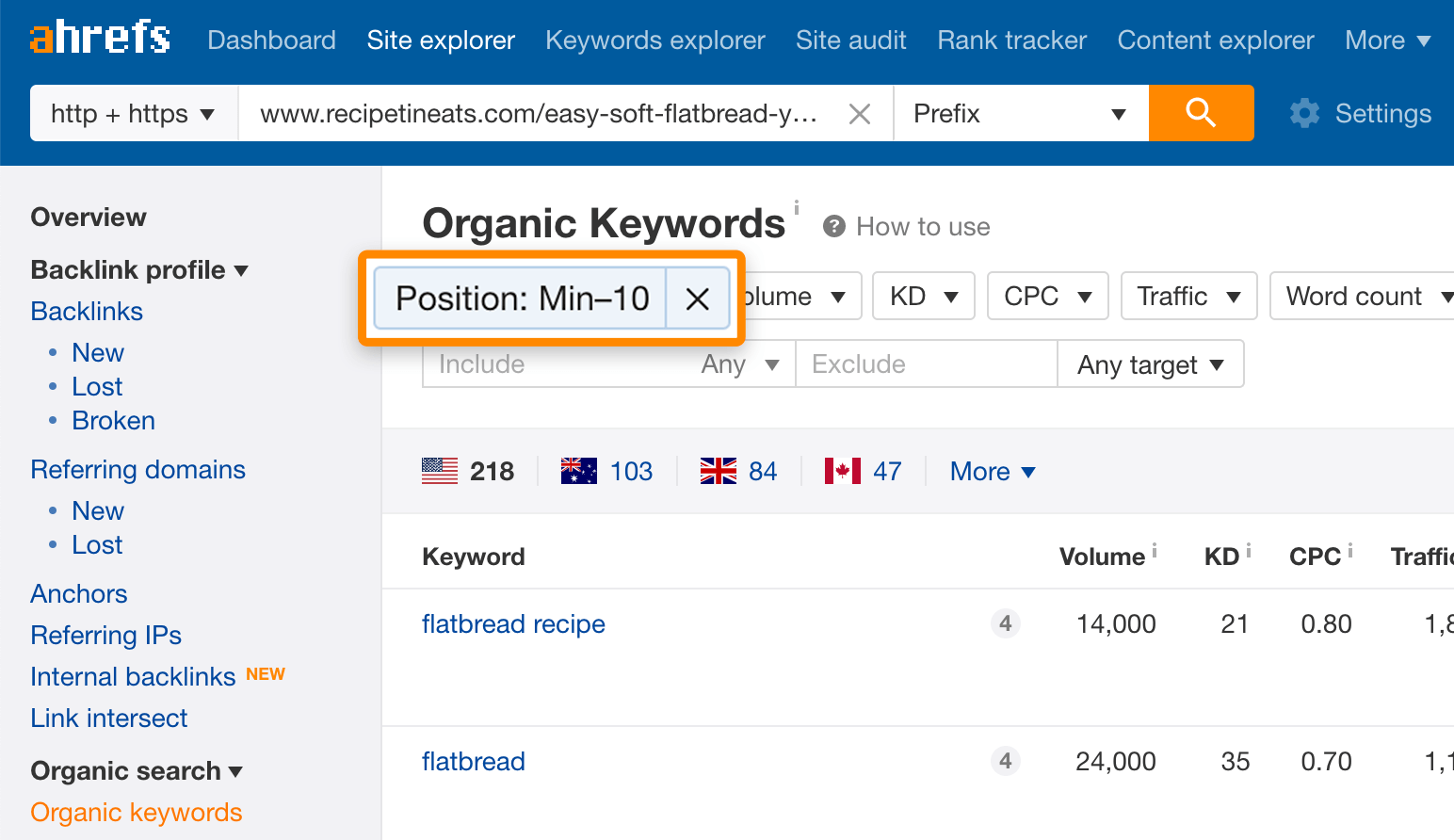

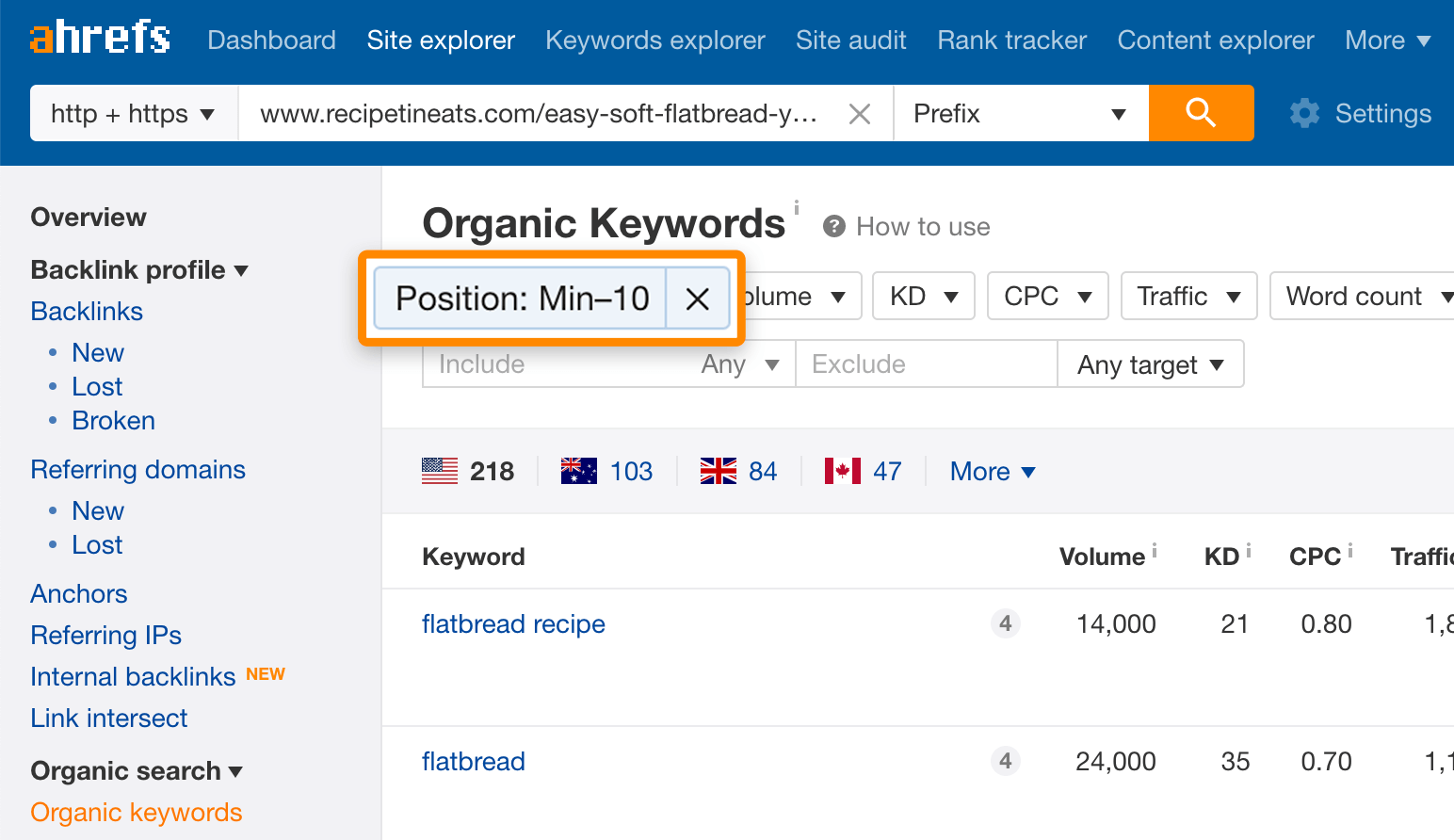

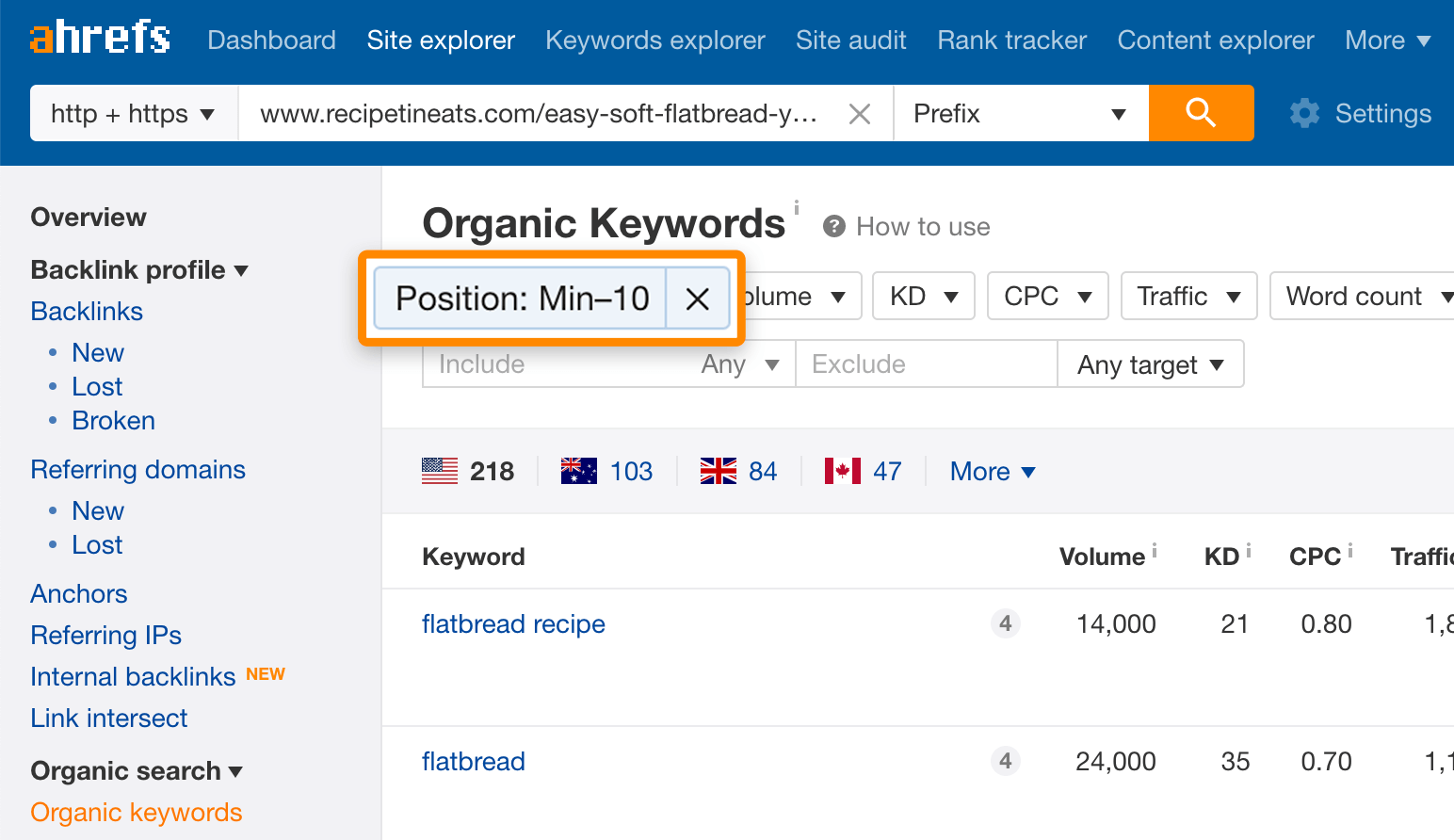

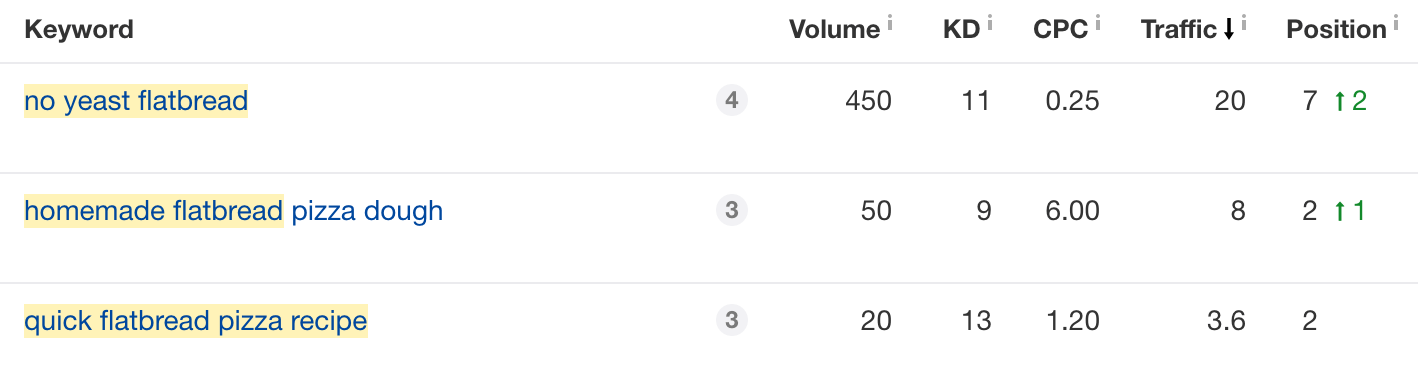

Collez le URL de la page de premier rang dans l’explorateur de site d’Ahrefs, puis accédez au rapport sur les mots clés organiques. Pour éliminer les mots clés non pertinents, filtrez les mots clés où la page se classe en dixième position ou plus.

Vous remarquerez probablement que bon nombre d’entre eux sont des synonymes ou des moyens moins populaires de rechercher à peu près la même chose, mais certains devraient vous donner un aperçu de ce que les chercheurs veulent voir sur cette page.

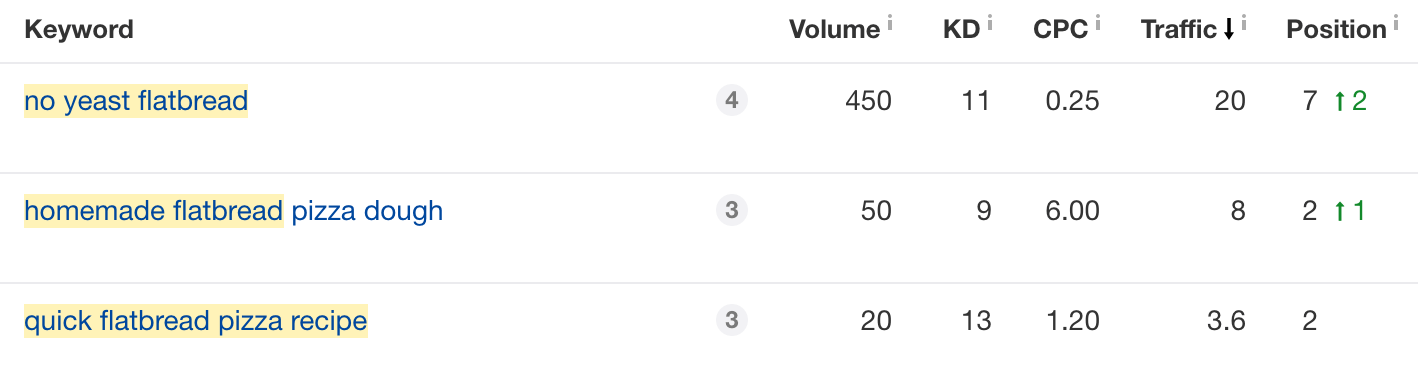

Par exemple, nous voyons que la page de classement supérieur pour «recette de pâte à pain plat» se classe également pour des choses comme «pain plat sans levure», «recette rapide de pizza à pain plat», «pain plat fait maison»:

Notez que vous ne devez pas fourrer ces mots et ces phrases dans votre message, mais plutôt les utiliser pour aplanir l’angle de votre contenu et créer un contour approximatif.

Par exemple, si nous écrivions une recette de pâte à pain plat, nous voudrions probablement mentionner la vitesse dans l’intro, et nous pourrions vouloir avoir des sections distinctes sur la fabrication du pain plat avec et sans levure.

Si vous n’utilisez pas Ahrefs, vous pouvez faire la même chose en consultant les pages les mieux classées et en faisant preuve de bon sens.

4. Rédigez un brouillon

Bonne nouvelle: il est enfin temps de mettre le stylo sur papier et de rédiger votre message.

Parce que cela n’a pas grand-chose à voir avec SEO, nous ne nous attarderons pas trop sur ce processus. N’oubliez pas que le but ici n’est pas d’écrire un brouillon parfait dès le départ, mais plutôt de transformer vos pensées en quelque chose de tangible avec lequel travailler.

Voici quelques conseils pour le faire le plus rapidement possible:

Écrivez pendant que vous parlez

La plupart des meilleurs articles de blog sont rédigés sur un ton informel et conversationnel, il n’est donc pas nécessaire d’agoniser chaque mot. Écrivez juste pendant que vous parlez.

Ne vous inquiétez pas si cela semble idiot; vous pouvez corriger cela à l’étape suivante.

Utilisez la technique Pomodoro

La technique de Pomodoro est simple: vous définissez une minuterie de 25 minutes et un objectif que vous souhaitez atteindre dans ce laps de temps.

Pour rédiger des articles de blog, un bon objectif est un certain nombre de mots.

La plupart des gens tapent environ 40 mots par minute, ce qui représente 1 000 mots en 25 minutes. Cependant, la rédaction d’un article de blog est plus éprouvante mentalement que la simple saisie. Supposons donc une efficacité de 30 à 40%, soit 300 à 400 mots toutes les 25 minutes.

Faites une courte pause après 25 minutes, puis répétez.

Continuez ce processus jusqu’à ce que vous ayez une ébauche complète.

Sidenote.

Testez votre vitesse de frappe ici. De cette façon, vous pouvez définir un objectif plus personnalisé.

5. Modifiez votre brouillon

Il est important d’attirer les lecteurs dans le flux de votre contenu si vous voulez qu’ils restent, ce que vous faites.

Non seulement cela est bon pour les conversions (qui est finalement le point de classement), mais cela a également un impact positif sur les mesures d’engagement des utilisateurs comme le temps sur la page, le temps de séjour et le taux de rebond, qui, selon certains SEO, peuvent indirectement influencer les classements.

Voici trois points sur lesquels se concentrer:

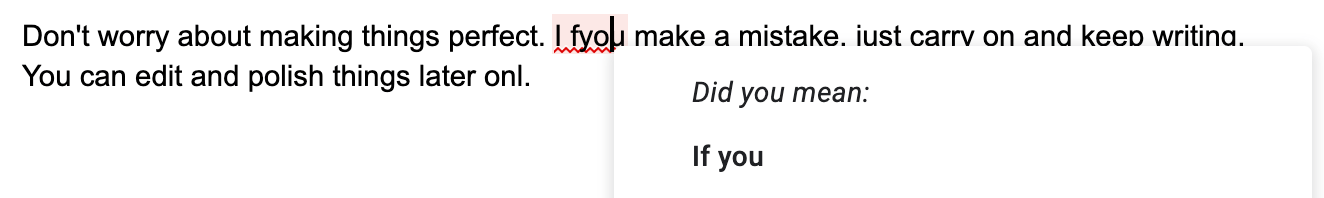

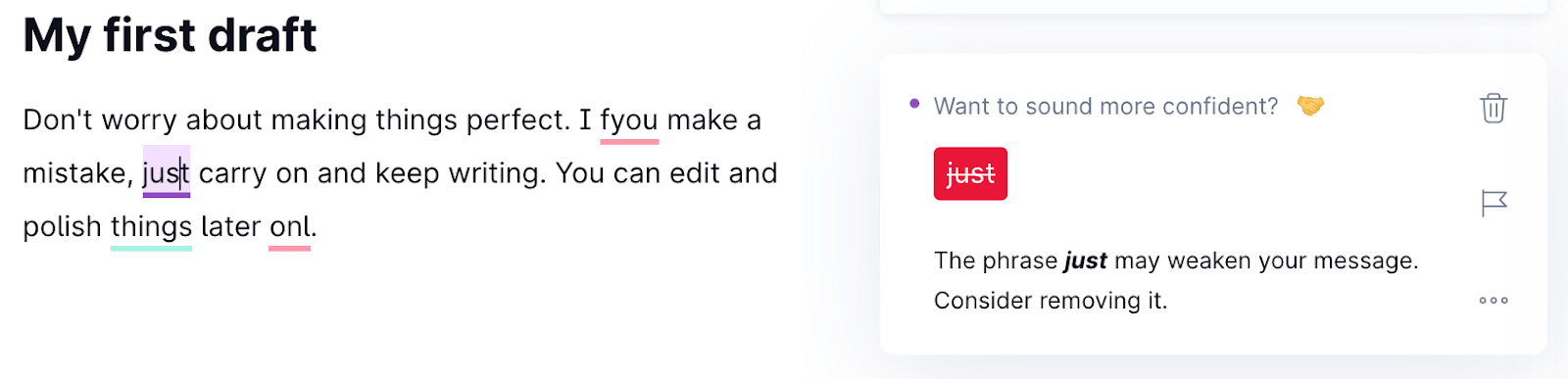

Corriger les fautes d’orthographe et de grammaire

La plupart des traitements de texte et des applications d’écriture sont dotés d’une vérification orthographique intégrée, vous n’avez donc pas besoin d’être un génie pour bien faire les choses. Faites un clic droit et choisissez la bonne orthographe.

Pour la grammaire, exécutez votre brouillon via un outil appelé Grammaire. Cela vous indiquera les virgules et les phrases mal placées qui n’ont aucun sens.

Assurez-vous qu’il coule

Si votre contenu semble anormal ou robotique, il est temps de reformuler.

Rester simple

La plupart des Américains lire en dessous d’un niveau de lecture de huitième année. Si vous utilisez des phrases et des mots complexes, cela va dérouter les lecteurs, et ils n’hésiteront pas à appuyer sur le bouton de retour.

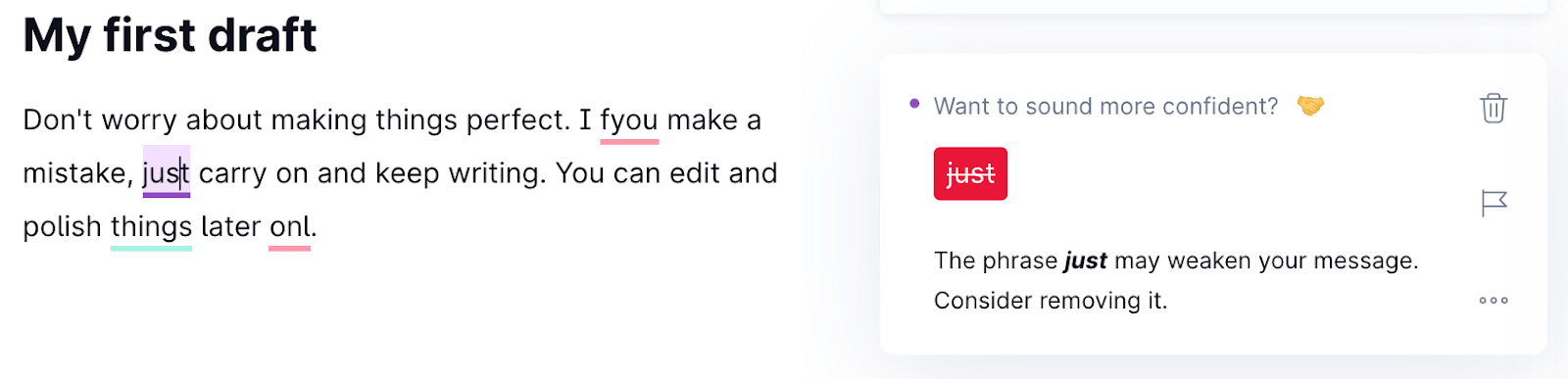

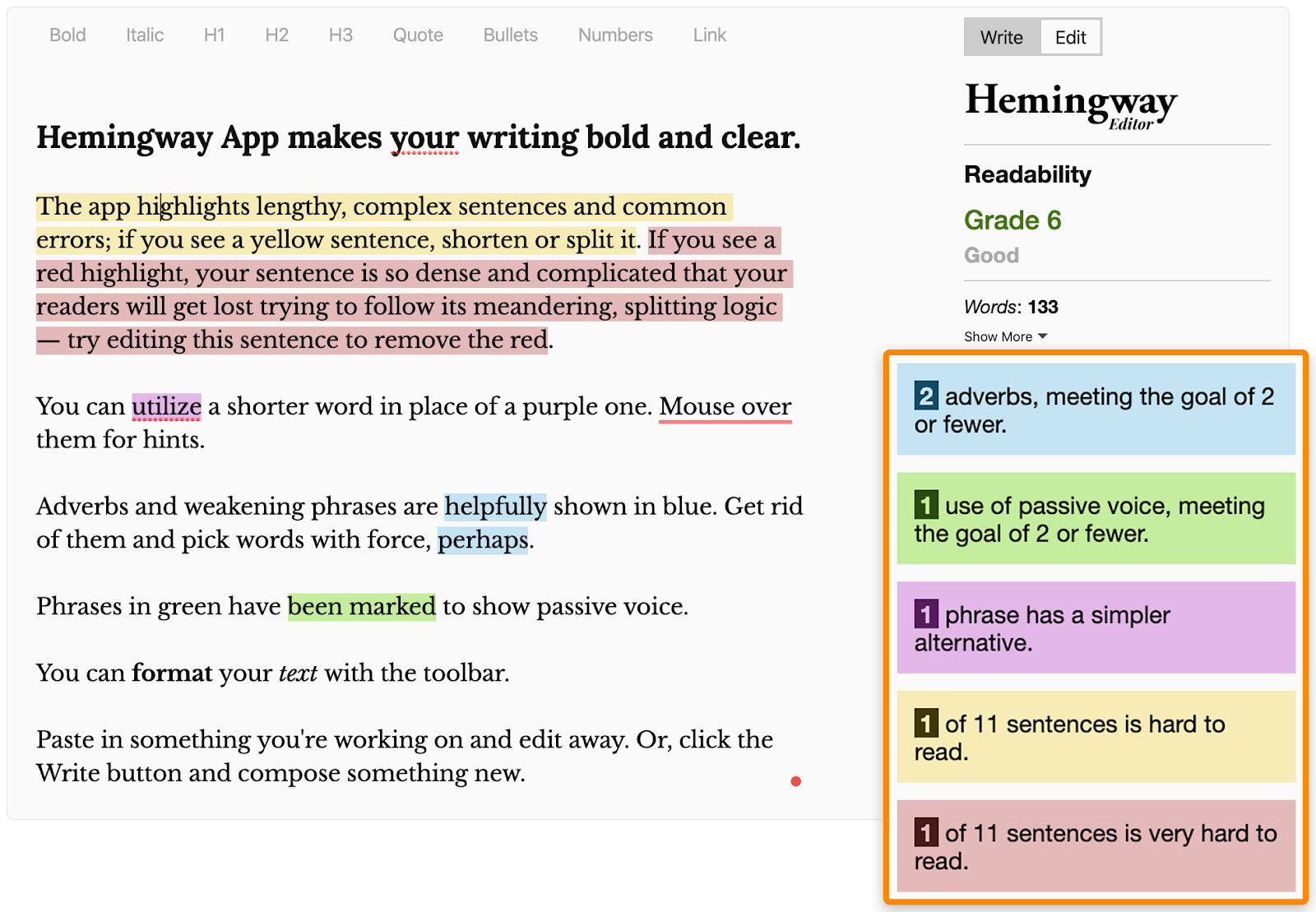

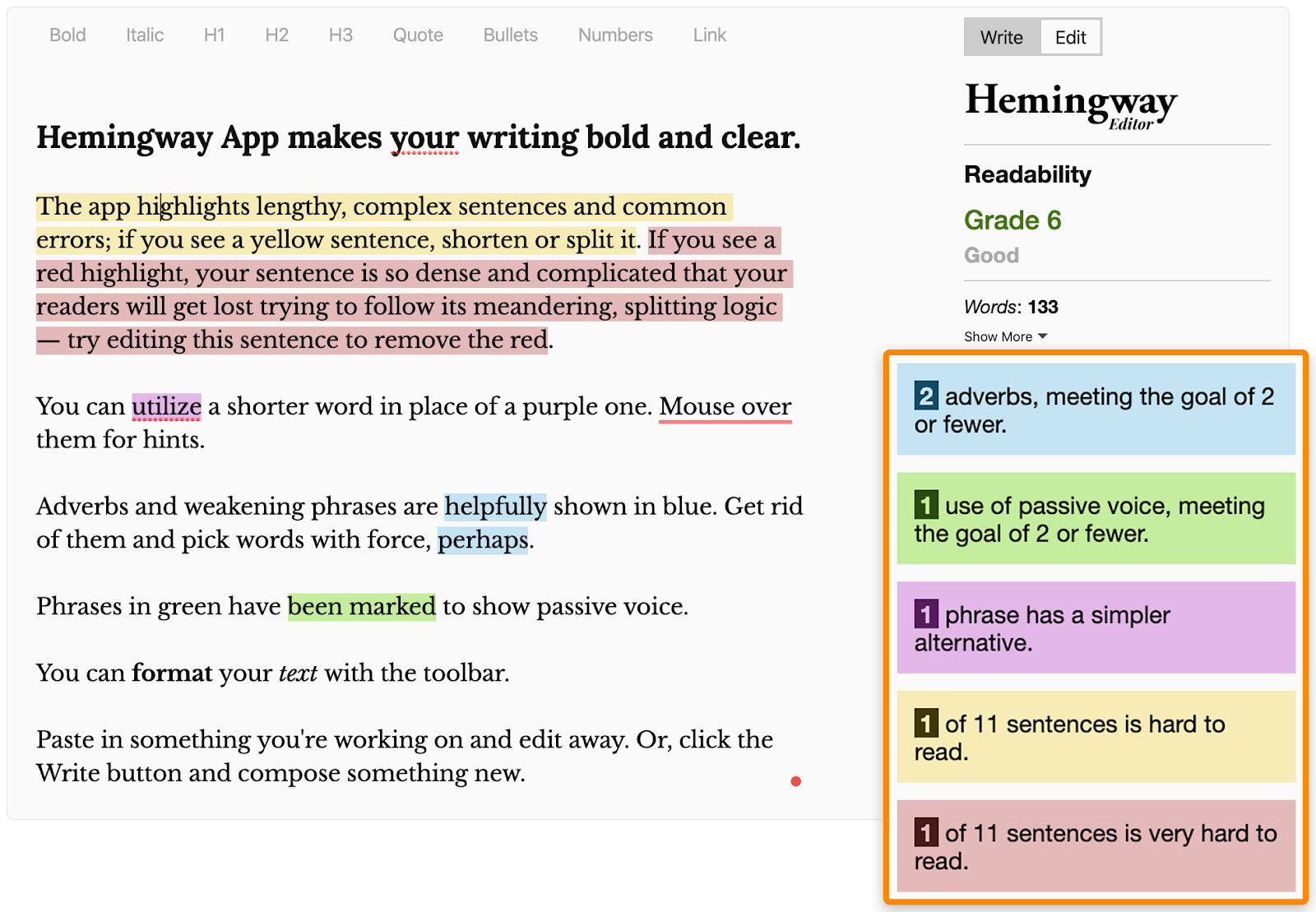

Résolvez cela en exécutant votre brouillon Hemingway.

Il s’agit d’un outil gratuit basé sur un navigateur qui vous aide à simplifier votre contenu en utilisant des phrases, des paragraphes et des mots plus simples.

Avoir un retour

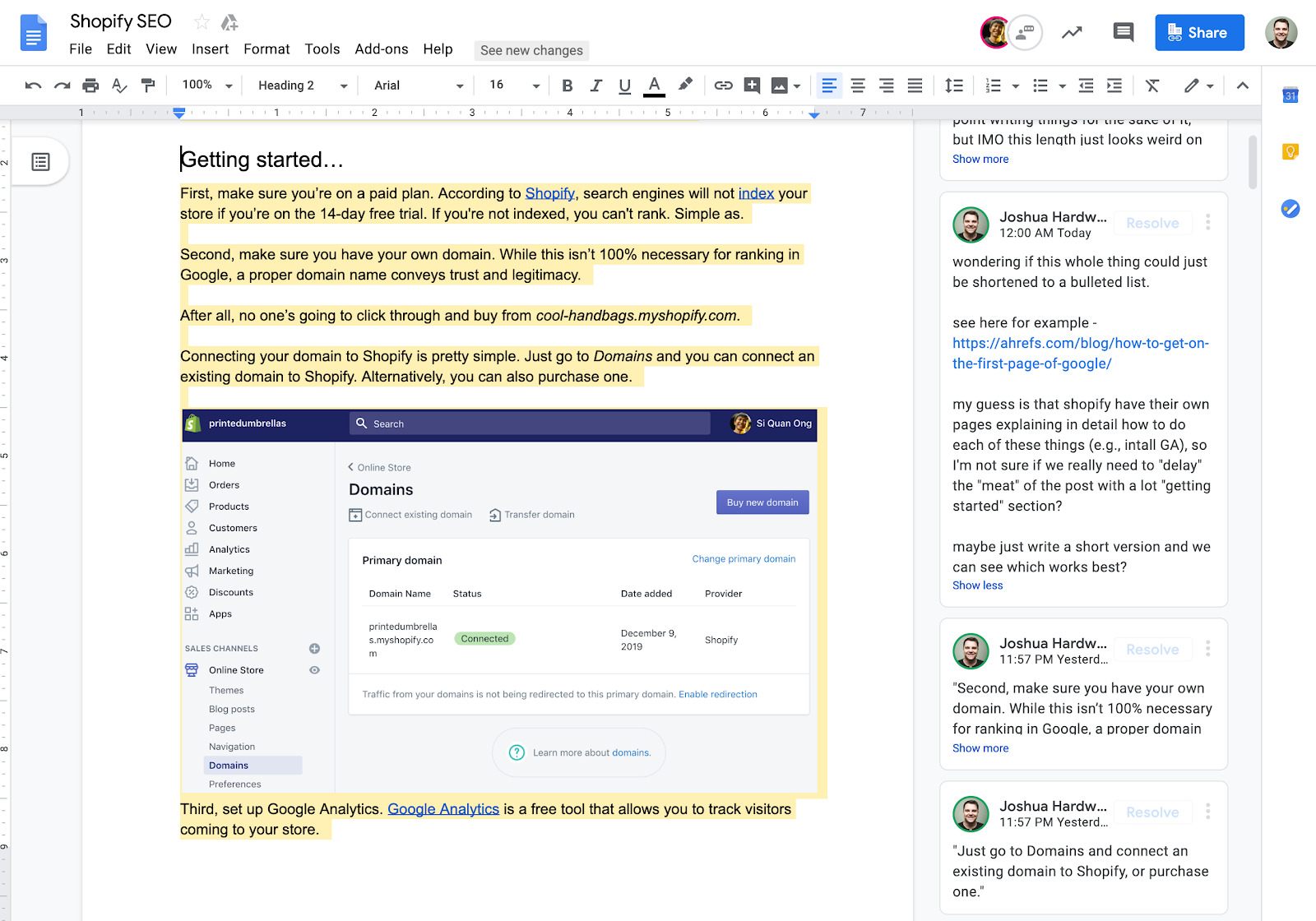

Bien sûr, il est déchirant d’entendre que votre contenu n’est pas à la hauteur. Mais la vérité est que l’opinion des autres peut aider à améliorer les choses de façon exponentielle.

Envoyez votre brouillon à un ami, dites-lui d’être honnête, aplanissez les plis.

6. Rendez votre contenu visuellement attrayant

Personne n’aime lire un mur de texte. Si vous avez écrit plus de quelques phrases, vous devez travailler pour briser la copie.

La façon la plus évidente de le faire est avec les images.

Ils n’ont pas besoin d’être spéciaux. Vous remarquerez que beaucoup de nos articles sur le blog Ahrefs incluent des captures d’écran annotées comme celle-ci:

Une capture d’écran de l’un de nos articles de blog.

Non seulement cela facilite le survol des choses, mais cela aide également à démontrer ce que nous essayons d’expliquer.

Vous pouvez également utiliser des vidéos pour ce faire:

Une vidéo intégrée à l’un de nos articles de blog.

De nombreuses études montrent que les visuels aident les gens à comprendre et à comprendre le contenu.Inclure des images et des vidéos utiles peut donc améliorer la satisfaction des utilisateurs, ce que nous savons important pour Google.

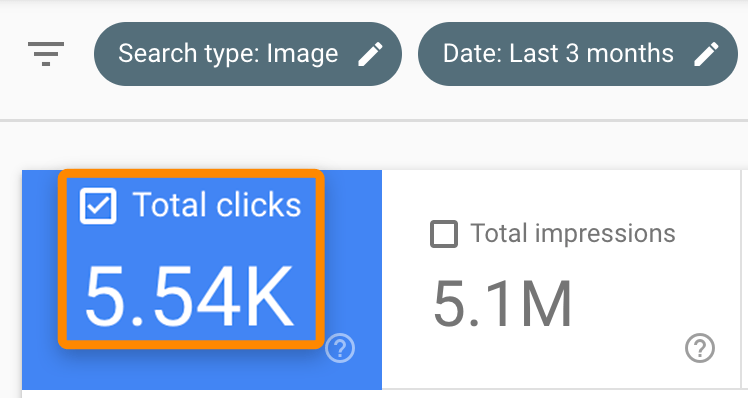

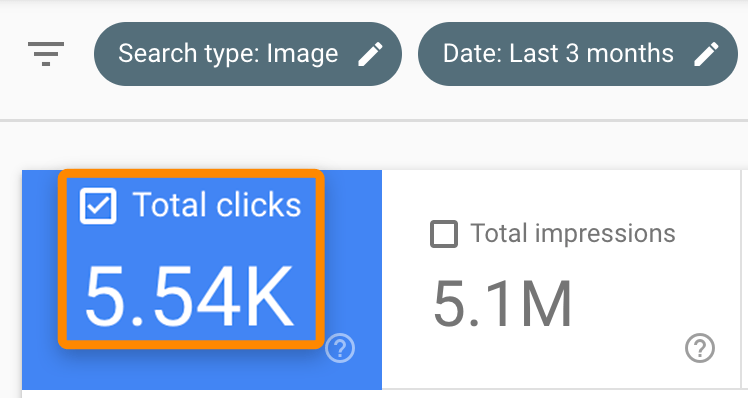

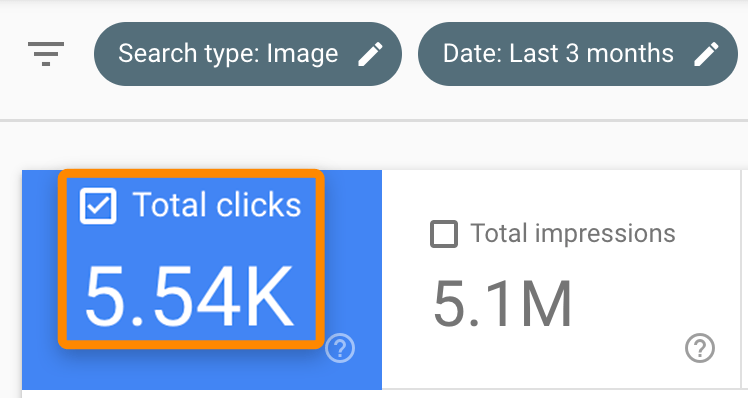

L’ajout d’images et de vidéos peut également aider votre contenu à se classer dans les onglets images et vidéos de Google.

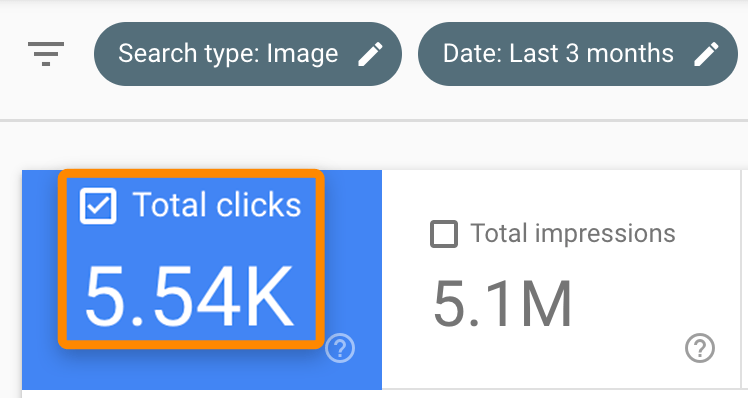

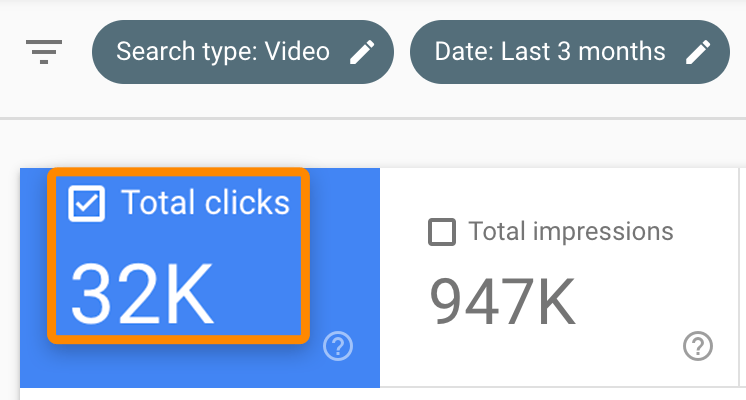

N’oubliez pas cela. Nous avons enregistré plus de 5 500 visites de Google Images au cours des trois derniers mois…

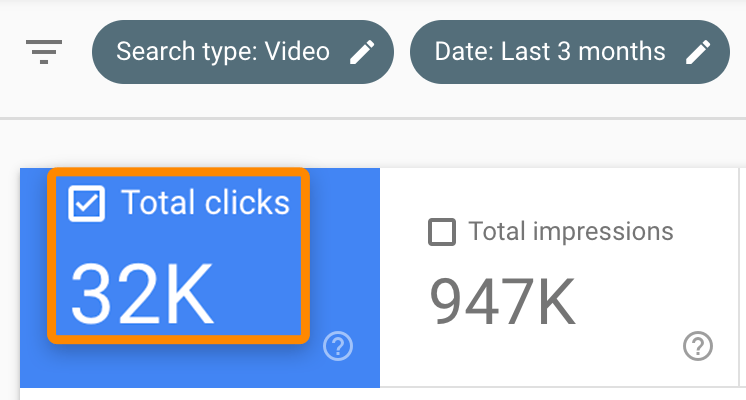

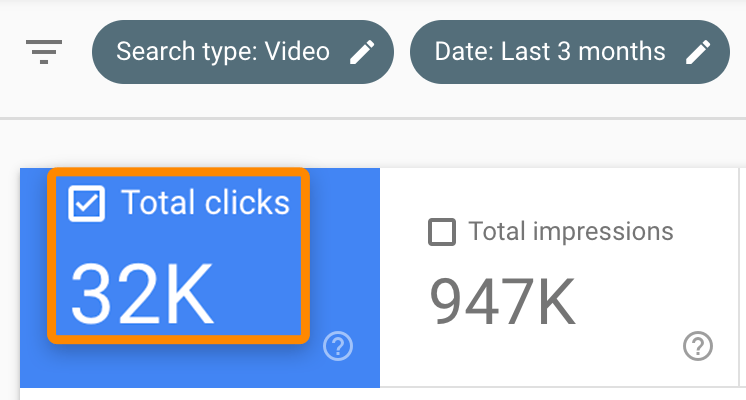

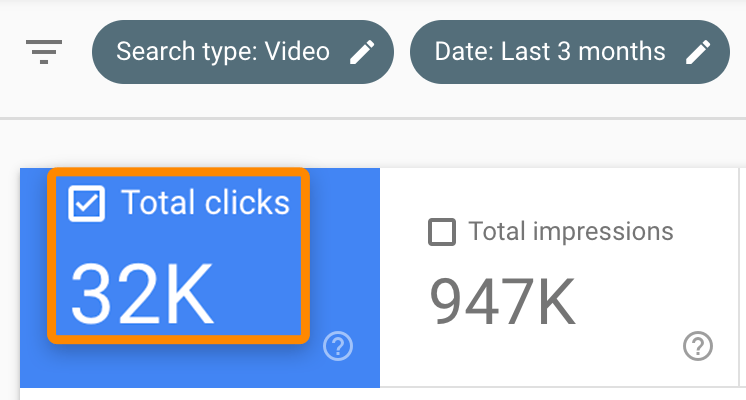

… Et 32 000 résultats vidéo:

Mais les images et les vidéos n’ont pas toujours de sens. Donc, une autre chose que vous pouvez faire est de casser de longs morceaux de texte en sous-sections en utilisant H2-H6 en-têtes.

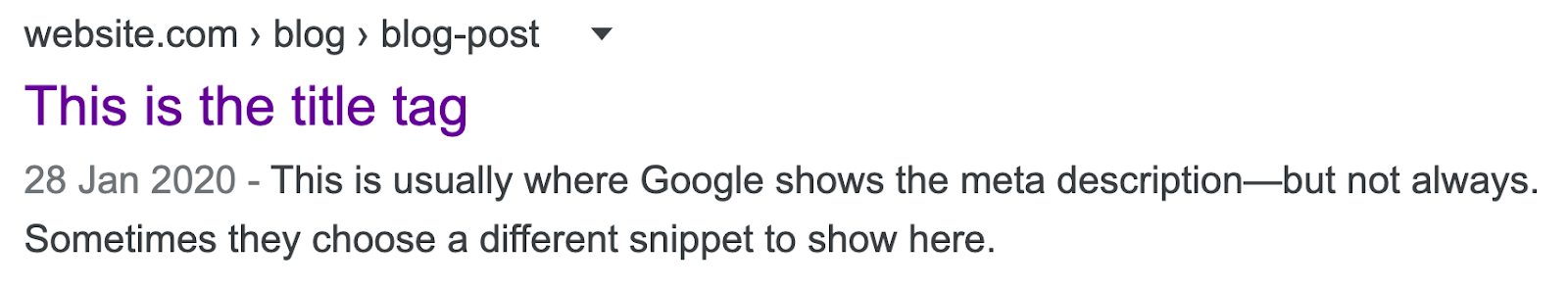

7. Rédigez un méta-titre et une description convaincants

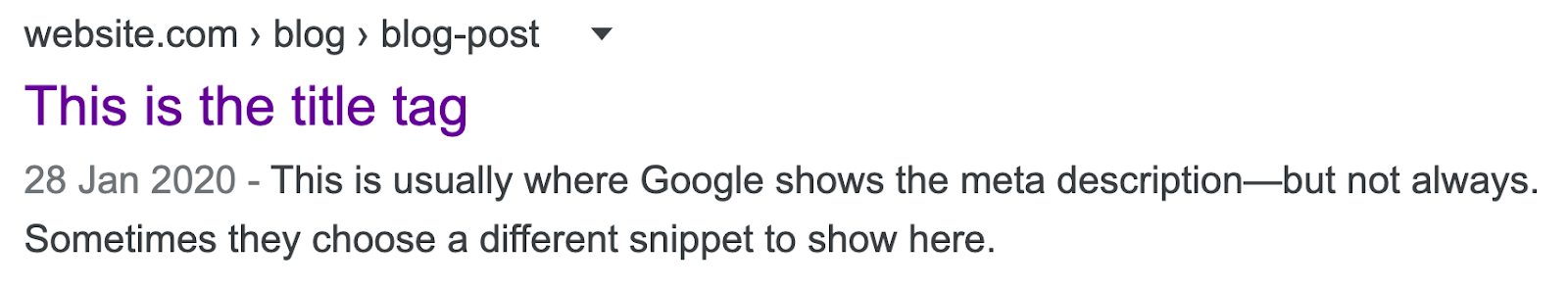

Les moteurs de recherche voient plus que le texte de la page. Ils examinent les métadonnées dans le code de la page pour en savoir plus sur votre contenu.

Les deux éléments de métadonnées les plus importants sont votre méta-titre et votre description. Ces deux éléments apparaissent dans les résultats de recherche de Google, et ils sont effectivement votre argument de vente auprès des chercheurs. Utilisez-les pour expliquer pourquoi ils devraient cliquer et lire votre message.

Sidenote.

Google réécrit parfois ces deux choses, donc ce que vous définissez n’est pas toujours ce qui apparaît dans le SERP. Mais il vaut toujours mieux les régler.

Il s’agit d’un autre endroit où il est utile de faire correspondre l’intention de recherche.

Quelle que soit la valeur des chercheurs, insérez-la dans votre balise de titre. Assurez-vous simplement qu’il s’agit toujours d’une description précise de votre contenu. Faites de même avec votre méta description.

Cela attirera plus de clics sur votre page dans les résultats de recherche, ce qui entraînera plus de trafic.

Certains SEO pensent que le taux de clics a également un impact sur les classements, mais Google dit que ce n’est pas le cas, car la mesure est trop bruyante.

D’une manière ou d’une autre. SEO n’est pas seulement une question de classement, mais aussi d’obtenir des clics de la part des chercheurs.

8. Téléchargez votre message

Rien à faire avec SEO, mais voici une astuce pour vous faire gagner du temps si vous utilisez WordPress: écrivez votre contenu dans Google Docs et téléchargez-le avec Wordable.

Il suffit d’un clic pour envoyer votre contenu – complet avec des images – à WordPress. Il est prêt à être publié en quelques secondes.

C’est ce que nous utilisons pour télécharger chaque article sur le blog Ahrefs.

Google nous dit que les deux facteurs de classement les plus importants sont le contenu et les liens.

https://www.youtube.com/watch?v=l8VnZCcl9J4&feature = youtu.be&t = 1820

Ainsi, bien que la création de contenu parfaitement optimisé soit souvent suffisante pour un classement pour des sujets moins compétitifs, les liens sont toujours importants pour les sujets plus difficiles pour lesquels de nombreuses marques souhaitent se classer.

Mais voici le problème: le contenu et les liens sont quelque peu entrelacés.

En d’autres termes, personne ne veut établir de lien avec un contenu pauvre ou médiocre; ils renvoient vers du contenu précieux pour leurs visiteurs.

Bien que la création de liens soit un sujet distinct et complexe en soi, il existe des moyens d’utiliser votre contenu pour améliorer votre capacité à gagner des liens.

1. Faites-en la ressource incontournable sur un sujet

Retirez cela, et les gens sont plus susceptibles de créer un lien vers votre guide par rapport aux autres.

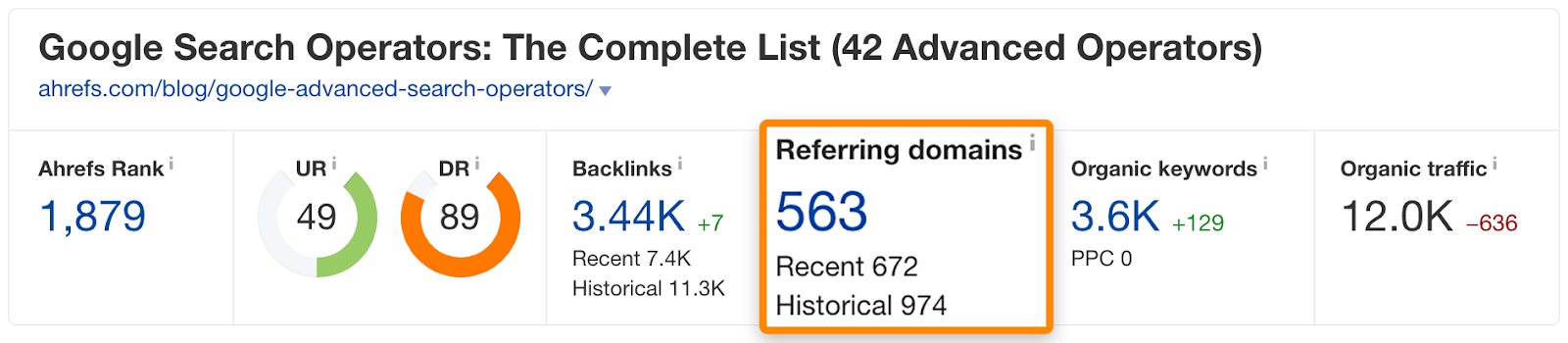

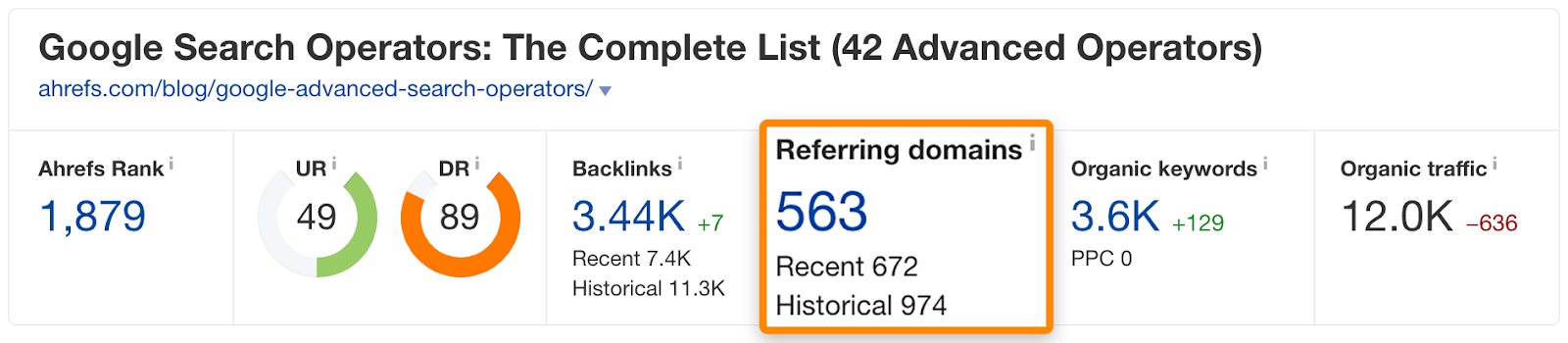

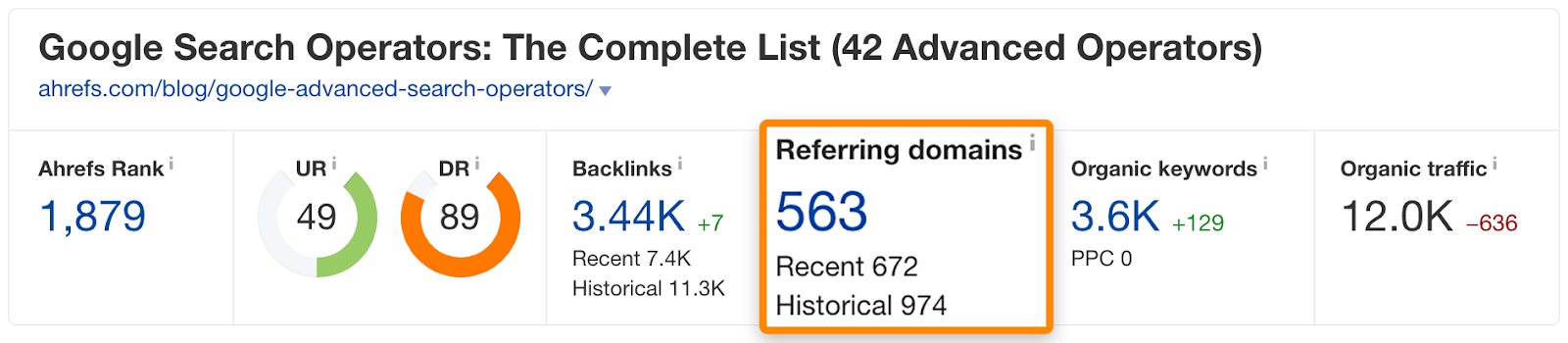

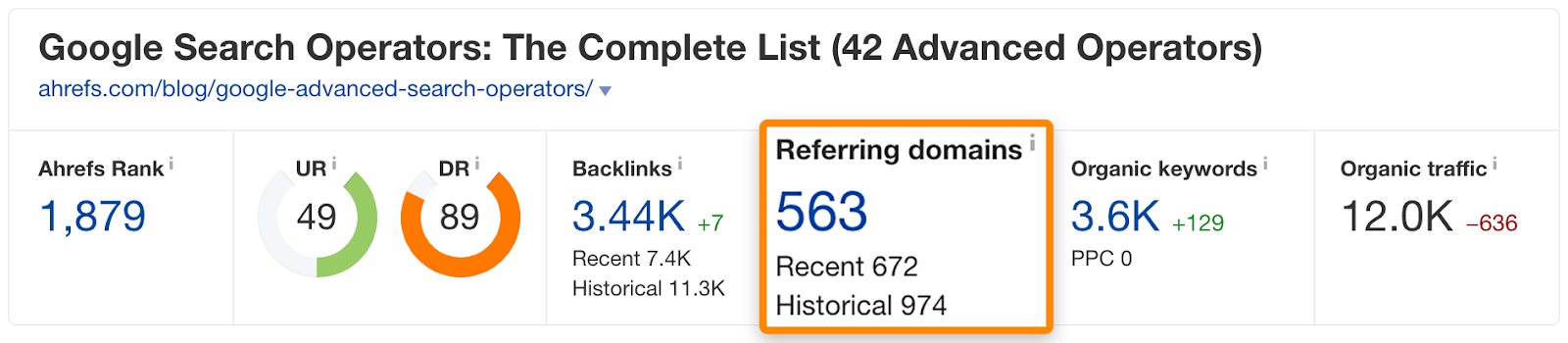

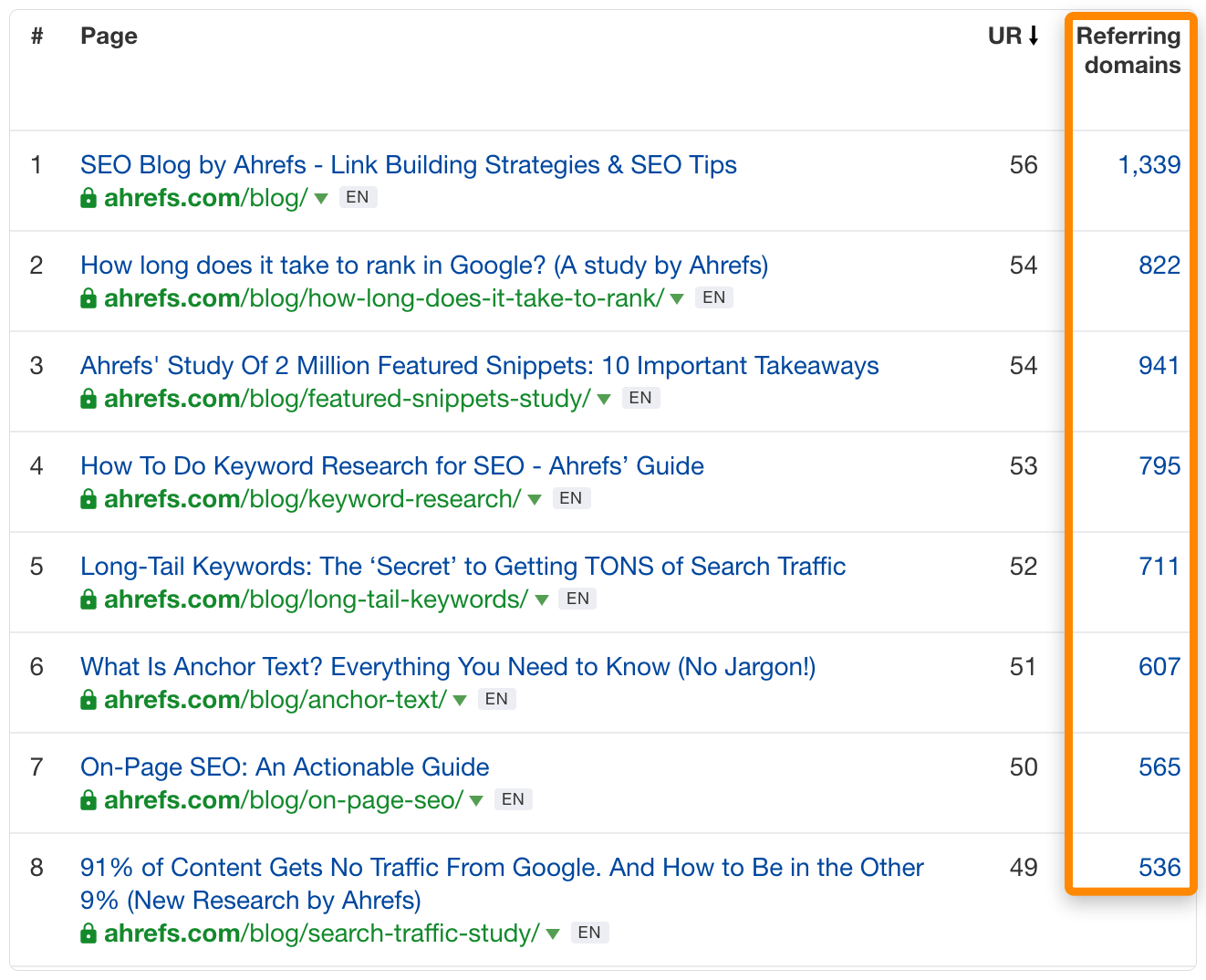

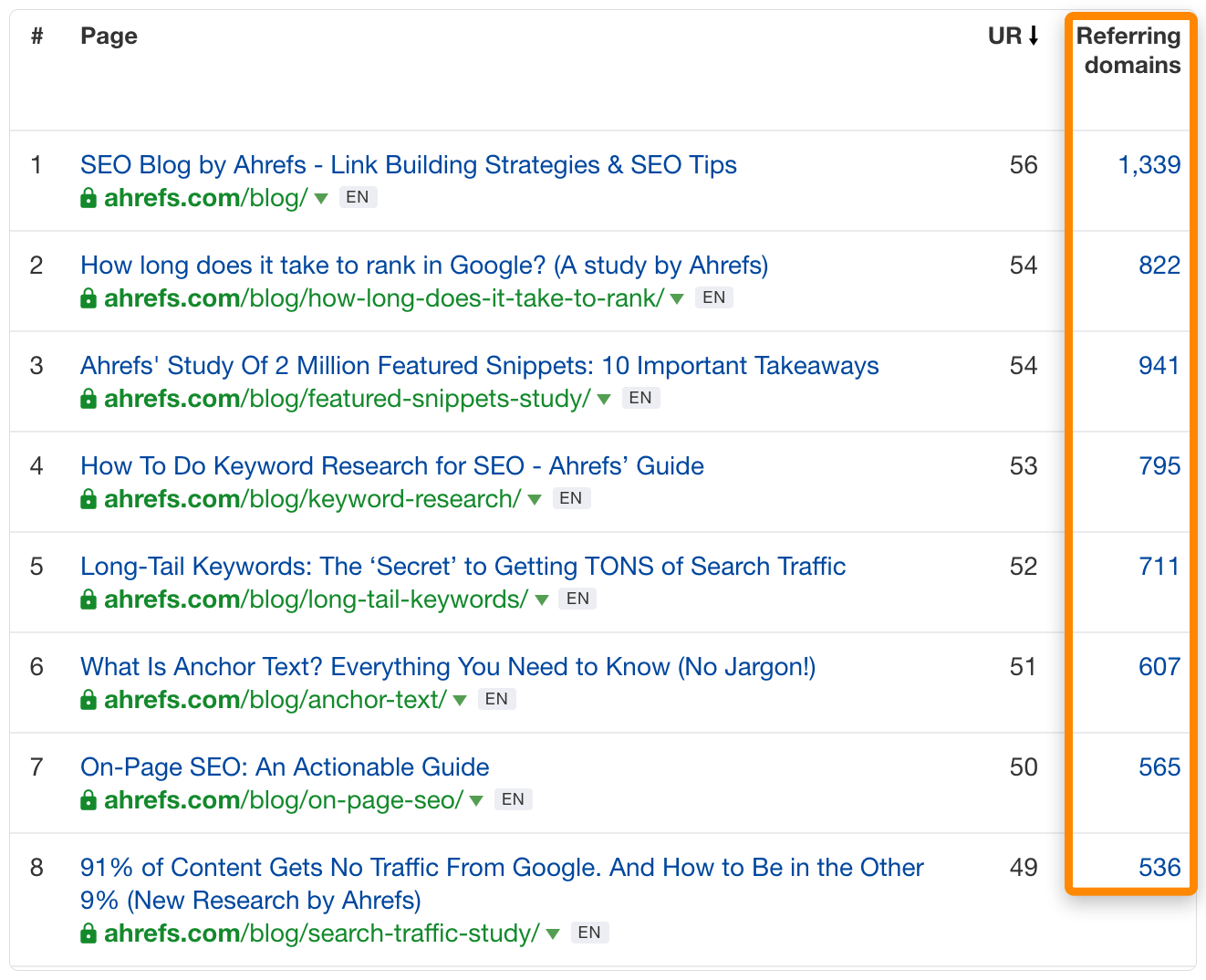

Nous l’avons fait avec notre guide des opérateurs de recherche Google, qui a attiré des backlinks de plus de 560 sites Web:

2. Inclure des données uniques

Avoir des données uniques signifie que les gens doivent vous citer comme source lorsqu’ils citent ces données.

C’est pourquoi nos études obtiennent généralement des tonnes de liens:

3. Rendez-le aussi accessible que possible

Les gens ne vont pas créer de lien vers quelque chose qu’ils trouvent déroutant ou difficile à lire. (C’est une autre raison pour laquelle l’étape # 6 est si importante).

Dernières pensées

Suite à une expérience éprouvée SEO un cadre pour écrire du contenu est logique, et il améliore certainement vos chances de classement. Mais il est important de se rappeler que les choses ne fonctionnent pas toujours, même si vous faites tout «correctement».

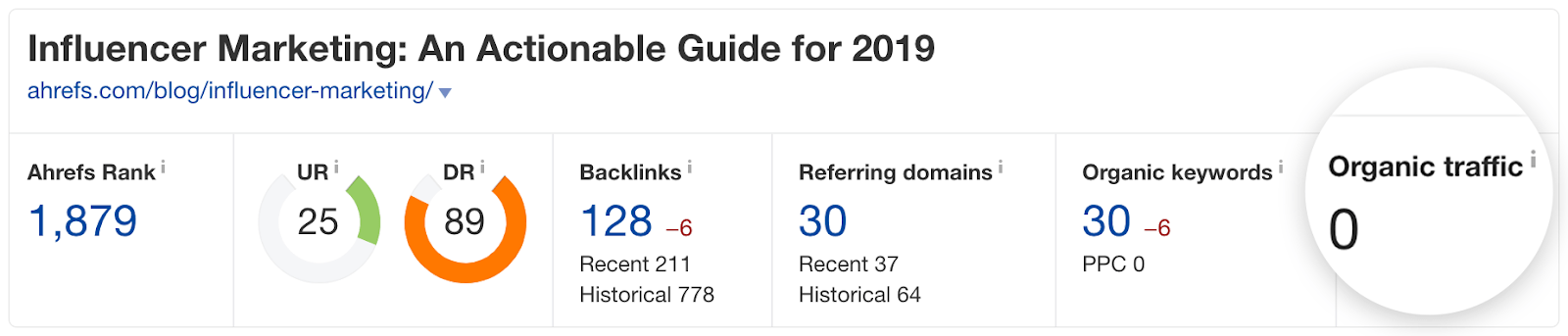

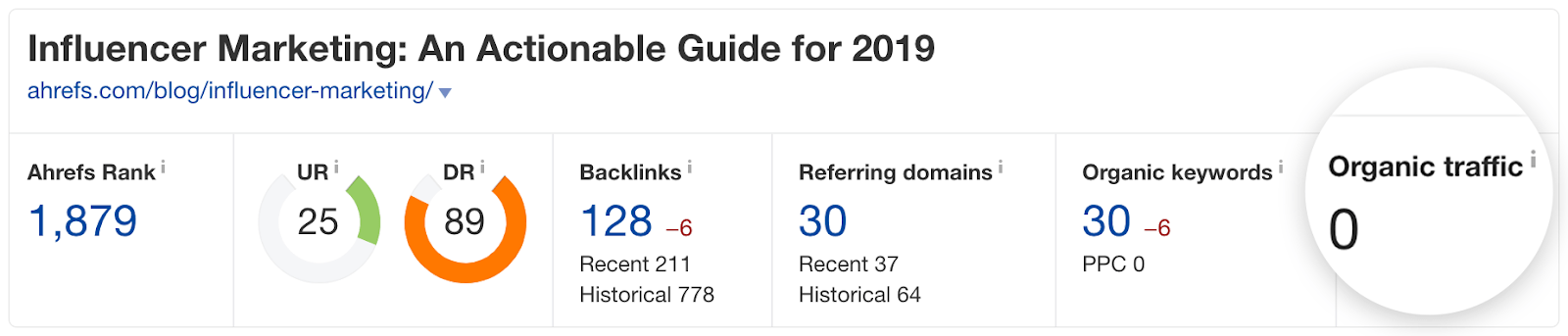

Regardez simplement le trafic vers notre article sur le marketing d’influence:

C’est un sujet qui a fait ses preuves, la publication s’aligne sur l’intention de recherche et couvre le sujet de manière exhaustive … mais elle ne se classe même pas dans le top 100.

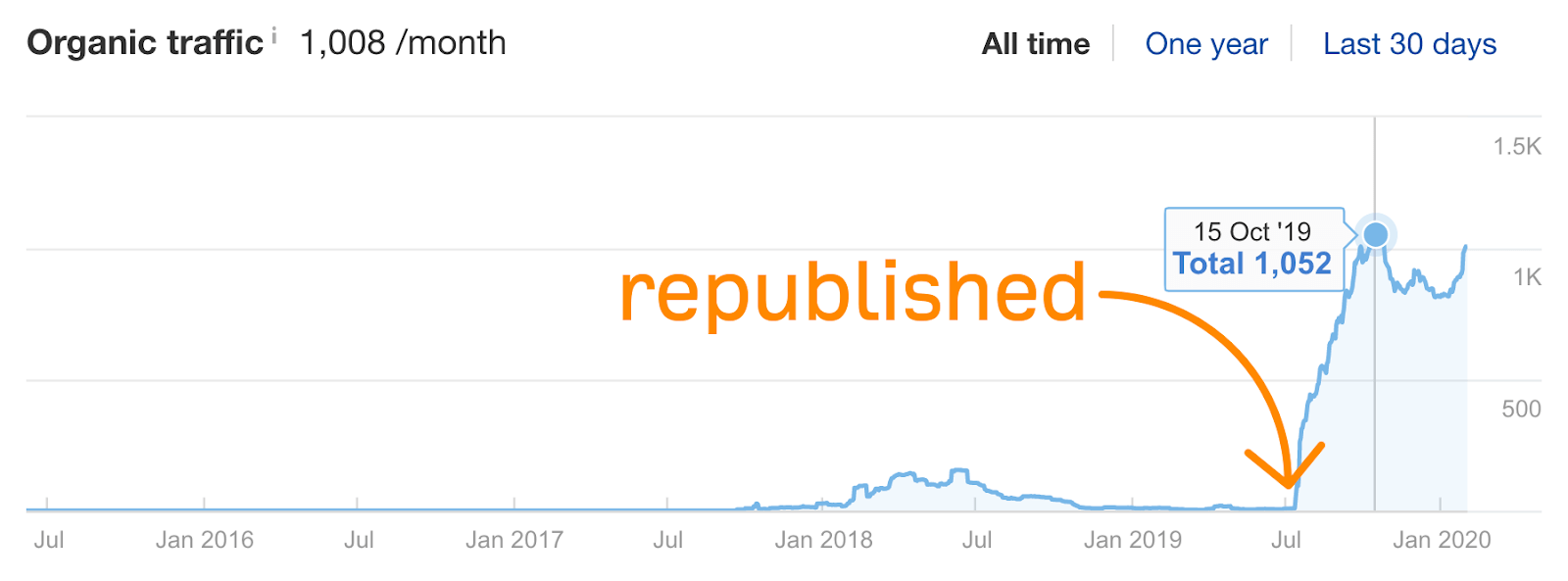

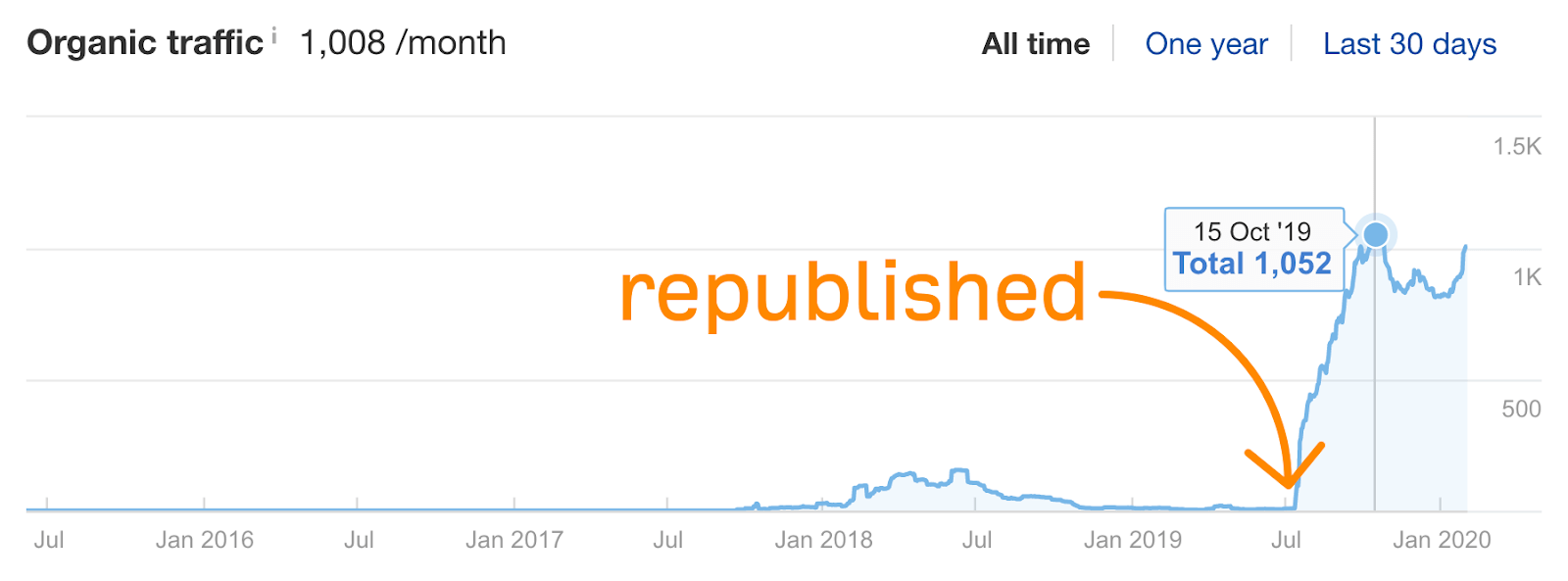

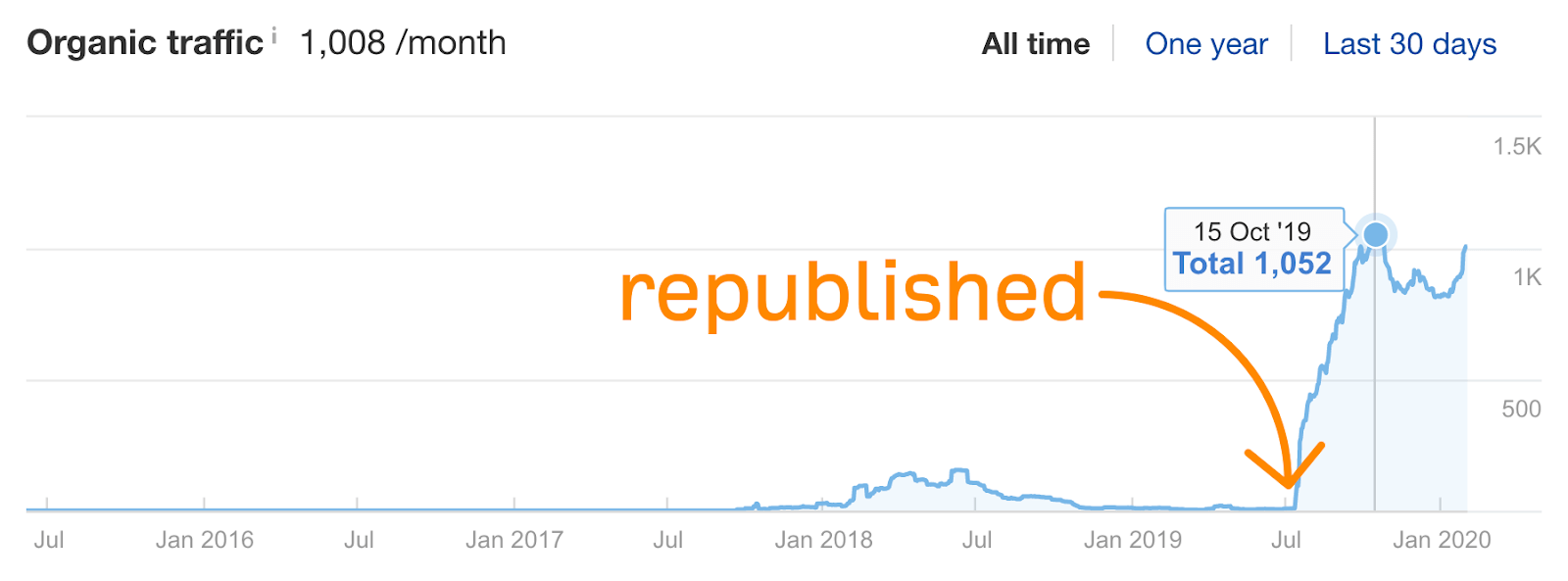

Si cela se produit, ce n’est pas la fin du monde. Réécrivez et republiez le contenu, puis réessayez.

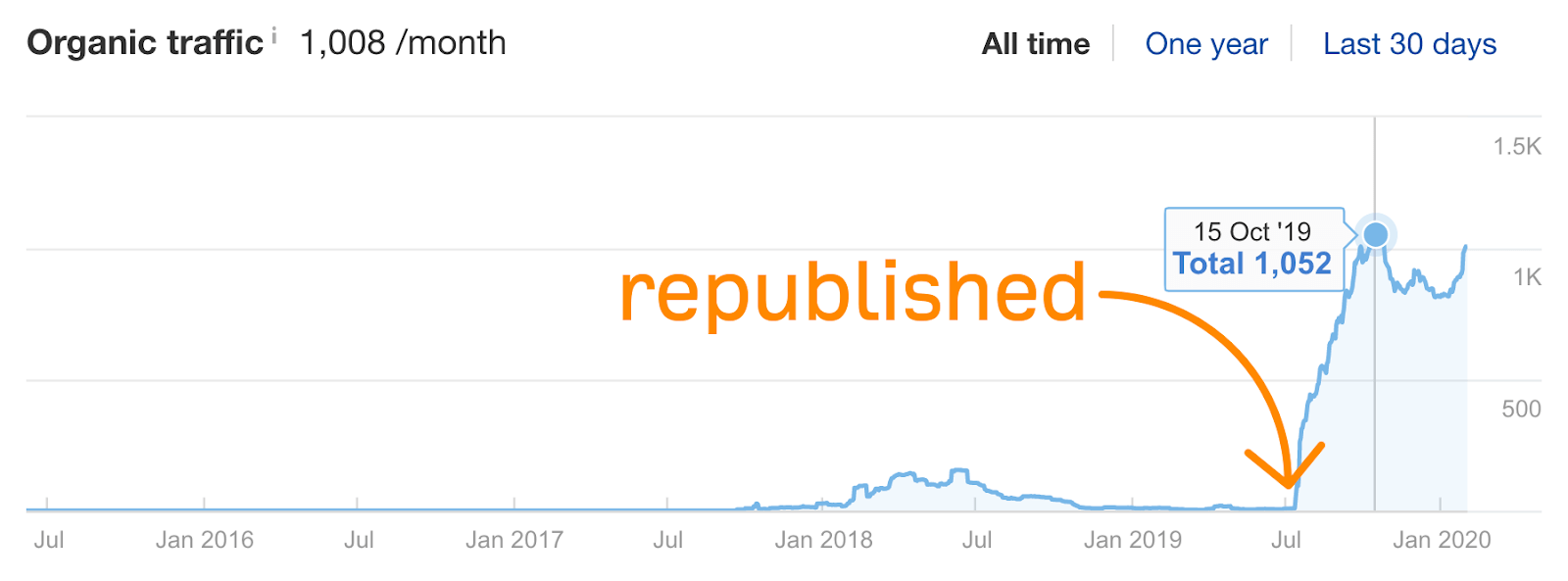

Nous l’avons fait avec notre guide pour générer plus de trafic vers votre site Web, et le trafic et les classements ont traversé le toit:

Vous pouvez également réécrire le contenu lorsque le trafic commence à baisser.

Voici ce que nous avons fait avec notre liste des principales recherches Google:

Avons-nous oublié quelque chose d’important dans ce guide? Donne moi un cri sur Twitter.

Rapport Searchmetrics: comment Amazon et Google s’entraident

Imaginons que vous recherchiez un nouveau grille-pain. Vous utiliserez probablement un moteur de recherche, dont Google est le plus important. Mais bon nombre de ces recherches de produits sur Google profitent au plus grand détaillant du monde, Amazon. Afin de mieux comprendre la relation symbiotique entre Google et Amazon, la plateforme de référencement et de marketing de contenu Searchmetrics a publié une étude basée sur 10 000 mots clés, «Amazon vs Google: la bataille pour la recherche de produits. «

Ces mots clés génèrent un produit localisé sur Amazon comme le premier résultat organique d’une recherche sur Google Desktop. Aucune recherche avec le mot «Amazon» n’a été incluse.

Pourquoi AdWords?

L’étude a révélé que, même lorsque Amazon a le premier résultat de recherche, il a également au moins un – et parfois plus – résultats de recherche organiques supplémentaires de niveau inférieur pour près de la moitié des recherches.

Et ce n’est pas tout. Les listes AdWords pour les produits sur Amazon s’affichent à côté des recherches de produits sur Google pour 10,5% des mots clés, au-dessus ou en dessous des résultats de recherche naturels. AdWords s’appelle désormais Google Ads, mais le rapport utilise l’ancien terme pour distinguer les autres types d’annonces Google.

Alors, pourquoi Amazon devrait-il investir dans AdWords payant, s’il est déjà classé premier dans les résultats de recherche Google pour autant de produits?

La raison, comme détaillé dans l’étude Searchmetrics: AdWords donne à Amazon une présence dominante sur la page de résultats pour ces recherches de produits.

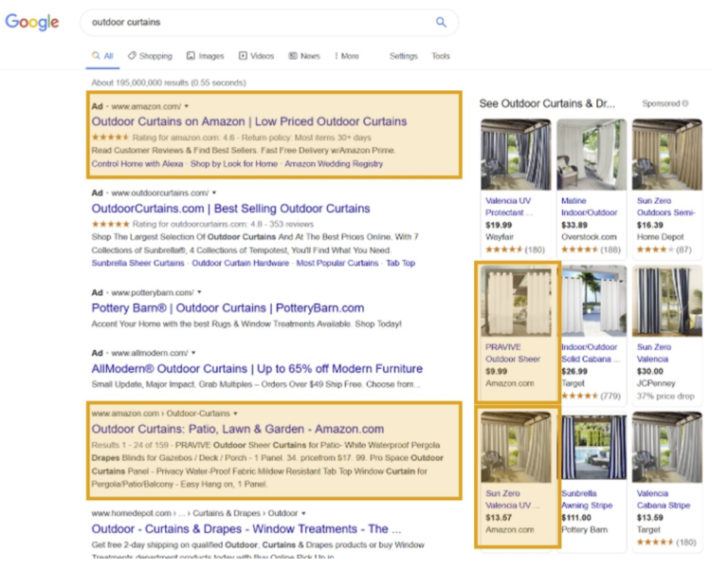

Amazon aide Google

Voici une capture d’écran de l’étude, montrant les résultats de Google pour le terme de recherche « rideaux d’extérieur ». Le produit sur Amazon est le premier résultat organique, mais l’annonce Amazon AdWords est le premier retour sur la page, plus le produit vendu par Amazon est affiché dans deux annonces dans la boîte d’annonces Google Shopping correspondante.

À partir du rapport Searchmetrics

Comme le dit l’étude: «Amazon se bat contre ses concurrents en achetant lui-même un grand nombre d’AdWords, même lorsqu’il a le meilleur résultat gratuit. Cependant, comme Google profite à quiconque achète AdWords et qu’Amazon paie pour les annonces malgré le résultat organique le plus pertinent, [Google also benefits]. «

Les annonces Shopping de Google (AKA Product Listing Ads) apparaissent pour 56% des pages de résultats où Amazon est le meilleur résultat organique, et les résultats d’Amazon apparaissent dans près d’un tiers des résultats de la boîte Google Shopping.

L’étude Searchmetrics a déclaré que cela signifie que « l’extrait organique d’Amazon [result] est en concurrence pour attirer l’attention des internautes avec un carrousel d’offres de produits « dans les annonces Google Shopping. Dans certains cas, l’unité Shopping – en particulier si elle est suivie d’un ou deux AdWords payés – peut pousser le premier résultat organique d’Amazon sous le pli pour les utilisateurs de bureau. Mais Amazon est plus que couvert par les annonces AdWords et les annonces de l’unité Shopping.

«Forte présence»

De plus, la plupart des images affichées sur une page de résultats où Amazon est le premier résultat organique incluent une image Amazon.

Lorsque Amazon est le meilleur résultat organique pour les «rideaux d’extérieur» ou autre, le détaillant aura souvent une image de produit affichée chaque fois que Google affiche des images sur la page, ce qui représente environ 44% du temps. Les vidéos associées apparaissent pour près de 35% des recherches.

« Il s’agit d’une forte présence pour un seul domaine », indique l’étude, « et qui souligne l’investissement d’Amazon dans la publicité payante dans la recherche Google, afin de compléter son classement en haut des résultats de recherche. »

Mais Google n’a d’autre choix que de soutenir cette présence d’Amazon pour les recherches de produits, car ce sont des résultats pertinents et parce que les achats AdWords d’Amazon sont une source de revenus substantielle.

Lecture connexe

Les spécialistes du référencement révèlent les tactiques et les tendances les plus efficaces pour la recherche en 2020. Il comprend également la priorité de Google et le sentiment et l’éthique de l’industrie du référencement.

Président et fondateur d’E2M Solutions Inc, vous guide à travers les tendances clés qui peuvent donner des retours marketing par email impressionnants en 2020. Exemples inclus.

La directrice marketing de Fractl, Amanda Milligan, relance son émission de podcast et nous fait découvrir les trois plus grands conseils, apprentissages et expériences de podcast.

Lauren Crain, responsable des services à la clientèle, explique comment les B2B, les B2C et les PME du commerce électronique peuvent aligner les objectifs et les tests pour être sur la bonne voie pour la croissance de 2020.

Comment optimiser le référencement des images?

L’optimisation des pages et des images est l’étape de base de votre référencement. Les moteurs de recherche devenant de plus en plus intelligents, le processus pour obtenir un bon classement dans les moteurs de recherche devient de plus en plus complexe.

Aujourd’hui, il faut bien plus qu’un contenu de qualité pour arriver en première page.

De nombreux facteurs contribuent à un bon classement dans les moteurs de recherche, l’un des plus importants étant l’optimisation des pages.L’optimisation de la page est le pilier de votre référencement et l’un des facteurs importants d’optimisation de la page est l’optimisation de vos photos.

L’optimisation de vos images est l’un des éléments de base de l’optimisation on page. Les images sont une composante visuelle importante d’une page web. On dit qu’une « image vaut mieux que mille mots ».

Si elles sont utilisées correctement, elles peuvent transmettre votre message en un seul coup d’œil, tandis qu’une utilisation négligente des images peut détruire toute votre impression. En outre, les images peuvent être une bonne source de trafic pour Google Image Search et d’autres moteurs de recherche d’images.

Les facteurs d’optimisation d’image les plus importants sont la balise alt, la balise titre, la taille de l’image, le nom de l’image et le lien de l’image.

La balise alt

La balise Alt est probablement le facteur d’optimisation de l’image le plus important. Le texte de la balise alt est affiché à la place de l’image si celle-ci ne peut pas être affichée ou si son chargement prend trop de temps.

La plupart des moteurs de recherche sont basés sur le texte, c’est-à-dire qu’ils ne peuvent pas lire les images et les vidéos. L’emplacement de vos images apparaît comme un espace vide pour les moteurs de recherche. Ces espaces vides ne sont en aucun cas bons pour votre référencement global. La balise alt indique non seulement aux moteurs de recherche qu’une image est placée ici, mais elle les informe également sur le sujet de votre image.

Une bonne pratique pour la balise ALT est de garder vos balises alt courtes mais descriptives.

Remplissez vos balises alt avec des informations utiles pour les moteurs de recherche, mais n’essayez pas d’aller trop loin. Par exemple, la balise alt pour une photo d’une fête d’anniversaire devrait être quelque chose comme ceci : alt= »ma fete d’anniversaire ». Mettre en place toutes ces procédures n’est pas forcément simple lorsque l’on débute et demande un investissement personnel important. SI vous n’avez pas le temps de faire cela vous meme vous pouvez faire appel à une entreprise pour referencement SEO

Taille des images

La taille de l’image est un facteur très important car elle affecte directement le temps de chargement de la page. Il y a plusieurs choses que vous pouvez faire pour vous assurer que vos images ne ralentissent pas la page :

Utilisez le format .jpg plutôt que .png (cela fonctionne dans la plupart des cas)

Compressez vos images avant de les télécharger. Utilisez un des plugins de compression d’images WordPress.

Comment nommer les images pour le référencement

Tout comme les mots-clés sont importants dans l’URL, il en va de même pour les images.

Les noms de fichiers riches en mots clés peuvent aider les robots des moteurs de recherche à déterminer la pertinence de vos images.

Évitez d’utiliser des noms de fichiers d’images par défaut comme « efeiJJF12.jpg », car ils ne donnent pas beaucoup d’informations sur l’image.

Utilisez des noms de fichiers descriptifs avec des mots clés séparés par « – » (trait d’union). Par exemple, « nouveau-pc-portable.jpg ».

14 opérateurs de recherche Google pratiques pour le référencement (une liste complète)

Voulez-vous accélérer votre processus de référencement et faciliter la recherche? Les opérateurs de recherche Google peuvent vous aider à rendre vos pratiques de marketing de contenu efficaces.

Ils vous aident même à identifier de nouvelles opportunités, à effectuer une analyse des concurrents et à auditer votre site pour détecter les menaces potentielles susceptibles de nuire à votre classement.

Dans cet article, nous énumérerons les opérateurs de recherche Google pratiques pour le référencement. Mais avant de révéler les opérateurs de recherche, regardons ce qu’ils sont …

Qu’est-ce qu’un opérateur de recherche Google?

Les opérateurs de recherche Google sont des commandes, généralement sous forme de mots, de caractères ou de symboles, qui vous aident à rendre votre recherche plus spécifique et plus ciblée.

Si vous êtes un spécialiste du marketing de contenu et effectuez des tâches telles que la recherche de mots clés, la génération de sujets de contenu et la vérification des performances SEO de votre site, vous améliorez l’efficacité des opérateurs de recherche Google.

Grâce à ces techniques de recherche simples, vous pouvez rechercher rapidement de nouveaux termes de recherche pour vous classer et trouver des problèmes sur votre site comme des erreurs d’indexation. Vous pouvez même les utiliser pour identifier de nouvelles opportunités de publication d’invités pour obtenir des backlinks et plus encore.

Alors, êtes-vous prêt à en savoir plus sur les opérateurs de recherche Google?

Liste complète des opérateurs de recherche Google

Voici une liste complète des opérateurs de recherche que vous pouvez utiliser pour affiner votre recherche sur Google. Nous expliquerons chaque opérateur de recherche et montrerons également comment vous pouvez les combiner.

1. Obtenez une correspondance exacte avec des devis («»)

Si vous recherchez quelque chose de spécifique ou souhaitez trouver une correspondance exacte de votre requête de recherche, alors les opérateurs de recherche de citations sont utiles. En utilisant des guillemets, Google vous fournira des résultats qui correspondent à l’expression que vous recherchez et exclura tous les autres résultats.

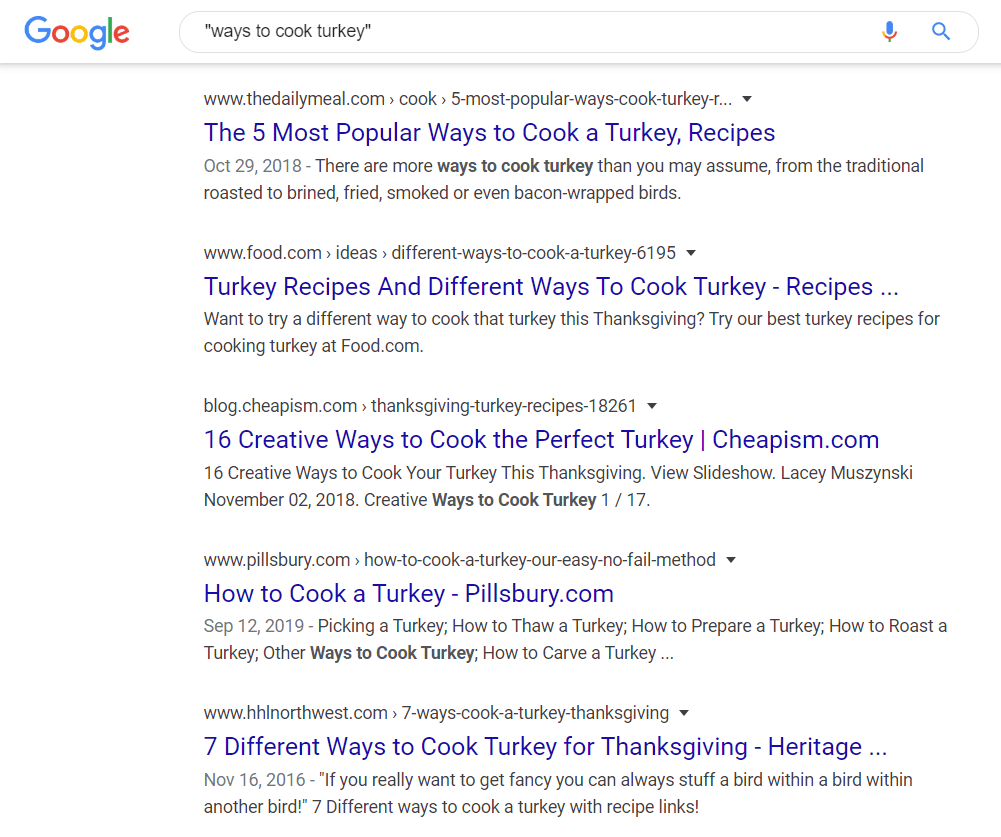

Supposons que vous cherchiez des moyens de cuisiner une dinde mais que vous ne trouviez pas ce que vous voulez. Pour rendre la recherche plus précise, vous pouvez mettre la requête de recherche entre guillemets. De cette façon, vous ne verrez que les pages qui contiennent l’expression exactement comme elle est.

Les opérateurs de recherche de devis sont également un excellent moyen de savoir si quelqu’un a copié votre contenu. Copiez simplement une longue phrase de votre contenu et collez le texte dans Google avec des guillemets.

Si vous voyez des sites Web autres que le vôtre, votre contenu a été supprimé. Vous pouvez alors prendre des mesures contre ces sites Web.

Vous pouvez même utiliser cet opérateur de recherche Google pour trouver du contenu en double pour votre propre site Web. Puisque contenu en double peut affecter vos classements de recherche, il est recommandé de vérifier de temps en temps.

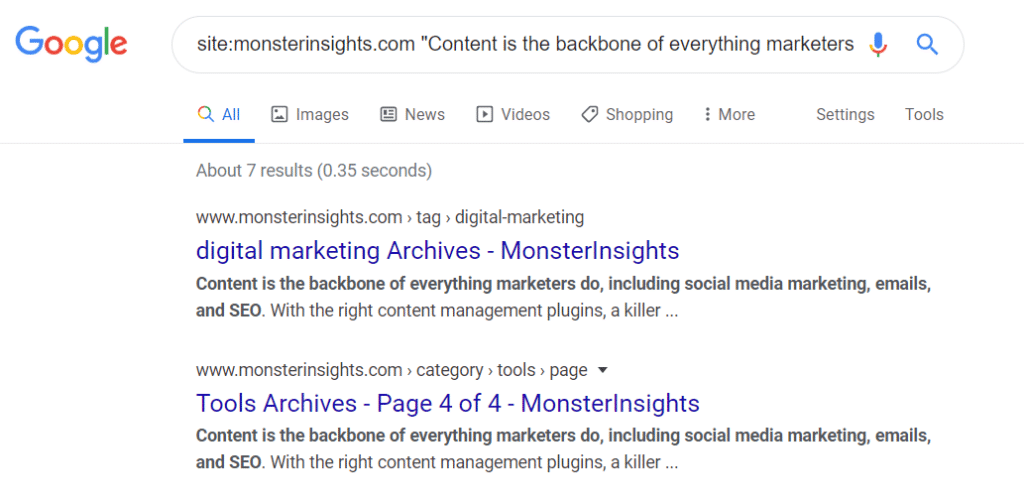

Et si vous souhaitez affiner votre recherche, vous pouvez combiner des devis avec l’opérateur site :. Comment peux-tu faire ça? Laissez-nous vous expliquer…

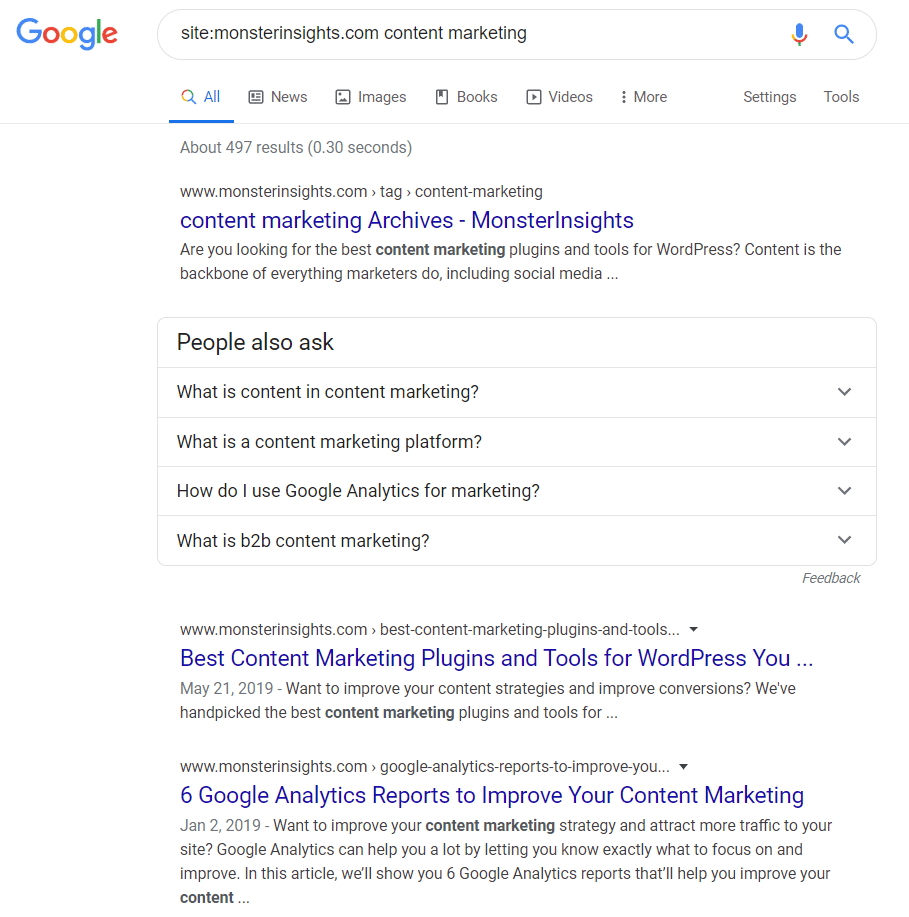

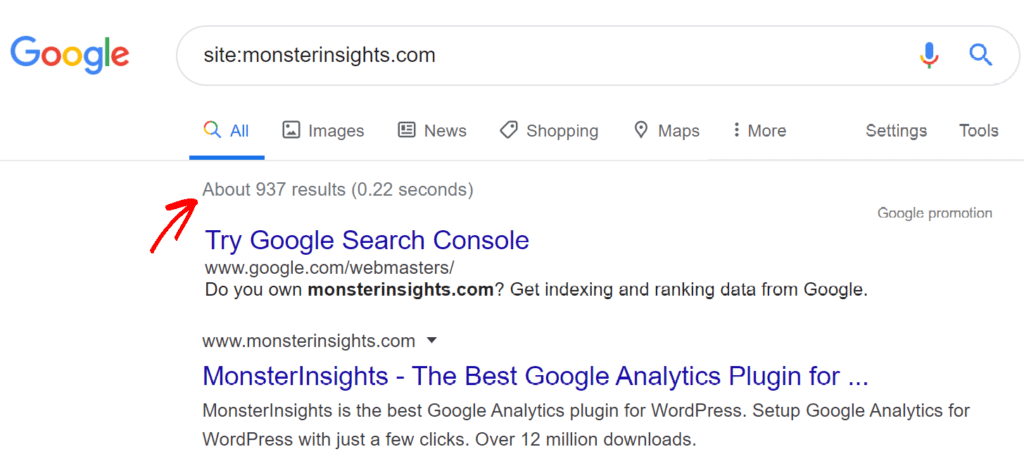

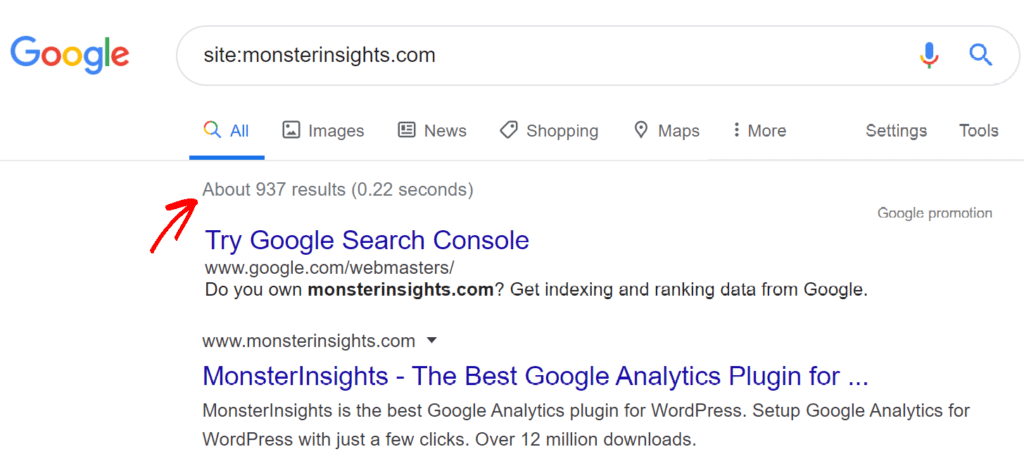

2. Recherche d’un site Web spécifique avec le site:

Voulez-vous des résultats de recherche à partir d’un site Web spécifique? alors site: opérateur est ce dont vous aurez besoin. Il ne fera apparaître que les résultats d’un site Web particulier.

Vous pouvez simplement entrer site: example.com dans le moteur de recherche et Google affichera les résultats de ce site Web. Ou vous pouvez effectuer une recherche à partir de mots clés ou d’expressions spécifiques d’un domaine à l’aide de l’opérateur de recherche.

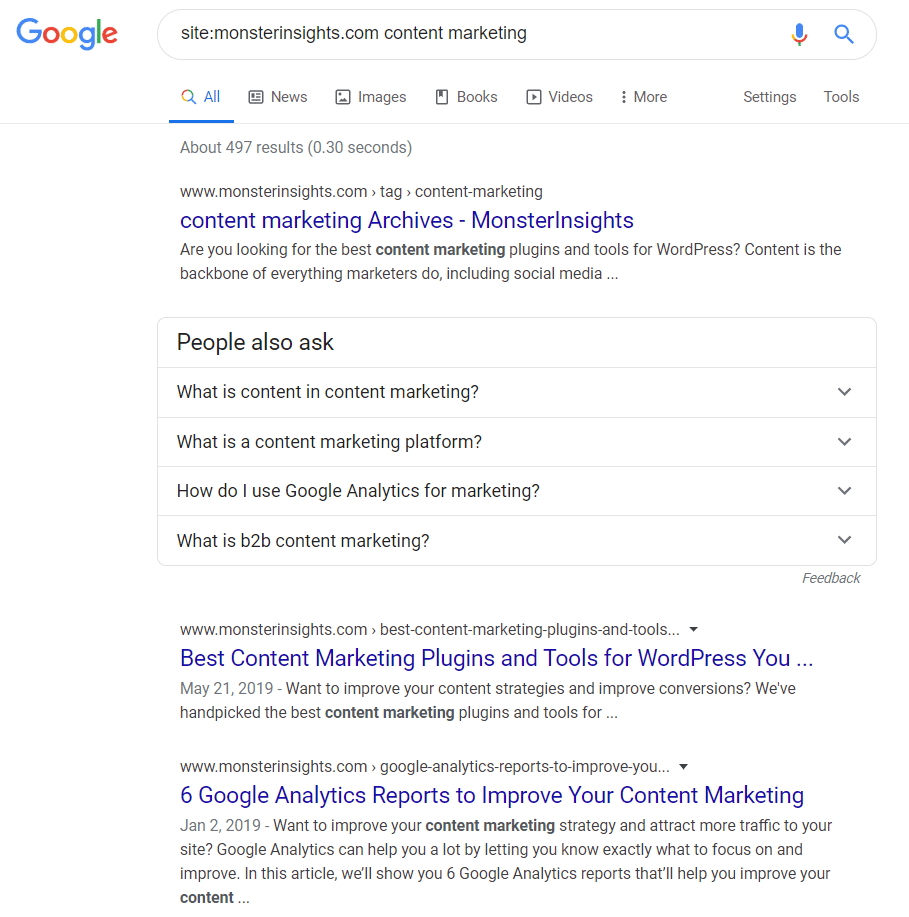

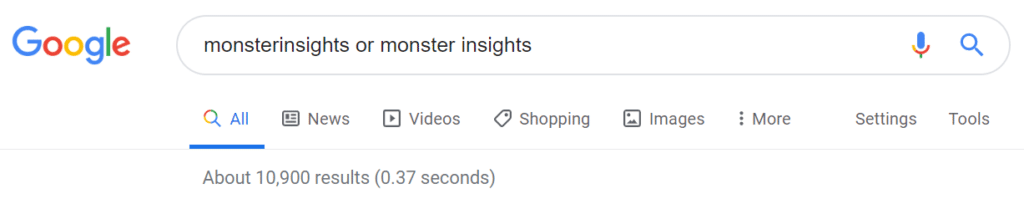

Par exemple, si nous voulons savoir si MonsterInsights a des pages contenant l’expression marketing de contenu, nous allons entrer site: marketing de contenu monsterinsights.com dans le moteur de recherche.

Cet opérateur de recherche est super utile lors de l’analyse de concurrents. Vous pouvez saisir le terme de recherche avec le site Web de votre concurrent et voir ce qu’il écrit sur le sujet.

Il existe plusieurs façons d’utiliser site: opérateur de recherche pour améliorer votre recherche. Comme nous l’avons expliqué dans l’opérateur de recherche précédent, vous pouvez combiner site: et citations pour trouver du contenu en double sur votre site.

Entrez simplement site: votredomaine.com « texte de votre contenu » dans le moteur de recherche. Les résultats afficheront des pages qui ont le même contenu sur votre site Web.

Un autre cas d’utilisation du site: l’opérateur de recherche consiste à rechercher d’éventuelles erreurs d’indexation. Lorsque vous effectuez une recherche sur votre propre domaine, le nombre de résultats doit correspondre au nombre total de pages et de publications que vous avez publiées sur votre site Web.

Si vous pensez que le nombre est plus élevé, vous pouvez approfondir et rechercher les pages qui ne doivent pas être indexées. En revanche, si le nombre est trop faible, vous pouvez savoir quelles pages ne sont pas indexées.

Notez que Google vous fournit une estimation si vous utilisez cet opérateur de recherche. Pour une image plus précise des erreurs d’indexation, vous devez utiliser Google Search Console.

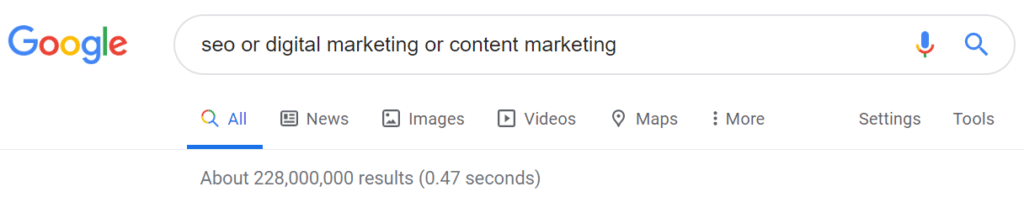

3. Utilisez OU pour rechercher une requête ou une autre

Vous ne savez pas quels mots clés rechercher? L’utilisation d’un opérateur de recherche OU vous aide à afficher les résultats de recherche pour un terme de recherche ou un autre. Vous pouvez également utiliser l’opérateur de recherche pipe (|) comme alternative à OR car il fonctionne de la même manière.

Alors, quand devez-vous utiliser OR? Pour commencer, si vous ne savez pas quel terme de recherche vous donnera le bon résultat que vous recherchez, vous pouvez inclure plusieurs mots clés et les séparer avec OR.

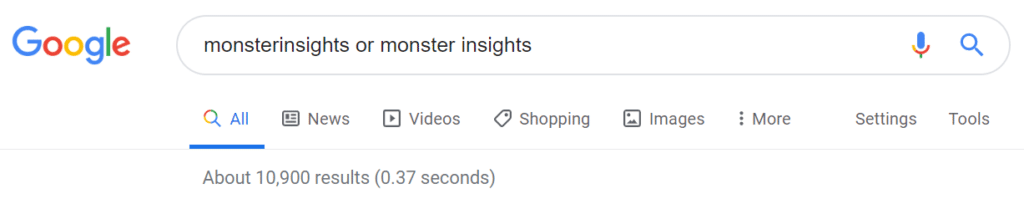

Une autre façon d’utiliser l’opérateur OR est de rechercher les mentions de marque.

Étant donné que les utilisateurs peuvent mentionner votre marque sur n’importe quelle plate-forme et utiliser différentes orthographes, il est difficile de trouver exactement chaque résultat manuellement. Mais si vous utilisez OR dans votre recherche, vous pouvez affiner les résultats.

Conseil de pro: Vous pouvez même créer une alerte Google à l’aide des opérateurs de recherche OU pour recevoir une notification instantanée des mentions de votre marque.

4. Inclure les termes de recherche avec AND

Google utilise par défaut l’opérateur AND dans ses recherches de recherche normale. Si vous ET dans vos recherches, Google vous fournira des résultats liés aux termes de recherche.

Par exemple, si vous recherchez des cupcakes ET des recettes, le moteur de recherche vous montrera les résultats des recettes qui expliquent comment faire des cupcakes. Cet opérateur de recherche Google est utile lorsque vous souhaitez combiner plusieurs opérateurs de recherche.

5. Exclure les termes de recherche en utilisant moins (-)

Maintenant, si vous souhaitez exclure certains mots, expressions ou même sites Web d’une recherche, vous aurez besoin de l’opérateur de recherche moins (-).

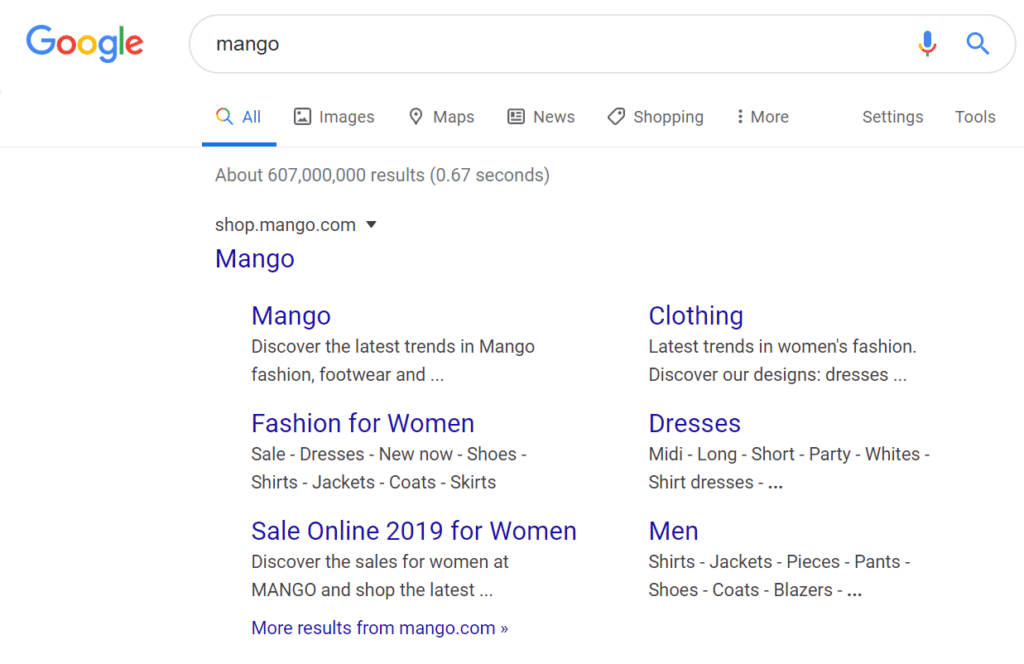

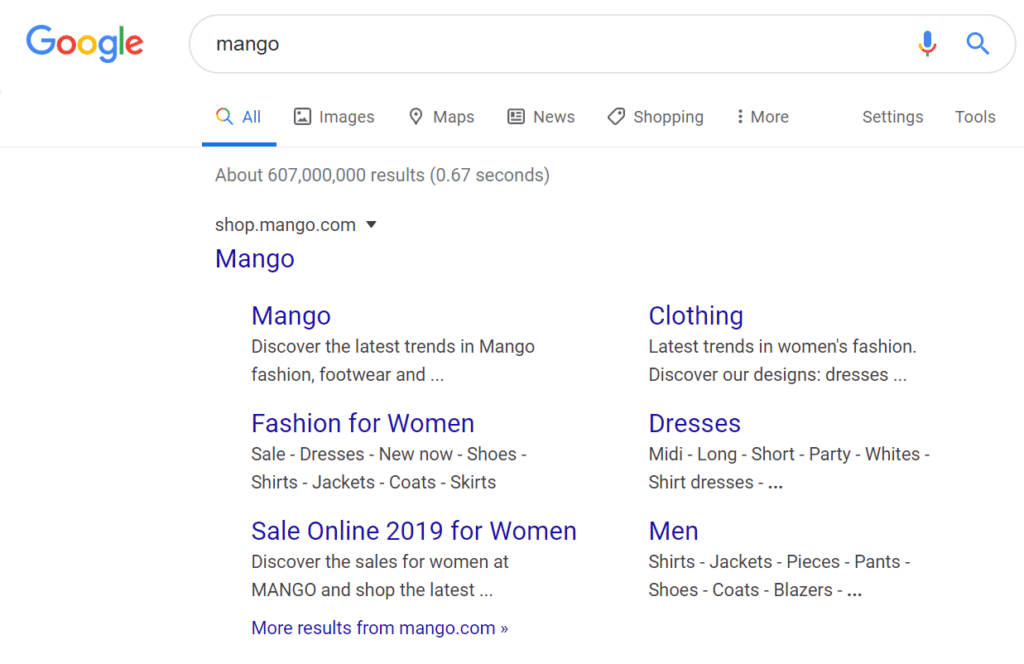

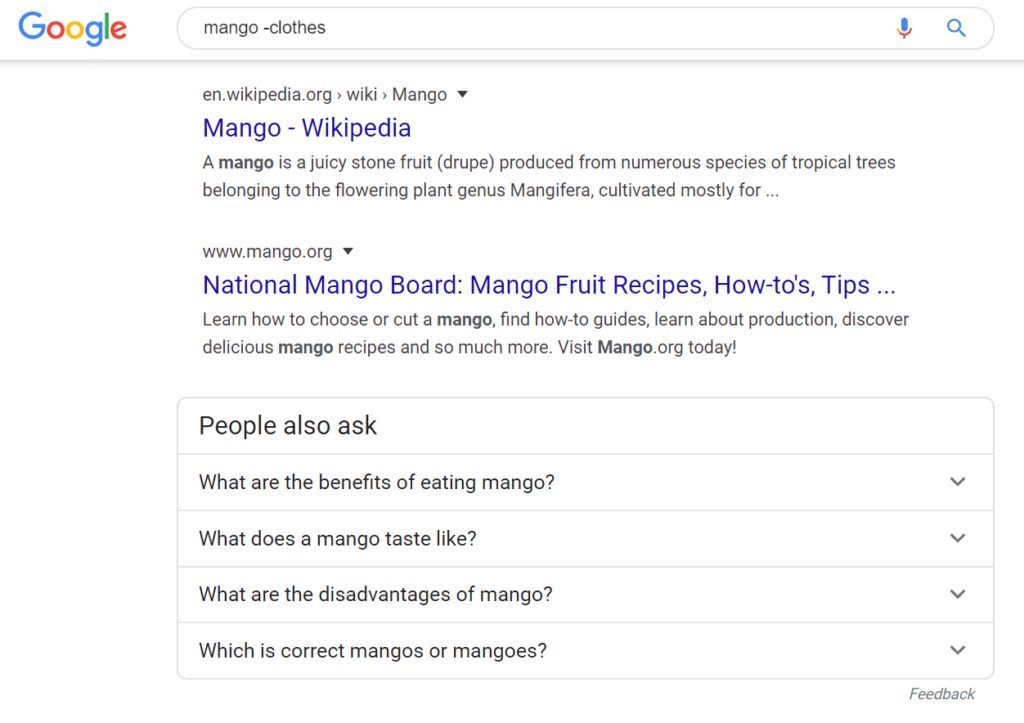

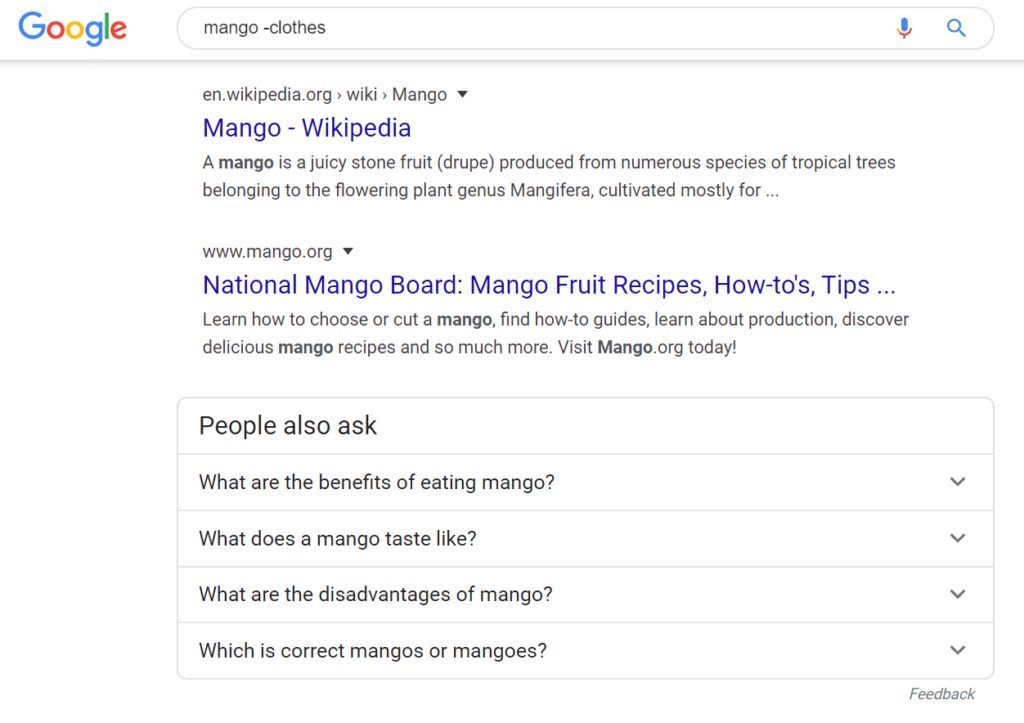

Vous pouvez utiliser moins pour différents cas. Par exemple, supposons que vous souhaitiez en savoir plus sur la mangue aux fruits. Mais lorsque vous recherchez le mot sur Google, le premier résultat que vous verrez est celui de Mango, une marque de vêtements espagnole.

Pour supprimer tout résultat de la marque et obtenir des résultats plus précis sur le fruit, vous pouvez utiliser l’opérateur de recherche moins et saisir mangue-vêtements.

Les résultats ne montreront désormais que des pages sur la mangue (le fruit), ses faits, ses recettes et où les obtenir.

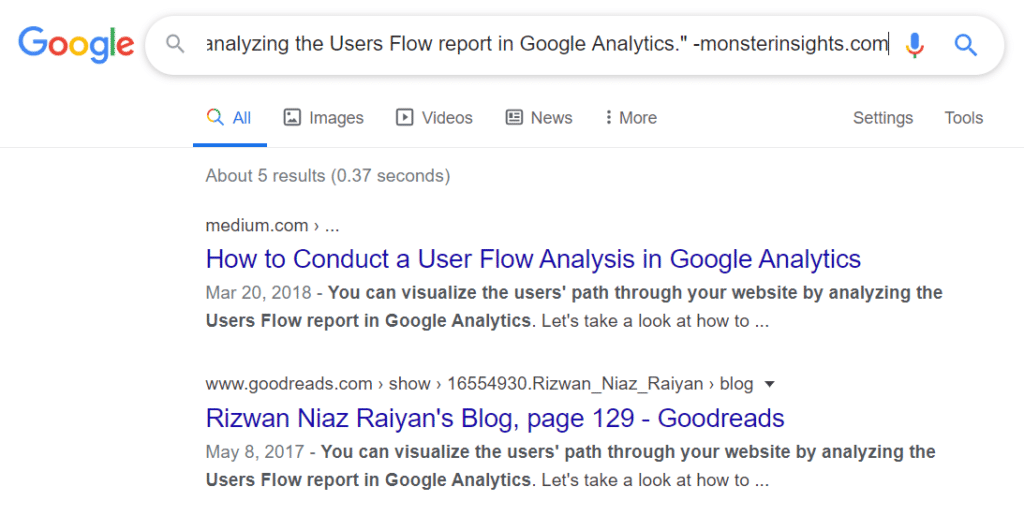

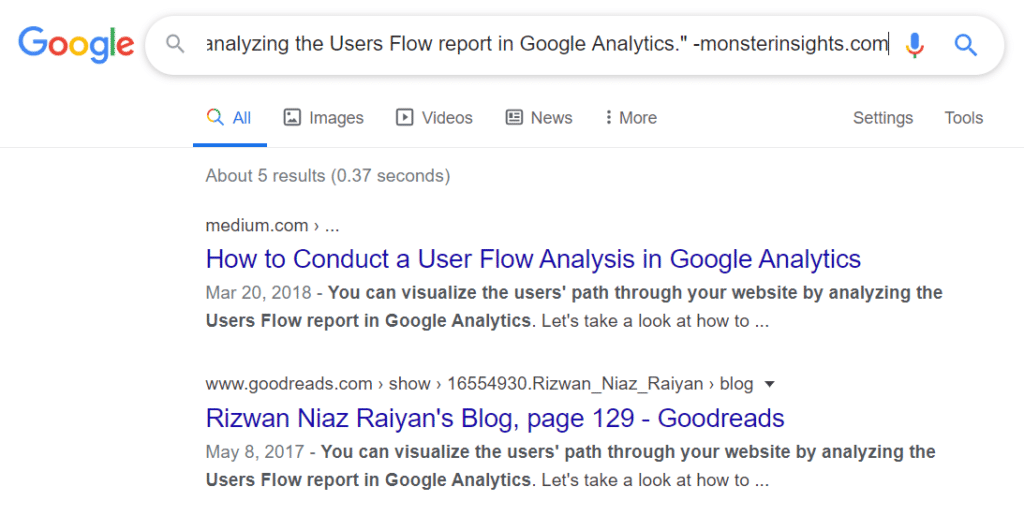

Vous pouvez même utiliser un opérateur de recherche moins et le combiner avec des guillemets pour vérifier si quelqu’un vole votre contenu. Entrer «Texte de votre contenu» -votredomaine.com dans Google.

En excluant votre site Web des résultats de recherche, vous pouvez voir qui copie votre contenu. S’il s’agit d’un site Web qui organise du contenu, vous pouvez alors obtenir un backlink. Il vous suffit de contacter le site Web et de leur demander de lier votre site en tant que source.

Par exemple, nous avons collé un texte de notre propre article de blog entre guillemets sur Google et exclu notre domaine des résultats de recherche. Comme vous pouvez le voir, 5 résultats ont exactement le même texte.

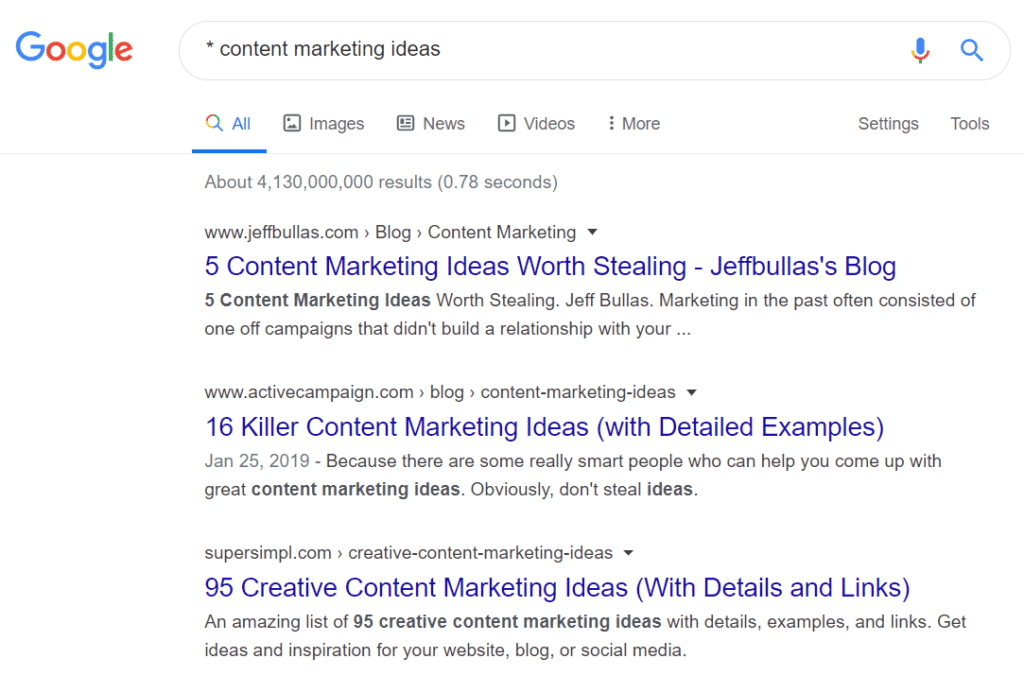

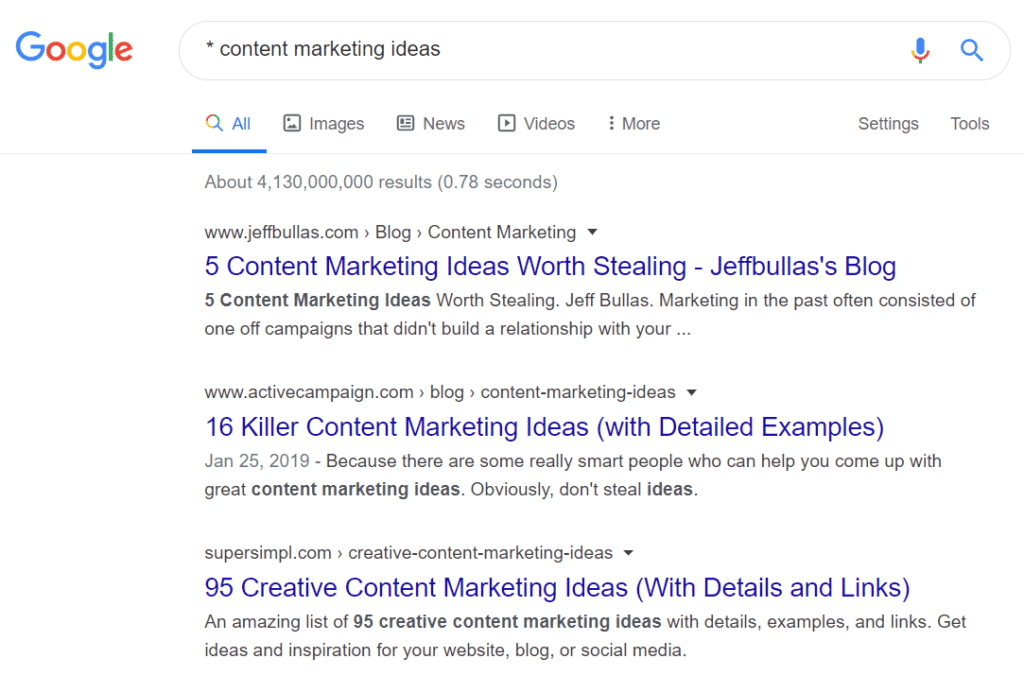

6. Utilisez l’astérisque (*) pour les résultats génériques

Vous pouvez utiliser un astérisque (*) lorsque vous ne savez pas quels mots clés saisir dans votre requête de recherche.

Cet opérateur de recherche Google est utile lorsque vous ne connaissez pas les mots clés. Le moteur de recherche correspondra automatiquement à toute expression ou mot pertinent.

Par exemple, si vous écrivez une publication de liste et que vous ne connaissez pas le nombre exact, vous pouvez ajouter un astérisque au début de votre requête de recherche.

Imaginons que vous rédigiez un article sur les idées de marketing de contenu. Puisqu’il n’y a pas de numéro spécifique pour la publication, vous pouvez ajouter un astérisque avant les idées de marketing de contenu.

Comme vous pouvez le voir, les résultats sont différents articles de liste sur le même sujet. Vous pouvez même combiner des astérisques avec des guillemets pour rendre votre recherche plus précise.

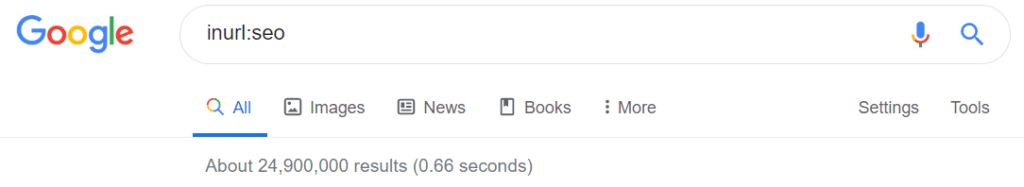

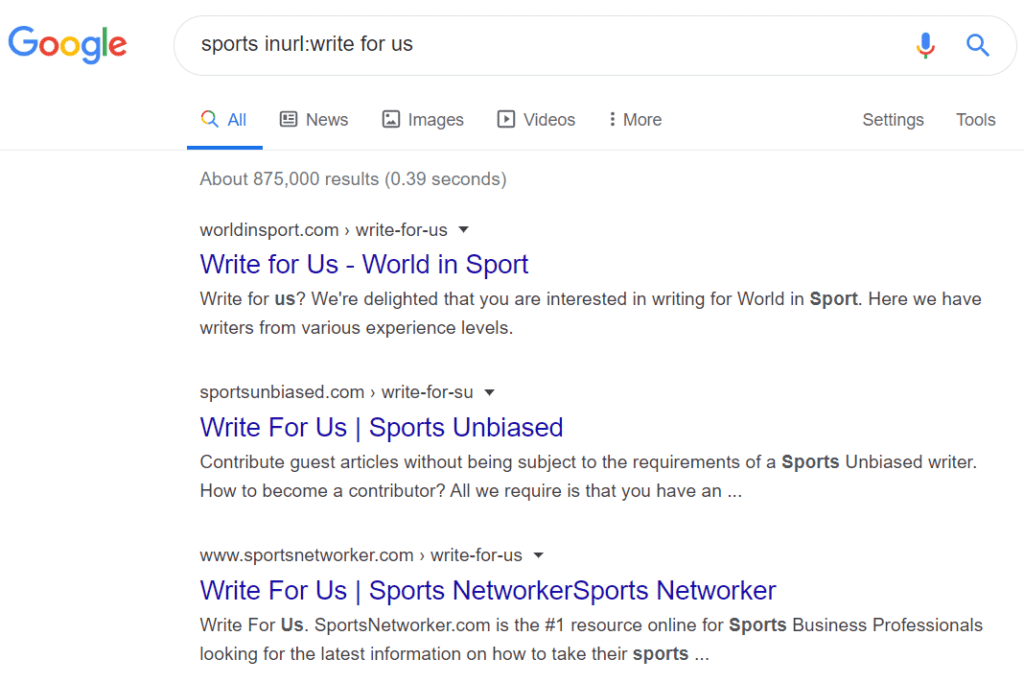

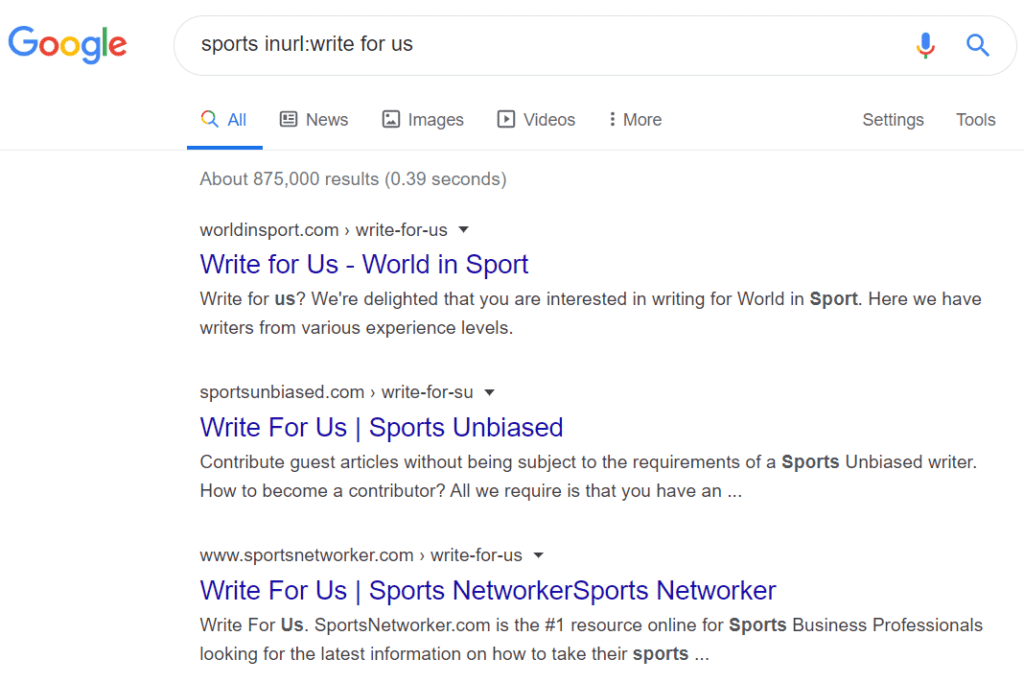

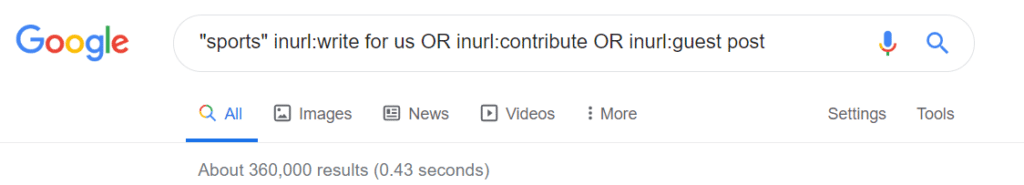

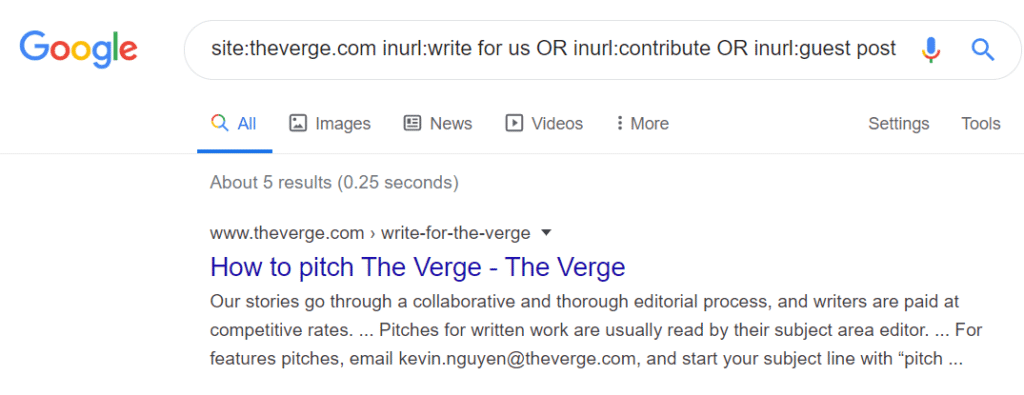

7. Rechercher des mots dans l’URL avec inurl:

Si vous souhaitez rechercher des URL contenant certains mots clés, alors inurl: L’opérateur de recherche peut vous aider. Et si vous avez une phrase que vous souhaitez trouver dans une URL, vous pouvez utiliser allinurl: opérateur de recherche.

Il existe d’autres applications de cet opérateur de recherche et vous pouvez le combiner avec d’autres opérateurs pour affiner votre recherche.

Par exemple, vous pouvez trouver des opportunités de publication d’invités en utilisant inurl. Vous pouvez rechercher des expressions ou des termes comme écrire pour nous, contribuer, poste invité, publications, etc. en utilisant l’opérateur de recherche inurl. Et pour le réduire davantage, vous pouvez également entrer dans votre secteur au début.

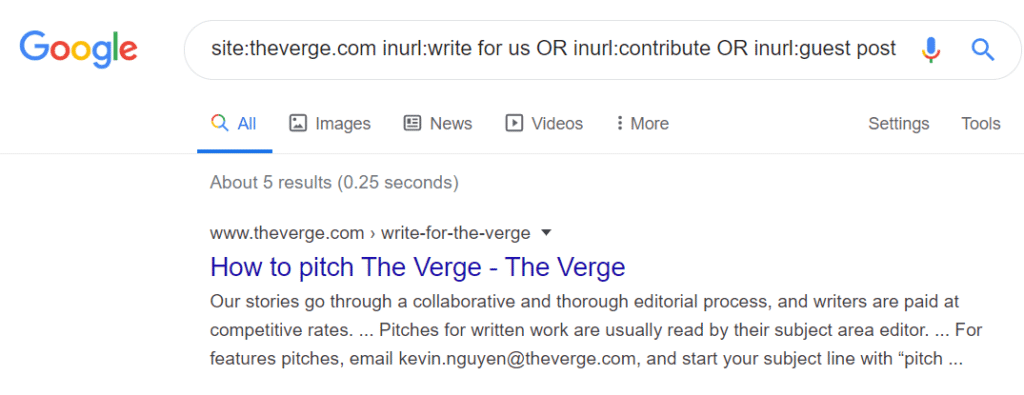

Vous pouvez même combiner tous ces termes pour trouver des opportunités de publication d’invités en utilisant inurl: avec les opérateurs de recherche OR. Voici à quoi cela ressemblerait sur Google.

Et si vous recherchez des publications d’invités sur un site Web spécifique, vous pouvez combiner inurl: avec l’opérateur de recherche site :. Les résultats seront spécifiés sur les pages d’un site Web particulier qui autorisent les publications d’invités.

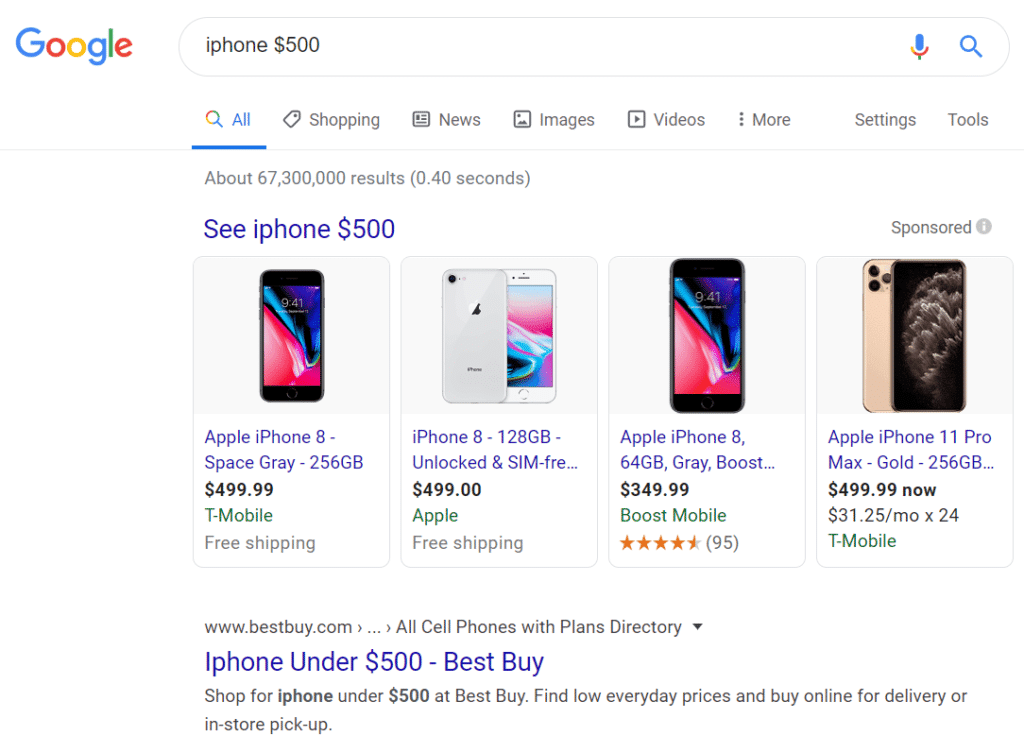

8. Découvrez les prix en utilisant le dollar ($)

La vérification des prix des articles peut être une tâche longue pour beaucoup. Mais vous pouvez accélérer ce processus en utilisant l’opérateur de recherche dollar ($).

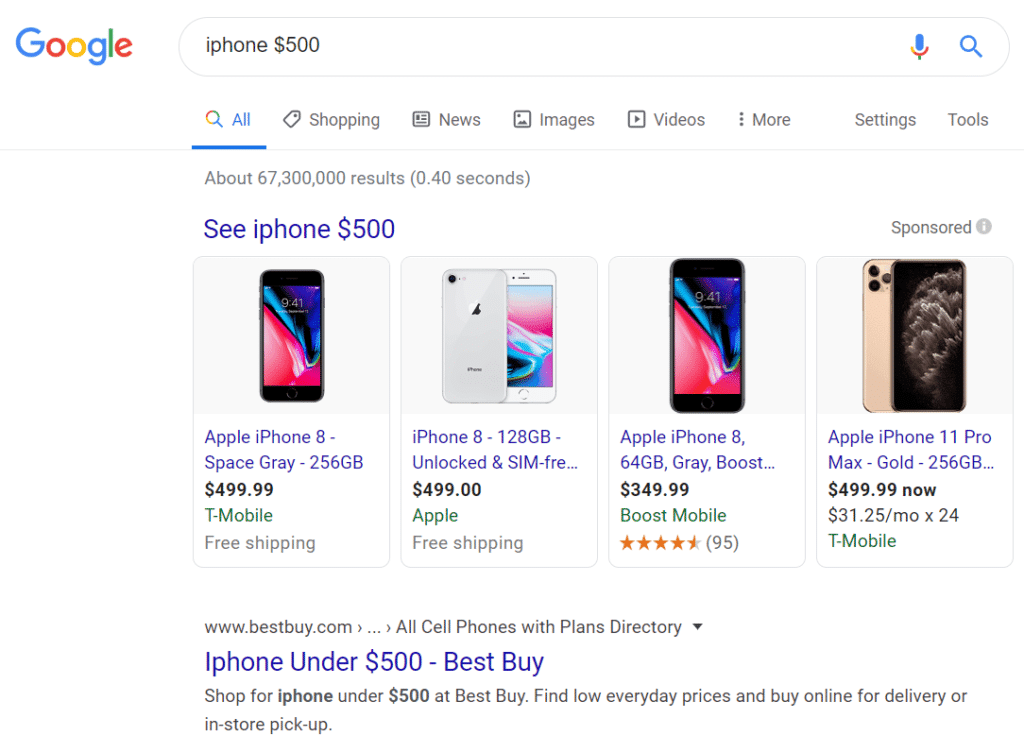

Entrez simplement le nom du produit et un prix estimé avec le signe $ sur Google. Le moteur de recherche vous apporte des résultats correspondant à cette fourchette de prix.

9. Utilisez filetype: pour rechercher des fichiers

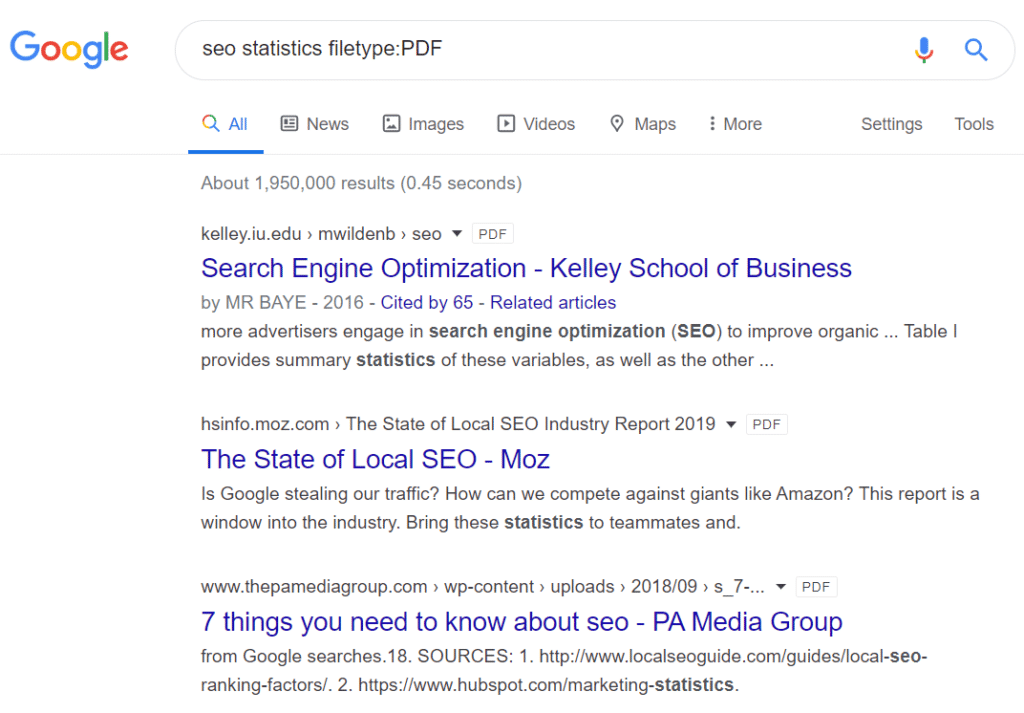

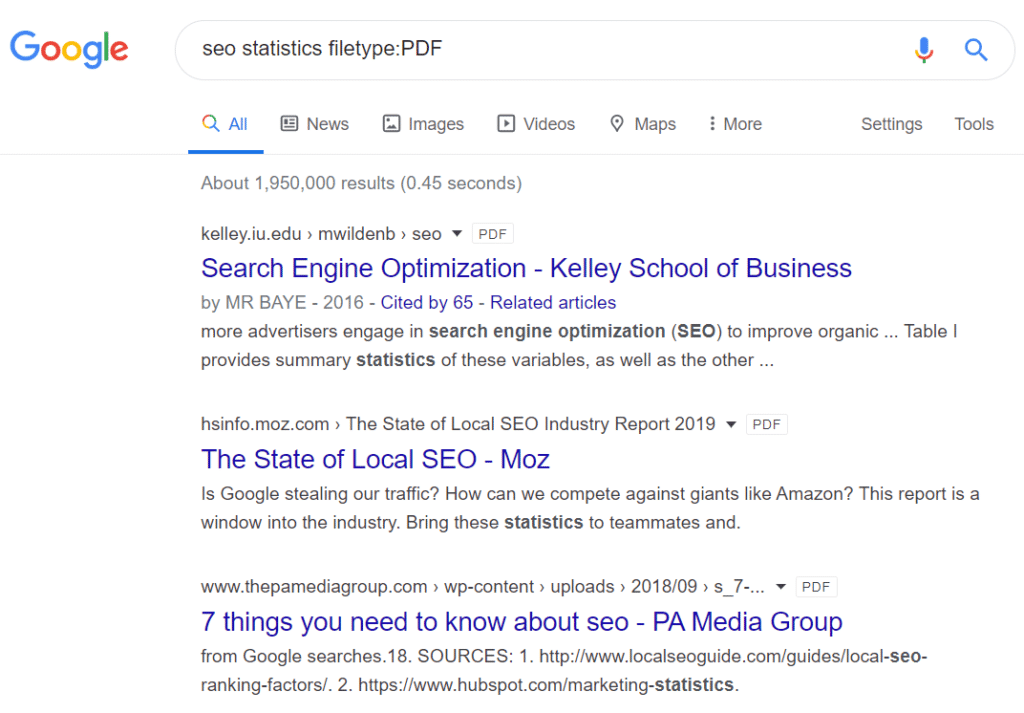

Êtes-vous à la recherche de fichiers PDF ou souhaitez-vous des MP3 d’un podcast? Pour vous aider à trouver le fichier que vous recherchez, vous pouvez utiliser Type de fichier: opérateur de recherche.

Tout ce que vous avez à faire est d’entrer le terme de recherche, puis ajoutez le type de fichier souhaité à la fin. Cet opérateur de recherche est utile si vous recherchez des rapports sur votre secteur d’activité ou un sujet particulier.

10. Trouver certains mots dans le contenu avec intext:

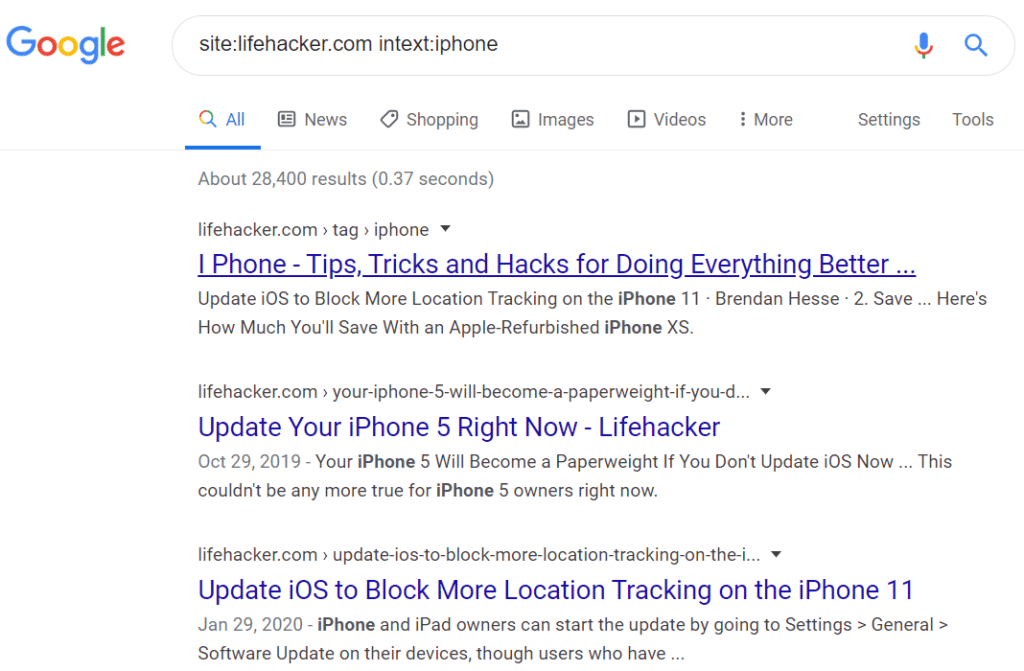

Vous pouvez trouver des mots clés dans le texte du contenu à l’aide de intext: opérateur de recherche. Et tout comme inurl, vous pouvez utiliser l’opérateur allintext: pour rechercher des phrases.

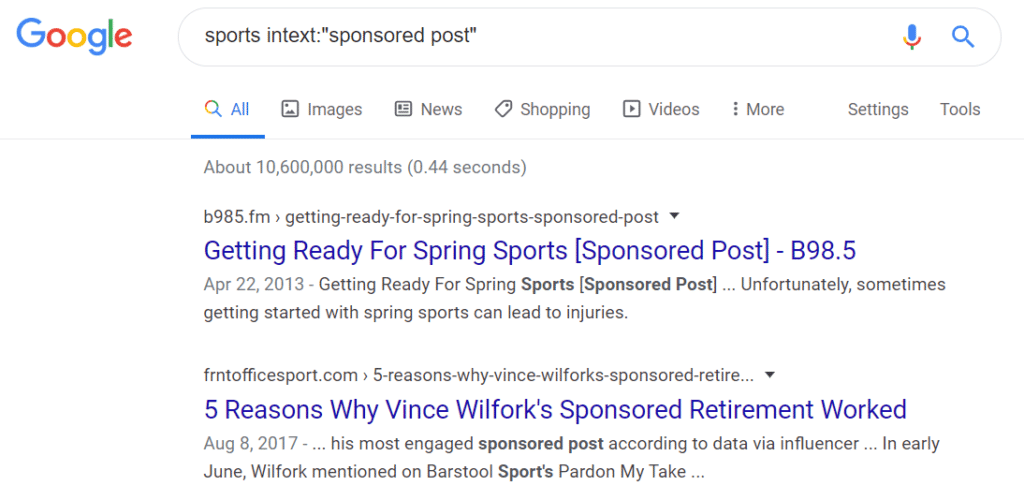

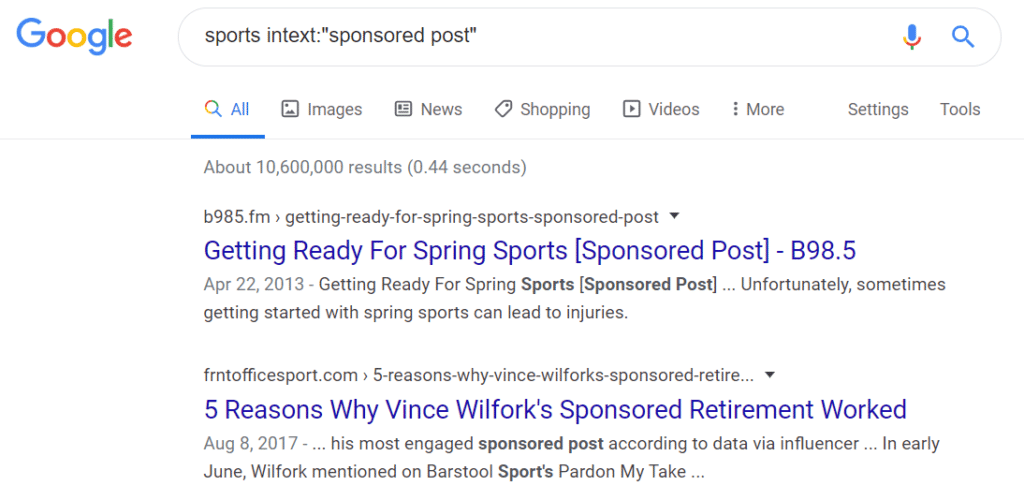

Cet opérateur de recherche Google avancé est utile pour effectuer des recherches sur les concurrents et si vous recherchez un poste sponsorisé ou des opportunités de relations publiques.

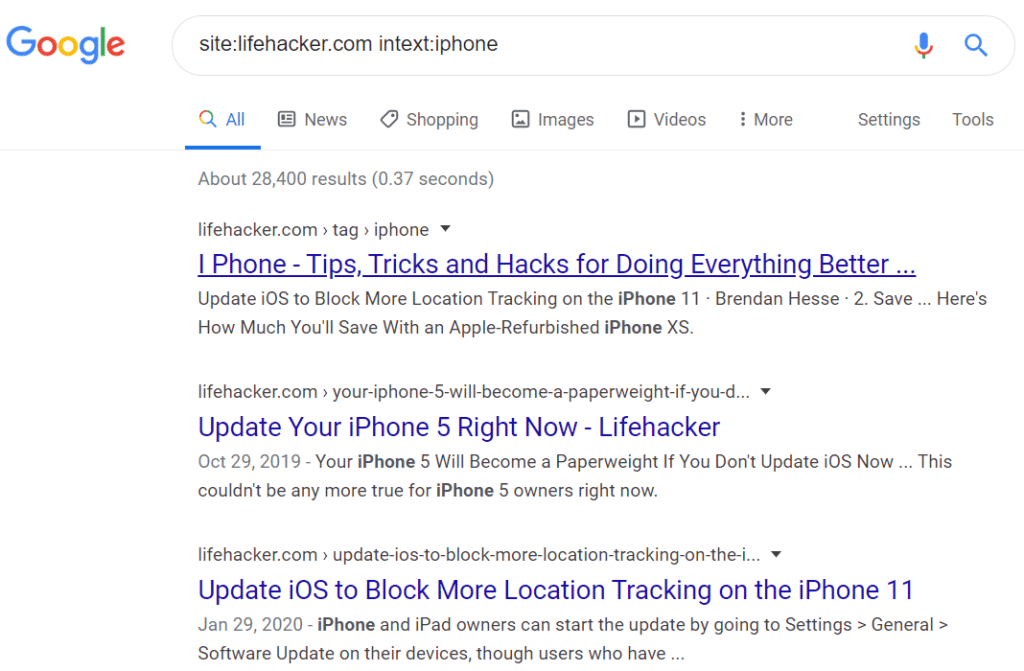

Supposons que vous souhaitiez savoir combien de fois le terme iPhone apparaît sur Lifehacker. Vous pouvez entrer site: lifehacker.com intext: iphone dans Google et il présentera toutes les pages de Lifehacker qui contiennent le mot-clé.

Vous pouvez même l’utiliser pour trouver des opportunités de publications sponsorisées et essayer des variantes comme votre créneau et intext: « article sponsorisé ».

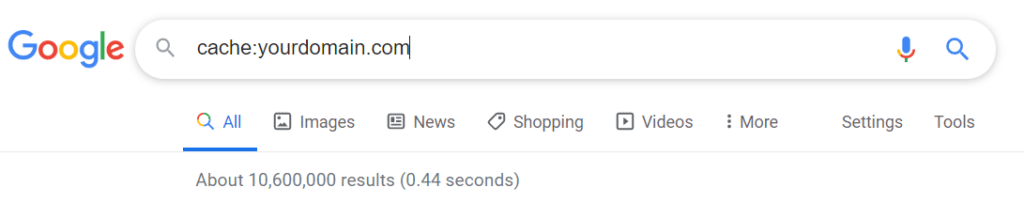

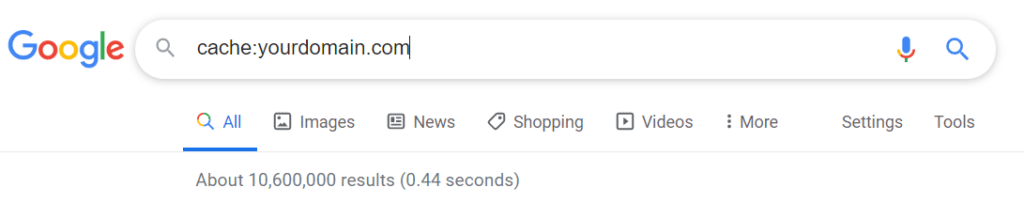

11. Voir la version mise en cache la plus récente utilisant le cache:

Un autre opérateur de recherche Google qui peut vous aider à vérifier si votre page est indexée ou non cache: opérateur de recherche.

En utilisant le cache: vous pouvez afficher la version en cache la plus récente d’une page Web. Si la page est mise en cache à une ancienne date, vous pouvez vérifier les erreurs d’indexation.

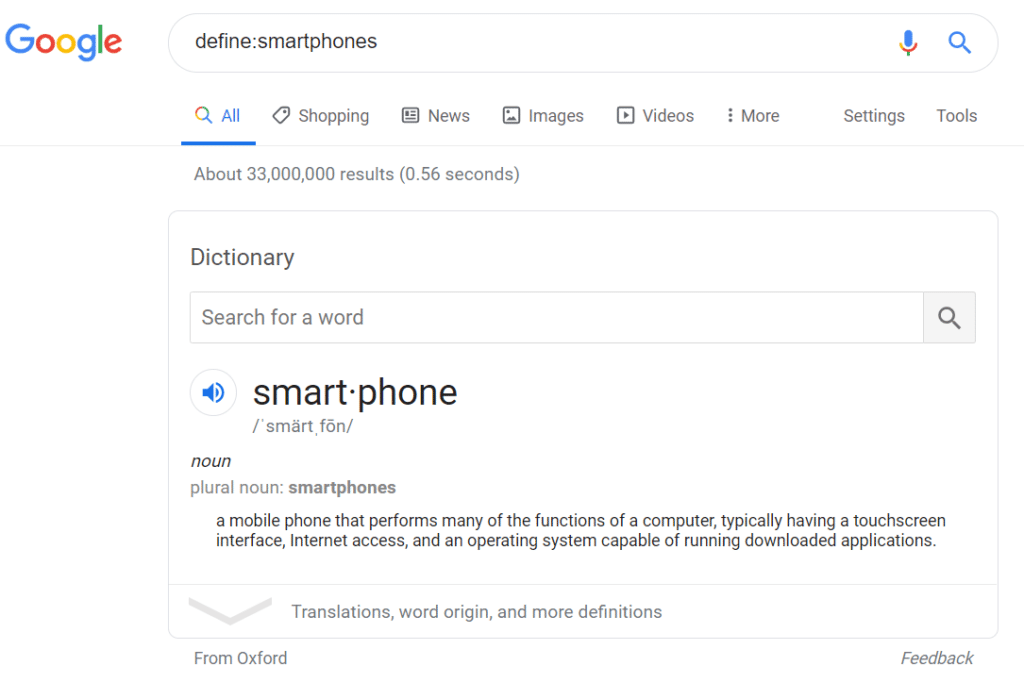

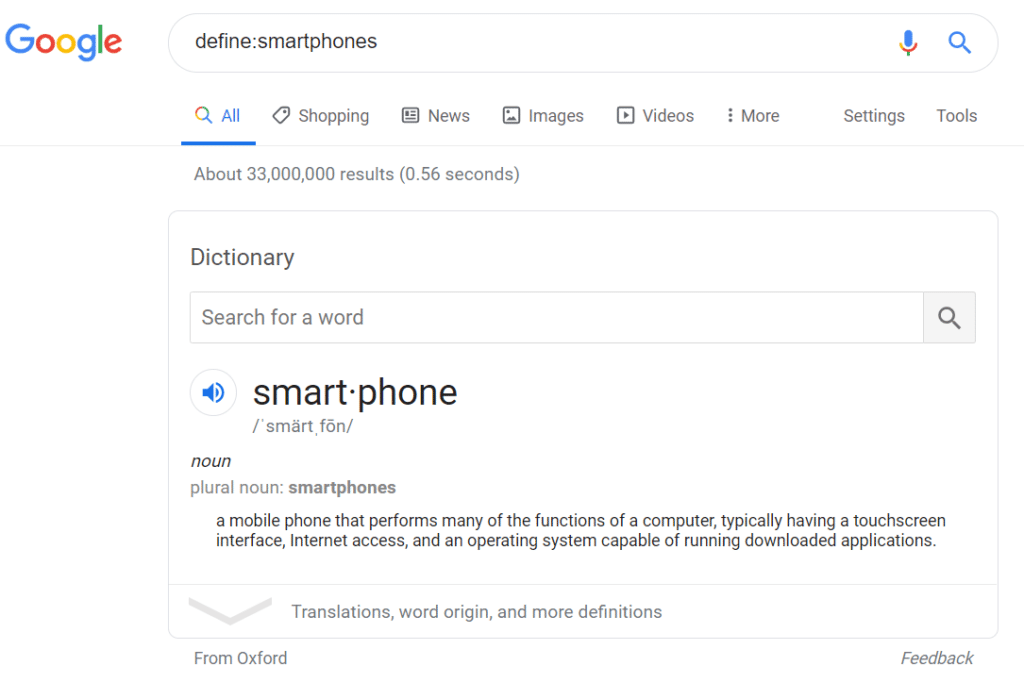

12. Utilisez define: pour rechercher les significations d’un mot

Vous cherchez une définition d’un mot mais vous ne trouvez pas le bon résultat de recherche? Avec l’aide de définir: opérateur de recherche, vous pouvez afficher un extrait de Google qui montre la signification de votre terme de recherche.

Cela vous fait gagner du temps et vous n’avez pas besoin de parcourir différents résultats de recherche pour trouver la signification d’un mot ou d’une phrase.

13. Recherche de mots dans les titres avec un titre:

Maintenant, tout comme les opérateurs de recherche inurl: et intext:, vous pouvez également utiliser intitle: opérateur de recherche. Il vous aide à trouver des mots spécifiques qui apparaissent dans le titre d’une page. Et si vous souhaitez rechercher des phrases, vous pouvez utiliser l’opérateur allintitle: search.

Vous pouvez combiner intitle: avec l’opérateur site: search pour voir quels articles contiennent les mots-clés que vous recherchez.

Vous pouvez utiliser l’opérateur intitle: search de plusieurs manières. Vous pouvez le combiner avec intext: pour trouver des pages de ressources, opportunités de publication d’invitéset les articles sponsorisés.

Et si vous recherchez un mot-clé pour apparaître dans le titre et dans le contenu, vous pouvez combiner intext: avec intitle: opérateur de recherche.

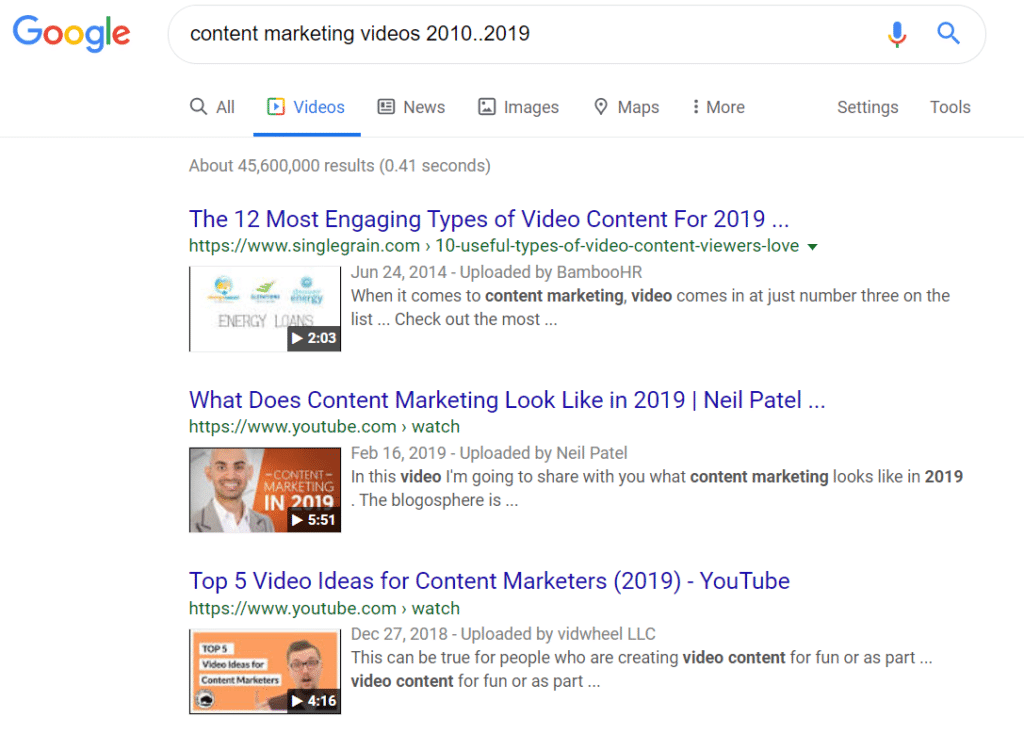

14. Utilisez deux périodes (..) pour définir une plage

Voulez-vous limiter votre recherche entre une plage? Avec deux périodes (..) opérateur de recherche Google, vous pouvez définir les paramètres du moteur de recherche pour rechercher vos requêtes.

Cependant, notez que cet opérateur de recherche peut fonctionner avec certaines requêtes car c’est un succès ou un échec.

Mots finaux

Les opérateurs de recherche Google sont faciles à utiliser une fois que vous avez compris. Ils sont extrêmement utiles pour les spécialistes du marketing de contenu qui effectuent des activités de référencement, souhaitent promouvoir leur contenu et suivre les concurrents.

Vous pouvez les combiner de différentes manières pour tirer le meilleur parti de vos résultats de recherche, comme nous vous l’avons montré dans cet article.

Et c’est tout le monde!

Nous espérons que vous avez aimé notre article sur les opérateurs de recherche Google pratiques pour le référencement. Si vous le souhaitez, vous pouvez également consulter notre guide expliquant pourquoi votre entreprise a besoin de Google Analytics dès maintenant.

N’oubliez pas de nous suivre sur Twitter et Facebook pour des conseils plus utiles sur le référencement, Google Analytics, WordPress, etc.

25 faits surprenants que vous ne saviez pas sur Snapchat

Snapchat ne consiste pas seulement à suivre les Kardashian.

Il ne se limite pas non plus à partager des selfies stupides / mignons / spontanés avec des amis ou des histoires de margaritas au chocolat.

Snapchat est plus que tout cela.

En fait, si vous l’utilisez de manière stratégique, cela peut être un outil puissant pour commercialiser votre marque.

Cela semble excitant, non?

Il est.

Mais avant de commencer à commercialiser sur Snapchat, vous devez d’abord savoir tout ce que vous pouvez sur l’application.

Pourquoi?

Parce que vous devez savoir qui est sur Snapchat, comment les utilisateurs se comportent et à quoi ressemble une campagne marketing Snapchat réussie. (Aussi, être un tout-savoir est amusant!)

Vous voulez connaître des faits moins connus sur Snapchat?

Continuer à lire! (Indice: 1-15 sont parfaits pour les commerçants.)

Qu’est-ce que Snapchat?

Snapchat est une application qui vous permet de partager des photos et des vidéos avec d’autres personnes en ligne.

Mais contrairement à Facebook et Instagram, votre contenu n’est pas stocké de manière permanente.

Une fois visualisé, il disparaît et devient irrécupérable.

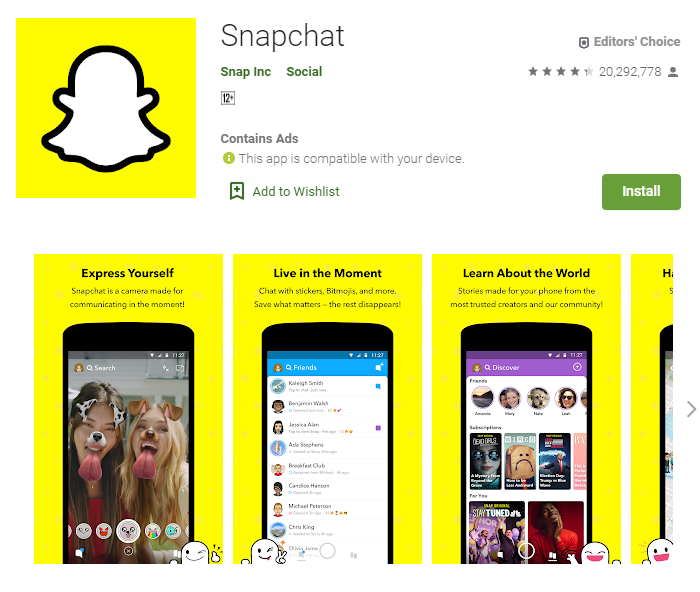

La création d’un compte sur Snapchat est facile. Téléchargez simplement l’application sur jeu de Google ou la Magasin d’applications. Installez-le sur votre appareil et vous êtes prêt!

L’application Snapchat est disponible en téléchargement sur Google Play.

L’application Snapchat est disponible en téléchargement sur Google Play.Avec Snapchat, vous profitez d’un large éventail de fonctionnalités. Vous pouvez utiliser Discover pour obtenir les dernières nouvelles.

Vous pouvez ajouter un filtre amusant à vos selfies. Il existe également des autocollants, des outils de dessin et des emojis que vous pouvez utiliser pour personnaliser tout ce que vous envoyez ou postez.

25 faits surprenants que vous ne saviez pas sur Snapchat

Plongeons-nous!

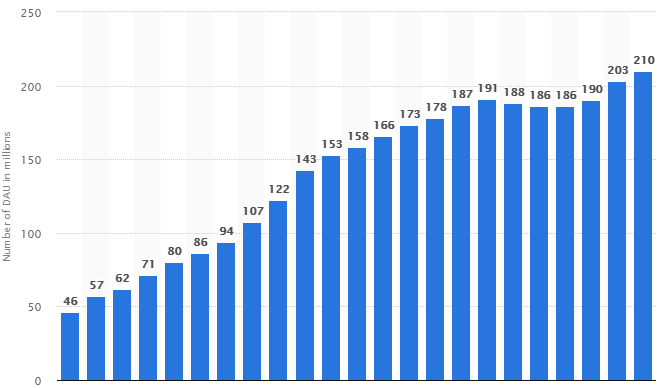

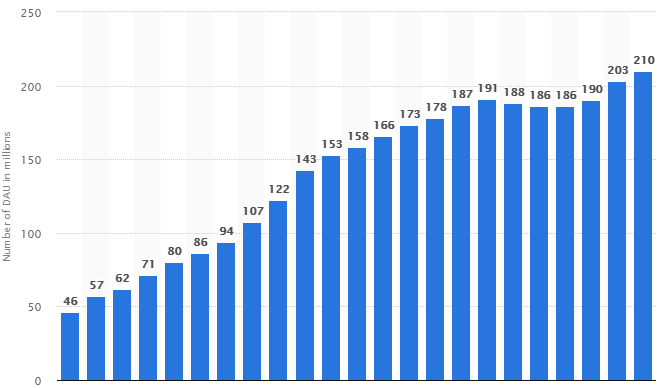

1. Il y a Plus de 210 millions Utilisateurs Snapchat actifs

Voici un graphique de Statista montrant la croissance de Snapchat de 2014 à 2019.

Impressionnant!

Avec plus de 210 millions d’utilisateurs actifs, Snapchat est une énorme opportunité marketing pour vous.

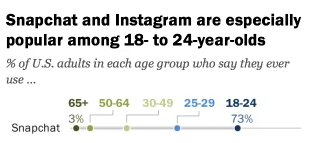

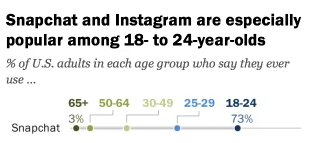

2. 73% des utilisateurs de Snapchat aux États-Unis ont entre 18 et 24 ans

Filaire rapports que c’est l’amour des ados qui est la vie et le souffle de Snapchat.

Regardez ce tableau de Pew Research pour voir qui utilise le plus l’application.

La majorité de ceux sur Snapchat sont Gen Z utilisateurs, selon le tableau.

En tant que responsable marketing, vous pouvez avoir une idée de ce sur quoi votre campagne devrait se concentrer si vous utilisez Snapchat. Comme le propre rapport de Snapchat le met:

«Depuis sa création, Snapchat a intrinsèquement créé un espace sans frottement où les créateurs de la génération Z peuvent expérimenter leur identité, sans avoir à se sentir comme« sur la marque »en communiquant avec leurs groupes d’amis proches. «Une grande partie de la philosophie du produit autour de l’éphéméralité est fondée sur cette notion selon laquelle vous pouvez être qui vous voulez aujourd’hui, sans enregistrer qui vous étiez hier», explique

Amy Moussavi, responsable mondiale des informations consommateurs chez Snapchat. »

Aux États-Unis, 90% de tous les 13-24 ans utilisent Snapchat

Les adolescents décrivent Snapchat comme un moyen de parler sans utiliser de mots. C’est le moyen le plus simple de contacter des amis. Et c’est « vraiment cool » parce que « tout le monde l’utilise ».

Il n’est pas étonnant que 90% des adolescents et des jeunes adultes aux États-Unis utilisent Snapchat!

4. 63% des utilisateurs de Snapchat vont sur l’application tous les jours

Sur ces 63%, 49% vont sur Snapchat plus d’une fois par jour.

5. Taco Bell payé 75 000 $ pendant 24 heures du filtre / annonce Taco

Pour augmenter les ventes, Taco Bell a lancé le filtre à tacos sur Snapchat. Voici à quoi cela ressemblait.

Aujourd’hui seulement: transformez-vous en taco en utilisant notre @Sn Snapchat lentille. Parce que Cinco de Mayo. pic.twitter.com/P4KwLdFNFZ

– Taco Bell (@tacobell) 5 mai 2016

Le filtre est humoristique, pertinent et unique.

Les utilisateurs l’ont adoré et ont obtenu 224 millions de vues.

Le résultat?

Taco Bell a payé 75 000 $ pour l’annonce.

Un bon investissement pour l’exposition qu’il a obtenue.

6. 61% des utilisateurs de Snapchat sont des femmes

Les femmes sont naturellement attirées par les visuels, la couleur, la créativité et la connexion. Tout ce que Snapchat donne.

Si vous êtes un spécialiste du marketing, cela en dit long sur la façon dont vous devez fabriquer vos campagnes Snapchat.

sept. 4 sur 10 Les utilisateurs de Snapchat disent avoir découvert une nouvelle marque à travers des publications et des mentions de célébrités

Le marketing d’influence est aujourd’hui un moyen prometteur de commercialiser une entreprise. Et quel meilleur endroit pour le faire que sur Snapchat?

Avec 4 Snapchatters sur 10 répondant à de nouvelles marques approuvées par des célébrités, des vloggers et des blogueurs experts, Snapchat est un endroit où vous pouvez trouver un public extrêmement réceptif pour votre marque.

8. Snapchat Pionnier Annonces vidéo verticales

Les annonces vidéo verticales sont des annonces qui peuvent être affichées avec votre téléphone tenu verticalement.

Vous avez peut-être déjà regardé un certain nombre de publicités vidéo verticales, mais saviez-vous que Snapchat les a lancées?

Leur idée a rendu la visualisation des publicités plus pratique.

9. Vous pouvez suivre les experts Rock Star Business sur Snapchat

Qui savait que Snapchat pourrait être un puissant outil commercial?

Voici les 3 meilleurs experts que vous devriez suivre dès maintenant.

10. Snapchat a co-créé un géofiltre sympa avec Netflix

Pour sa sortie de 4 nouveaux épisodes de « The Gilmore Girls », Netflix a imprimé 10 000 tasses avec un code Snapchat spécial.