Comment utiliser l'analyse de lisibilité • Yoast

Edwin Toonen

Edwin est un écrivain, éditeur et gestionnaire de contenu expérimenté. Avant de rejoindre Yoast, il a passé des années à perfectionner ses compétences dans le premier magazine de conception Web aux Pays-Bas.

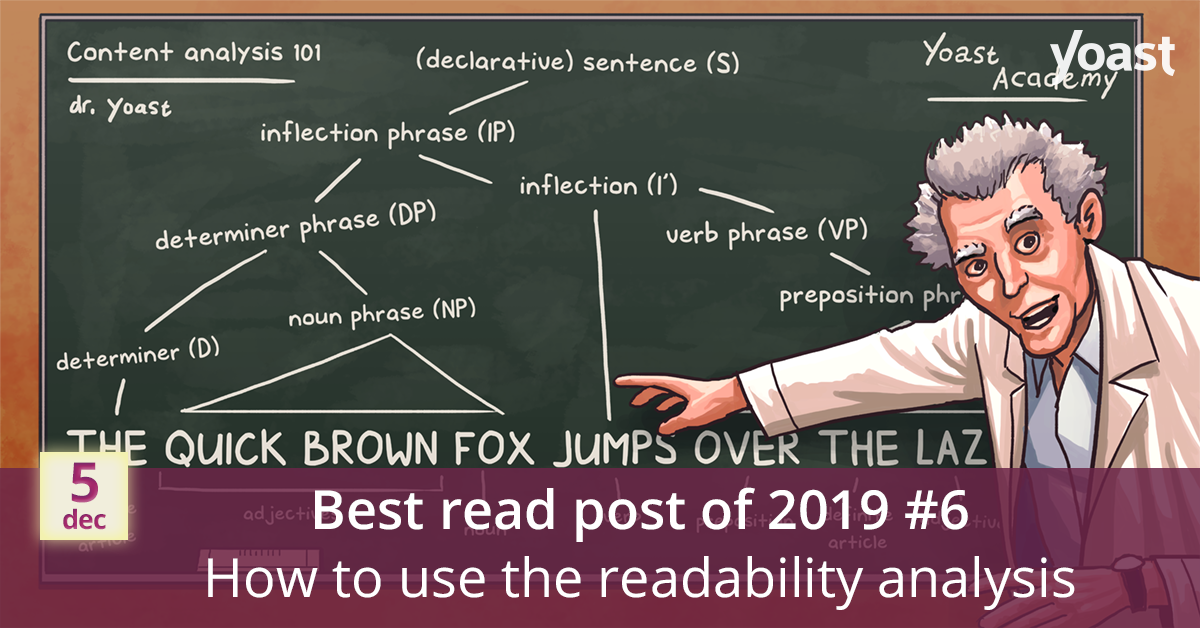

Tout le monde connaît les puces colorées (ou les points, ou même les «feux de circulation») dans Yoast SEO. Deux parties du plugin utilisent ce système: le analyse de contenu et l'analyse de lisibilité. Le premier vérifie si votre publication est résistante au référencement, tandis que la seconde vérifie si elle est lisible pour un public général. Bien sûr, ces deux sont interconnectés, comme un contenu lisible est extrêmement important si vous voulez que votre site fonctionne bien dans les résultats de recherche. Ici, je vais vous montrer comment utiliser l'analyse de lisibilité.

Nous espérons que vous prendrez plaisir à lire # 6 de nos articles les plus lus cette année! Découvrez comment l'analyse de lisibilité de Yoast vous aide à écrire du contenu lisible et pourquoi c'est important. N'oubliez pas de revenir demain pour un autre surprise du compte à rebours des fêtes!

Que fait l'analyse de lisibilité dans Yoast SEO?

L'analyse de lisibilité utilise un algorithme pour déterminer la lisibilité de votre publication. Nous avons soigneusement conçu cet algorithme pour le rendre aussi précis que possible sans être trop strict. Il comporte plusieurs vérifications qui vous donneront des conseils lorsque vous rédigerez votre message. En d'autres termes, en suivant les conseils, vous pouvez rendre votre texte plus facile à lire et à comprendre.

Il a été dit que Yoast SEO suggère d'abaisser votre écriture. Bien sûr, ce n’est pas le cas. Nous voulons simplement aider les gens à écrire du contenu facile à comprendre. Je reviens toujours à cette citation de conception de contenu héros Sarah Richards à propos de rendre votre contenu aussi lisible que possible pour les humains:

"Vous n'êtes pas stupide, vous vous ouvrez."

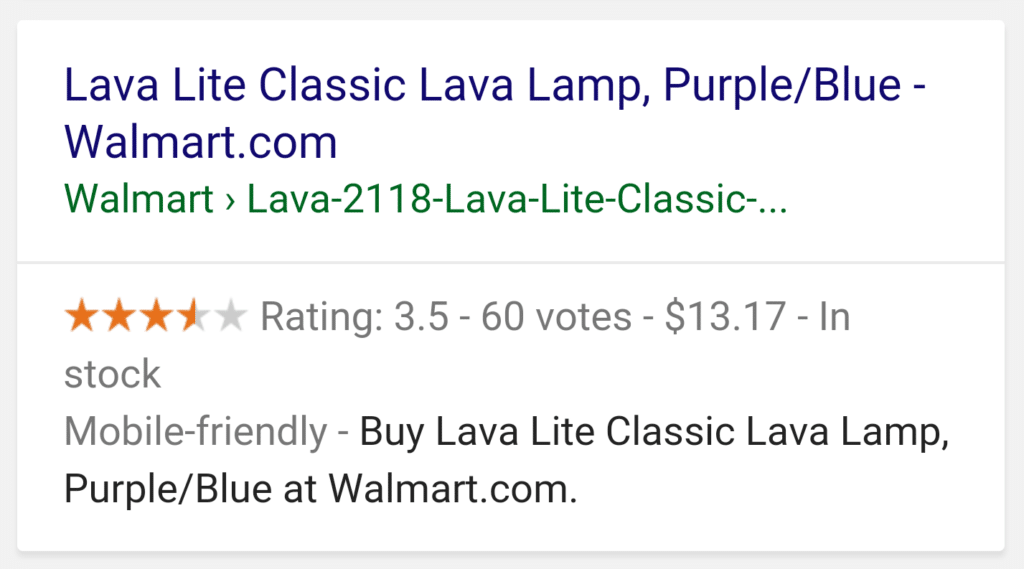

En simplifiant le contenu, vous augmentez automatiquement votre audience, car de plus en plus de personnes saisissent le message de votre contenu. De plus, vous n'écrivez plus votre contenu uniquement pour les gens. Les assistants virtuels comme Alexa et Siri doivent également pouvoir travailler avec. Et même Google utilise de plus en plus de contenus bien écrits pour des résultats riches, comme des extraits en vedette.

Cela étant dit, alors que les conseils dans la section de lisibilité ne sont pas les conseils de tout et tout, cela vous donne des indices importants sur la difficulté perçue de votre texte. Il est primordial d'écrire en gardant à l'esprit la lisibilité, comme nous le pensons rangs de lisibilité!

Vérifications de lisibilité actuelles

Pour le moment, Yoast SEO utilise les contrôles suivants:

- Mots de transition: Utilises tu mots de transition comme «le plus important», «parce que», «donc» ou «en plus de cela» pour lier votre texte? L'utilisation de ces mots améliore le flux de votre article car ils fournissent au lecteur des conseils sur ce qui va suivre.

- Début de phrase: L'une de vos phrases consécutives commence-t-elle par le même mot? Cela peut sembler répétitif pour votre lecteur, et cela peut être ennuyeux. Gardez toujours vos phrases variées, afin que votre article soit lisible et sans obstacles. À moins que vous ne vouliez prouver quelque chose ou l'utiliser comme style d'écriture, bien sûr.

- Facilité de lecture Flesch: Ce test de renommée mondiale analyse les textes et les note sur une échelle de 1 à 100. Plus le score est bas, plus le texte est difficile à lire. Textes avec un très haut Facilité de lecture Flesch score (environ 100) sont très faciles à lire. Ils ont des phrases courtes et aucun mot de plus de deux syllabes. Habituellement, un score de facilité de lecture de 60 à 70 est jugé acceptable / normal pour la copie Web.

- Longueur de paragraphe: Certaines personnes ont tendance à utiliser des paragraphes extrêmement longs. Cela rend votre texte intimidant car il ne devient qu'un gros bloc de texte. Décomposez-le, utilisez des paragraphes plus courts et n'oubliez pas de phrases fondamentales certains ont pensé.

- Répartition des sous-positions: Comme pour les longs paragraphes, les textes sans sous-titres sont difficiles à numériser, ce qui les rend plutôt intimidants. Nous vérifions donc si vous utilisez suffisamment de sous-titres pour guider vos lecteurs dans le texte et les aider à trouver ce qu'ils recherchent.

- Durée de la peine: La longueur de la phrase est l'un des principaux aspects qui peuvent rendre un texte difficile à lire. Si la plupart de vos phrases sont trop longues – plus de 20 mots – les gens perdent de vue votre argument. Les lecteurs doivent souvent reculer de quelques mots pour savoir ce que vous voulez dire. C'est très fatigant et inefficace. Essayez de contrôler le nombre de mots dans une phrase. Raccourcissez vos phrases. Visez une compréhension facile, pas un chef-d'œuvre littéraire complexe.

- Voix passive: En utilisant beaucoup de voix passive dans votre texte le fait paraître éloigné, et votre message sera moins clair. Vos phrases deviennent verbeuses et difficiles car la structure de la phrase est plus difficile à comprendre. Chaque fois que vous utilisez la voix passive, demandez-vous toujours si une meilleure alternative active est disponible.

Langues prises en charge

L'analyse de lisibilité est disponible en anglais et en plusieurs langues, comme l'allemand, le français, l'espagnol, le portugais et le russe. Vérifiez fonctionnalités par langue pour un aperçu. Nous travaillons en permanence sur l'ajout de nouvelles langues.

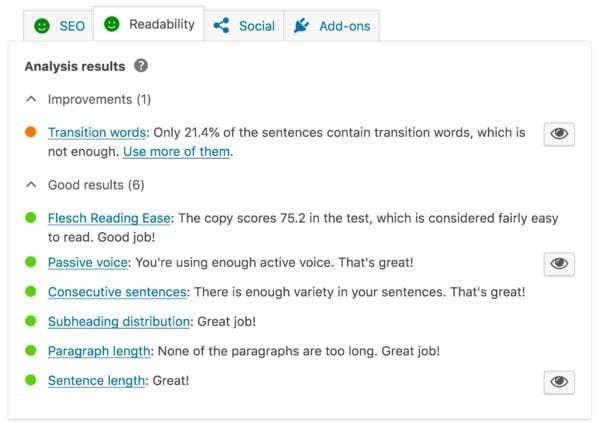

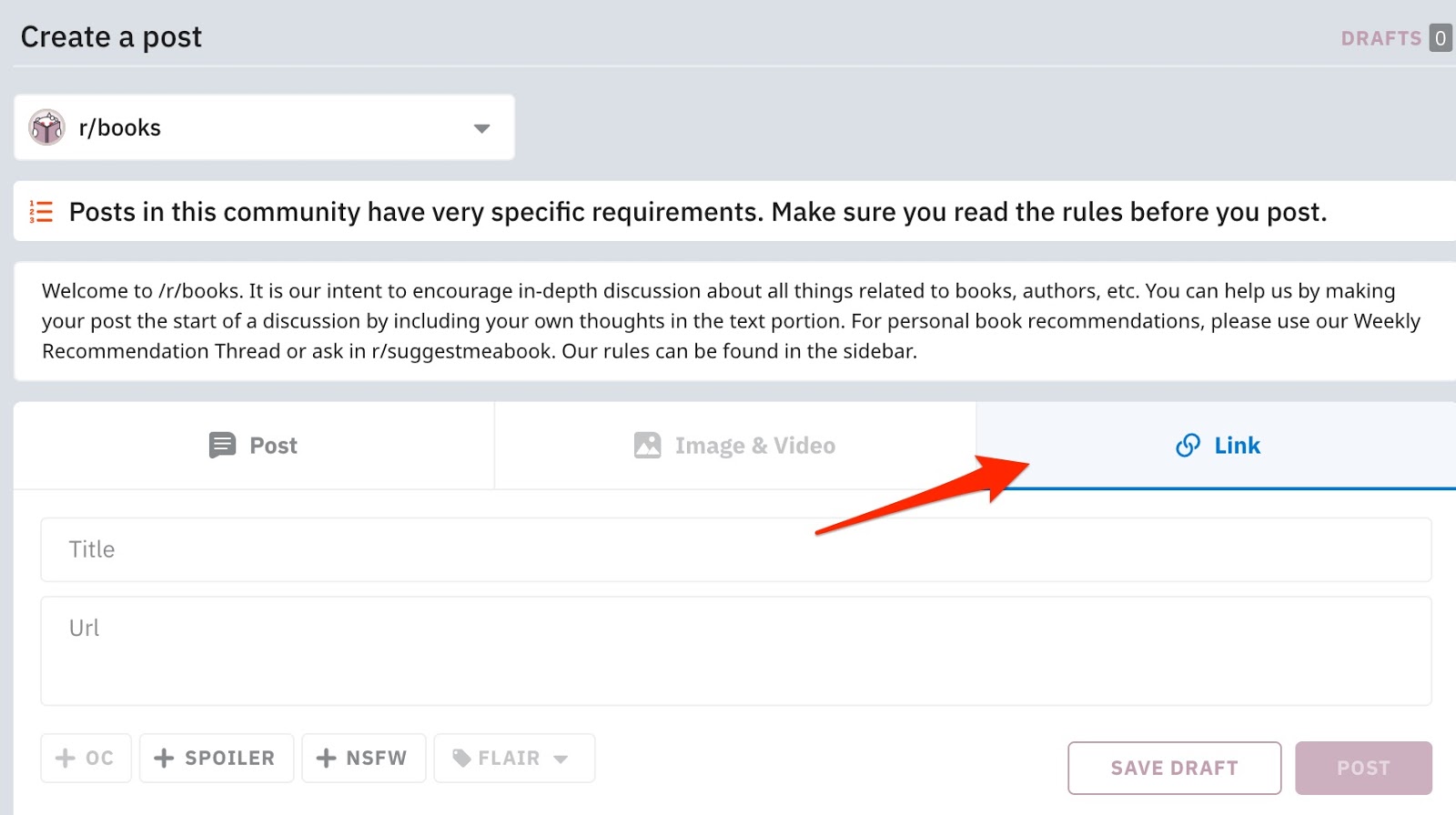

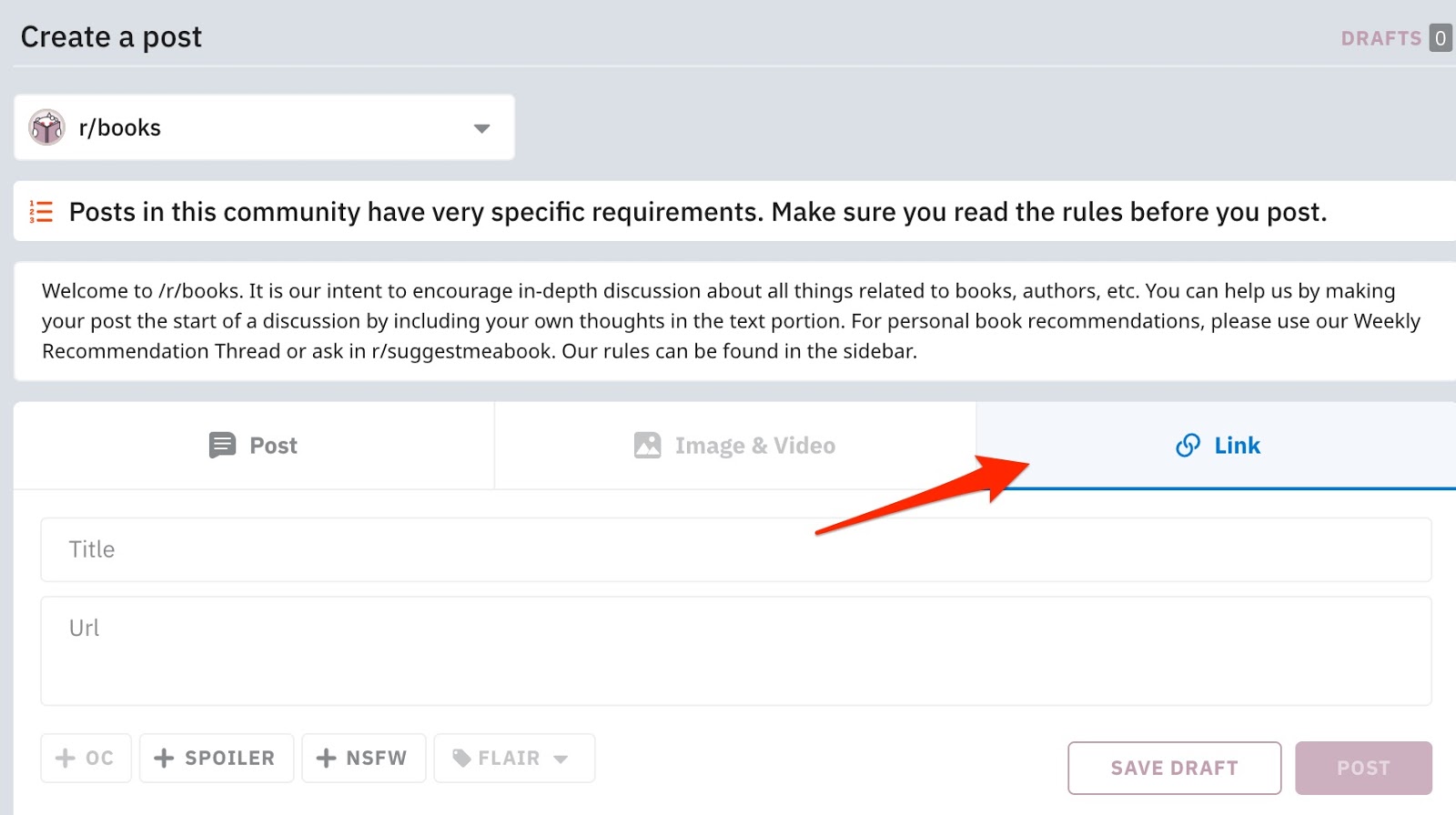

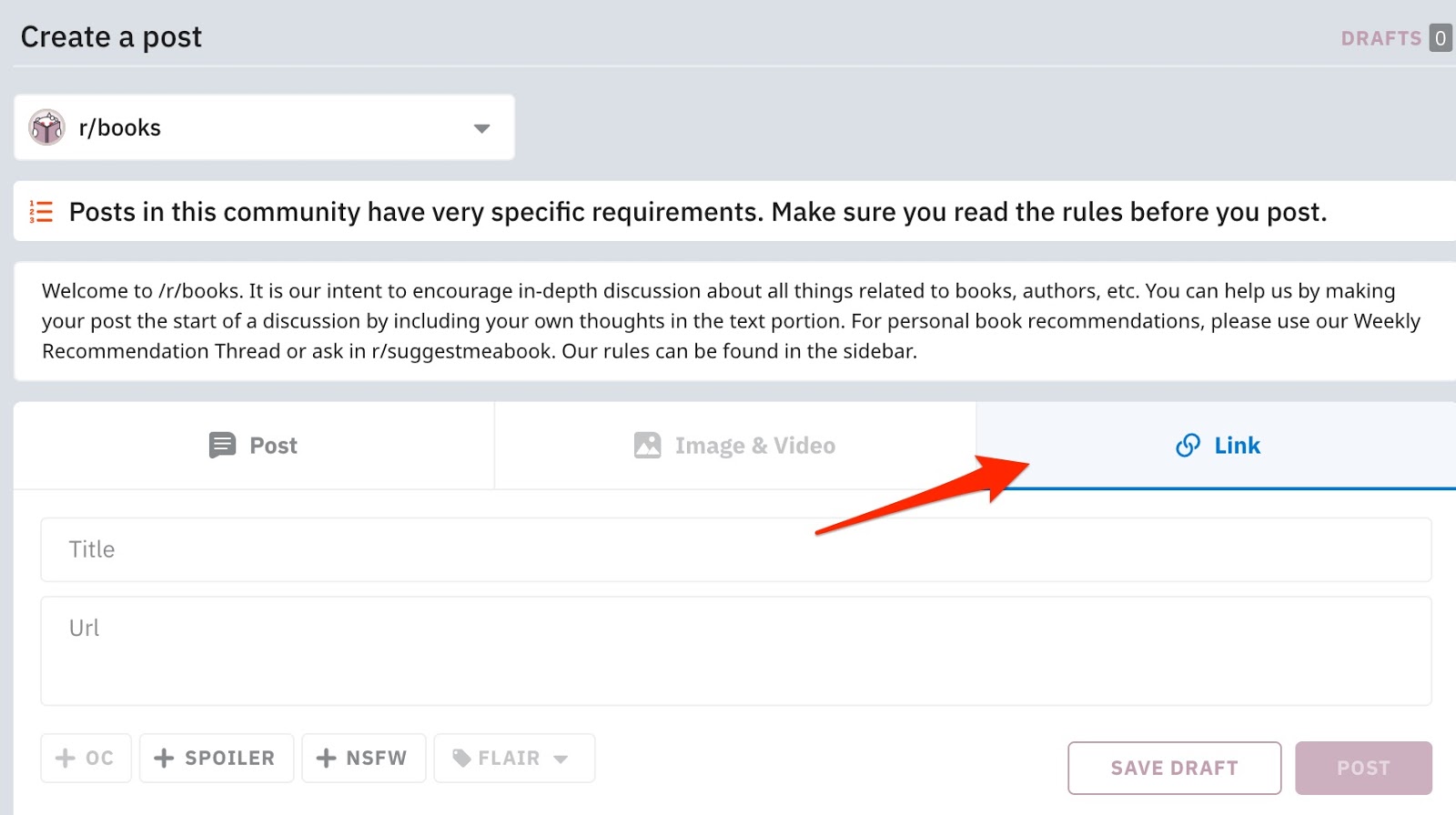

Comment utiliser l'analyse de lisibilité dans Yoast SEO

Il est très facile d'utiliser l'analyse de lisibilité dans Yoast SEO pour améliorer votre contenu. Personnellement, je viens commencer à écrire l'article que je veux écrire. Je garde le public pour lequel j'écris à l'arrière de ma tête et j'essaie d'utiliser les mots qu'ils utiliseraient. Bien que le score de lisibilité soit calculé en temps réel, je ne regarderai pas le score pendant le processus d'écriture. Ce n'est qu'après (le brouillon de) mon article que je vais vérifier le score de lisibilité et voir si je dois corriger quoi que ce soit. Si je reçois une puce orange ou rouge, je peux cliquer sur l'icône en forme d'œil pour savoir où des améliorations peuvent être apportées. Peasy facile!

Chacun a son propre processus d'écriture et d'édition, et ma façon de procéder n'est pas nécessairement la façon dont vous devez l'utiliser. Par exemple, vous visez peut-être un niveau Flesch de 80. Si c'est le cas, vous devez découvrir ce qui fonctionne progressivement. Lorsque vous utilisez l'outil de lisibilité pendant un certain temps, vous remarquerez que vous aurez automatiquement une idée du niveau que vous visez. La pratique rend parfait!

Toutes les balles doivent-elles être vertes?

C'est une question que nous recevons souvent et non, toutes les balles ne doivent pas être vertes. Ce que vous devriez viser, cependant, est une balle verte et joyeuse dans l'ensemble – celle de l'onglet qui indique «Lisibilité». Avoir une puce orange pour l'un des chèques, comme dans la capture d'écran ci-dessus, c'est bien. Votre article pourra toujours être classé, même s'il ne réussit pas tous les tests. Ce n'est qu'une indication, pas une nécessité.

Nous voulons que tout le monde puisse lire et comprendre le contenu, mais nous savons également qu'il existe des secteurs où la langue utilisée est totalement différente de celle que les gens ordinaires utiliseraient. C’est parfaitement bien. Découvrez ce qui fonctionne dans votre cas. Besoin d'aide pour? Veuillez lire notre guide ultime du copywriting SEO.

Essaye le!

La lisibilité et les analyses de contenu de Yoast SEO vous aident à rédiger d'excellents articles à l'épreuve du référencement faciles à saisir pour tous. Ce faisant, vous vous assurez que chaque élément de contenu que vous écrivez est prêt à commencer le classement dans les moteurs de recherche, tout en restant agréable pour les lecteurs. Vous n'avez pas encore Yoast SEO, ou vous voulez profiter des fonctionnalités supplémentaires impressionnantes de notre plugin Premium? Qu'est-ce que tu attends?

Lire la suite: Comment utiliser le contenu et l'analyse SEO de Yoast SEO »

Devenez une série pro Yoast SEO

Source link

Comment devenir un expert SEO (8 étapes)

Vous cherchez à devenir un SEO expert mais vous ne savez pas par où commencer?

Avec la demande de SEO professionnels plus haut que jamais et moyenne taux horaires assis entre 75 $ – 150 $, il existe une incitation financière claire à SEO.

Mais sans collèges offrant des diplômes en SEO, c'est à vous de tracer votre propre chemin dans l'industrie.

Dans ce guide, vous apprendrez à pénétrer le terrain et à démarrer votre parcours pour devenir un SEO expert en 8 étapes simples.

Que faisons-nous vraiment vouloir dire par "SEO expert"?

Expert est un terme relatif. Vous pourriez me voir comme un SEO expert, mais quelqu'un avec plus d'expérience comme Rand Fishkin ne le ferait certainement pas.

Peu importe vos connaissances SEO, il y aura toujours quelqu'un qui en saura plus.

Pour cette raison, votre objectif ne devrait pas être de devenir SEO expert en soi. Ce devrait être en apprendre suffisamment pour obtenir des résultats cohérents.

8 étapes pour devenir un SEO expert

Suivez ce processus simple pour passer de SEO débutant à SEO pro.

- Découvrez comment fonctionnent les moteurs de recherche;

- Comprendre les trois principaux facteurs de classement;

- Maîtrisez les quatre seaux principaux de SEO;

- Créer un site Web;

- Niche vers le bas;

- Créer des systèmes et déléguer;

- N'arrêtez jamais d'apprendre;

- Sois patient

L'index de Google contient des milliards de pages Web, qui est construit principalement à partir de rampant la toile.

Lorsque vous saisissez une requête dans Google, elle extrait toutes les pages correspondantes.

Comme il existe souvent des millions de résultats pertinents, l'algorithme de Google les classe ensuite en fonction de centaines de facteurs. Personne ne sait quels sont tous ces facteurs ni comment ils sont pondérés, mais nous en connaissons certains.

Sidenote.

SEO influence uniquement les résultats dits organiques. Cela n'affecte pas les annonces payantes.

En savoir plus sur ces facteurs dans ce post.

Beaucoup de gens s'enlisent dans l'optimisation des facteurs de classement qui ne sont pas si importants. Donc, avant de commencer à être obsédé par la vitesse de page ou balises de titre, assurez-vous d'être au-dessus des trois grands.

Pertinence

Voici à quel point votre page correspond à la requête.

Si quelqu'un tape "comment faire de l'huile de lavande" dans Google, alors Google ne retournera pas de pages sur les voitures parce que cela n'a pas d'importance.

Mais la pertinence va plus loin que cela. Votre page doit également correspondre à la type de contenu que les gens veulent voir.

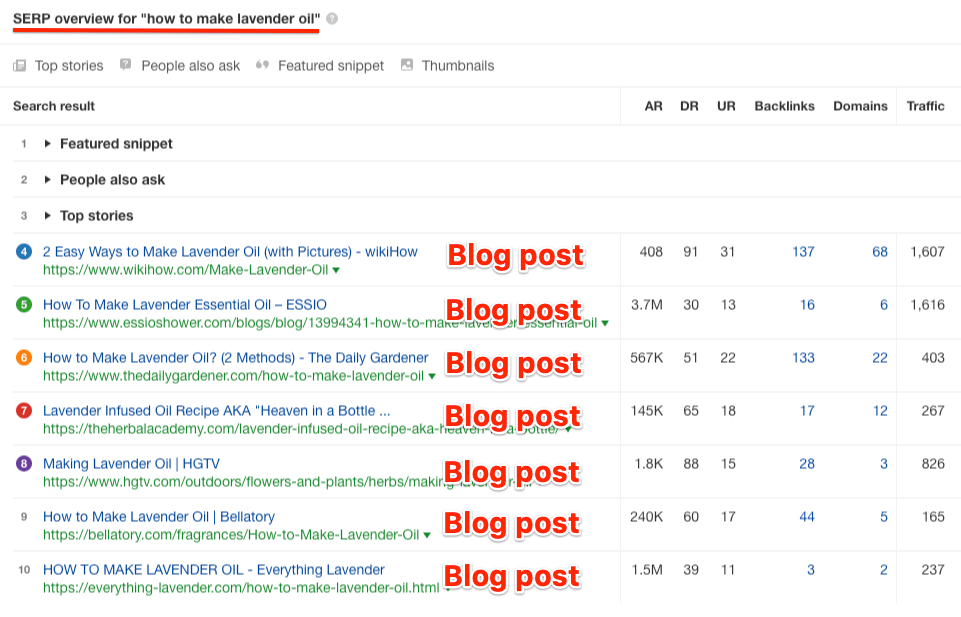

Par exemple, une personne qui cherche «comment faire de l'huile de lavande» veut un tutoriel. Ils ne cherchent pas à acheter de l'huile de lavande prête à l'emploi. C'est pourquoi tous les résultats de la première page sont des articles de blog et non des pages de produits.

Répondre au «pourquoi» d'une requête est appelé optimisation pour l'intention de recherche.

Autorité

Cela se résume en grande partie à backlinks.

Google considère les liens comme des votes de confiance. Plus vous avez de backlinks de haute qualité, plus vous êtes susceptible de vous classer.

Les meilleurs backlinks ont deux attributs clés: autorité et pertinence.

- Autorité se rapporte à la puissance du site Web de liaison et de la page Web. Chez Ahrefs, nous avons deux mesures pour mesurer cela: Évaluation du domaine et URL Évaluation. Les liens les plus puissants sont ceux des pages à haute UR.

- Pertinence se rapporte au sujet du site Web et de la page Web de liaison. Par exemple, si un article sur la fabrication d'huile de lavande a deux backlinks, l'un d'un blog technologique et l'autre d'un site Web de santé, celui du site de santé est probablement plus pertinent. Cependant, la pertinence au niveau de la page est également importante. Si la page de lien sur le site Web technologique concerne un sujet pertinent comme les meilleurs diffuseurs intelligents, et celle sur le site Web de santé concerne un sujet sans rapport avec la musculation, alors le lien du site Web technologique peut être plus pertinent.

Utilitaire

Google vise à montrer le meilleur résultat en pole position. Cela signifie qu'il ne suffit pas simplement de correspondre à l'intention de recherche. Votre contenu doit être le plus méritant de la première place.

Mais ce qui constitue la qualité et l'utilité dépend de la requête de recherche elle-même. Par conséquent, la meilleure solution consiste à examiner les pages actuellement les mieux classées et à voir ce qui est bon à leur sujet, et où elles ne sont pas à la hauteur.

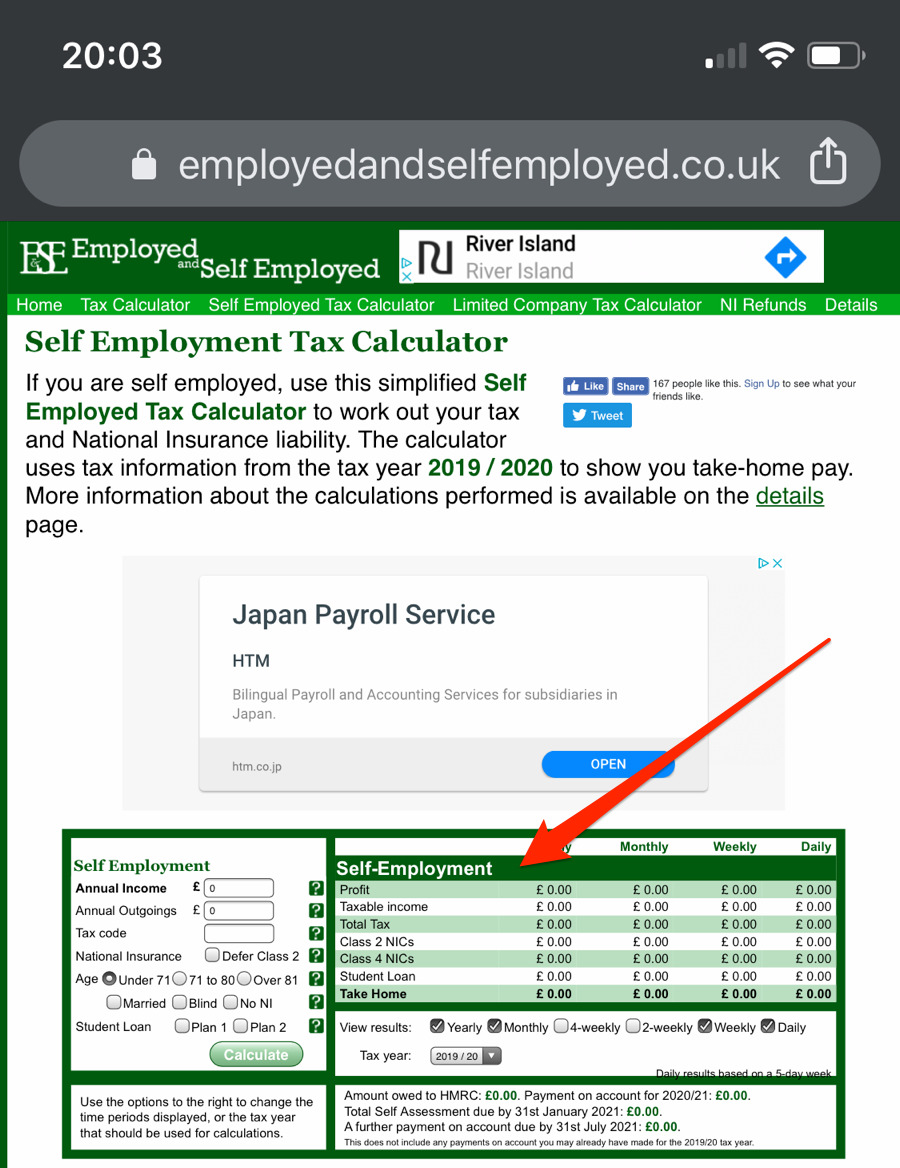

Par exemple, cette calculatrice fonctionne bien sur le bureau mais manque d'utilité pour les visiteurs mobiles car il est presque inutilisable sur mobile:

Penser à SEO comme un puzzle avec plusieurs pièces. Comprendre comment ils s'emboîtent est une connaissance essentielle pour tout professionnel de l'industrie.

Les quatre pièces sont:

- Recherche de mots clés;

- Sur la page SEO;

- Création de liens;

- Technique SEO

Voyons ce que cela implique.

Recherche de mots clés

La recherche par mot clé consiste à trouver des mots et des phrases pertinents que les gens tapent dans des moteurs de recherche comme Google.

En général, vous devez cibler des mots clés qui:

- Avoir un «potentiel de trafic» (c.-à-d., Sont susceptibles d'envoyer du trafic organique à votre façon si vous les classez)

- Avoir une «valeur commerciale» (c'est-à-dire susceptibles d'attirer des clients potentiels);

- N'est pas trop compétitif

Pour trouver des mots clés qui correspondent à la facture, entrez quelques idées dans Explorateur de mots clés d'AhrefsEt consultez l'un des rapports sur les idées de mots clés.

Pour chaque mot clé, vous verrez quelques statistiques importantes:

- Volume de recherche: le nombre moyen de personnes qui recherchent le mot clé chaque mois;

- Difficulté des mots clés (KD): la difficulté estimée de classement sur la première page de Google notés sur une échelle de 0 à 100;

- Clics: le nombre de clics sur les résultats de recherche de ce mot clé chaque mois.

Les meilleurs mots clés sont ceux qui présentent un potentiel de trafic élevé (c'est-à-dire un volume de recherche et des clics élevés), une valeur commerciale élevée et une difficulté de classement faible.

Sur la page SEO

Sur la page SEO est la pratique de l'optimisation des pages Web pour aider à améliorer les classements et attirer plus de trafic organique des moteurs de recherche.

Les exemples comprennent:

- Optimisation pour l'intention de recherche;

- Utilisation de modificateurs de mots clés dans vos balises de titre;

- Écrire des méta-titres et des descriptions attrayants;

- Utiliser des balises alt descriptives pour les images;

- Lien interne aux pages que vous souhaitez classer.

Pour en savoir plus sur la page SEO stratégies, regardez cette vidéo:

https://www.youtube.com/watch?v=gDYjjkvtOVo

Création de liens

Le renforcement des liens est le processus d'acquisition de nouveaux backlinks à partir de sites Web tiers. Ils aident à améliorer le classement et à augmenter le trafic organique, mais peuvent également envoyer le trafic de référence à votre guise.

Découvrez quelques tactiques éprouvées de création de liens dans ces vidéos:

https://www.youtube.com/watch?v=3sF-m5LKCf4Etlist = PLvJ_dXFSpd2tjUTuAHpHidz5e2hAedP_mEtindex = 2

Technique SEO

Technique SEO consiste à optimiser votre site Web afin que les moteurs de recherche puissent explorer et indexer efficacement votre contenu, et que les visiteurs aient une expérience utilisateur positive.

Les exemples comprennent:

Apprenez à effectuer une technique de base SEO audit du site dans cette vidéo:

https://www.youtube.com/watch?v=oJPGa0J6p5Q

Peu importe le nombre de livres que vous lisez sur le golf, vous ne gagnerez jamais un tournoi sans vous procurer un ensemble de clubs et vous entraîner.

Il en va de même pour SEO. Vous devez connaître la théorie, mais rien ne peut remplacer de se salir les mains et de classer un site.

Pour démarrer votre propre projet, il vous suffit de:

- Choisissez un sujet qui vous passionne;

- Acheter un domaine et un hébergement;

- Mettre en place un site Web de base;

- Commencez à créer du contenu

À partir de là, il s'agit de mettre votre SEO connaissances en pratique en optimisant votre contenu, en créant des liens et en vous assurant que votre site est techniquement solide SEO la perspective.

Rien ne vous en apprendra plus sur SEO que de faire ça.

Cela dit, cela prend évidemment du temps et rien ne prend plus de temps que d'écrire du contenu. Donc, si vous avez le budget pour le faire, il n'y a pas de honte à externaliser du contenu. Assurez-vous simplement de donner à votre rédacteur des instructions claires afin que ce qu'il produit soit optimisé pour le classement.

Envie de prendre des clients?

Imaginez que vous êtes un propriétaire d'entreprise qui cherche à embaucher un SEO. Souhaitez-vous embaucher quelqu'un qui n'a pas classé un site Web dans sa vie? Définitivement pas. Pour cette raison, bien que vous puissiez être tenté de vous lancer dans des projets indépendants au début, il est injuste de mettre en danger les moyens de subsistance de quelqu'un juste pour pouvoir pratiquer et affiner votre métier.

Si vous souhaitez accélérer le processus d'apprentissage, obtenez plutôt un poste de débutant dans une agence respectée.

Jack de tous les métiers, maître de rien.

C’est ce que vous serez au début de votre SEO voyage puisque vous devez en apprendre un peu sur tout pour avoir une base solide dans le domaine.

Cependant, vous devez dépasser cela au fil du temps.

Voici deux façons de procéder:

A. Maîtrisez une compétence spécifique SEO

Car SEO est un domaine tellement vaste, vous n'aurez pas le temps de devenir un expert à la fois du renforcement des liens et de la technique SEO. Il y a tellement peu de chevauchement entre les deux que l'amélioration d'une compétence n'améliore pas vraiment l'autre.

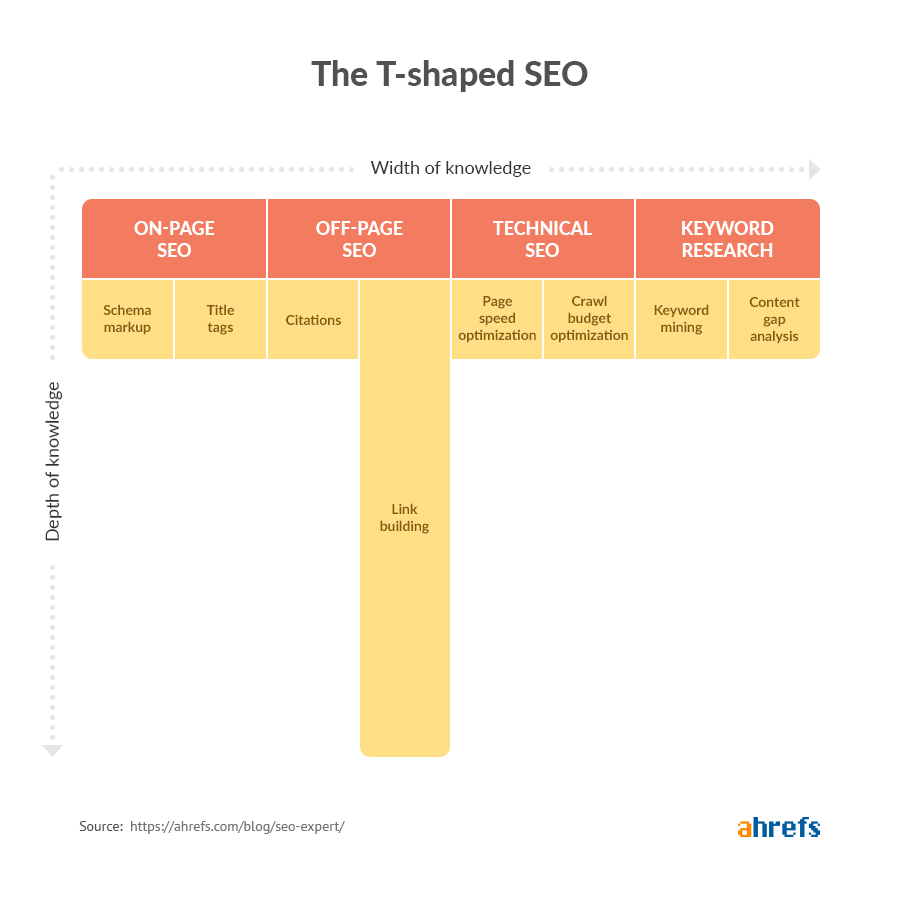

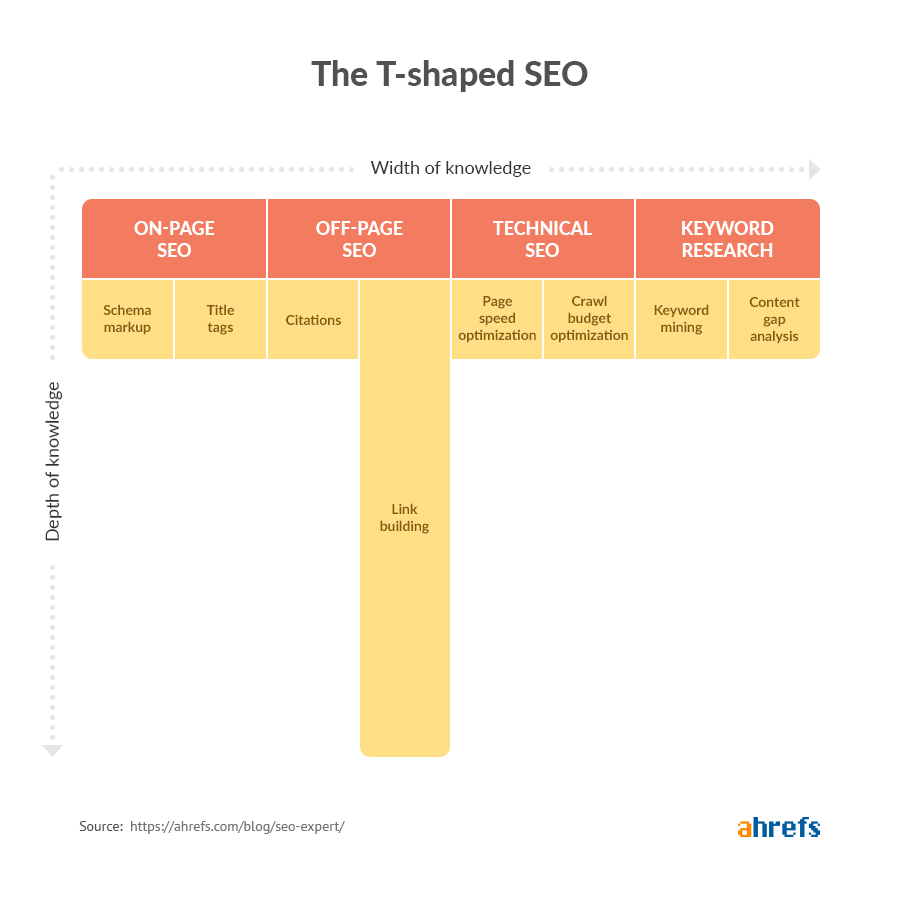

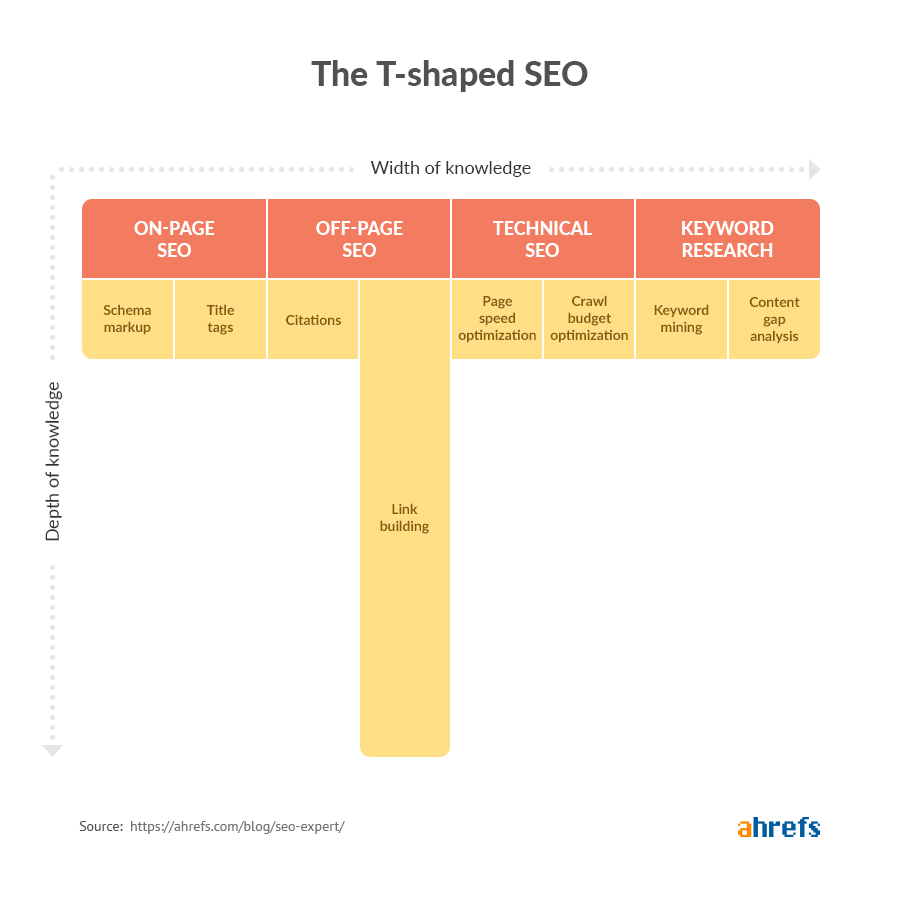

Au lieu de cela, vous devriez devenir ce qu'on appelle un T SEO expert.

Être en forme de T SEO expert signifie que vous avez de vastes compétences dans tous les domaines SEO, mais exceller dans un domaine particulier.

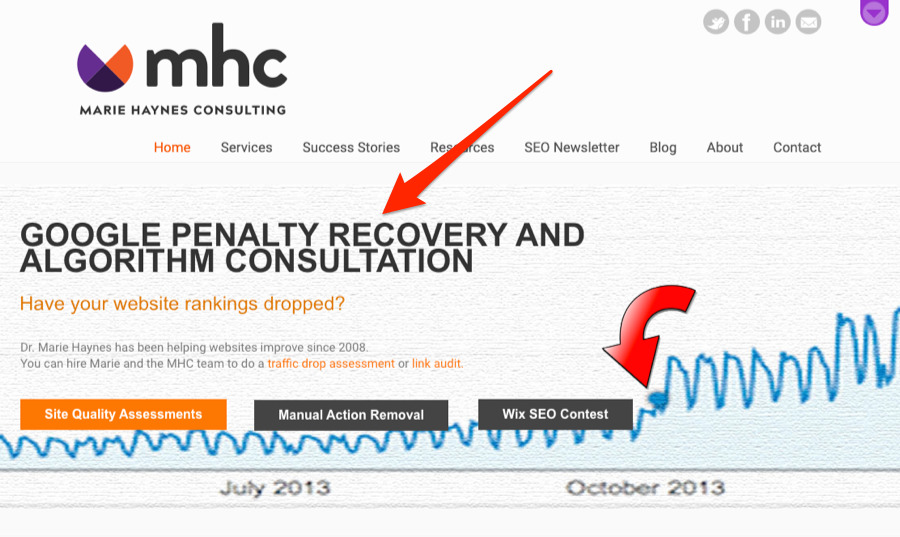

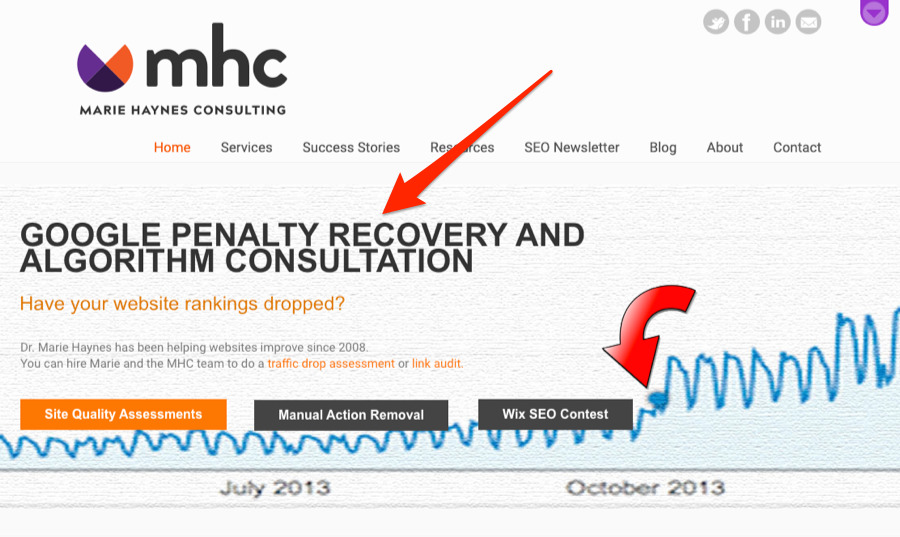

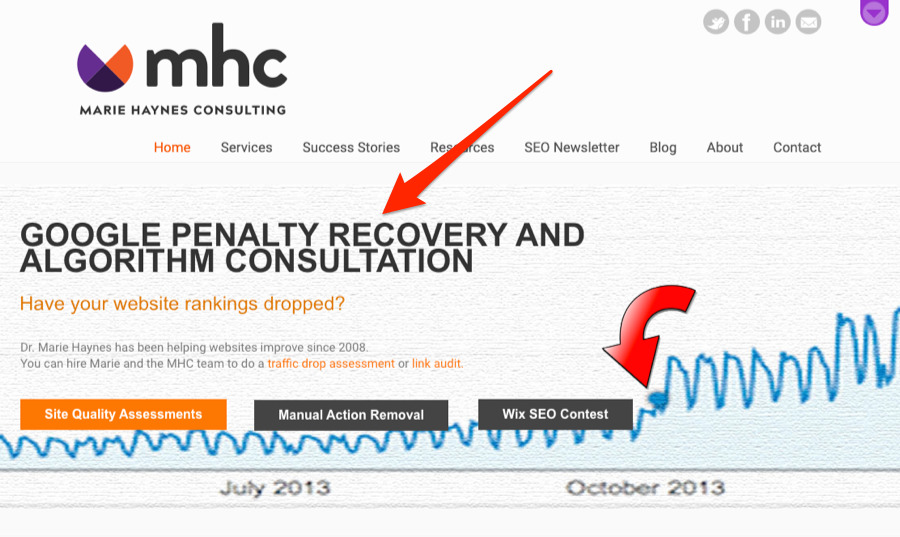

Marie Haynes est un exemple fantastique de distributeur en forme de T. Elle est spécialisée dans la récupération des pénalités Google et la consultation d'algorithmes. Elle ne crée pas de liens. Elle ne fait pas sur la page SEO. Elle vérifie les sites Web avec des baisses de trafic pour savoir ce qui s'est passé et aide les propriétaires d'entreprise à rectifier la situation.

Seeker Digital, une agence spécialisée dans la sensibilisation, est un autre bon exemple.

Maître SEO pour une industrie

Faire SEO pour les agents immobiliers nécessite une approche complètement différente de commerce électronique SEO.

Pour l'agent immobilier, les priorités peuvent inclure la mise en place d'un profil Google My Business et l'inscription dans les annuaires populaires de l'industrie. Pour une boutique en ligne, l'optimisation des pages produits et catégories est probablement plus importante.

Devenir la référence SEO expert pour un type d'entreprise est un excellent moyen d'affiner vos compétences et votre offre client. Cela peut également être extrêmement lucratif.

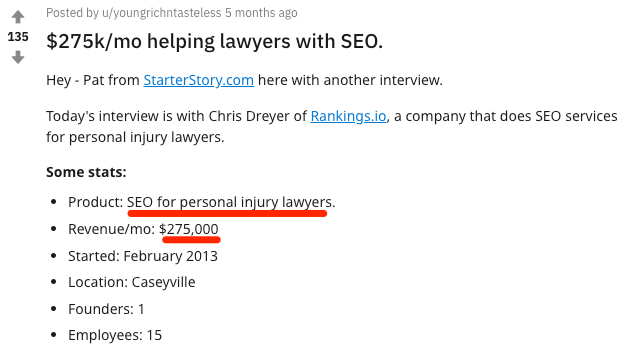

Exemple: cette entreprise ne SEO pour les cabinets d'avocats en dommages corporels et chiffre d'affaires supérieur à 275 000 $ / mois—Et c'est avec seulement 15 employés:

Donc, bien que vous puissiez créer une entreprise rentable, SEO services pour toutes sortes d'entreprises, il est plus facile de perfectionner votre métier lorsque vous vous concentrez sur un créneau.

Assurez-vous simplement que votre créneau choisi est à la fois quelque peu lucratif et intéressant pour vous. Par exemple, si vous êtes intéressé par l'immobilier, vous pouvez fournir SEO services aux sociétés immobilières. C’est un créneau où l’argent circule assez librement et où les entreprises sont toujours à la recherche d’une longueur d’avance.

Plus vous en apprenez sur SEO, plus vous vous rendrez compte qu'il n'y a pas assez d'heures dans la journée pour tout faire vous-même.

Mais même s'il y en avait, le faire serait toujours inefficace.

Être un «en forme de T SEO «expert» signifie qu'il y a des gens qui sont mieux équipés pour gérer la plupart SEO tâches que vous. Déléguer ces tâches aux bonnes personnes vous libère du temps à consacrer aux choses que vous préférez et que vous aimez le plus.

Par exemple, si votre expertise réside dans la recherche de mots clés et la rédaction de contenu qui se classe, c'est ainsi que vous devriez passer votre temps. Vous pouvez faire appel à quelqu'un pour gérer des tâches telles que la création de liens et l'assistance technique. SEO.

Grâce au gain de temps passé, vos clients bénéficieront d'un meilleur service car ils disposent de personnes hautement spécialisées qui travaillent sur tous les aspects de leur SEO.

Cependant, plus de personnes signifie plus de pièces mobiles, ce qui peut entraîner des choses tombant entre les fissures.

La création de systèmes est le meilleur moyen de garder tout le monde sur la même longueur d'onde. Cela signifie créer SEO listes de contrôle (ou SOP) que vous utilisez sur chaque projet pour garder les choses sur la bonne voie.

Voici un système pour générer un flux cohérent de backlinks de haute qualité pour vous aider à démarrer:

https://youtube.com/watch?v=Ovu2ZYWgOJQ

SEO se déplace rapidement. Rien qu'en 2018, Google a signalé avoir effectué plus de 3 200 mises à jour d'algorithmes.

Bien que bon nombre de ces mises à jour aient été relativement mineures pour les utilisateurs, cela vous donne une bonne idée de la vitesse à laquelle les «meilleures pratiques» dans SEO Peut changer. Cela dit, essayer de garder le contrôle sur chaque petit changement que Google fait est probablement un effort futile, il est donc préférable de rester concentré sur les fondamentaux.

En d'autres termes, plutôt que de poursuivre les modifications de l'algorithme, poursuivez ce que l'algorithme essaie de faire: fournir le contenu le meilleur et le plus pertinent aux utilisateurs. De cette façon, vous n'aurez pas à vous soucier autant des mises à jour et des pénalités.

Cela signifie-t-il que vous ne devriez pas travailler en réseau et suivre des experts pour élargir vos opportunités et rester au courant de nouvelles stratégies précieuses? Bien sûr que non. Voici donc quelques façons de le faire:

Choisissez celles qui vous plaisent le plus, mais n'allez pas trop loin. Suivez le principe de Pareto et passez 80% de votre temps Faire et 20% de votre temps apprentissage.

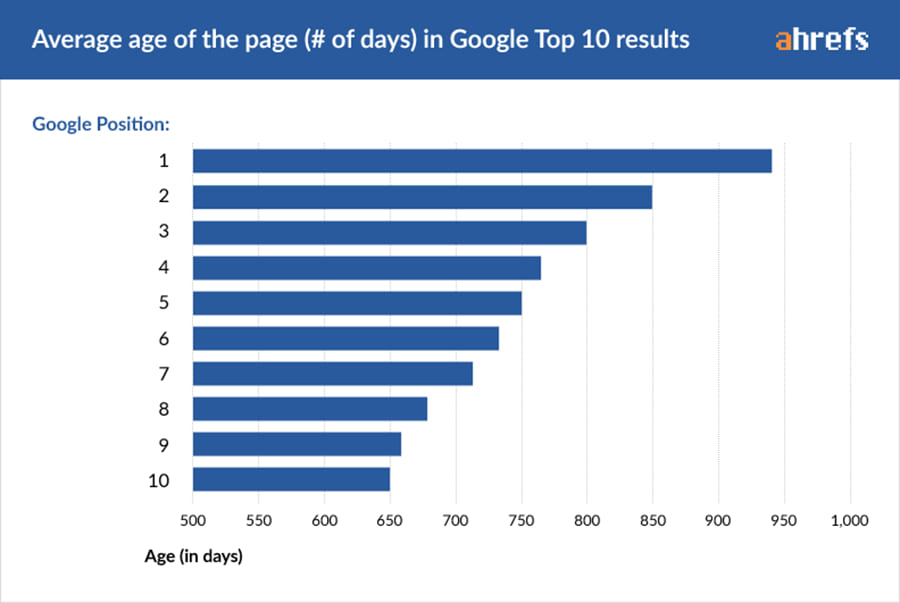

K Anders Ericsson célèbre théorisé qu'il faut 10 000 heures de pratique pour maîtriser une nouvelle compétence. Cela peut-il prendre moins? Peut-être. Mais le point est le suivant: devenir un SEO expert n'est pas un processus du jour au lendemain.

Donc, ne vous sentez pas mal si votre contenu n'atteint pas la première page au cours des deux premières semaines.

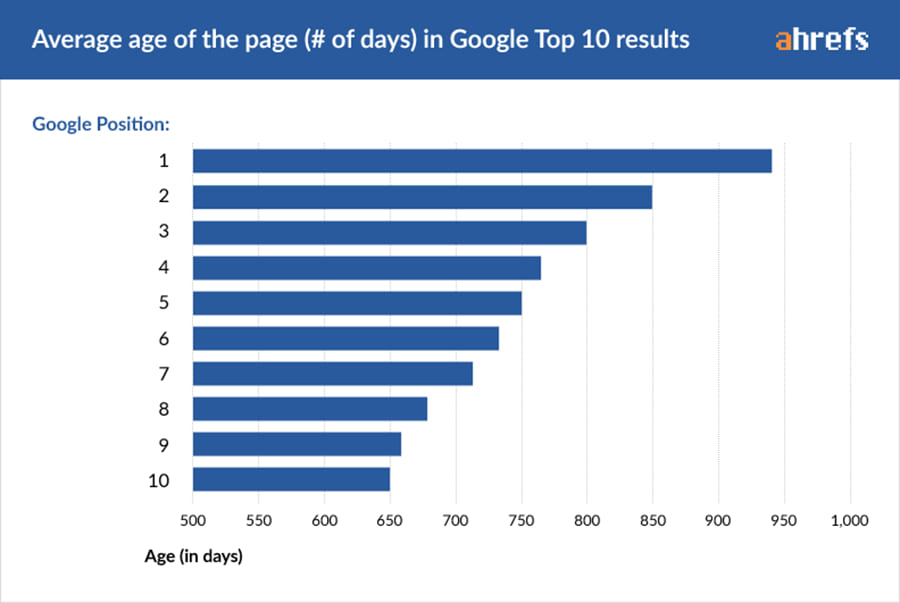

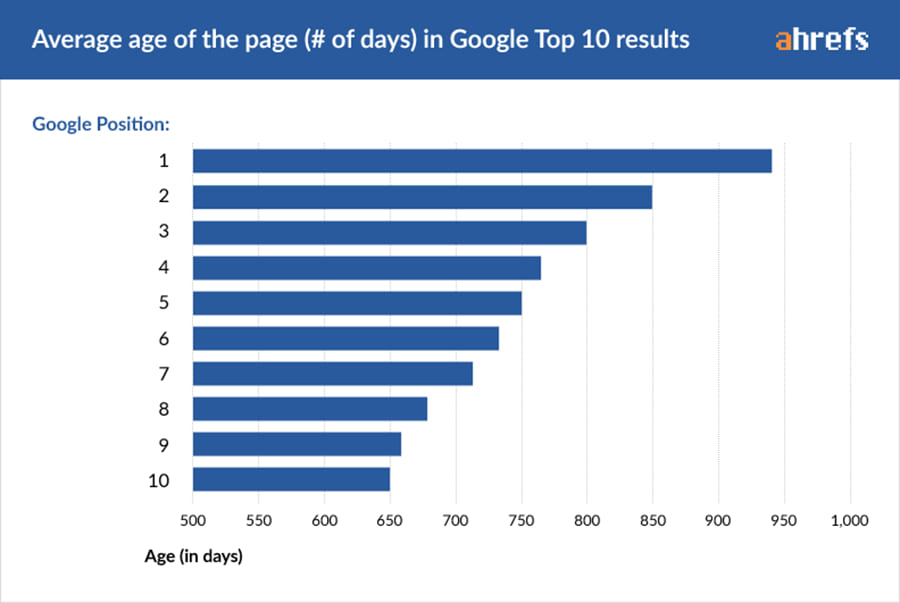

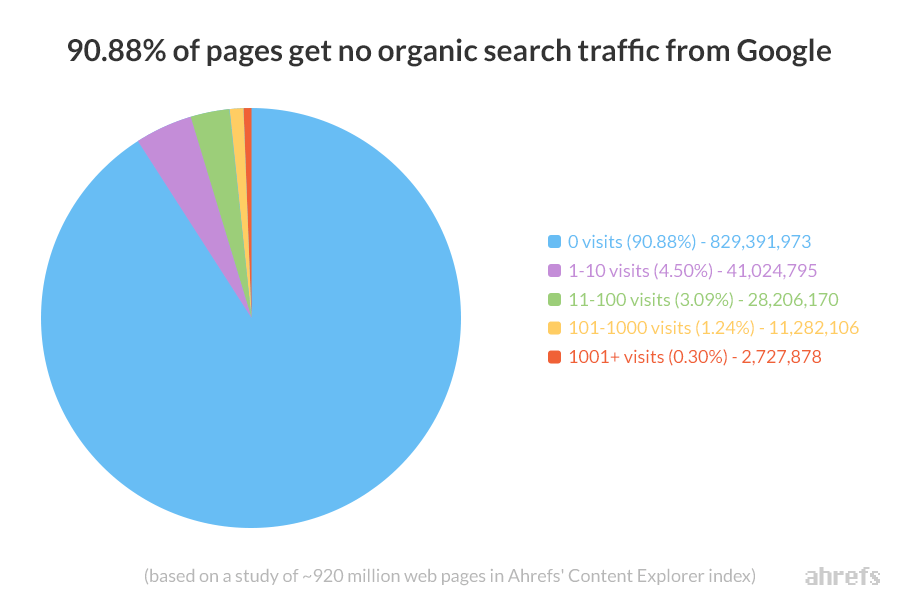

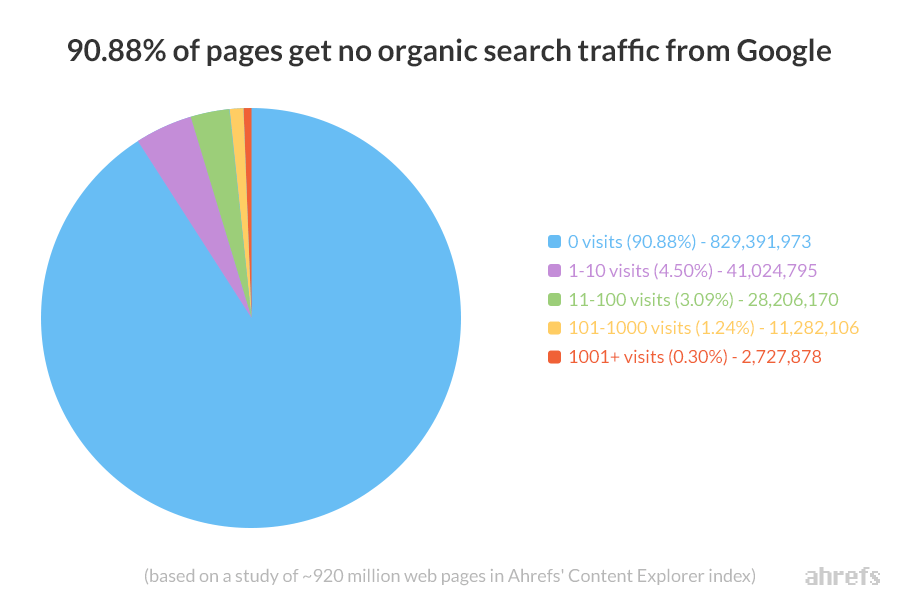

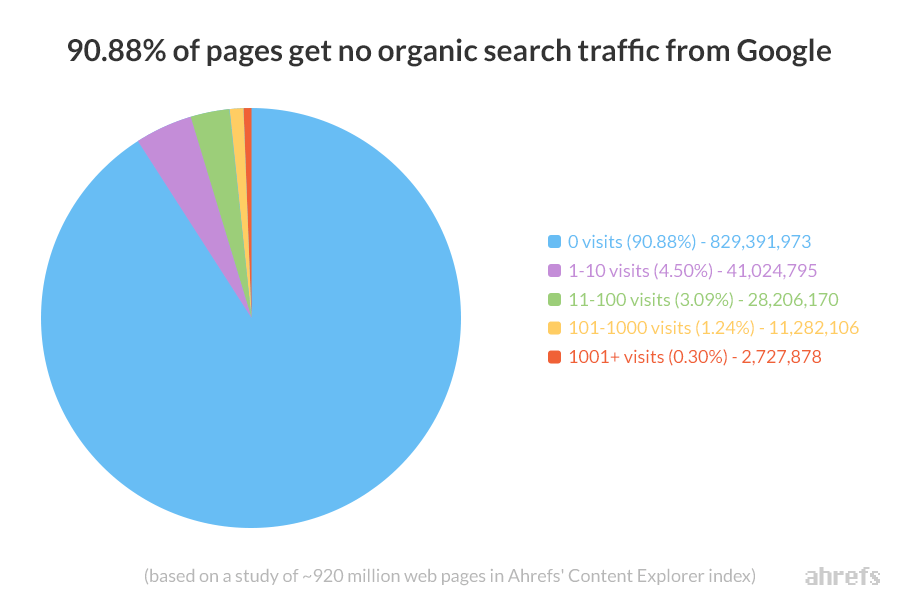

Il est peu probable que cela se produise, selon notre recherche.

Cependant, si vous créez un bon contenu, optimisez vos pages, suivez les meilleures pratiques de recherche de mots clés et créez suffisamment de liens de haute qualité, vos pages finiront par commencer à se classer.

Alors continuez à moudre, gardez votre patience et n'abandonnez pas.

Vous avez des questions? Frappez-moi dans les commentaires ou Tweet moi.

Améliorer la personnalisation avec l'apprentissage automatique

En tant que spécialiste du marketing, vous devez avant tout vous demander comment vous assurer de survivre non seulement à la concurrence, mais aussi de devenir l’un des leaders du marché.

Et pour devenir un leader du marché, vous devez travailler sérieusement personnalisation mais cela à grande échelle parce que vous devez vous concentrer sur le marché mondial, vous devez exiger une automatisation et c’est là que apprentissage automatique entre.

Vous devez créer une présence numérique qui contribuera à renforcer l'engagement des clients, à accroître la notoriété de la marque et à renforcer les objectifs de l'entreprise. On s’attend à ce que vous travailliez sur votre contenu Web et développiez vos capacités de gestion de la relation client. Vous devez également vous rappeler qu’il est absolument nécessaire de déployer divers efforts pour automatiser les activités de marketing clés.

Avec le marché mondial comme cible, obtenir une tâche personnelle peut-être une tâche difficile, mais vous pouvez améliorer cela avec un personnalisation moteur. Votre objectif ultime sera de cibler le contenu que vous fournissez à vos clients et prospects en fonction de ce que vous savez à leur sujet et de ce dont vous pensez qu’ils pourraient avoir besoin.

Personnalisation ou personnalisation

Avant de vous lancer dans l’intégration de l’apprentissage automatique, il est essentiel de ne pas confondre personnalisation et personnalisation. Alors que la personnalisation est effectuée dans l’intérêt du client, celle-ci est lancée par le client dans le but de rechercher le contenu souhaité.

Dans les recherches de PWC intitulé «Services financiers à l’horizon 2020 et au-delà: bouleverser les bouleversements», il a été observé que l’intelligence client serait le principal prédicteur de la croissance des revenus et de la rentabilité. La personnalisation est l’incroyable résultat de votre intelligence client qui vous permettra de contrôler les clients qui envoient beaucoup de messages par le biais de promotions globales, ce qui se traduira également par une réduction considérable des achats de supports.

La personnalisation est une mission essentielle que votre startup ne peut se permettre de jouer pour se lancer dans un marketing efficace. Une fois que vous êtes en mesure de personnaliser le parcours de vos clients potentiels, vous êtes sur le point de renforcer leur engagement client et de le fidéliser à long terme.

Vous pouvez vous inspirer de la façon dont Netflix formule des recommandations de film, des suggestions de musique de Spotify et des promotions spéciales sur Amazon pour vraiment comprendre l'effet personnalisé. contenu c'est avoir et que cela ne devient pas seulement la norme mais une attente du consommateur. Toutes ces grandes entreprises technologiques sont en mesure d'accomplir cette lourde tâche en intégrant l'apprentissage automatique, qui devient rapidement un outil essentiel et indispensable dans la personnalisation du contenu.

Fait intéressant, il existe un grand nombre de fournisseurs de moteurs de personnalisation. Evergage, Monetate, Certona et Dynamic Yield sont quelques-uns des fournisseurs du marché proposant ce service. «Gartner’s»Quadrant magique pour les moteurs de personnalisation«Le rapport de 2019 montre que l'adoption du moteur de personnalisation est en hausse de 28% depuis 2016.

Vous devez localiser les points essentiels de votre parcours client qui sont: optimal pour ajouter une touche personnelle. Le contexte a toujours été à l'origine des différences entre les clients, qui entraînent généralement un besoin de contenu spécifique.

La personnalisation étant prédictive, l'apprentissage automatique a commencé à jouer un rôle central.

Vous trouverez ci-dessous trois manières d'utiliser l'apprentissage automatique pour améliorer la personnalisation.

1. Utilisation de données démographiques sécurisées

La base de données démographiques est d’avoir accès aux comportements et préférences distinctifs de vos clients, ce que vous pouvez appliquer avec l’apprentissage automatique. Bien qu'il soit facile pour vous de mettre la main sur ces informations, il existe un cliché.

Vos concurrents, surtout ceux qui ont accès à gros moteurs de recherche pouvez utiliser ces moteurs de recherche pour trouver des informations très personnelles sur vos clients, telles que des problèmes médicaux, le statut professionnel, des informations financières, des convictions politiques et d'autres informations confidentielles. Ces données seront bien sûr collectées, stockées et liées à votre profil de données.

La seule façon efficace de ne pas participer à cette opération consiste à protéger vos données des données. Les cybercriminels savent également que cette information est une mine d’or et ont hâte de la saisir.

Des données démographiques complètes peuvent souvent révéler un profil socioéconomique complet pour les clients – leur distance par rapport aux commerces, leur revenu moyen, leur âge moyen, leurs ratios ethniques, leur population d’étudiants jeunes ou universitaires et parfois même les statistiques concernant les couples mariés ou célibataires.

Tandis que vos concurrents utiliseront ces données pour former et améliorer leur modèle prédictif, tout en simplifiant de la même manière le problème ultime de personnalisation des données, les cybercriminels utiliseront ces informations pour lancer des attaques sur vos clients ou même pour paralyser votre entreprise.

En tant que nouveau fondateur, vous envisagez peut-être les conséquences financières de la sécurisation de vos données, mais cela vous évitera de très mauvaises expériences. Si vous ne disposez pas des fonds nécessaires pour un VPN payant, rien ne vous empêche de vous abonner aux services d’un VPN gratuit.

Ce que vous finissez par obtenir est la capacité de masquer votre I.P. Adressez et chiffrez tout le trafic, ce qui vous aidera à éliminer les blocages géographiques et contribuera à la sécurité de vos données démographiques et à la confidentialité en ligne ultime.

2. Qui constitue votre public des médias sociaux?

Cross-canal La personnalisation est une source d’information très bénéfique, car le canal de prédilection des clients pour les réseaux sociaux est un moyen de découvrir à quel point le client est amical envers les contacts mobiles. C’est aussi un moyen d’accumuler des données démographiques du simple fait que différents groupes d’âge et groupes sociaux préfèrent différentes plateformes de médias sociaux.

Par exemple, Gen Z est connu pour avoir une préférence pour Instagram et Snapchat, tandis que la génération X et millennials s'accrochent plus à Facebook.

3. Comprendre les comportements en ligne de vos consommateurs

Outre les données démographiques et les personnes appartenant à votre audience sur les réseaux sociaux, une autre source d’informations qui vous permet de mieux comprendre le consommateur individuel dans la personnalisation consiste à appliquer l’apprentissage automatique pour une connaissance complète du comportement en ligne de votre consommateur. Le chemin de navigation de votre consommateur potentiel peut révéler beaucoup de choses sur la personne.

Vous aurez une idée très utile des préférences de votre consommateur. Le temps qu’il passe à parcourir les pages de votre site est un indice révélateur du degré de priorité de ce dernier et une source de données précieuses. Bien que vous ne puissiez peut-être pas collecter manuellement toutes ces informations précieuses, l’apprentissage automatique peut facilement donner un sens à ce comportement quelque peu «erratique».

L'apprentissage automatique est capable d'articuler les visites répétées sur le site et de proposer un profil approfondi et bien informé du client et de ses préoccupations.

Il est très important pour vous de savoir que pour réussir à intégrer l'apprentissage automatique à vos efforts d'amélioration de la personnalisation, vous devez vous efforcer de personnaliser le contenu sur tous les canaux. Cela garantira que votre les clients se sentent personnellement engagés en temps réel et où qu'ils soient.

Les pages produits de vos sites Web de démarrage doivent être pleines d’intérêt et adaptées aux préférences de chacun. Déployez la publicité prédictive sur la plate-forme de médias sociaux choisie par le consommateur.

Vous ne vous arrêtez pas à vos efforts sur votre site Web, vous exploitez les offres de courrier électronique en tant que référentiel de contenu personnalisé fiable. En effet, il est plus facile de proposer du contenu optimisé dans un courrier électronique que de travailler avec brio de telles merveilles sur une plate-forme. page Web. Cependant, l'intégration de l'apprentissage automatique en tant qu'application de l'intelligence artificielle vous offre la possibilité d'améliorer la personnalisation à grande échelle.

John Ejiofor est le fondateur et rédacteur en chef de Nature Torch. Il peut être trouvé sur Twitter .

Lecture connexe

Dans quelle mesure la recherche vocale est-elle développée? Quelles stratégies spécifiques les marques doivent-elles appliquer? Regard sur la situation actuelle et la voie à suivre.

Stimuler les affaires à partir d’annonces sociales payées est un défi pour les parties prenantes B2B. Un aperçu de ce qui fonctionne bien dans l'espace B2B et comment le faire fonctionner pour vous.

Le 30 septembre, Google a désactivé la position moyenne en tant que métrique. Moyens d'aider les annonceurs à définir de nouveaux paramètres: partage d'impressions et taux d'impressions.

Source link

Comment configurer un magasin affilié Amazon sur WordPress (La méthode la plus simple)

Souhaitez-vous créer un magasin affilié Amazon? Voulez-vous monétiser votre site Web WordPress?

Avec le programme d'affiliation Amazon Associates, vous pouvez créer un magasin en un rien de temps et à un coût minimal. Et puis commencez à vendre des produits pour gagner une commission sur chaque vente que vous effectuez.

C’est également l’un des moyens les plus simples de gagner de l’argent à partir de votre site Web existant, car vous pouvez ajouter des produits Amazon.

Dans cet article, nous allons vous montrer comment configurer un magasin Amazon Affiliate sur WordPress.

Qu'est-ce qu'un magasin d'affiliation Amazon?

Un magasin affilié Amazon est le lieu où vous vendez des produits Amazon.com sur votre site Web ou dans une boutique en ligne.

Alors, comment gagnez-vous de l'argent? Lorsque quelqu'un clique sur les produits répertoriés sur votre site, ils sont transférés sur Amazon. Et s'ils complètent l'achat, vous gagnez une certaine commission sur la vente. C'est si simple!

La beauté d'un magasin affilié Amazon réside dans le fait que contrairement à un magasin en ligne traditionnel, vous n'avez pas à vous soucier de l'expédition, de la logistique, de l'inventaire ou de la gestion des commandes. Amazon gère tout.

Prêt à créer votre magasin affilié Amazon sur WordPress? Lançons les choses…

Comment démarrer un magasin d'affiliation WordPress Amazon?

En suivant ces étapes, vous commencerez très rapidement à gagner de l'argent avec votre programme Amazon Associates et vous aurez votre propre magasin affilié opérationnel.

Étape 1: Obtenez un nom de domaine, un hébergement Web et des certificats SSL

Si vous construisez un magasin sur WordPress à partir de rien, vous aurez besoin de 3 éléments de base:

- Nom de domaine – c’est l’URL ou l’adresse Web de votre site Web, comme www.example.com ou www.monsterinsights.com

- Service d'hébergement Web – fournit un serveur sur lequel vous pouvez stocker toutes vos images, vidéos, contenus et autres éléments de site Web

- Certificat SSL – SSL signifie Secure Sockets Layer et chiffre toutes les communications entre votre utilisateur et votre site

Comme vous venez tout juste de commencer, nous vous recommandons de vous procurer Bluehost WooCommerce plan. Bluehost est l'un des meilleurs partagés services d'hébergement et est recommandé par WordPress et WooCommerce.

Thèmes WordPress

Thèmes WordPress

Vous pouvez également consulter nos guides sur comment créer un magasin WooCommerce et combien coute la creation d'un magasin en ligne pour plus de détails.

Étape 2: Inscrivez-vous pour un compte Amazon Associates

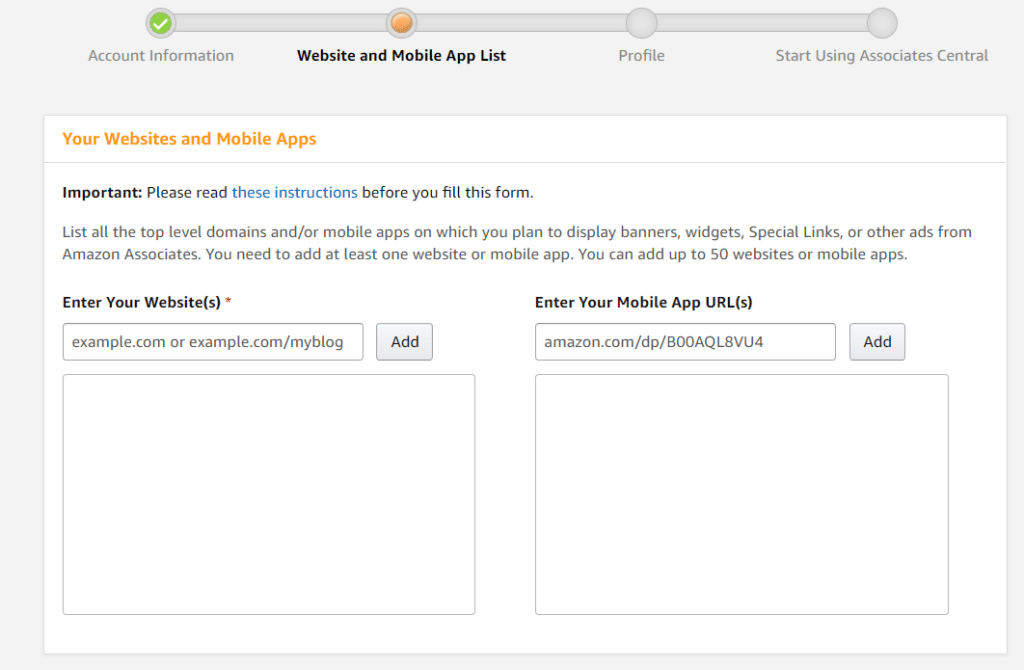

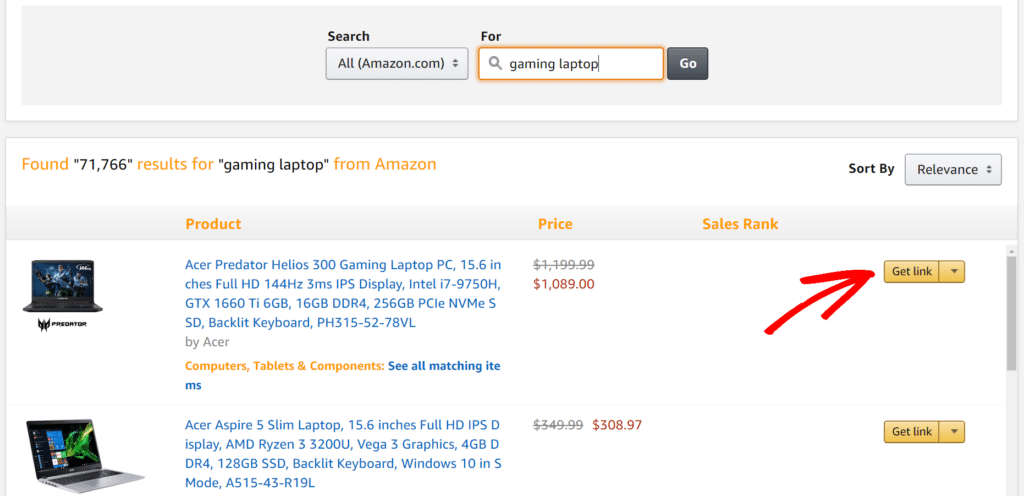

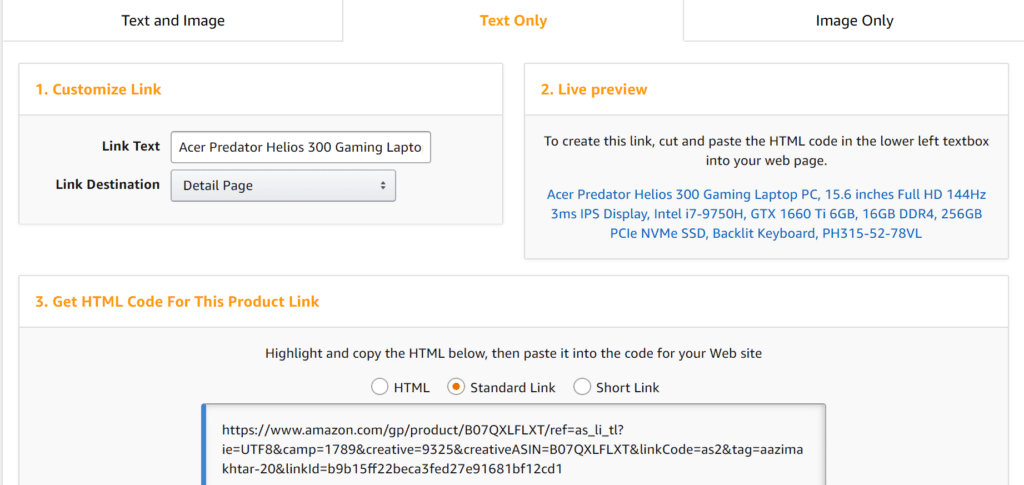

Une fois votre boutique créée, il est temps de créer un compte sur Amazon Associates. Le processus d'inscription est très simple et rapide. Aller à Site affilié Amazon Associates et cliquez Rejoins maintenant gratuitement.

WooCommerce WordPress plugin pour ajouter des produits à votre magasin affilié Amazon.

WooCommerce WordPress plugin pour ajouter des produits à votre magasin affilié Amazon.

Si vous construisez votre site Web à partir de la base, WooCommerce sera pré-installé avec Bluehost. Mais si vous avez déjà un site Web, vous pouvez ajouter le plug-in pour intégrer les produits d'Amazon.

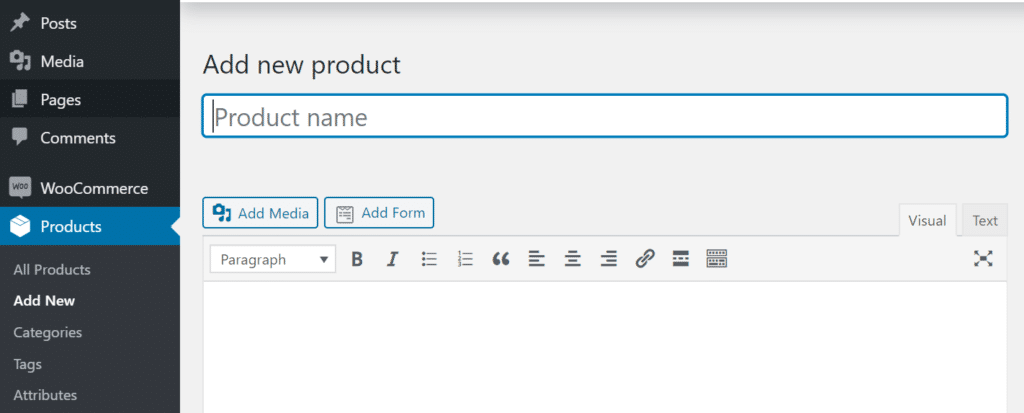

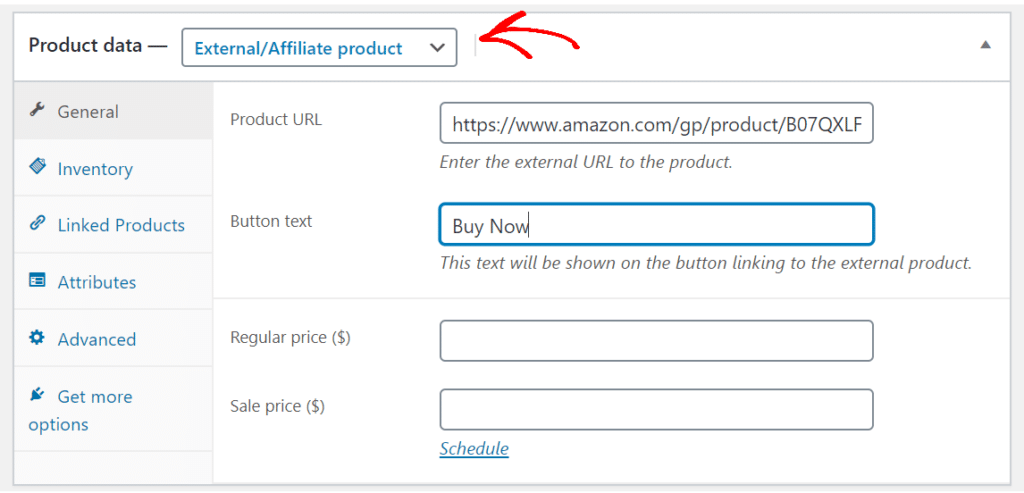

Pour commencer à ajouter vos produits, accédez à votre tableau de bord WordPress, puis cliquez sur Produit » Ajouter un nouveau. Ici, vous devrez entrer le nom du produit et sa description.

gagner plus d'argent depuis votre magasin e-commerce.

gagner plus d'argent depuis votre magasin e-commerce.

Une fois que vous avez terminé, cliquez sur Publier et vous êtes Amazon Affiliate Store est prêt à être mis en ligne!

Étape 5: Suivez vos liens d’affiliation Amazon dans WordPress

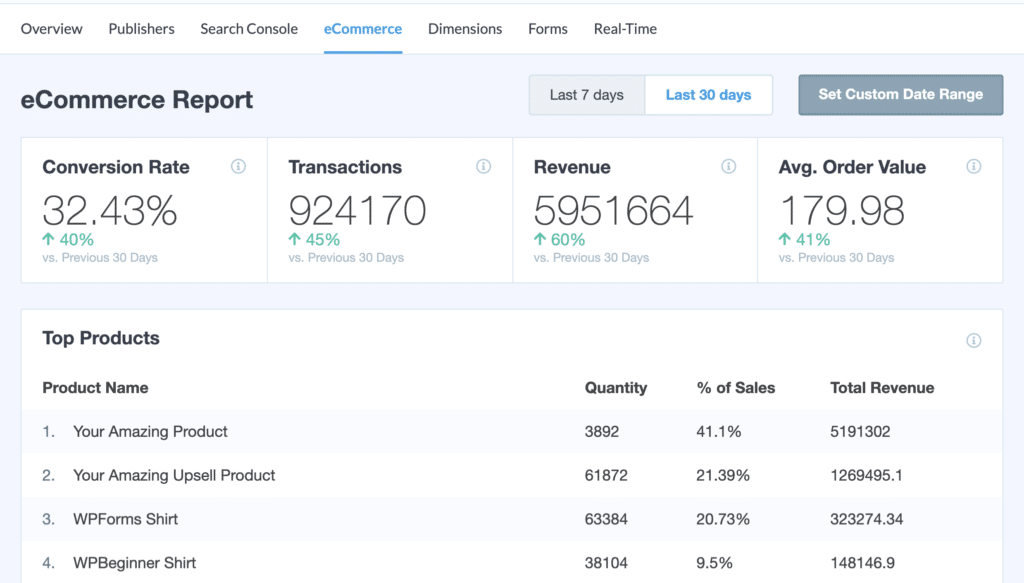

Maintenant que votre magasin est en ligne, comment pouvez-vous mesurer et suivre ses performances? Une solution simple consiste à utiliser MonsterInsights.

C’est le meilleur plugin WordPress pour Google Analytics. Automatiquement suit les liens d'affiliation Amazon sur votre site Web sans codage ni configuration supplémentaire.

Addon MonsterInsights pour le commerce électronique

Addon MonsterInsights pour le commerce électronique

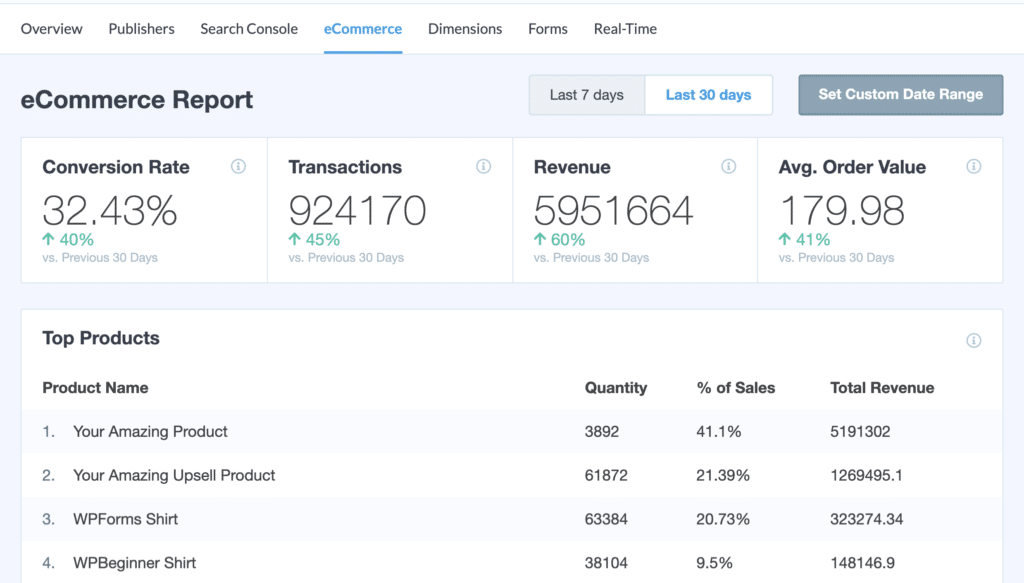

Et la meilleure partie est qu’il est prêt pour WooCommerce. Vous devez juste installer l'addon, activer le commerce électronique amélioréet MonsterInsights se chargera du reste.

Avec le rapport de commerce électronique, vous pouvez voir quels produits offrent les meilleures performances, quel est le taux de conversion de votre magasin, combien d’articles ont été ajoutés au panier et supprimés, etc.

Outils bonus pour surcharger votre magasin affilié Amazon

Vous êtes maintenant prêt à monétiser votre site Web et à gagner de l'argent avec le programme d'affiliation Amazon. Mais nous ne pouvons pas partir pour l'instant.

Voici quelques bonus WordPress plugins et outils cela peut vous aider à augmenter les conversions de votre site, augmenter le trafic, l'engagement, la présence des moteurs de recherche, etc.

- OptinMonster – C’est le meilleur plugin pour l’optimisation du taux de conversion. Vous pouvez l'utiliser pour ajouter des popups, des messages de sortie, générer des leads et monter en flèche vos ventes.

- WPForms – Si vous souhaitez ajouter des formulaires de commande, contactez-nous ou tout autre type de formulaire, WPForms est le meilleur plug-in à obtenir.

- RafflePress – Avec RafflePress, vous pouvez organiser de superbes cadeaux sur votre magasin affilié Amazon et obtenir du trafic, des suiveurs sociaux, des fiançailles et davantage de ventes.

- TrustPulse – En utilisant la puissance de la preuve sociale, vous pouvez afficher des notifications ou des FOMO dans votre magasin et faire exploser vos conversions..

- SemenceProd – C’est le meilleur plugin WordPress pour créer les prochaines pages. Vous pouvez l'utiliser pour créer un buzz sur les produits à venir.

- Yoast SEO – Le plug-in vous aide à optimiser les pages de vos produits pour le référencement afin qu'elles puissent occuper un rang supérieur dans les moteurs de recherche.

- Contact constant – Si vous envisagez d’envoyer des e-mails en masse ou commencer une newsletter, Constant Contact est le meilleur plugin pour automatiser vos flux de travail.

- Sucuri – La sécurité du site Web est d’une importance capitale, quel que soit le type de site Web que vous avez. C’est là que Sucuri est utile car il protège votre site contre toutes sortes de menaces.

Et c'est tout!

Vous êtes arrivé à la fin du guide.

Nous espérons que vous avez aimé notre article sur la création d’un magasin affilié Amazon sur WordPress. Vous pouvez également consulter notre guide sur comment suivre les conversions WooCommerce dans WordPress.

N'oubliez pas de nous laisser un commentaire pour toute question et suivez-nous sur Gazouillement et Facebook pour plus de tutoriels Google Analytics et WordPress.

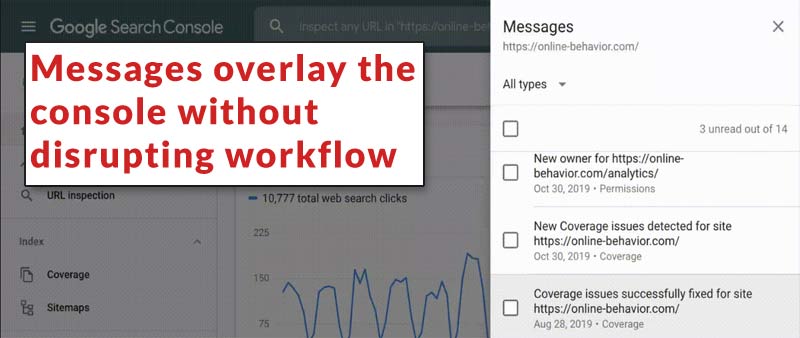

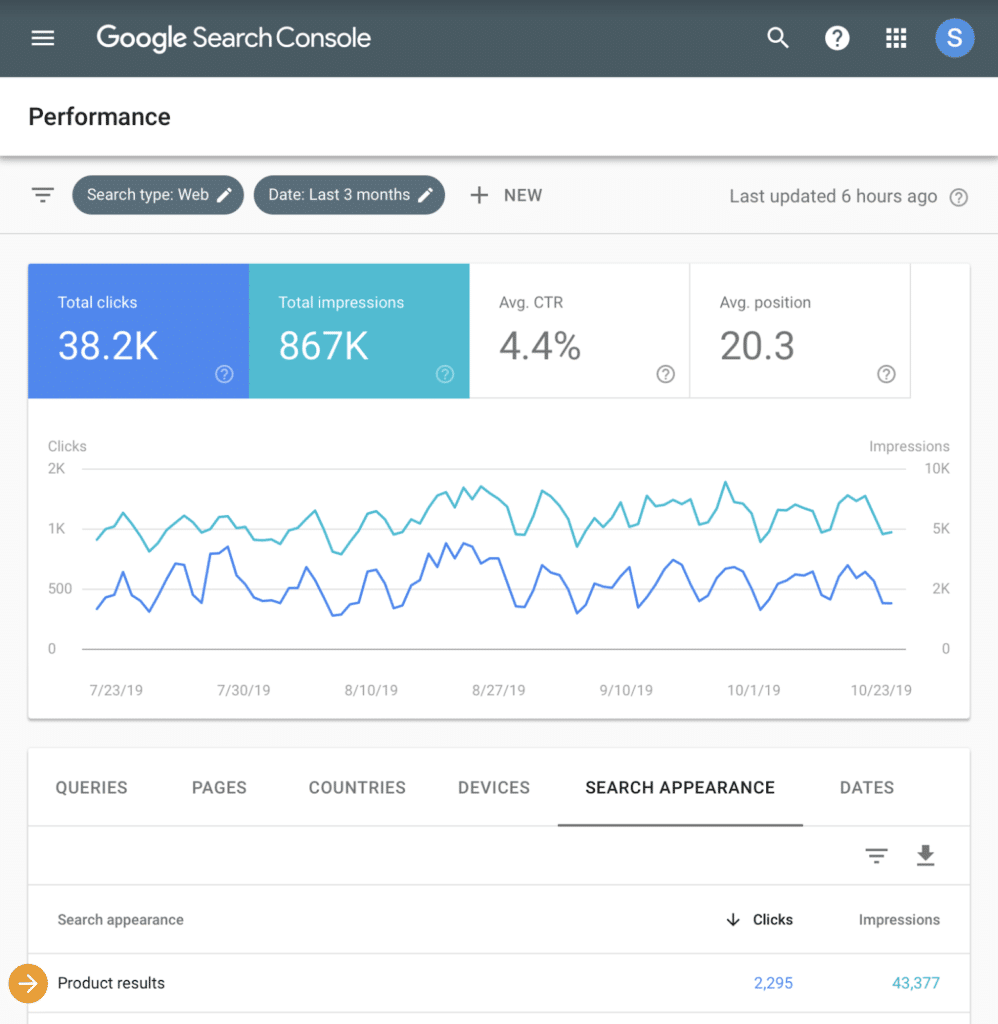

Nouvelle fonctionnalité de la console de recherche Google – Messages

Google a annoncé l'ajout d'une nouvelle fonctionnalité à la console de recherche Google. Cette nouvelle fonctionnalité permet aux éditeurs d'accéder à un panneau à partir duquel les messages de Google sont accessibles. Le panneau de messages cherche à améliorer l'efficacité de la communication de Google aux éditeurs.

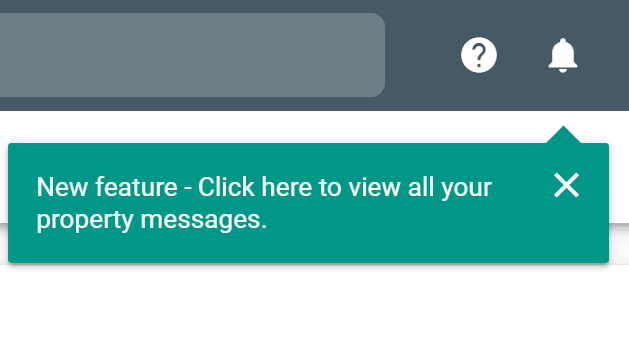

Les messages sont accessibles via l’icône cloche située dans le coin supérieur droit.

Selon Google:

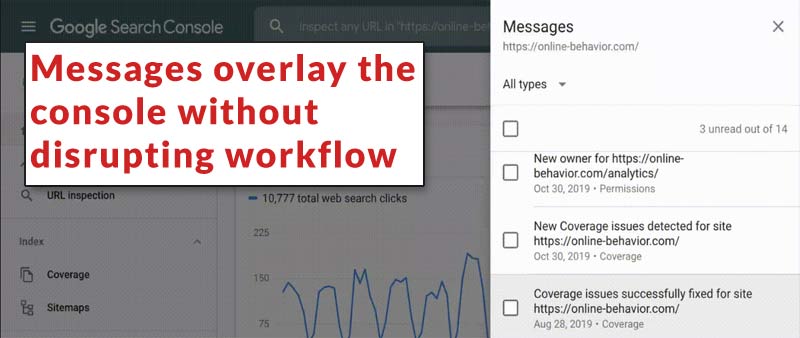

«À compter d’aujourd’hui, les messages seront accessibles via un panneau auquel vous pourrez accéder facilement en cliquant sur l’icône Cloche en haut de n’importe quelle page de la console de recherche. La principale différence par rapport à l’ancienne interface est qu’à présent, vous aurez accès à vos messages tout au long du produit, sans avoir à laisser vos rapports. ”

Les messages peuvent être consultés sans perturber votre flux de travail. Ils seront également classés. Les catégories typiques sont:

- Utilisabilité mobile

- Performance

- Couverture

- Chapelure

- Ensembles de données

- Données structurées imparables

- Des produits

Accéder aux messages plus anciens

Le panneau des nouveaux messages permettra aux éditeurs d’accéder aux messages plus anciens. Selon Google, cela permettra aux nouveaux utilisateurs ayant accès à la propriété GSC d’avoir une meilleure idée de l’historique du site en parcourant les messages précédents.

«Désormais, lorsque les utilisateurs ont accès à un nouveau site, ils peuvent voir les messages qu’il a reçus par le passé, ce qui devrait aider les nouveaux propriétaires à comprendre le contexte de cette propriété.»

Toutefois, cela se limite aux messages datant de mai 2019. Les messages plus anciens sont disponibles dans l'ancienne version (ancienne) de GSC, dans la section «Outils et rapports hérités».

Lire l'annonce officielle: Présentation des nouveaux messages de la console de recherche

Davantage de ressources

le guide ultime • Yoast

Marieke van de Rakt

Marieke van de Rakt est la fondatrice de Yoast Academy et la directrice générale de Yoast. Ses sujets de référencement préférés sont la rédaction SEO et la structure de site.

La recherche par mot clé est la première étape du processus de rédaction pour le référencement et un élément essentiel de toute stratégie de référencement. Avant de rédiger le contenu de votre site Web, vous devez réfléchir aux termes de recherche à rechercher, ce qui signifie qu’il faut vous mettre dans la tête des gens pour savoir quels mots ils utilisent lors de la recherche. Ensuite, vous pouvez utiliser ces termes exacts dans votre contenu pour pouvoir commencer. classement pour eux. Ceci est une recherche par mot-clé, et notre guide ultime vous guidera à travers les nombreuses étapes impliquées.

Nous espérons que vous apprécierez la lecture du # 7 de nos articles les plus lus cette année! Découvrez les étapes à suivre pour effectuer une recherche par mot clé appropriée. N'oubliez pas de vérifier demain pour une autre surprise du compte à rebours des vacances!

Qu'est-ce que la recherche par mot clé?

Avant de commencer à expliquer le processus de recherche par mot-clé, examinons les concepts les plus importants qui s’y trouvent.

Recherche de mots clés peut être défini comme le travail que vous effectuez pour élaborer une longue liste de mots-clés pour lesquels vous souhaitez classer.

Stratégie de mot clé est sur les décisions que vous prenez sur la base de cette recherche par mot clé.

Expressions-clés sont des mots clés contenant plusieurs mots. Nous avons tendance à utiliser le mot mot-clé tout le temps, mais nous ne voulons pas nécessairement dire que ce n’est qu’un mot. [WordPress SEO] est un mot clé, tel quel [The best Google Analytics plugin]. Les mots-clés se composent généralement de plusieurs mots! Ainsi, dans ce guide, lorsque nous parlons de mots-clés, nous parlons généralement d'une phrase plutôt que d'un seul mot. À partir de Yoast SEO 9.0, nous utilisons le terme phrase clé dans beaucoup plus d'endroits, et ont remplacé le terme focus mot-clé avec focus phrase clé.

Mots-clés longue queue sont plus spécifiques et moins communs car ils se concentrent plus sur un créneau. Plus les termes de recherche sont longs (et spécifiques), plus il sera facile de les classer. Les mots clés plus spécifiques (et souvent plus longs) sont généralement appelés mots clés à longue queue.

Focus phrase clé est le mot ou la phrase pour laquelle vous souhaitez que votre page soit trouvée. Vous devriez mettre votre phrase clé de focus dans la boîte méta du Yoast SEO plugin.

Intention de recherche est tout à propos de découvrir ce qu'un chercheur veut réellement. Ce ne sont pas simplement des mots-clés, mais les objectifs sous-jacents de ce qu'un chercheur veut savoir, faire ou acheter.

Lire la suite: Qu'est-ce que la recherche par mot clé? »

Pourquoi la recherche par mot clé est-elle importante?

Une bonne recherche par mot clé est importante car elle indiquera clairement termes de recherche votre public utilise. Chez Yoast, nous rencontrons fréquemment des clients qui utilisent un ensemble de mots pour décrire leurs produits, alors que leur public cible utilise un ensemble de mots complètement différent. En conséquence, les clients potentiels ne trouvent pas ces sites Web, en raison d’une discordance dans l’utilisation des mots.

Parfois, un service marketing décide de donner à ses produits un nom donné. Et cela peut être une décision marketing intelligente. Cela peut être un moyen de faire en sorte que les gens se souviennent de votre produit. Par exemple, vous ne louez pas de maison de vacances, mais [vacation cottages]. Mais sachez que très peu de personnes cherchent [vacation cottages]. Donc, si vous optimisez votre texte pour ces termes, vous vous classerez probablement bien sur ces termes spécifiques. Cependant, vous ne générerez pas beaucoup de trafic avec ces termes et vous manquerez une grande partie de votre public potentiel.

Donc, vous comprendrez que cela n’a aucun sens d’optimiser les mots que les gens n’utilisent pas. Une bonne recherche de mots clés garantit que vous utilisez les mêmes mots que votre public cible, ce qui rend tout l’effort d’optimisation de votre site Web bien plus rentable. De plus, en regardant intention de recherche, vous découvrez les questions de votre client. Ces questions devraient obtenir une réponse sous la forme d'un contenu de qualité.

Continue de lire: La base de la recherche par mot clé »

Comment faire une recherche par mot clé

Pour nous, la recherche par mot clé comporte quatre étapes. Tout d'abord, vous écrivez la mission de votre entreprise. Ensuite, vous dressez une liste de tous les mots-clés pour lesquels vous souhaitez être trouvé. Ensuite, vous examinez l’intention de recherche et, enfin, créez des pages de destination pour chacun de ces mots clés. Ce guide ultime vous guide pas à pas dans ces détails.

Nous vous guiderons pas à pas tout au long du processus de recherche de mots clés et vous donnerons des conseils pratiques pour démarrer facilement votre propre recherche de mots clés.

Points à considérer: Dans quelle mesure votre marché est-il concurrentiel?

Votre marché détermine si votre mission sera suffisamment géniale pour vendre vos produits à d’autres personnes. Certains marchés sont très concurrentiels, les grandes entreprises dominant les résultats de recherche. Ces entreprises disposent de budgets énormes pour le marketing en général et le référencement en particulier. La concurrence sur ces marchés est difficile, donc le classement sur ces marchés le sera également.

Peut-être vendez-vous des croisières à Hawaii. Vous offrez des installations de qualité pour les enfants, rendant les croisières particulièrement adaptées aux parents jeunes ou célibataires. Offrir de belles croisières à Hawaii pour les jeunes parents pourrait très bien rendre votre service unique. Recherchez ce qui distingue votre produit de la concurrence. Cela devrait être votre mission, votre créneau – et c’est ce que vous avez à offrir à votre public.

Si vous vous lancez dans un marché concurrentiel, le mieux est de commencer petit. Une fois que vous possédez une petite partie de ce créneau et que vous devenez un grand nom du secteur des croisières à Hawaï, vous pouvez essayer de monter de niveau et de vendre vos croisières à un public plus large (plus général). Votre mission deviendra alors beaucoup plus générale également.

Étape 1: Quelle est votre mission?

Avant de commencer quoi que ce soit, pensez à votre mission. Pensez à des questions telles que: Qui êtes-vous? De quoi parle votre site web? Qu'est-ce qui vous rend spécial? Qui essayez-vous d'atteindre? Et quelles promesses faites-vous sur votre site web?

Continuer à lire: Quelle est la mission de votre site web »

Beaucoup de gens ne peuvent pas répondre efficacement à ces questions au début. Vous devez comprendre ce qui vous distingue de la foule. De plus, vous devez savoir quel type de public vous souhaitez cibler. Prenez donc votre temps et écrivez littéralement votre mission sur un bout de papier, un ordinateur ou un iPad – tout ira bien, tant que vous le ferez. Une fois que vous pourrez répondre à ces questions en détail, vous aurez franchi la première étape, la plus importante de votre stratégie de mots clés.

Étape 2: Faites une liste de mots-clés

La deuxième étape de la recherche par mot-clé consiste à créer une liste de vos mots-clés. Avec votre mission en tête, essayez de vous mettre dans la tête de vos acheteurs potentiels. Que vont rechercher ces personnes? Quels types de termes de recherche pourraient-ils utiliser pour rechercher votre produit ou service étonnant? Posez-vous ces questions et écrivez autant de réponses que possible.

Si votre mission est claire, vous aurez une image assez claire de votre créneau et de vos arguments de vente uniques (les éléments qui distinguent votre entreprise des autres). Ce sont les termes pour lesquels vous souhaitez être trouvé.

Assurez-vous que les mots clés correspondent à votre site

Sachez que vous devriez être trouvé pour des termes qui correspondent à votre site. Si nous devenions fous et faisions de notre mieux pour que yoast.com soit classé parmi les chaussures de ballet, les gens seraient plutôt déçus de trouver notre site. Ils seraient probablement instantanément revenir à Google. Si nous nous classions pour des chaussures de ballet, nous aurions un énorme Taux de rebond. Et un taux de rebond élevé indique à Google que les utilisateurs ne trouvent pas ce qu'ils recherchent en fonction de leur terme de recherche. Cela conduirait inévitablement à un classement inférieur sur les chaussures de ballet pour notre site – et cela serait tout à fait justifié, car nous ne savons rien du ballet, ni même des chaussures.

Des outils que vous pouvez utiliser

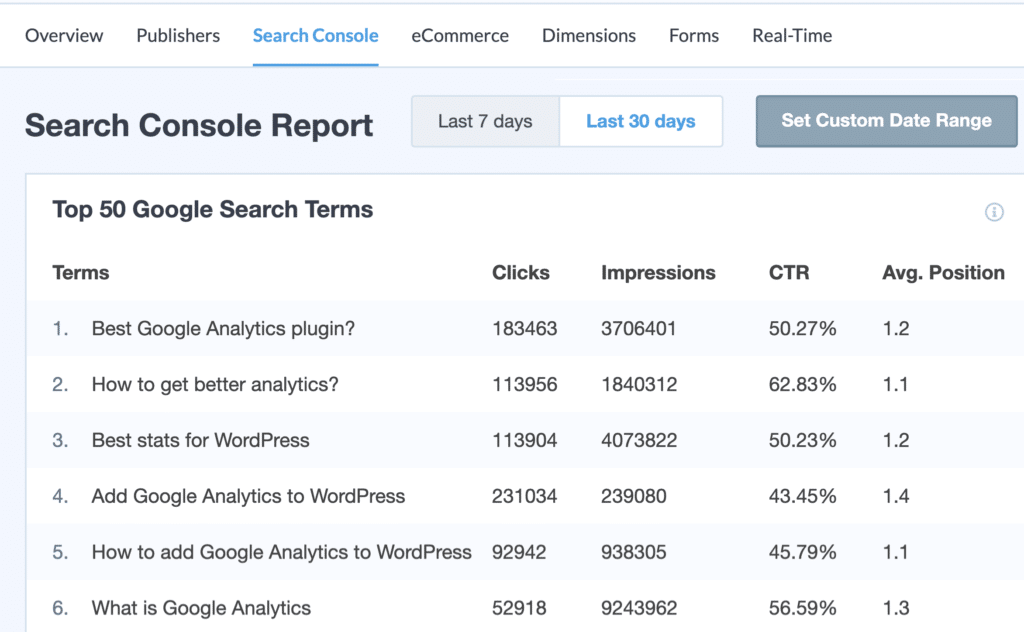

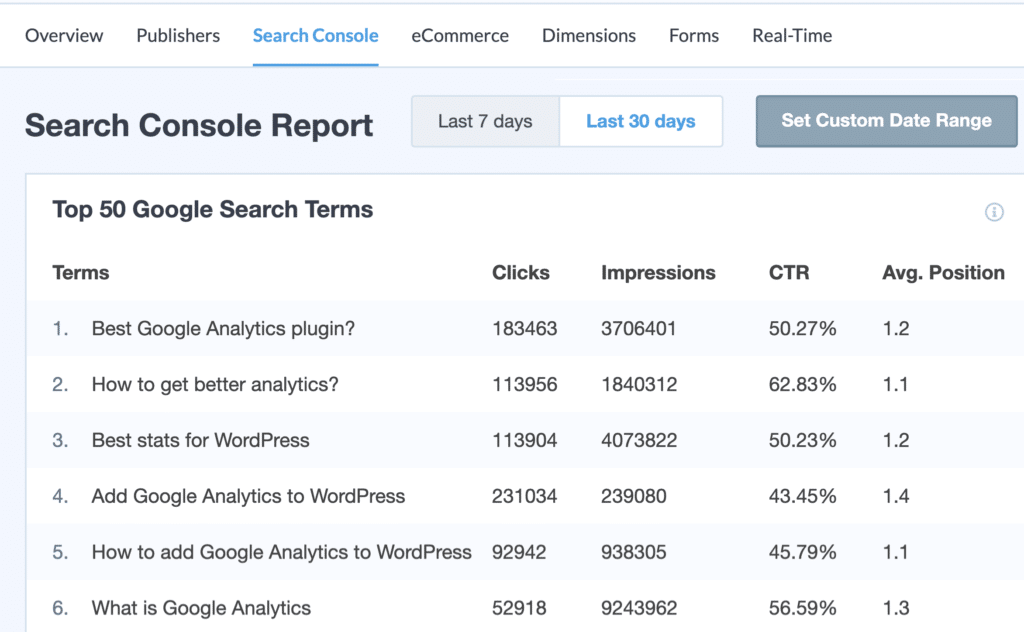

Faire une liste de termes de recherche possibles est difficile. Jusqu'à il y a quelques années, vous pouviez simplement consulter Google Analytics et connaître les termes utilisés par les internautes pour rechercher votre site Web. Malheureusement, ce n'est plus possible. Vous ne saurez donc pratiquement pas quels termes les gens utilisent dans les moteurs de recherche pour se retrouver sur votre site Web. Heureusement, il existe encore d’autres outils qui facilitent un peu la recherche de mots clés. Lisez notre article sur des outils que vous pouvez utiliser dans votre recherche de mots clés pour plus de trucs et astuces.

Étape 3: regardez l'intention de recherche

Les stratégies de référencement d’aujourd’hui devraient, pour l’essentiel, consister à répondre aux questions des gens. Chaque fois que quelqu'un entre une requête de recherche dans un moteur de recherche, il est en quête de quelque chose. Chaque type de question nécessite une réponse spécifique. Dans mon Article sur les bases du référencement sur l'intention de recherche, J'ai dit:

“L'intention de recherche a à voir avec la raison pour laquelle les gens effectuent une recherche spécifique. Pourquoi cherchent-ils? Cherchent-ils parce qu'ils ont une question et veulent une réponse à cette question? Cherchent-ils un site Web spécifique? Ou cherchent-ils parce qu'ils veulent acheter quelque chose?

Lors de la planification de votre contenu, posez-vous toujours ces questions. Il existe quatre types d'intentions:

- Intention d'information: Tout comme il est dit sur l'étain, les gens essaient de trouver des informations sur un sujet spécifique.

- Intention de navigation: Les gens veulent accéder à un site Web spécifique en entrant le terme dans un moteur de recherche.

- Intention commerciale: Les gens veulent acheter quelque chose très bientôt et font des recherches avant de faire un achat.

- Intention transactionnelle: Les gens cherchent à acheter quelque chose après avoir fait leurs recherches d'intention commerciale.

Découvrez quels types d'intention s'appliquent à vous et essayez de faire correspondre ces intentions de recherche, en donnant littéralement aux gens ce qu'ils veulent.

Étape 4: Construire des pages de destination

La prochaine étape vers une stratégie de mots clés à long terme consiste à créer super pages de destination. Dans le passé, chacun des mots clés pour lesquels vous vouliez être trouvé avait sa propre page de destination. Aujourd'hui, cependant, les moteurs de recherche sont si intelligents qu'ils utilisent principalement l'intention de recherche pour donner aux chercheurs la meilleure réponse à leurs questions. La page qui répond le mieux à ces questions se classera au premier rang. Les moteurs de recherche comprennent également les différences subtiles entre les mots clés afin que vous n'ayez pas à créer de pages de destination pour toutes les variantes subtiles d'un mot clé. Vous pouvez juste optimiser une page pour plusieurs phrases clés, synonymes et phrases clés associées.

Créer une vue d'ensemble

Nous vous conseillons de structurer votre structure de page de manière bien structurée. Pour ce faire, utilisez un tableur tel qu'Excel ou Google Docs / Sheets. Créez un tableau puis ajoutez votre liste de mots-clés. L'utilisation d'une table vous oblige à configurer une structure et à créer des pages de destination pertinentes. Placez les termes de recherche dans la première colonne et ajoutez des colonnes pour les différents niveaux de la structure de votre site.

Créer des pages de destination

Ensuite, vous devrez créer une page de destination pour vos termes de recherche, mais vous n’aurez pas à créer toutes ces pages immédiatement: cela peut être une tâche à long terme. Plus votre terme de recherche est spécifique, plus la page de destination de ce terme est intégrée dans la structure de votre site. Les mots-clés les plus importants mèneront à votre articles de contenu de pierre angulaire. Ce sont les mots-clés que vous voulez absolument classer. Pour ce faire, vous créez le meilleur contenu possible à propos de ce mot clé – faisant autorité et englobant, tout comme le guide ultime que vous lisez en ce moment. Tous vos articles connexes renverront à ce contenu fondamental. Cela devrait faire partie de votre stratégie de liaison interne, lequel Yoast SEO Premium peut vous aider à mettre en œuvre.

Une fois votre recherche de mots clés effectuée pour le référencement, vous devez avoir un aperçu clair des termes que les gens utilisent et des termes pour lesquels vous souhaitez que les pages de votre site soient trouvées. Cet aperçu devrait vous guider dans écrire du contenu pour votre site web.

Stratégie de mots clés à long terme

Aucun site Web ne devrait compter sur un seul mot clé ou une seule phrase clé pour son trafic. Vous devriez utiliser votre mission comme point de départ, puis entreprendre nos démarches pour effectuer une recherche de mots clés appropriée et travailler vers une base solide: une stratégie de mots clés. Cette section de notre guide ultime explique pourquoi il est important d’avoir une stratégie de mot clé à long terme.

Combien de mots-clés?

Nous ne pouvons pas vous dire le nombre exact de mots-clés que vous devriez avoir, mais nous pouvons vous dire que vous en avez besoin de beaucoup, autant que vous le pouvez. Cependant, plus de 1000 mots-clés, c'est probablement trop!

Même si votre entreprise est relativement petite, vous aurez probablement quelques centaines de mots-clés. Mais il n’est pas nécessaire de créer immédiatement des pages pour tout cela. L'avantage d'un système de gestion de contenu (CMS) comme WordPress est que vous pouvez ajouter du contenu au fur et à mesure. Pensez aux mots-clés que vous souhaitez classer pour le moment et à ceux qui ne sont pas aussi importants tout de suite. Comprenez vos priorités et planifiez la création de votre contenu.

Continuez à lire: Gérer un blog en pleine croissance: planification de contenu »

L'importance de la stratégie de mots clés à longue queue

Se concentrer sur les mots clés à longue queue devrait constituer un élément important d'une stratégie de recherche de mots clés à long terme. Les mots-clés à longue queue sont des mots-clés ou des expressions-clés plus spécifiques (et généralement plus longs) que des mots-clés plus courants, souvent appelés mots-clés «principaux». Les mots clés à longue queue génèrent moins de trafic de recherche, mais ont généralement une valeur de conversion plus élevée, car ils se concentrent davantage sur un produit ou un sujet spécifique. Lisez notre article sur l'importance de la longue queue mots clés si vous voulez savoir pourquoi vous devriez vous concentrer sur les mots clés à longue queue lors de l'optimisation de votre site.

Lire la suite: Faire des amis avec la longue queue »

Que fait la compétition?

Gardez toujours un œil sur la concurrence. Que vous recherchiez des mots clés à longue queue, qui sont spécifiques et composés de plusieurs mots, ou après des mots clés, dépend en grande partie de vos concurrents. Si la concurrence dans votre créneau est forte, vous aurez du mal à vous classer en tête-à-tête. Si vous avez peu de concurrence, vous pourrez même vous classer en tête du classement. Alors, comment allez-vous déterminer votre concurrence? Que devriez-vous chercher? Il y a deux étapes à suivre pour bien évaluer votre comparaison avec vos concurrents:

1. Google et analysez vos concurrents

2. Essayez, évaluez et essayez à nouveau.

1. Google et analysez vos concurrents

Google les mots-clés qui sont sortis de votre recherche de mot-clé. Commencez avec votre terme le plus "tête". Le plus général. Consultez la page de résultats du moteur de recherche (SERP). Ce sont les sites Web avec lesquels vous serez en concurrence une fois que vous aurez optimisé votre contenu pour un tel mot clé. Pour vérifier si vous pourrez ou non concurrencer les sites Web sur cette page de résultats, analysez les éléments suivants:

- Les sites Web sont-ils des sites professionnels? S'agit-il de sites Web d'entreprise? Demandez-vous si vous êtes ou non «égal» à ces entreprises. Votre site Web appartient-il à ces sites? Votre entreprise est-elle de la même taille et at-elle autant d’influence dans votre créneau?

- Le SERP présente-t-il des marques bien connues? Il est plus difficile de se classer lorsque vous êtes en concurrence avec des sites à forte marque. Si les marques sont connues grâce à des publicités à la télévision ou à la radio, vos chances de classement seront encore plus réduites.

- Qu'en est-il du contenu de ces sites? Le contenu est-il bien écrit et optimisé? Combien de temps les articles sont sur les sites? Si le contenu de vos concurrents est médiocre, vous aurez une plus grande chance de les devancer!

- Existe-t-il des annonces dans Google? Et combien coûte le paiement par clic dans Google Adwords? Les termes de recherche générant un paiement au clic élevé sont généralement plus difficiles à classer dans les résultats organiques.

Comment vous comparez-vous à la concurrence?

Tout se résume à une seule question: comment mon site Web tient-il par rapport aux sites des SERP? Êtes-vous de la même taille et du même budget marketing? Allez-y, concentrez-vous sur ces termes clés. Sinon, essayez un mot clé plus long.

La prochaine étape consiste à effectuer la même analyse avec un mot clé légèrement plus long. Les termes de recherche plus longs et plus spécifiques généreront moins de trafic, mais classement sur ces termes sera beaucoup plus facile. Se concentrer sur un ensemble de mots-clés longue queue combinés pourrait très bien attirer beaucoup de trafic. Une fois que vous avez réussi à classer ces mots clés à longue traîne, il sera plus facile de viser plus de termes principaux.

2. Essayer, évaluer et réessayer

Une fois que vous avez analysé en profondeur vos chances de classement sur un terme spécifique, vous devez ensuite rédiger un article étonnant et l’optimiser en conséquence. Et cliquez sur publier. Assurez-vous d’attirer de bons backlinks. Et attendez un peu. Consultez votre classement. Votre article apparaît-il? At-il atteint la première page des SERPs de Google? Ou est-ce caché à la page 2 ou 3? Assurez-vous d'évaluer vos articles dans les SERPs. Google les termes pour lesquels vous avez optimisé vos articles. Vérifiez si votre référencement paye!

Si vous ne parvenez pas à vous classer sur la première page, essayez d’écrire un autre article, axé sur un mot clé (encore) plus long. Faites-en un peu plus spécifique, plus de niche. Et voyez comment ça se passe. Évaluer à nouveau. Continuez ce processus jusqu'à ce que vous atteigniez la première page des SERP!

Stratégies de recherche de mots clés ad hoc

Dans un monde idéal, vous feriez votre recherche de mots-clés, feriez un beau tableau et créeriez des pages de destination pour chacun. La structure de votre site serait parfaite et vous rédigeriez des blogs et écriviez chaque jour pour que votre site soit de plus en plus prioritaire dans Google. Malheureusement, nous vivons dans le monde réel.

Bien entendu, vos recherches de mots clés ne seront pas toujours aussi complètes. Et certains articles ou articles ne sont pas écrits dans le cadre d’une stratégie géniale, mais simplement parce que le sujet était dans les nouvelles ou quelque chose t'a inspiré pour l'écrire. C’est comme ça que ça marche. Mais cela ne doit pas être un problème.

Si vous écrivez quelque chose qui ne correspond pas exactement à votre stratégie, cela ne signifie pas que vous ne devez pas essayer de faire en sorte que ce contenu soit classé. Vous pouvez toujours l'utiliser pour classer des éléments liés aux termes de la liste de votre stratégie de mots clés. Utilisez des outils comme tendances Google choisir le mot clé que vous souhaitez classer. Prenez au moins un peu de temps pour réfléchir à la manière de rendre votre article ou votre blog adapté à votre stratégie. Après tout, si vous écrivez un contenu précieux, vous pourriez aussi bien le classer!

Synonymes et mots-clés associés

Notre Yoast SEO Premium plugin vous permet d'optimiser votre contenu pour les synonymes et les phrases clés associées. Les synonymes sont des mots de remplacement direct pour votre phrase clé de mise au point, tandis que les phrases clés associées sont des mots et des concepts qui ne constituent pas un remplacement direct, mais des termes et des expressions qui approfondissent et élargissent la compréhension de votre phrase clé de mise au point. En utilisant des synonymes et des phrases clés associées dans votre texte, vous pouvez brosser un tableau complet de votre phrase clé de mise au point dans votre article. Rappelles toi, n'utilisez pas votre mot clé focus plus d'une fois. Vous ne savez pas si vous avez déjà utilisé une phrase clé de mise au point? La poste pourquoi et comment exporter vos phrases clés de focus avec Yoast SEO Premium explique comment obtenir un aperçu des phrases clés de focus que vous avez utilisées auparavant et sur quelle page.

Mot clé de focus singulier ou pluriel?

Devriez-vous viser le mot clé singulier ou pluriel? Cela dépend de la requête. Au fur et à mesure que Google en apprend plus sur les intentions de recherche de votre requête, il est en mesure de mieux deviner ce que vous recherchez. Par exemple, si vous recherchez livre, vous obtenez un résultat différent de celui obtenu si vous recherchez livres. Apparemment, Google pense que dans le premier cas, vous recherchez une définition ou certaines histoires, dans le second, vous pensez que vous recherchez des livres à acheter. Assurez-vous donc de savoir ce que vous proposez sur votre page et que cela correspond à la requête et aux résultats que Google donne pour cette requête.

Yoast SEO Premium prend en charge les formulaires, de sorte qu'il détecte automatiquement toutes les différentes formes de votre phrase clé de mise au point (appelée mot-clé stemming). Maintenant, vous n’avez plus à optimiser votre message pour un événement spécifique. forme lexicale. Optimiser votre publication est devenu un processus beaucoup plus naturel. Cependant, il existe des raisons pour lesquelles vous souhaitez toujours optimiser un mot spécifique sous une forme spécifique. Dans ce cas, vous pouvez mettre votre phrase clé de focus entre guillemets: «meilleurs livres de tous les temps». Yoast SEO prendra désormais uniquement en compte cette phrase clé exacte lors de la vérification de votre contenu.

Continue de lire: Comment choisir le mot clé de focus parfait »

Conclusion sur la recherche de mots clés pour le référencement

La recherche par mot clé devrait être le début de toute stratégie de référencement durable. Le résultat sera une longue liste de mots-clés pour lesquels vous aimeriez être trouvés. Mais le plus difficile reste à venir: écrire tout ce contenu. Vous devriez écrire des articles et des articles de blog sur chaque mot clé pour lequel vous souhaitez être trouvé. C’est tout un défi!

Continuer à lire: WordPress SEO: Le guide ultime pour un meilleur classement des sites WordPress »

Source link

13 tactiques éprouvées pour augmenter le trafic de votre blog

Vous avez du mal à gagner du terrain sur votre blog? Consommé des tonnes de «guides ultimes» et des cours, mais le trafic n'a pas bougé?

Il y a quelques années, le Ahrefs blog était loin d'être populaire. Malgré la publication de trois nouveaux articles par semaine et le respect des «meilleures pratiques en matière de blogage», le trafic était en plateau.

C’est à ce moment-là que nous avons décidé de changer de stratégie.

Ces dernières années, nous avons publié 1 à 2 publications par semaine et le trafic de nos blogs a explosé.

Comment avons-nous fait ça?

Voici 13 tactiques éprouvées que nous avons utilisées pour augmenter le trafic sur notre blog:

- Écrivez sur des sujets que les gens recherchent

- Assurez-vous que votre recherche correspond à votre intention

- Créer du contenu en profondeur

- Construire une liste de diffusion

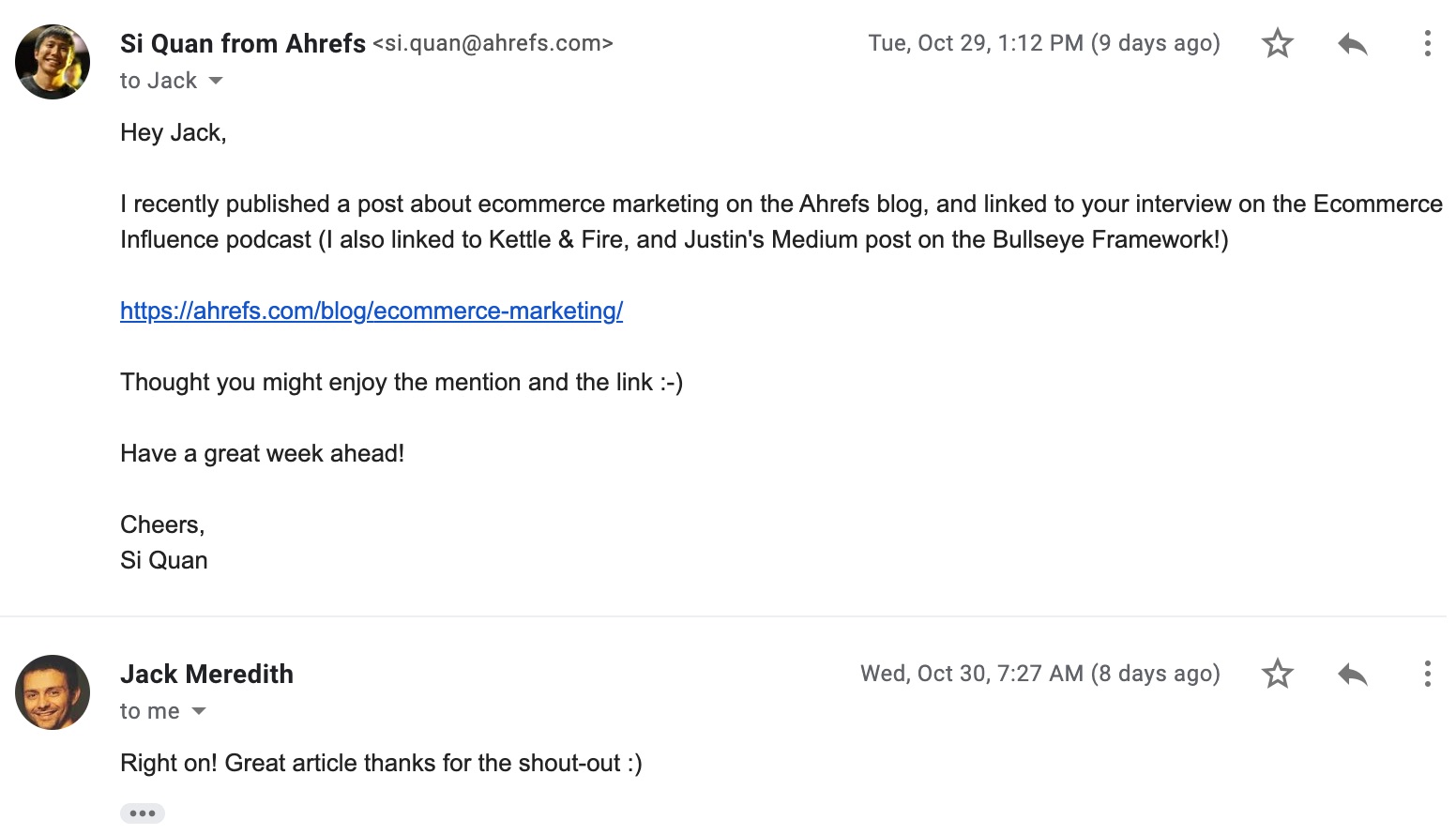

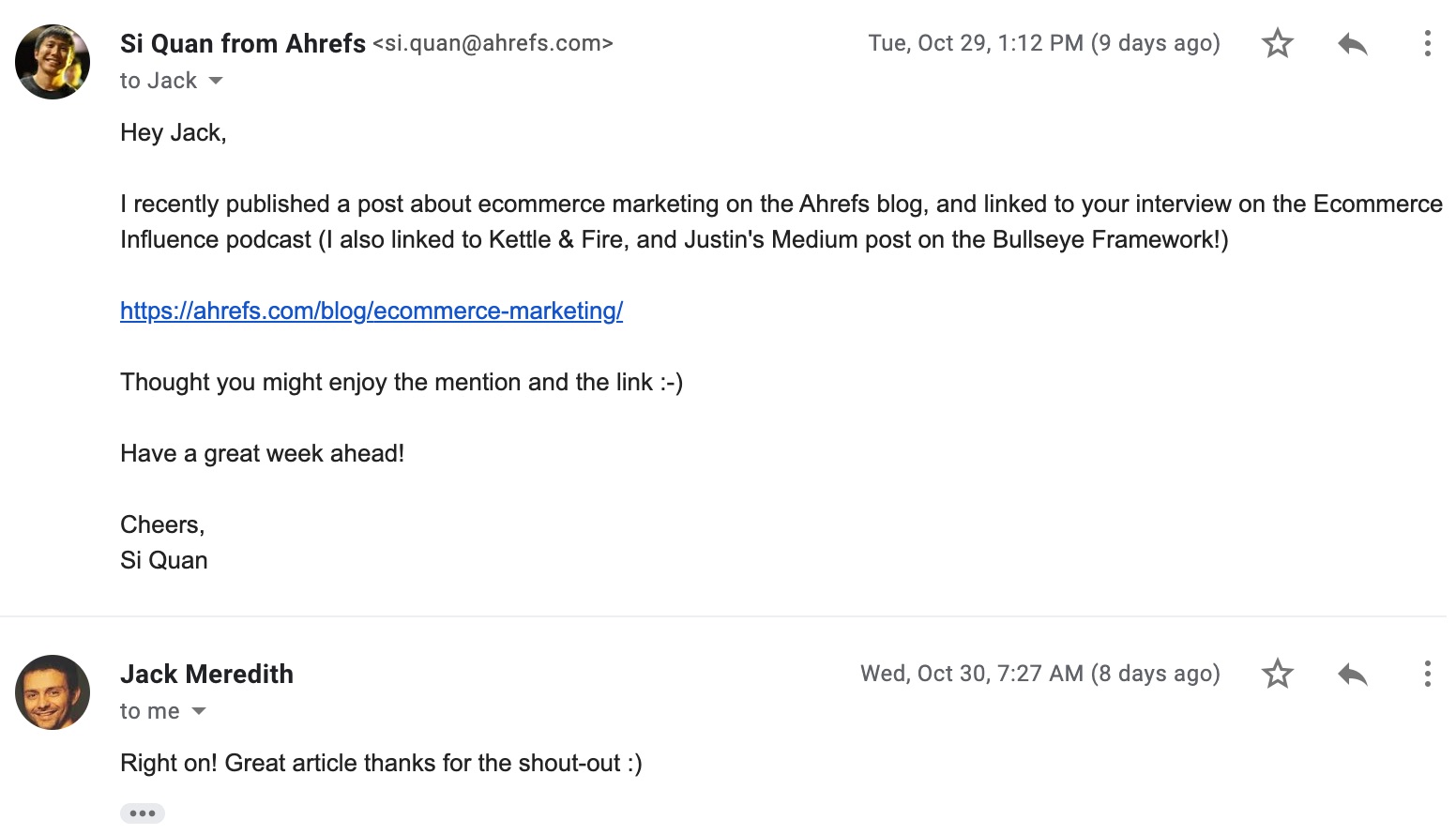

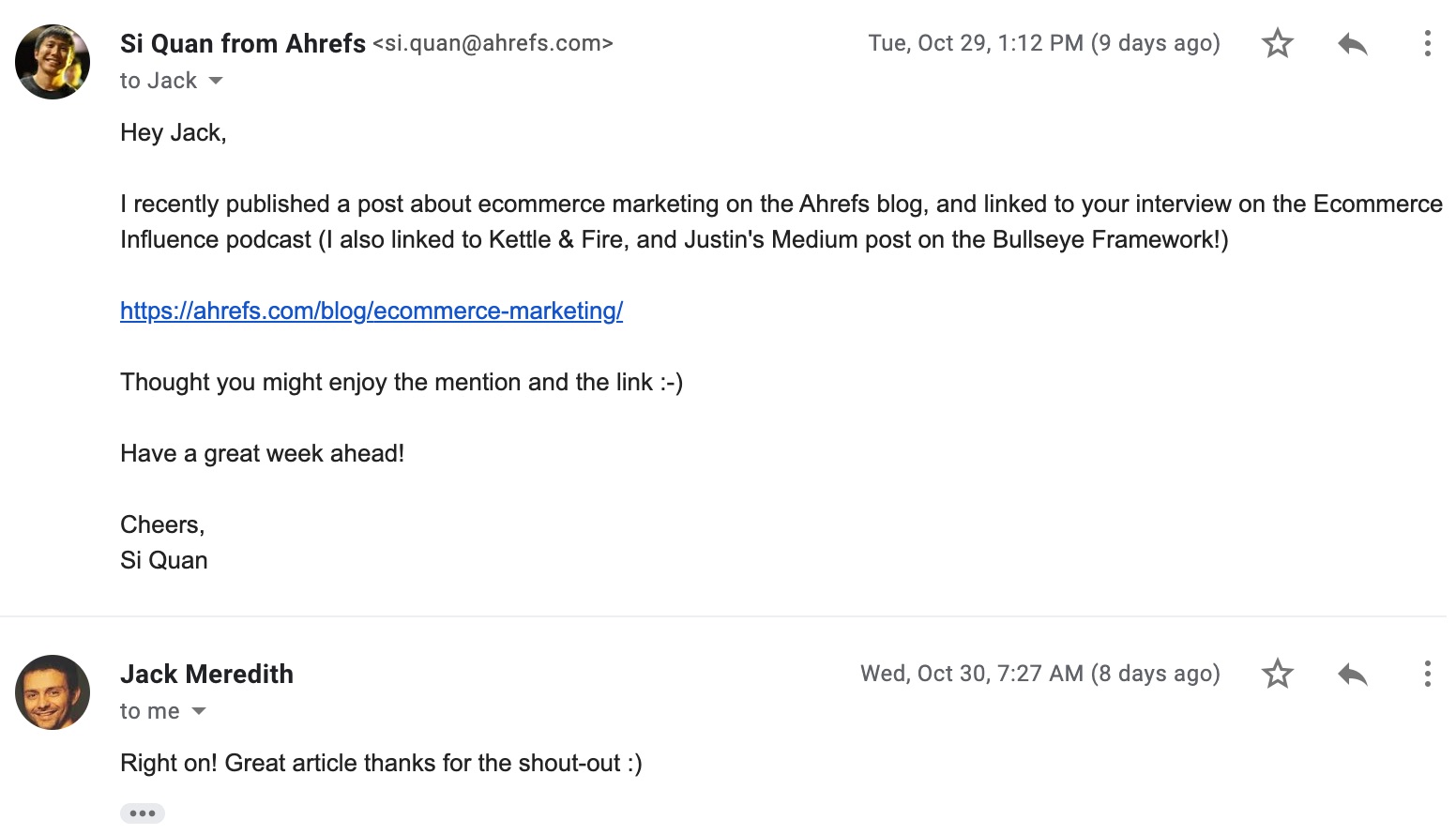

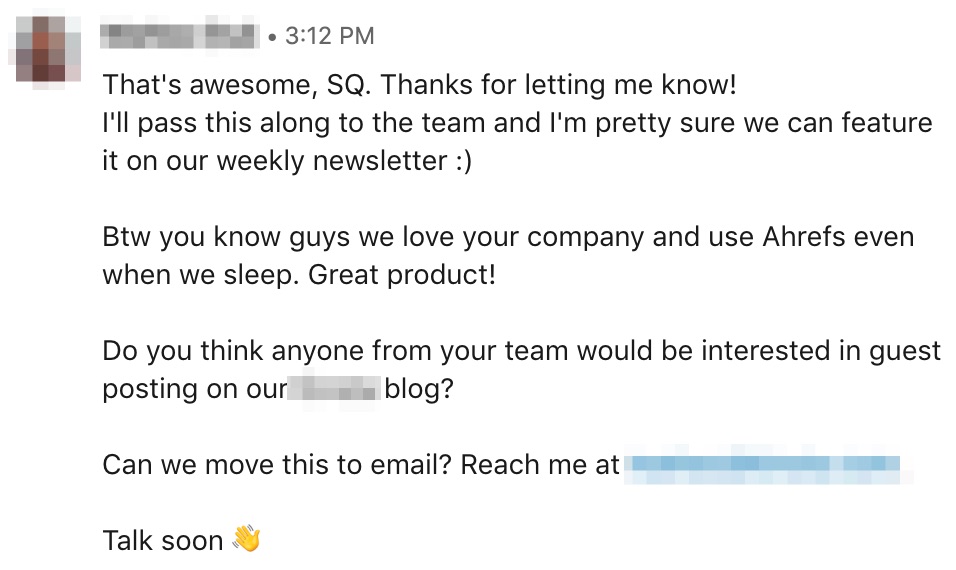

- Contactez les personnes que vous mentionnez dans votre message

- Boostez des pages importantes avec des liens internes

- Construire des liens

- Répondre aux questions sur Quora

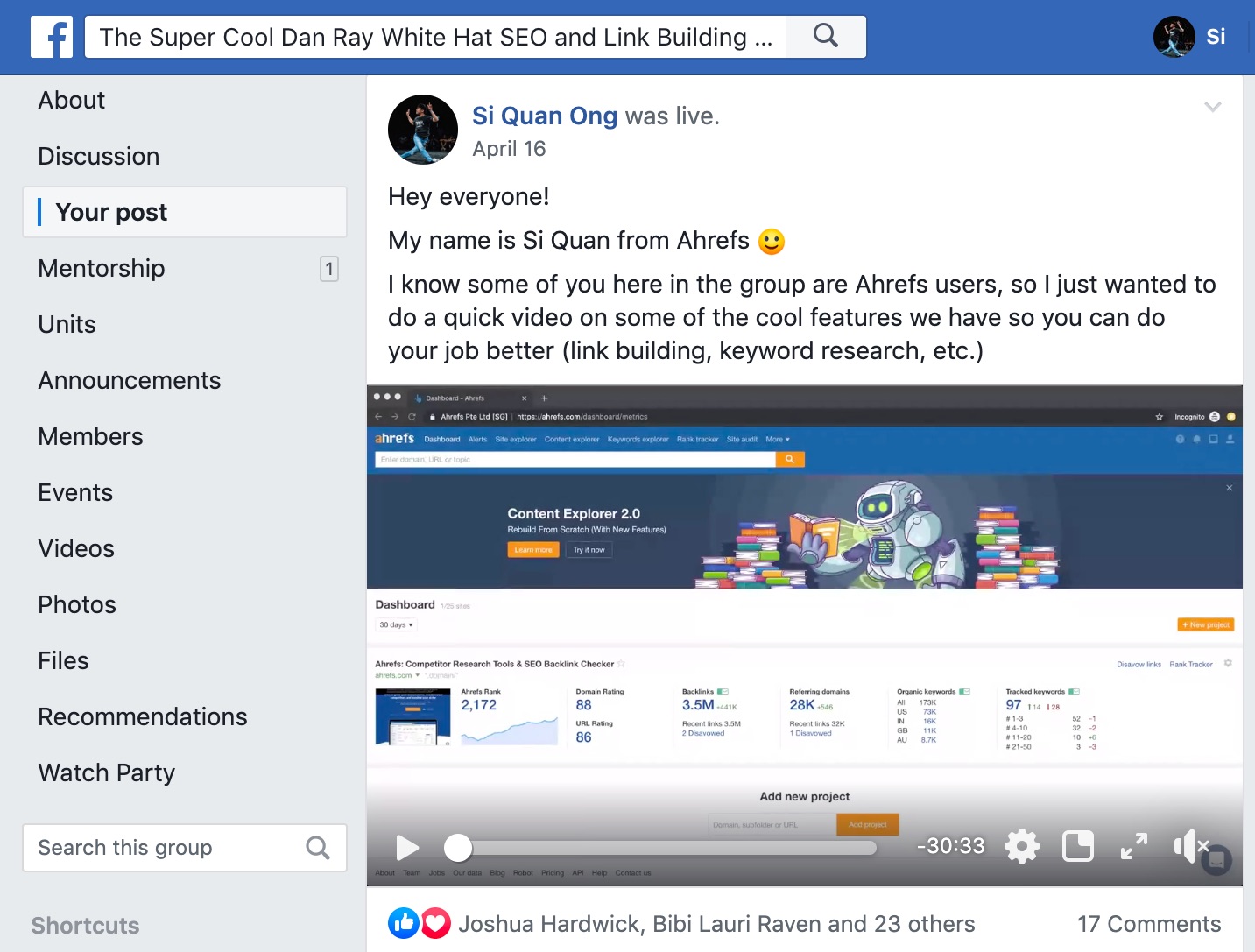

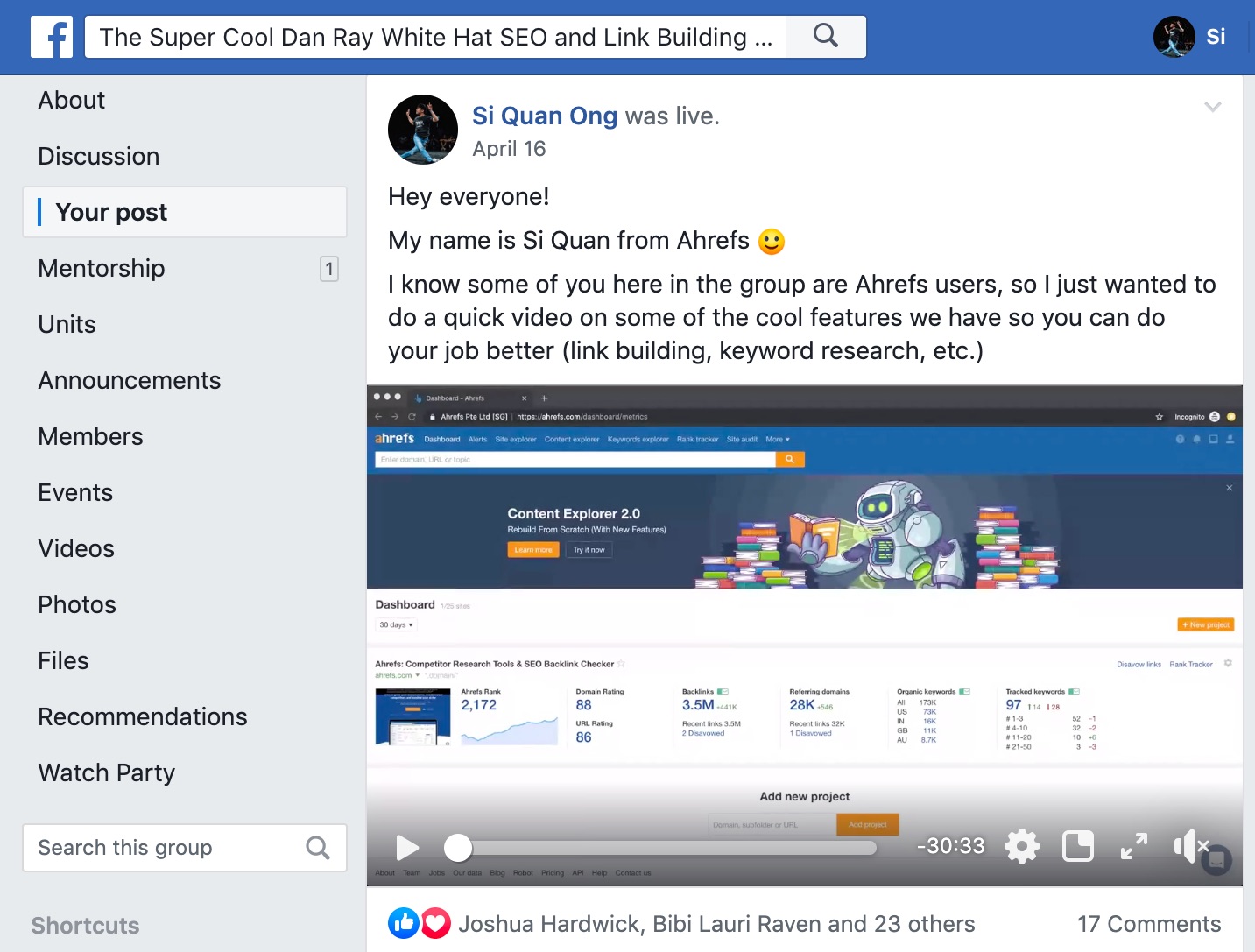

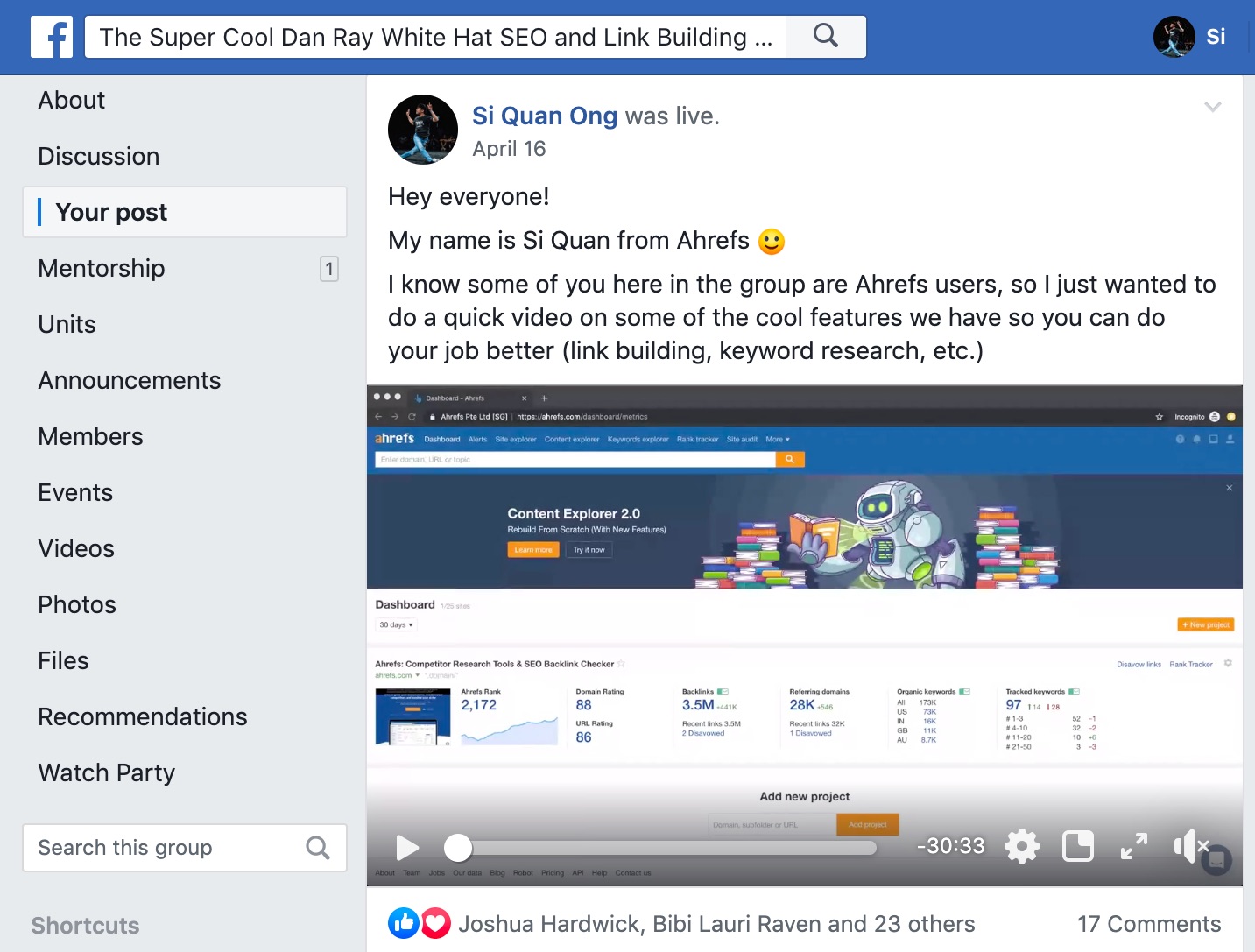

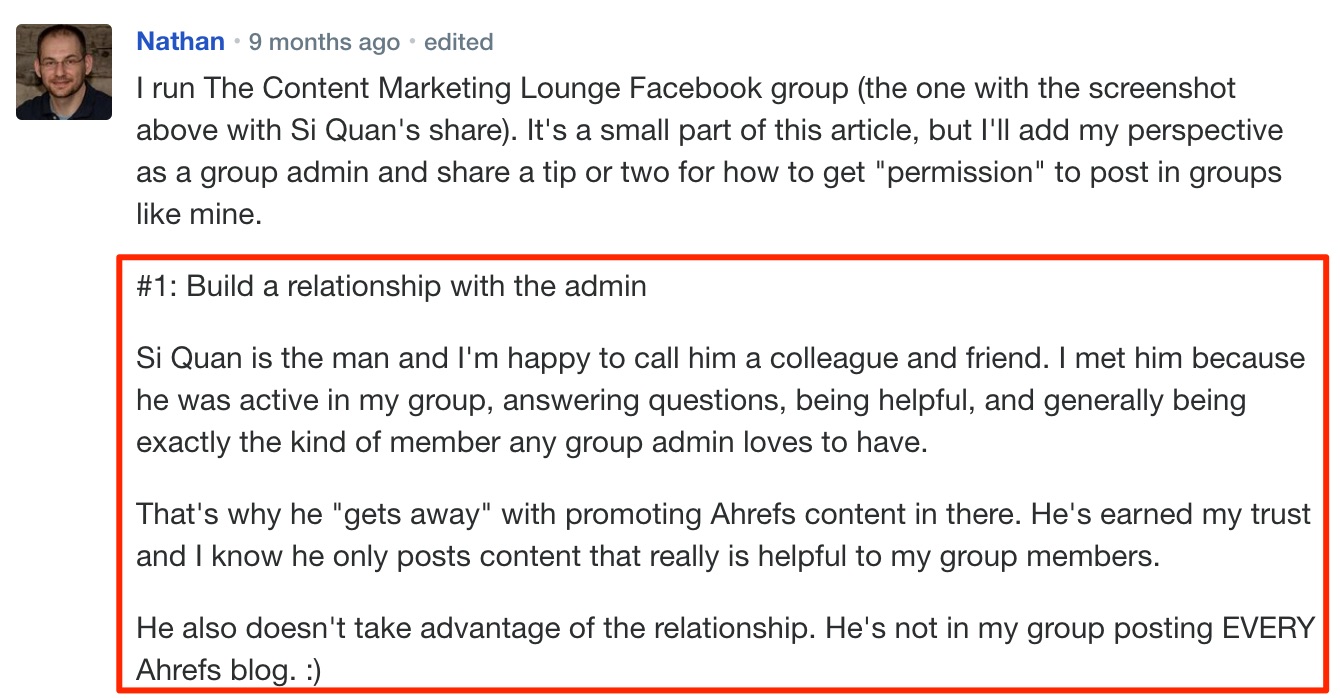

- Promouvoir le contenu dans les communautés pertinentes

- Publier des messages d'invités sur votre site

- Créer des images partageables

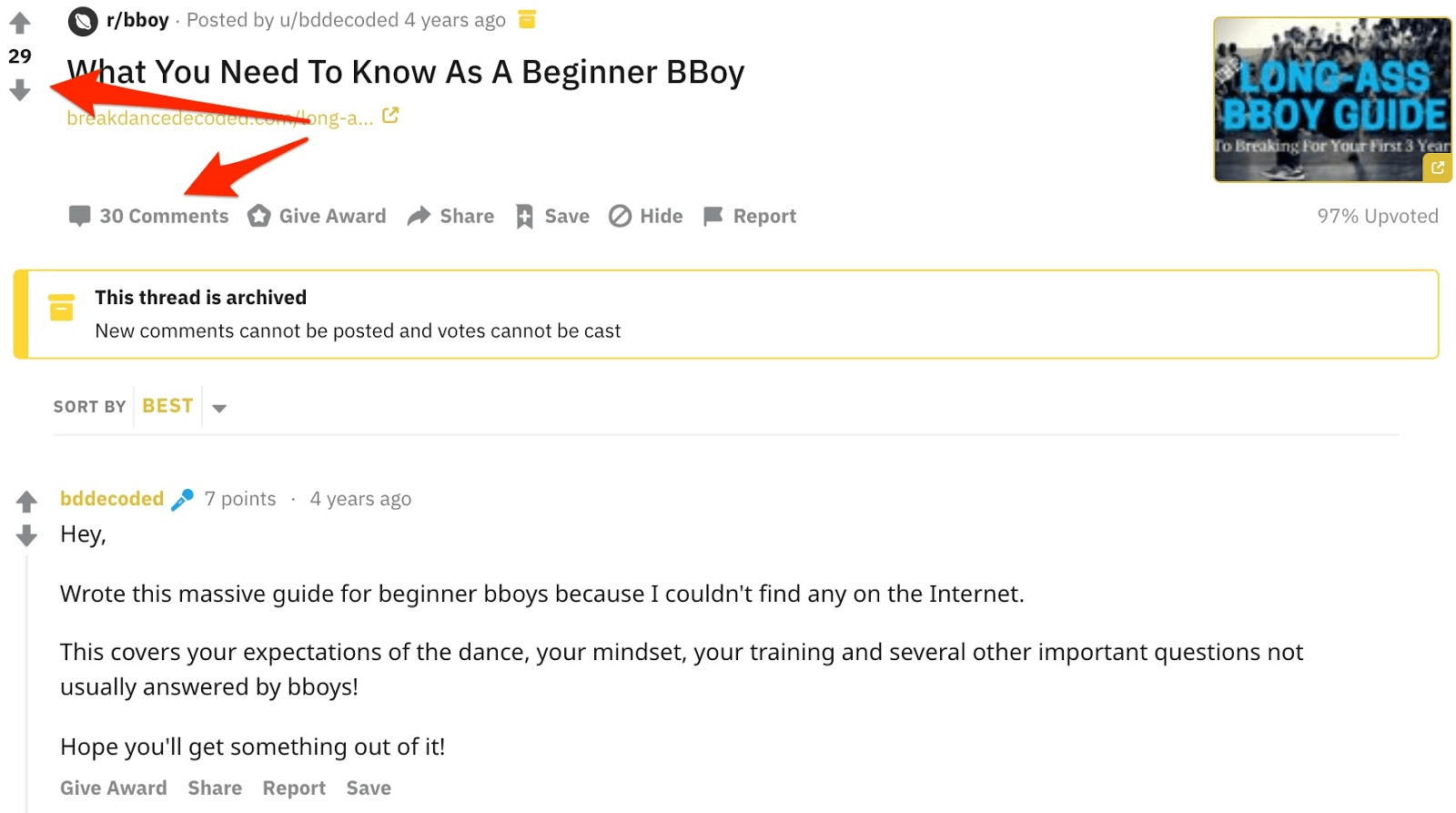

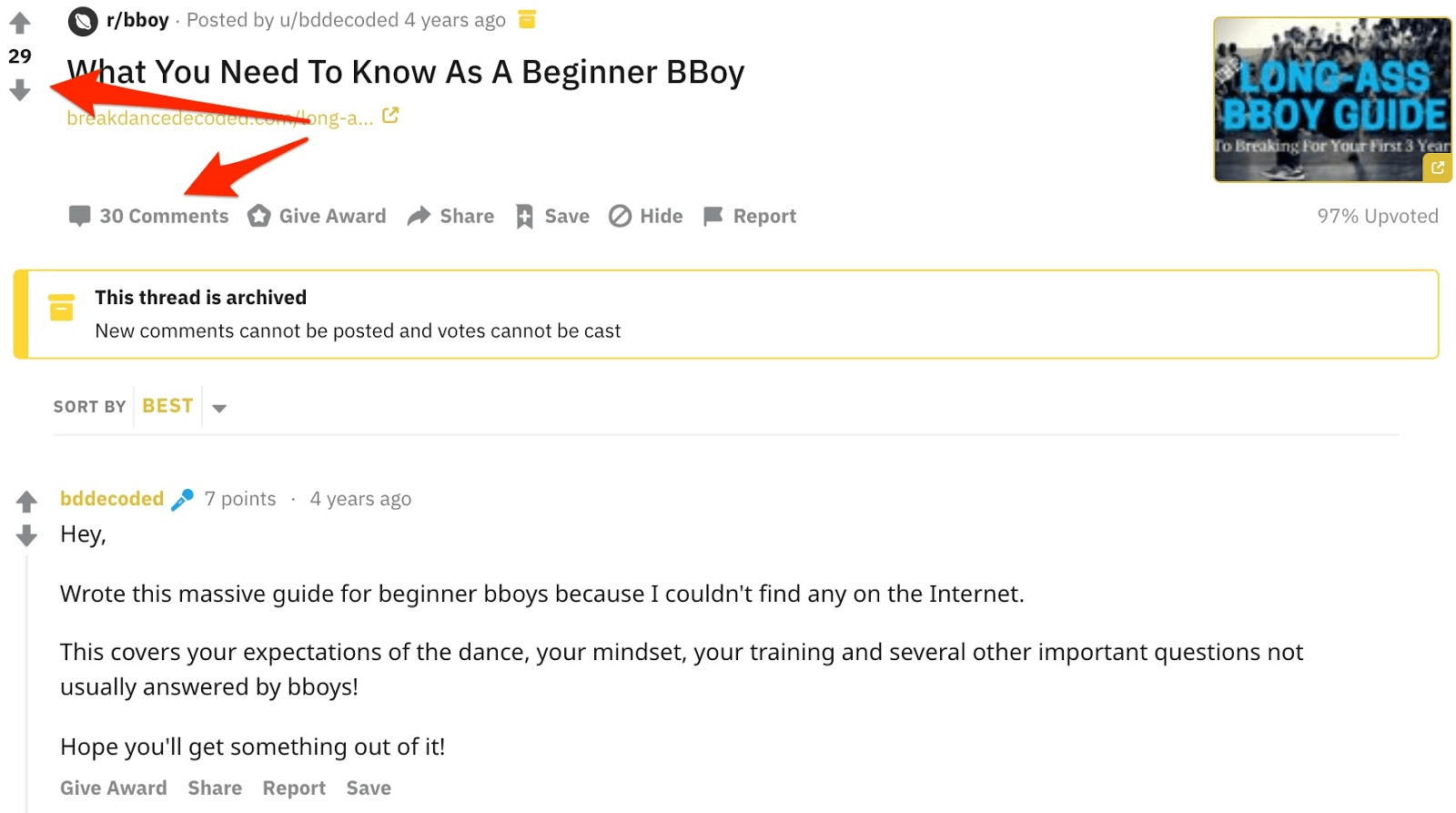

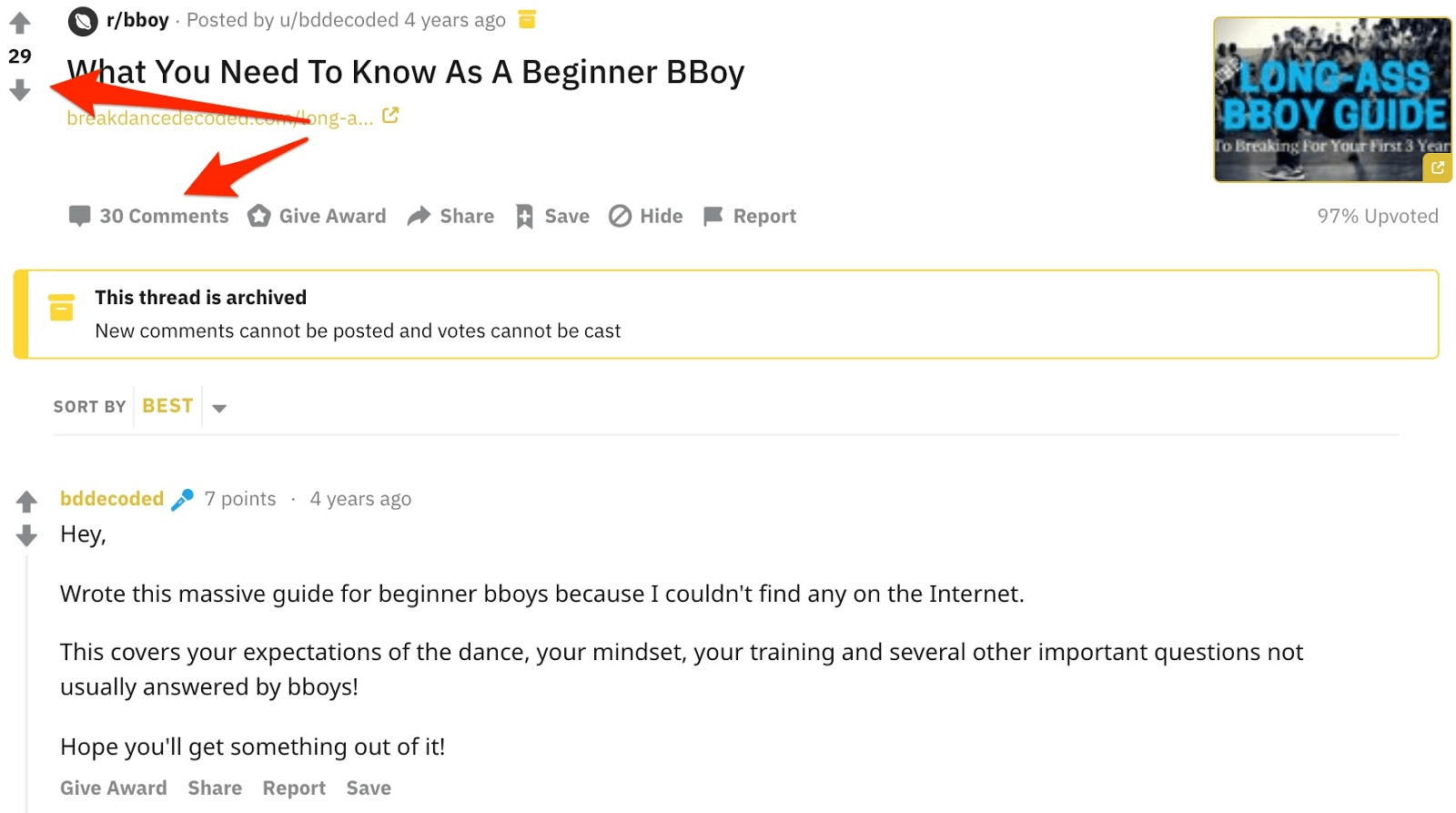

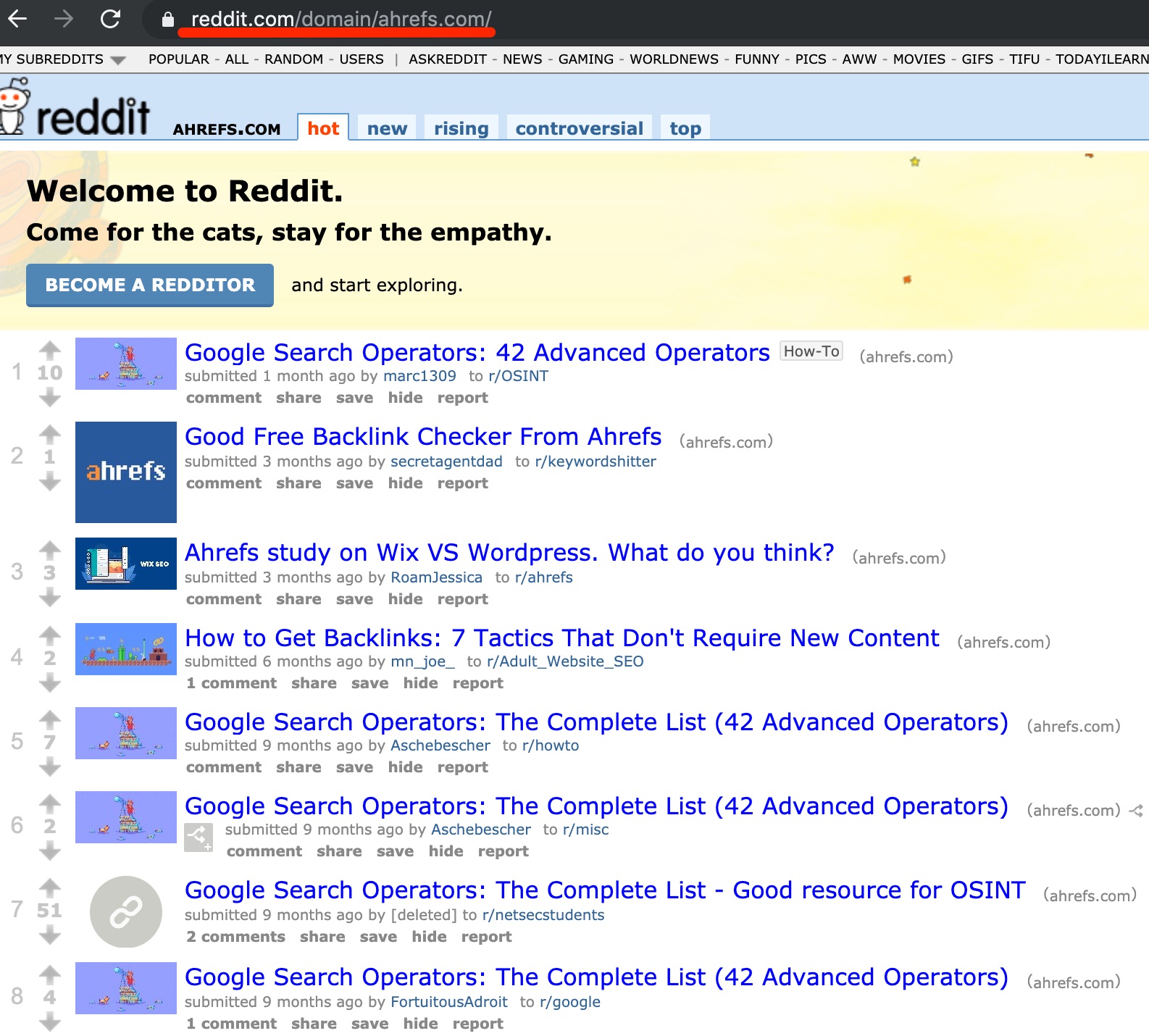

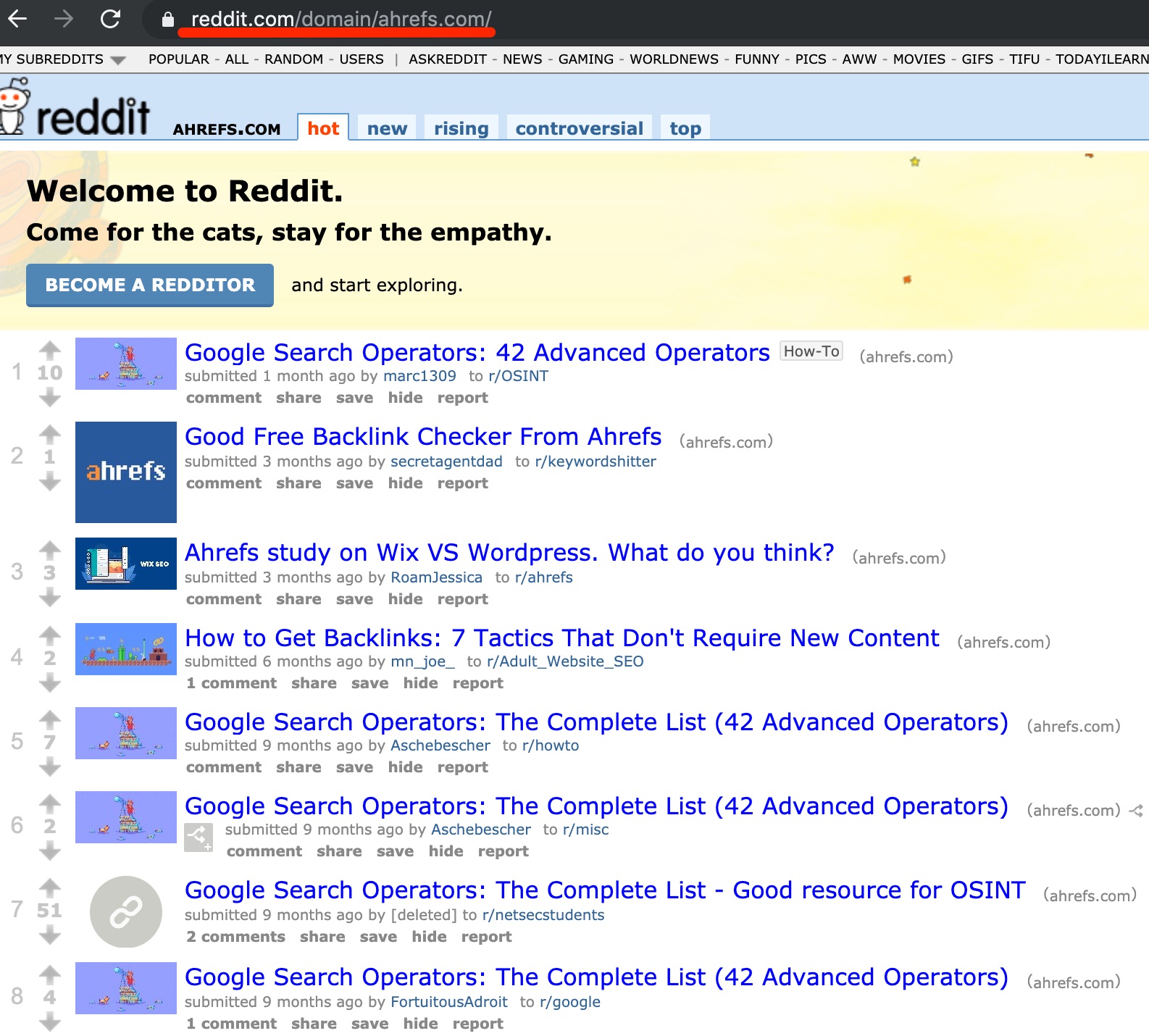

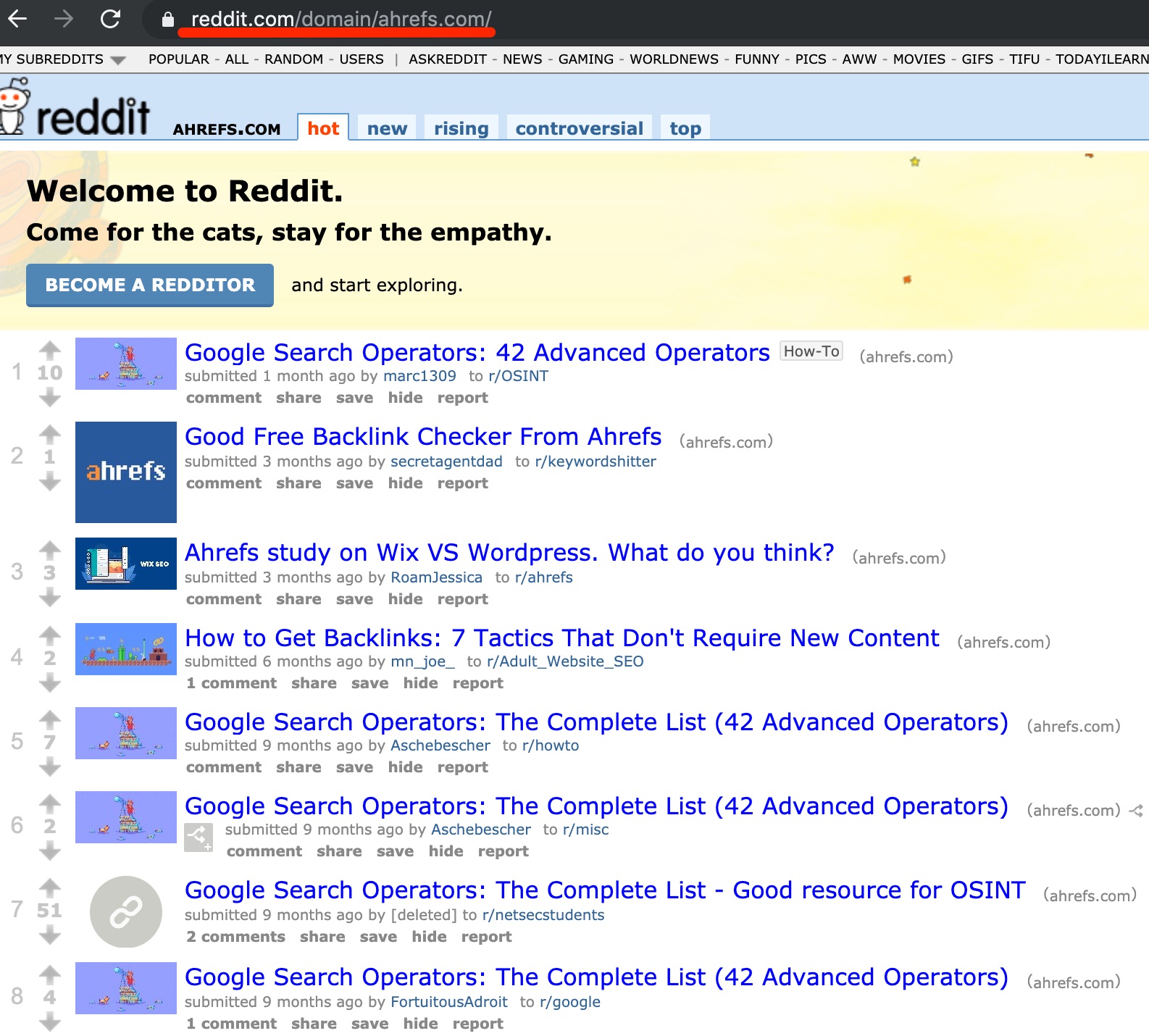

- Partagez votre contenu sur Reddit

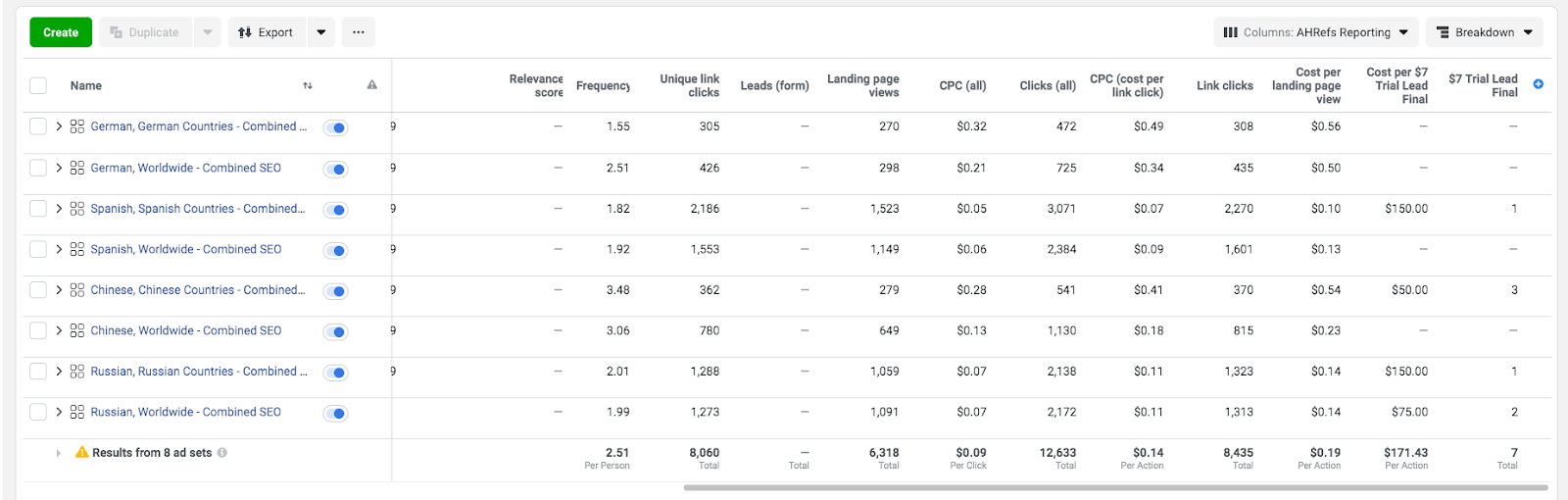

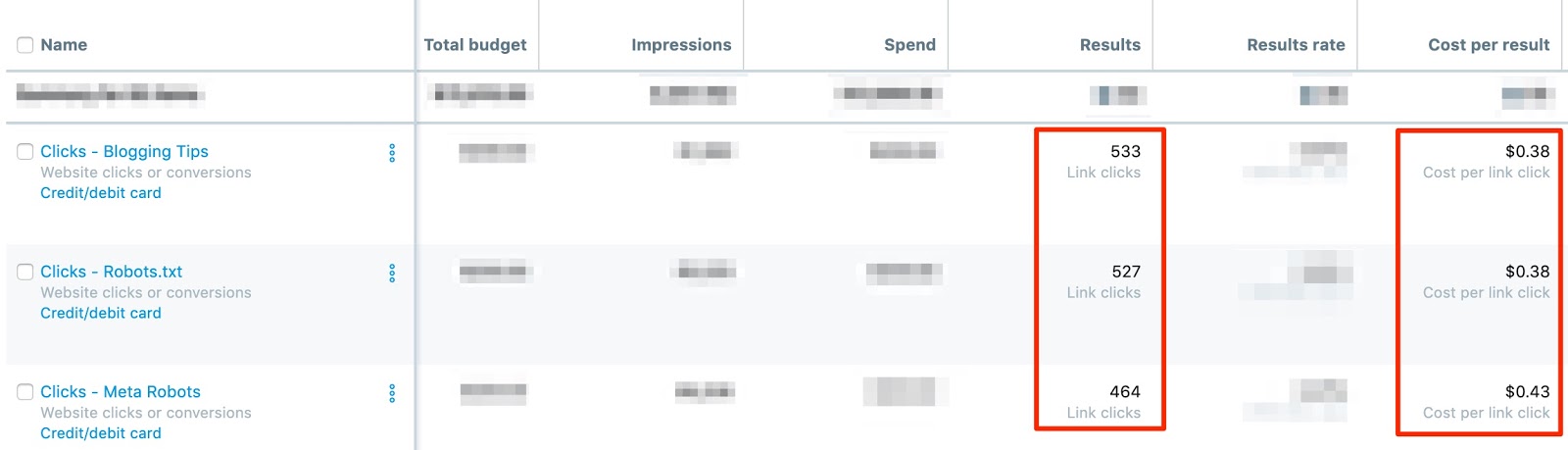

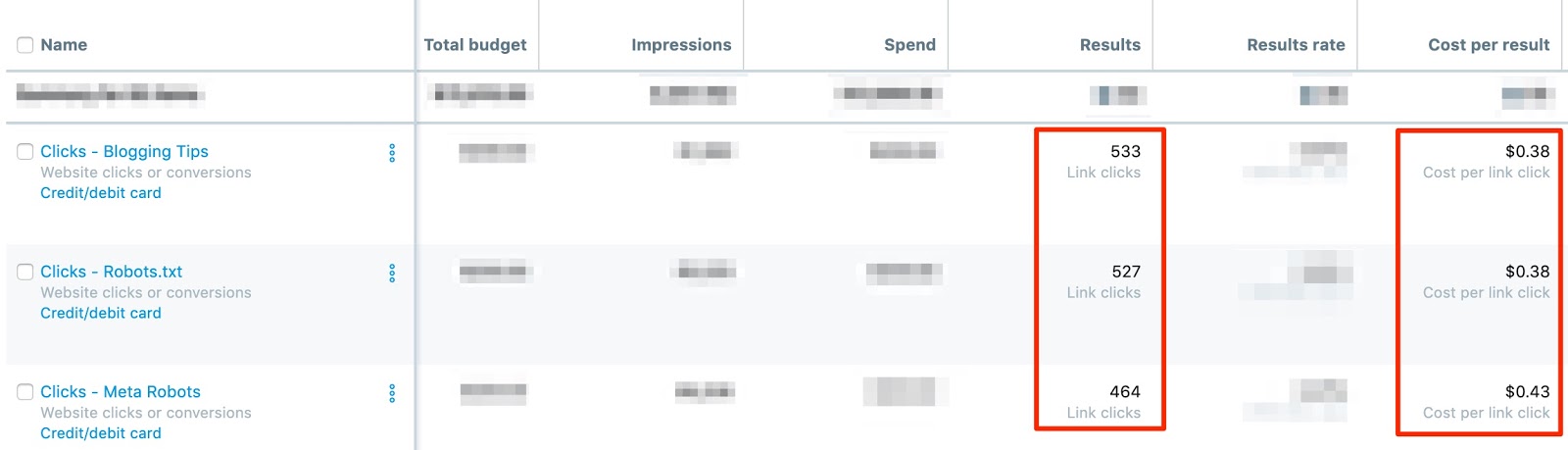

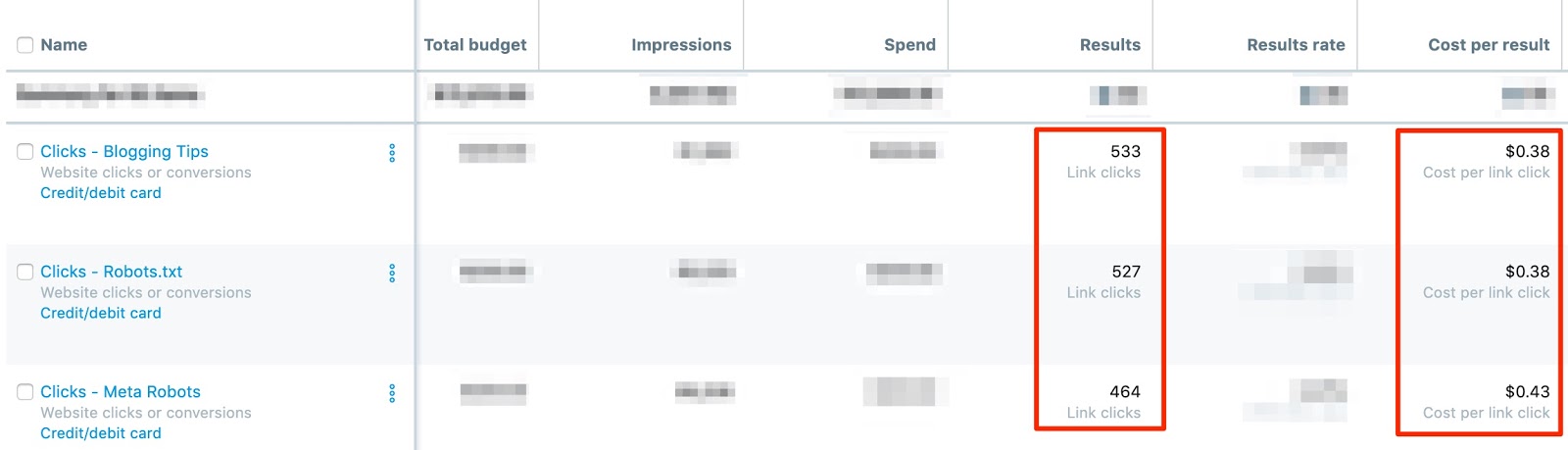

- Diffuser des annonces

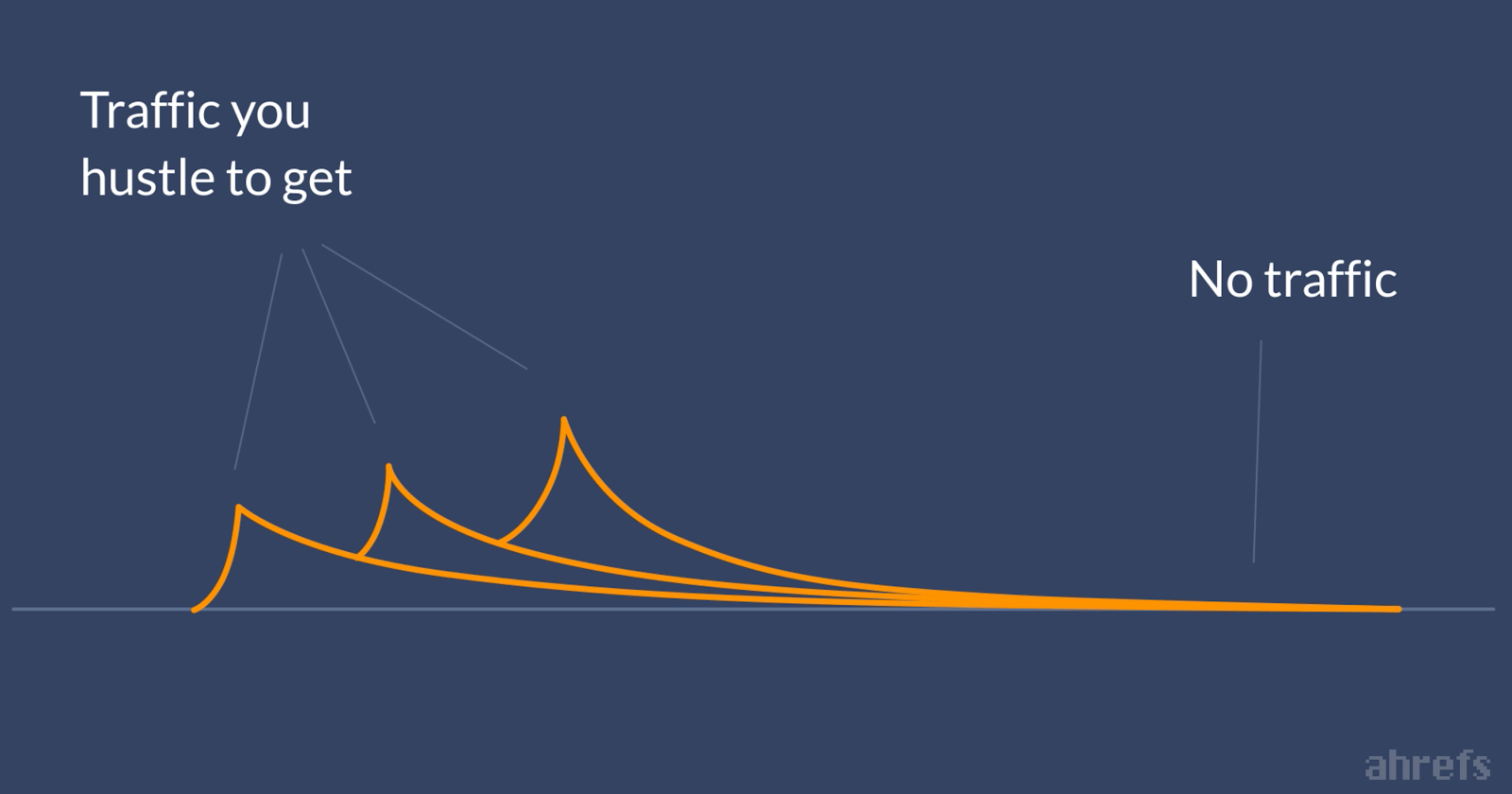

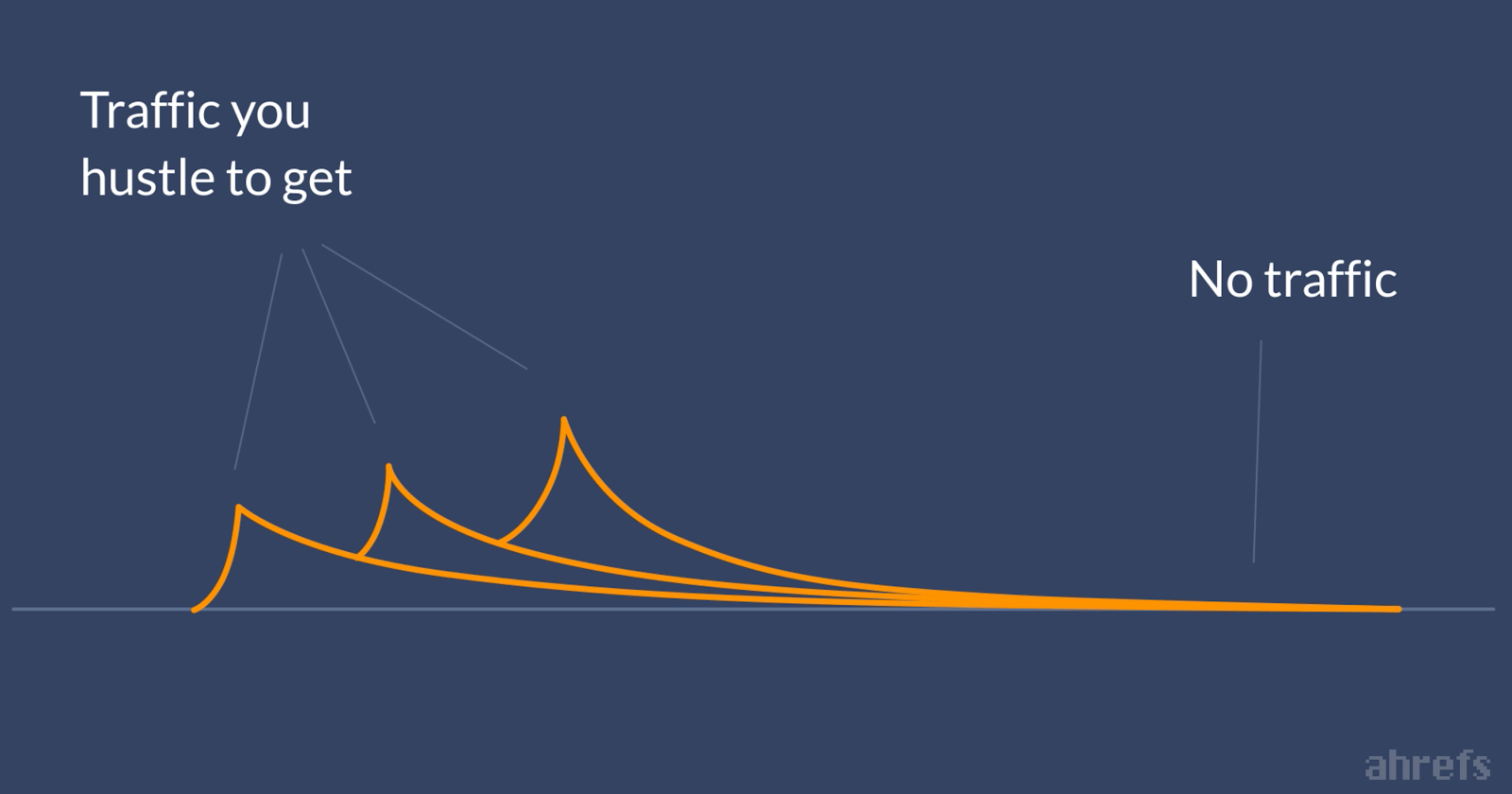

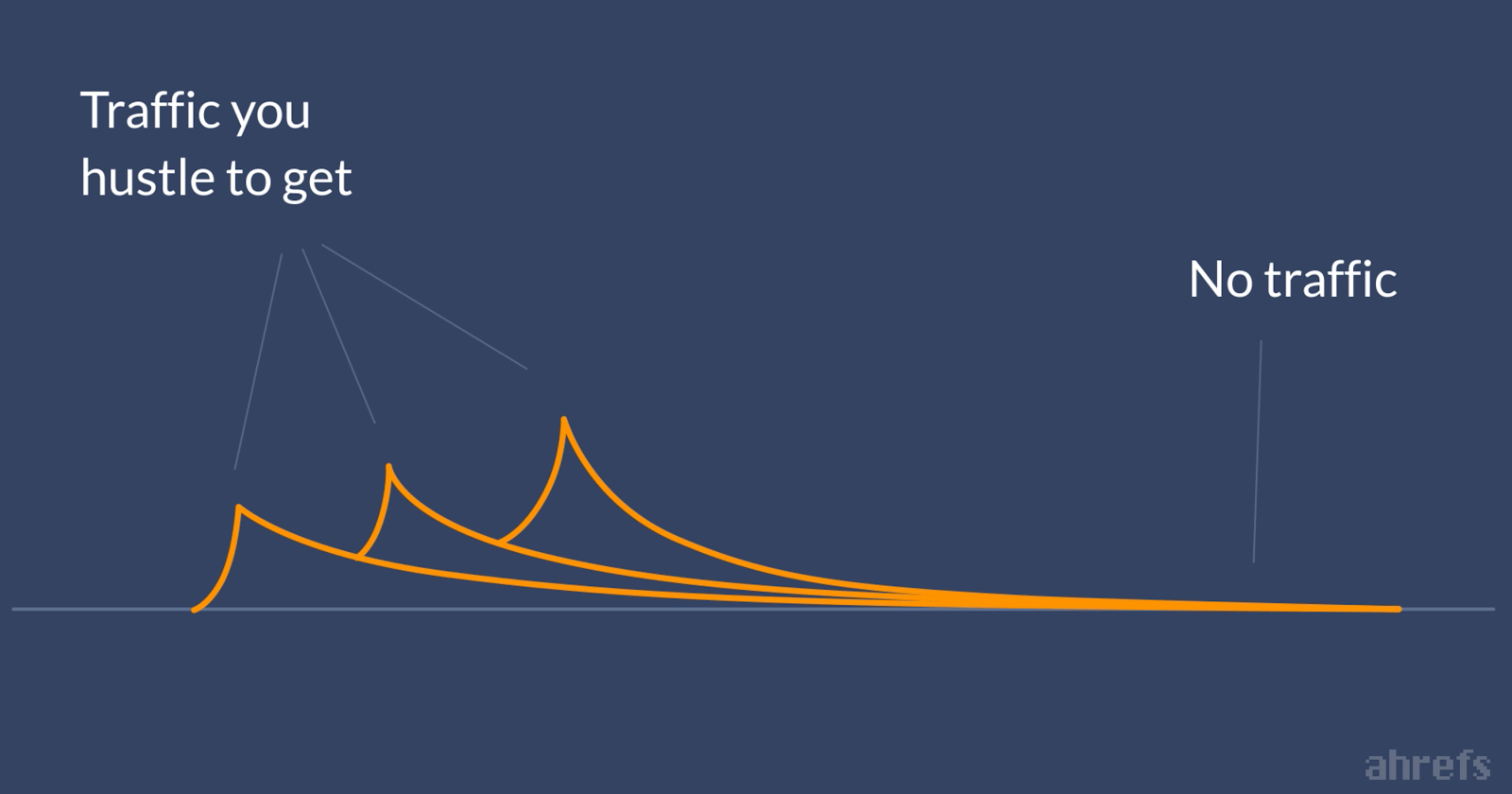

Il peut être tentant d’écrire sur ce qui vous passionne. Il peut s’agir des derniers sujets de l’industrie, des dernières nouvelles ou même d’un coup de gueule aléatoire.

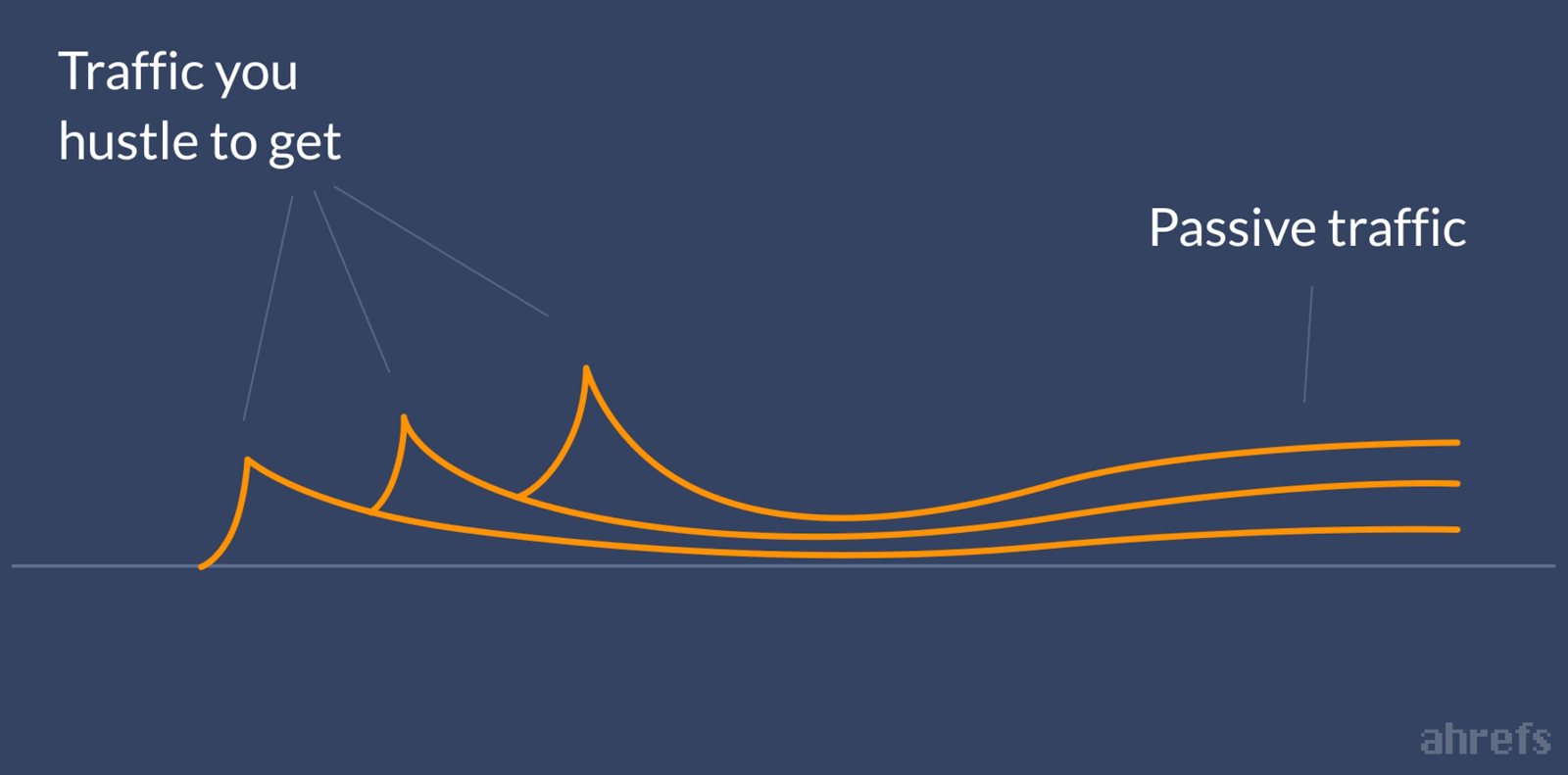

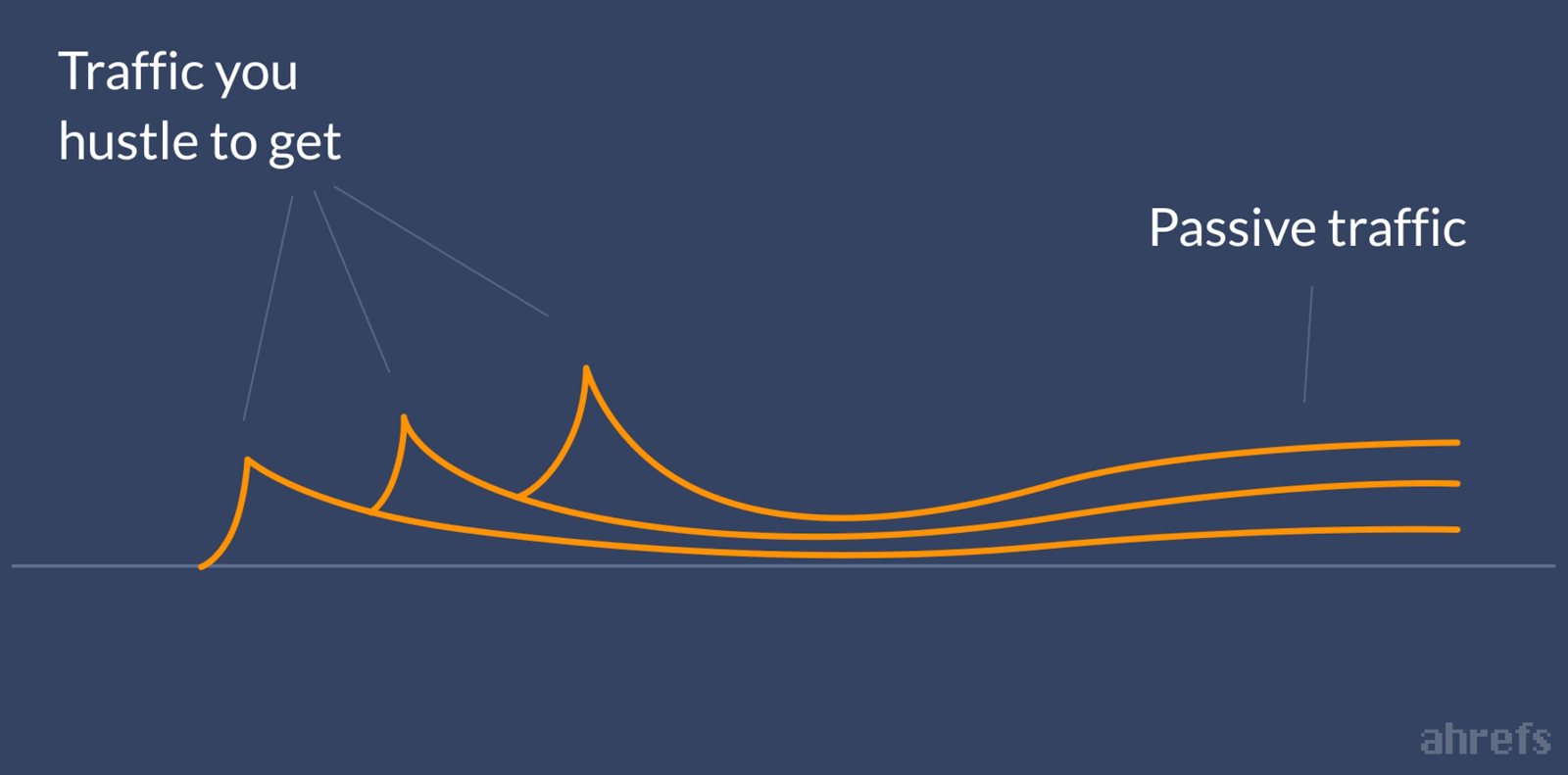

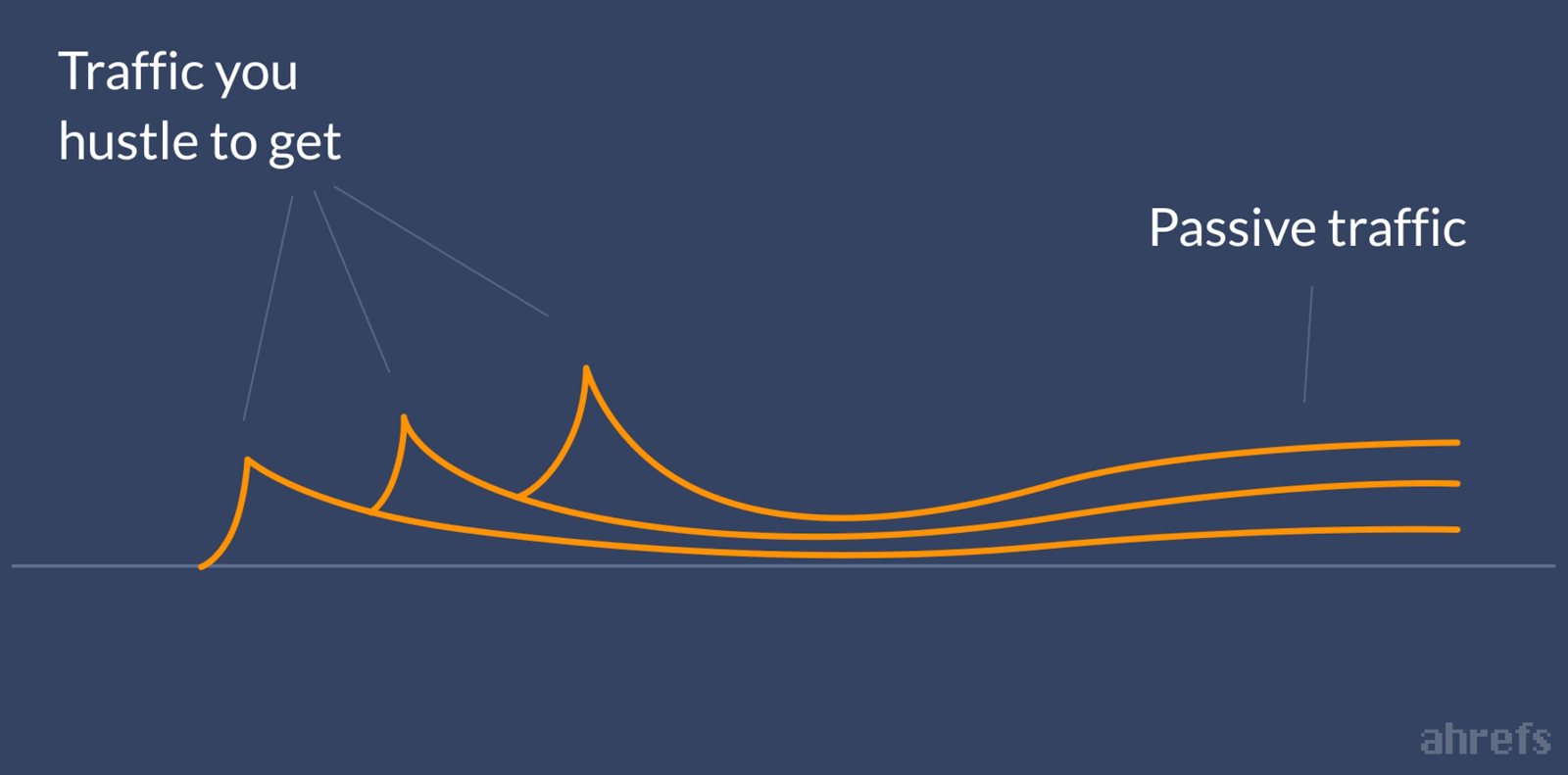

Mais ces types de messages ont une courte durée de vie.

Vous constaterez peut-être un pic de trafic («pic d’espoir») peu de temps après la publication, mais une fois que l’intérêt pour les actualités, les tendances ou les évanouissements disparaîtra, le trafic de votre blog disparaîtra à néant («ligne plate de nope»).

La solution? Écrivez sur des sujets que les gens recherchent.

Tant que votre article classement dans Google pour les requêtes de recherche pertinentes, vous recevrez un trafic de recherche organique passif cohérent.

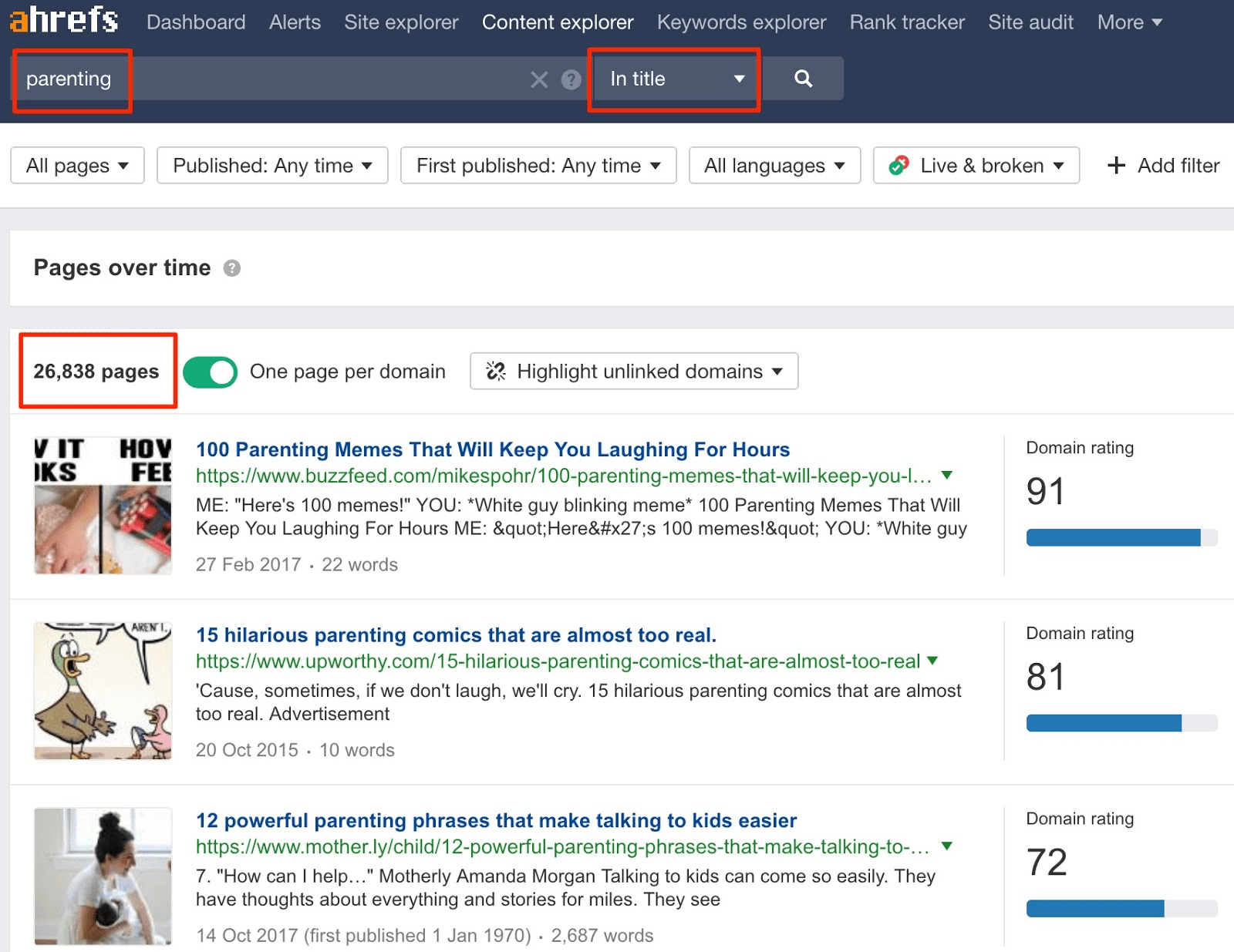

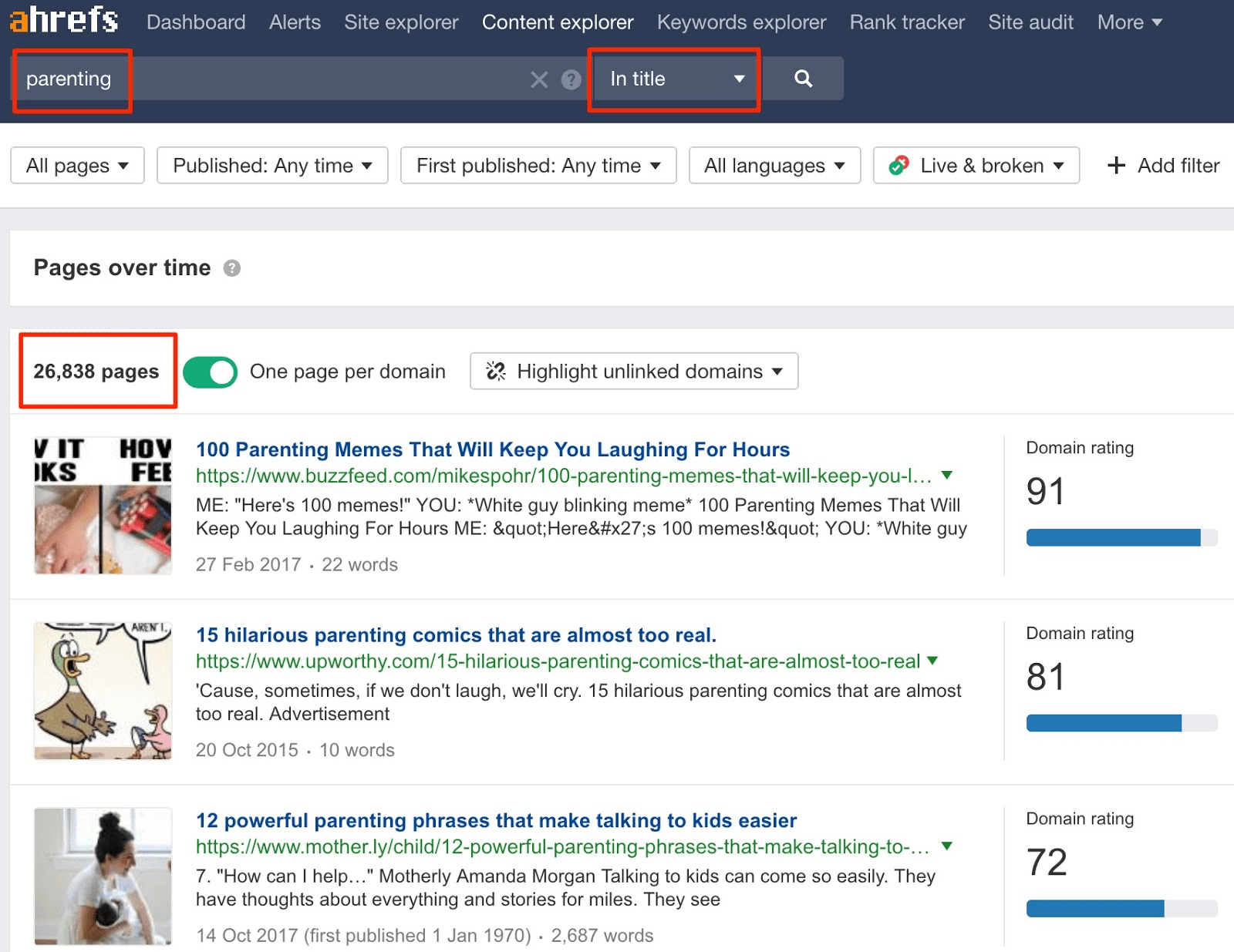

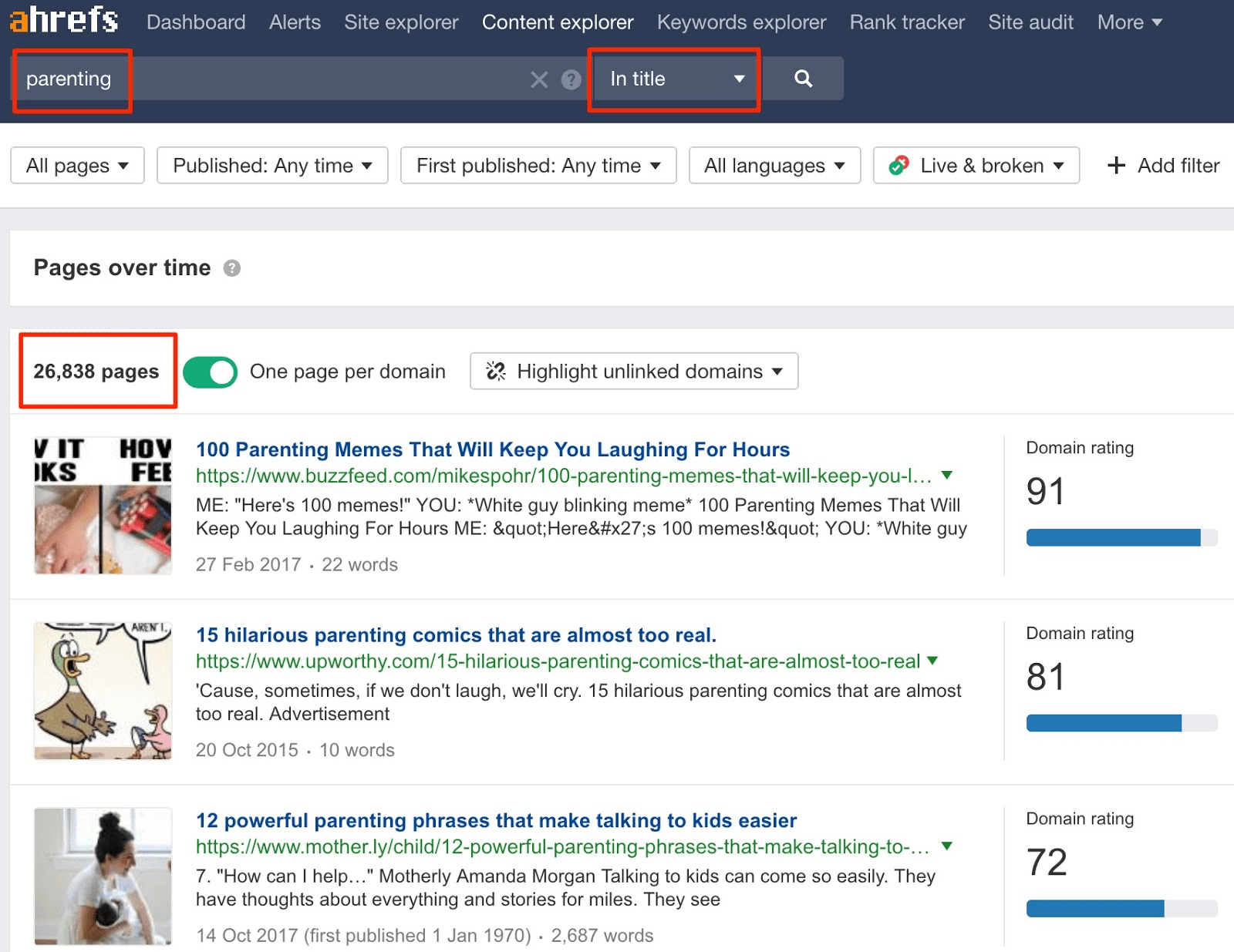

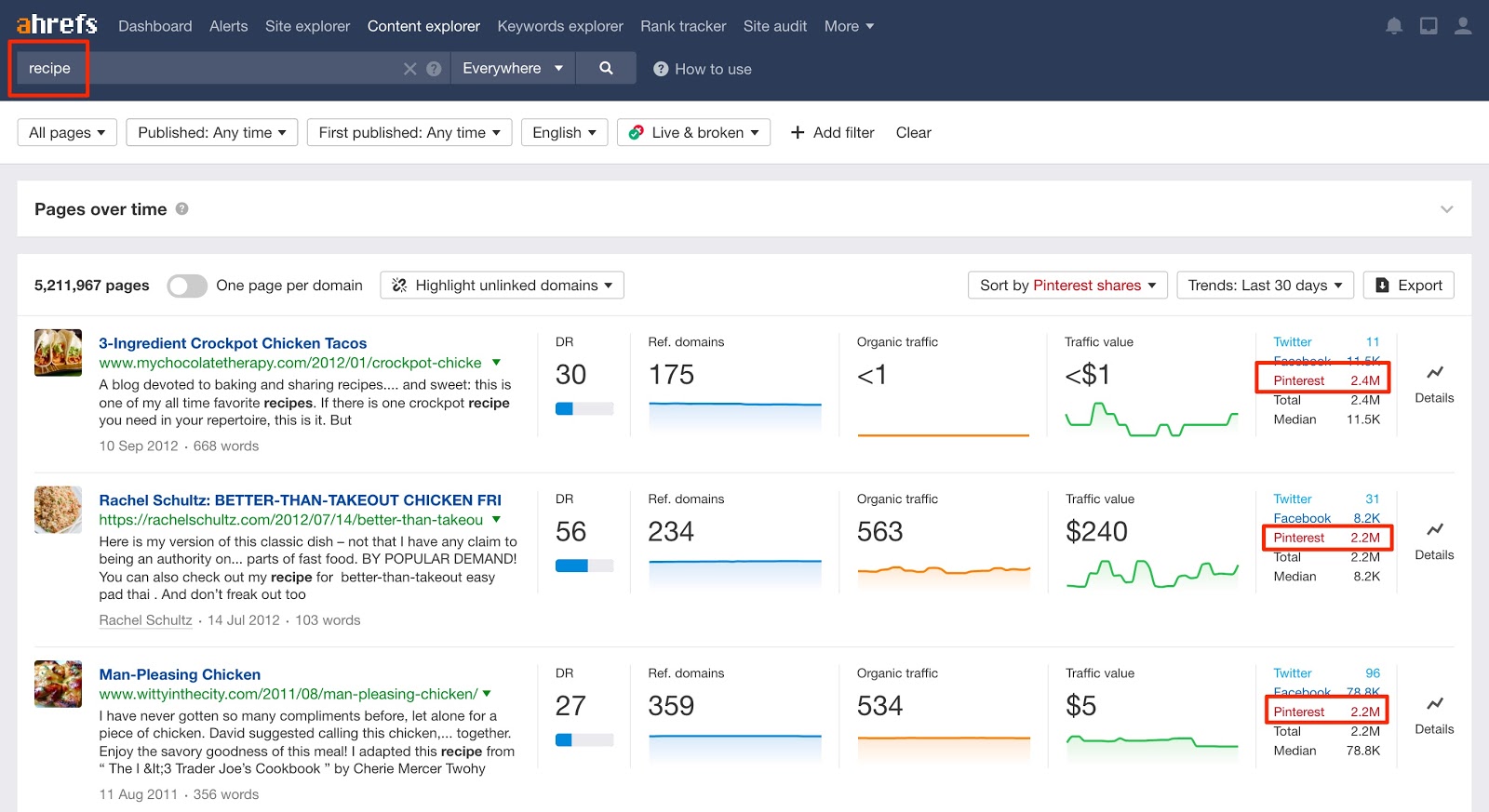

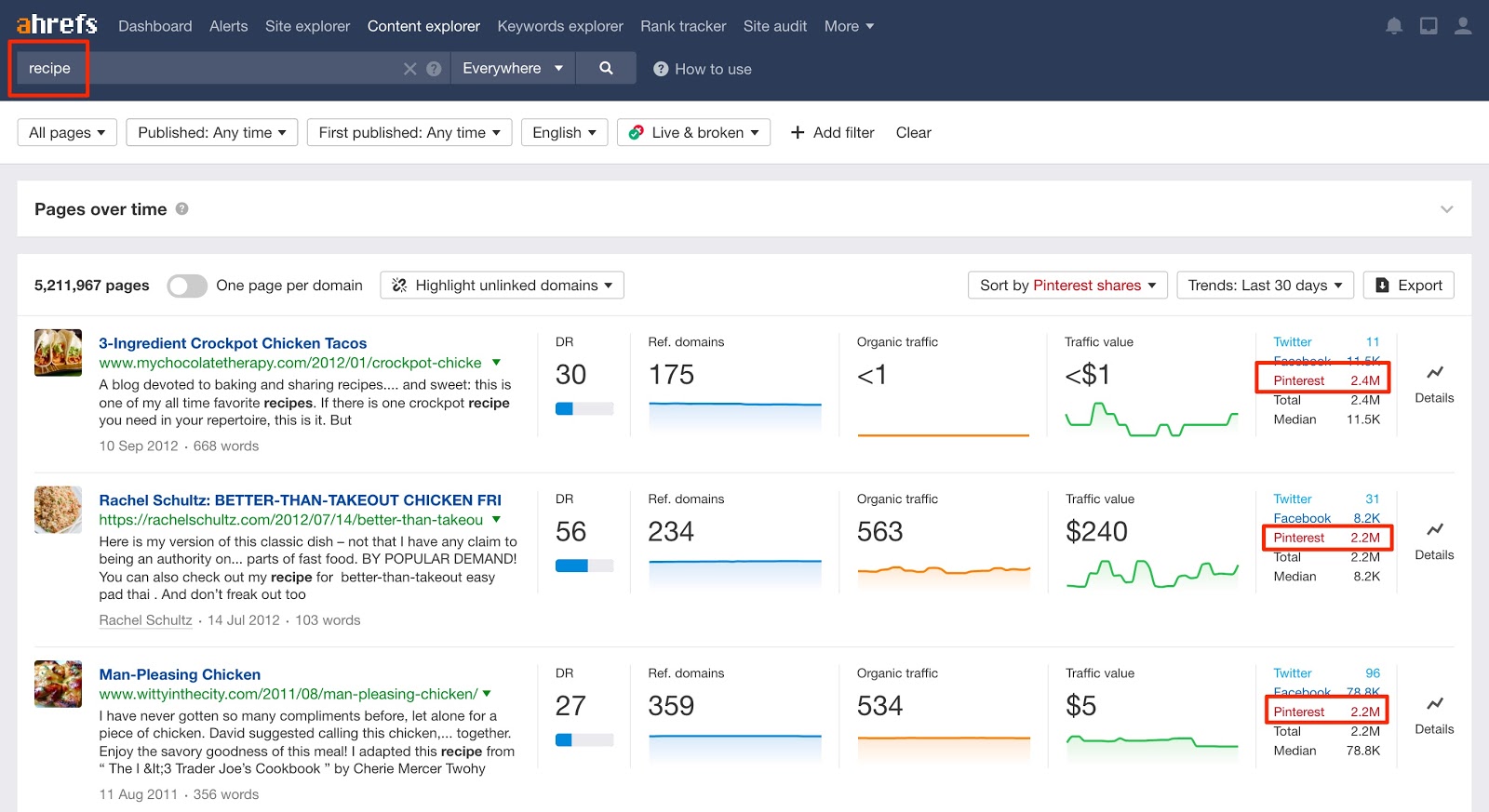

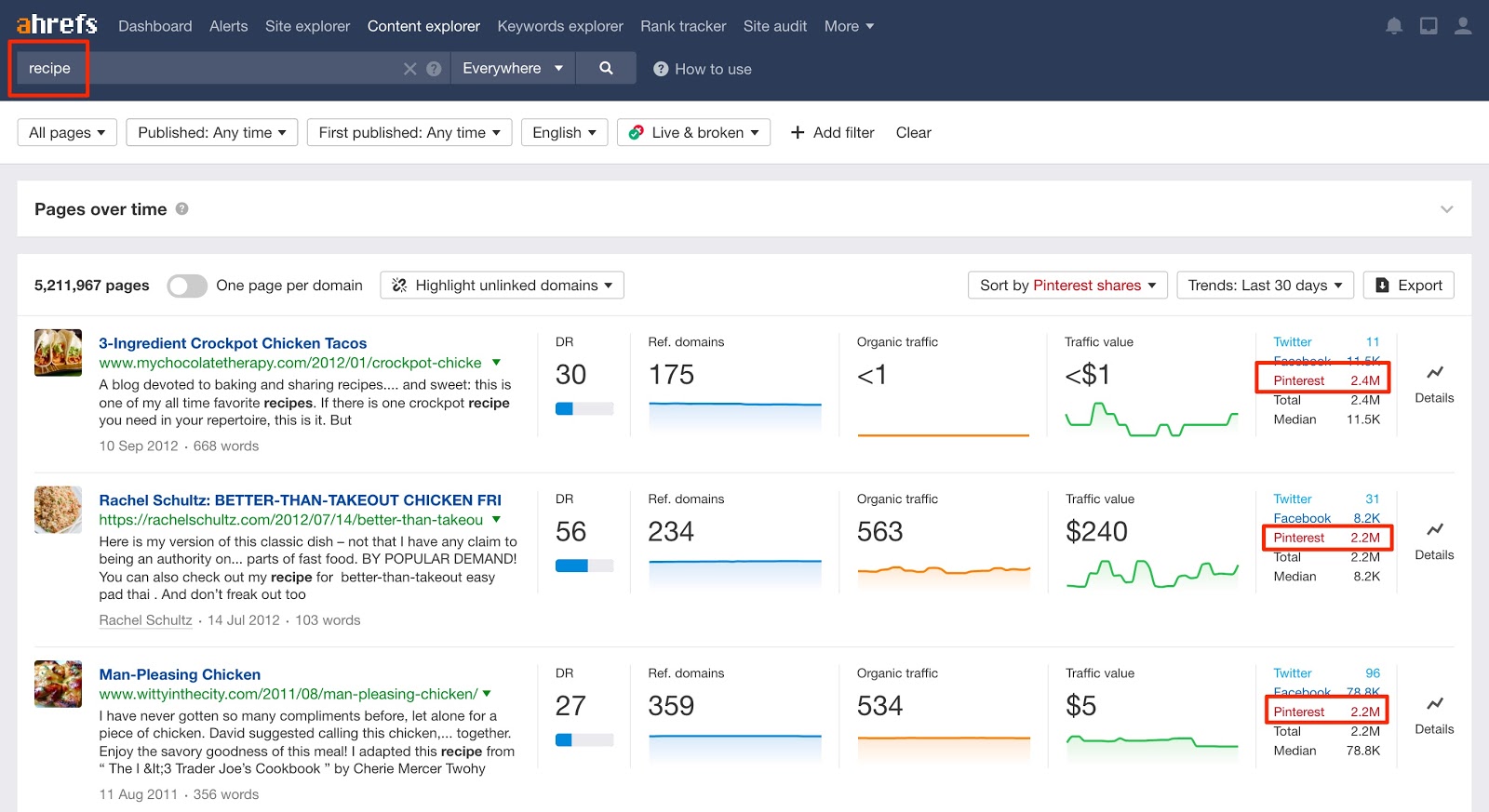

C’est le fondement de notre approche avec le Ahrefs blog. Chaque publication que nous publions cible un terme présentant un potentiel de trafic de recherche.

Maintenant, comment trouvez-vous ces sujets?

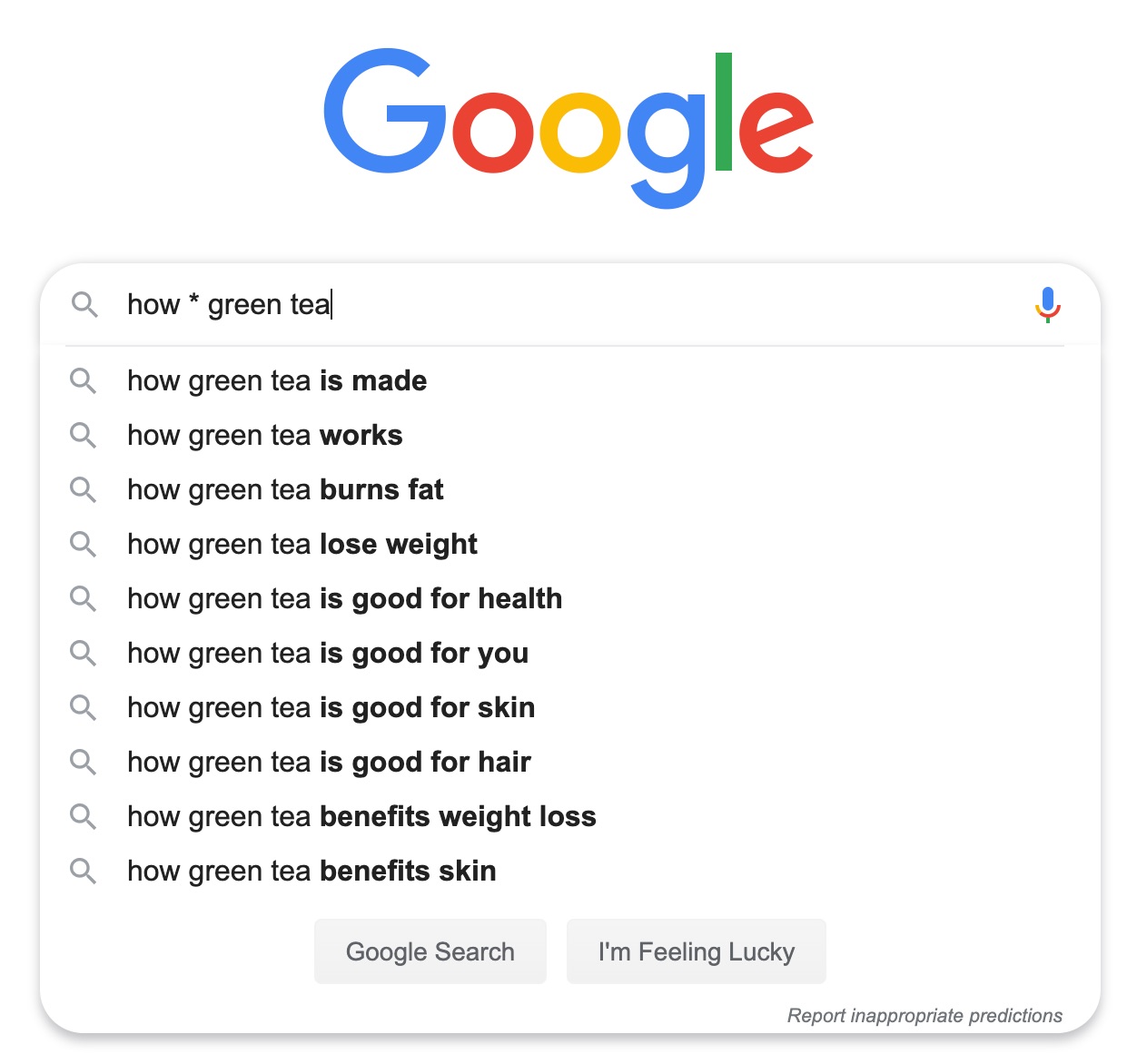

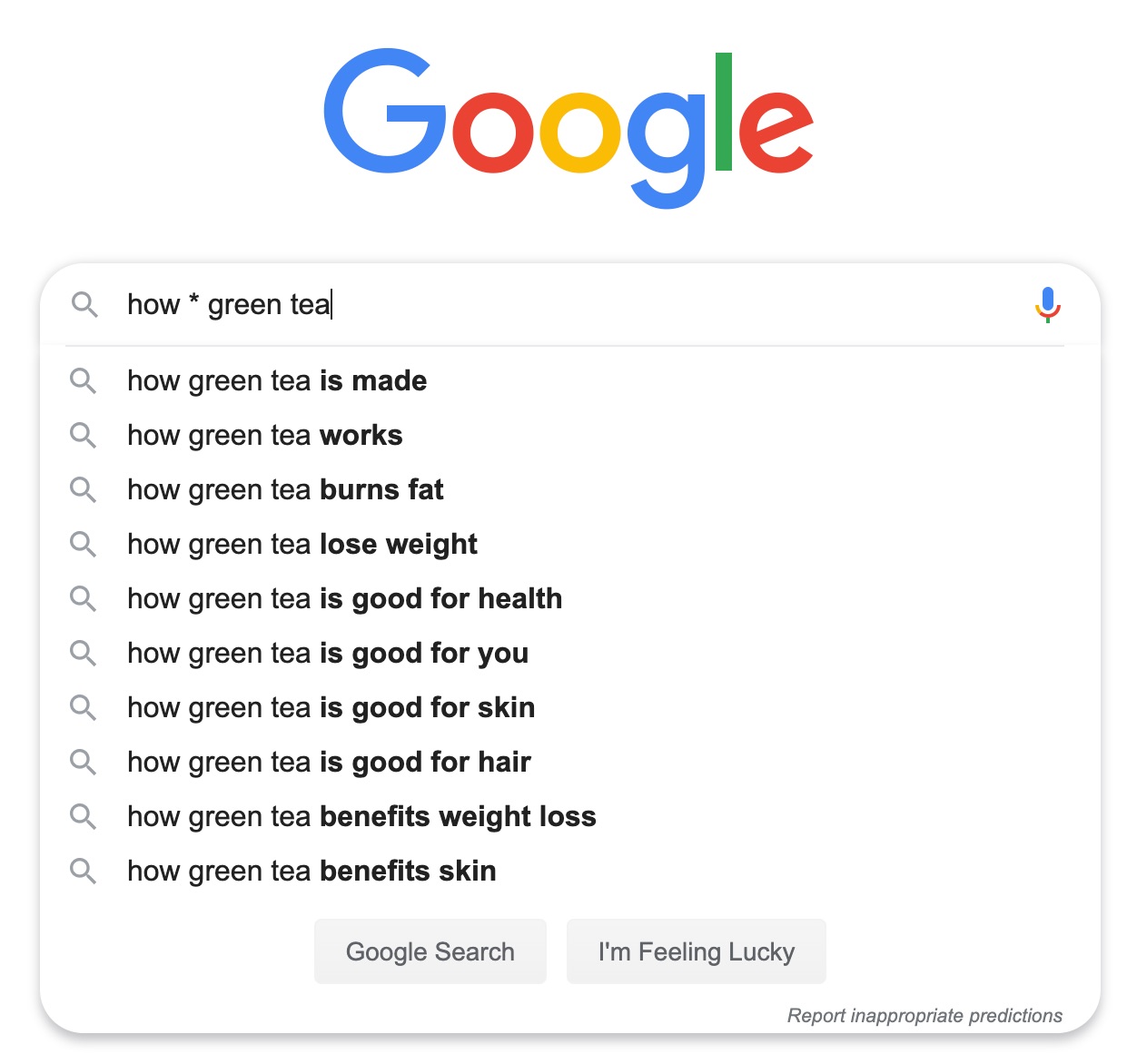

La façon la plus simple de commencer est de taper un mot clé pertinent dans Google et de consulter les idées suggérées. Ce sont des termes connexes que d'autres ont recherchés.

Sidenote.

L'utilisation d'un astérisque (*) fait office de caractère générique, ce qui suggère plus d'idées.

Le problème est que Google ne vous dit pas à quel point ces recherches sont populaires. Ils pourraient obtenir une recherche par mois, des millions ou n'importe où entre les deux.

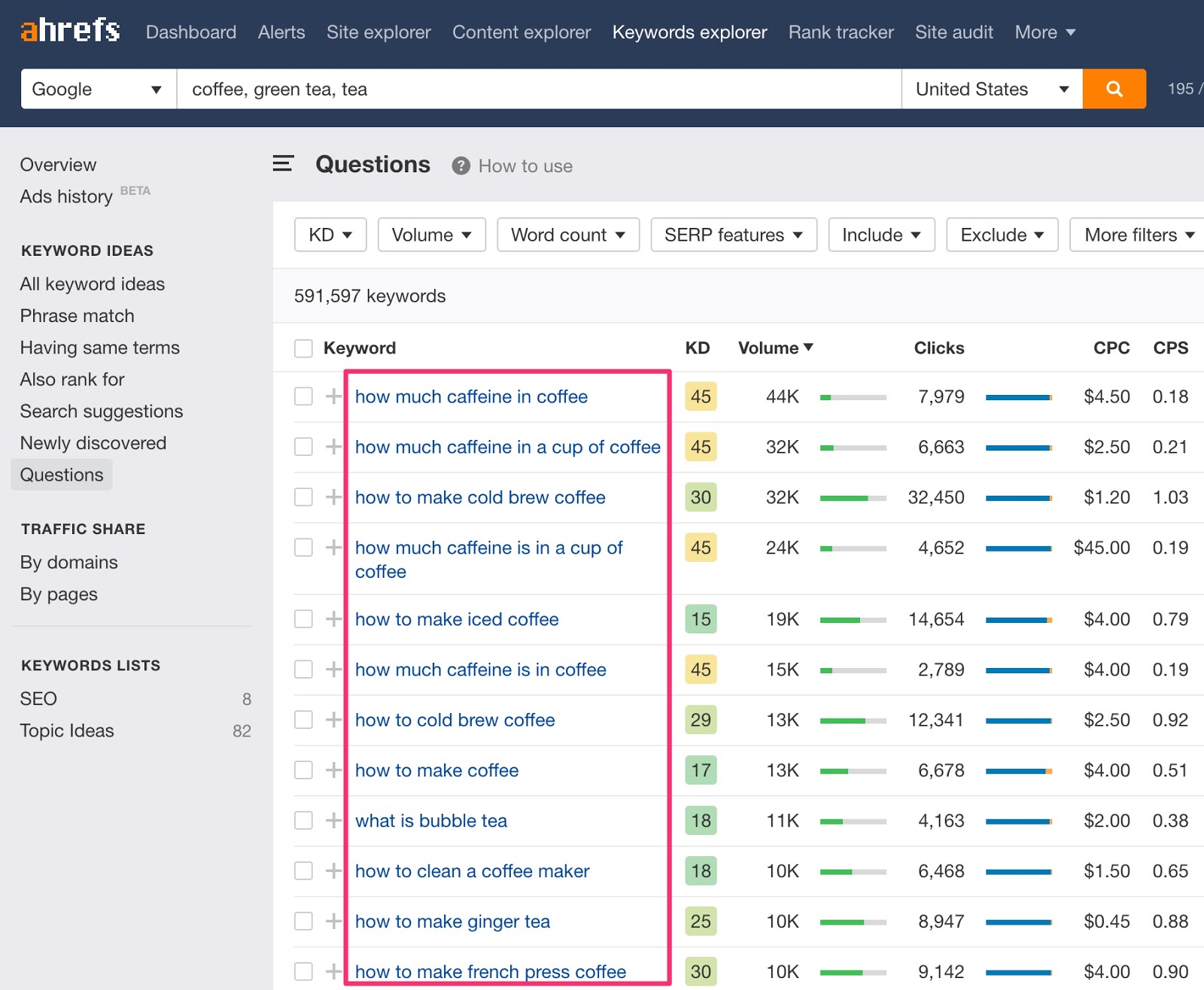

Pour résoudre ce problème, utilisez un outil de mot clé professionnel tel que Ahrefs ’Keywords Explorer.

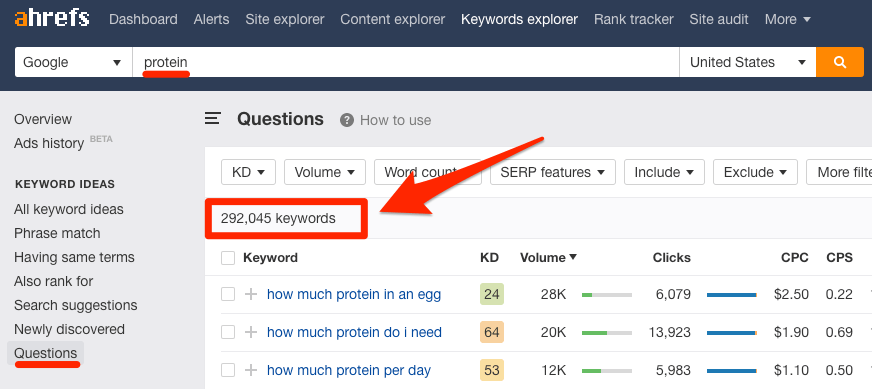

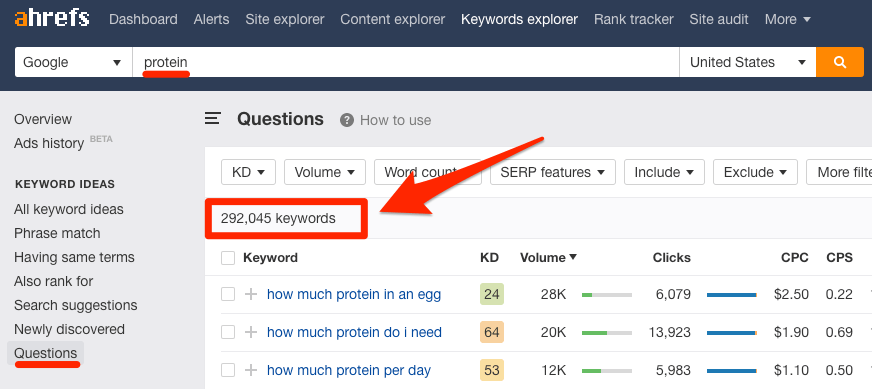

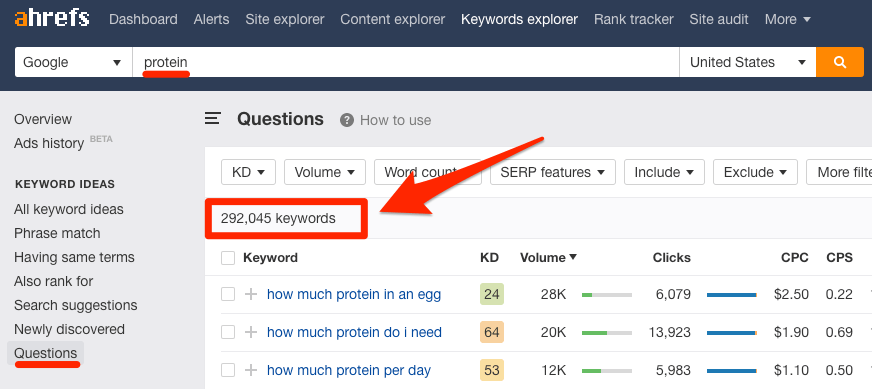

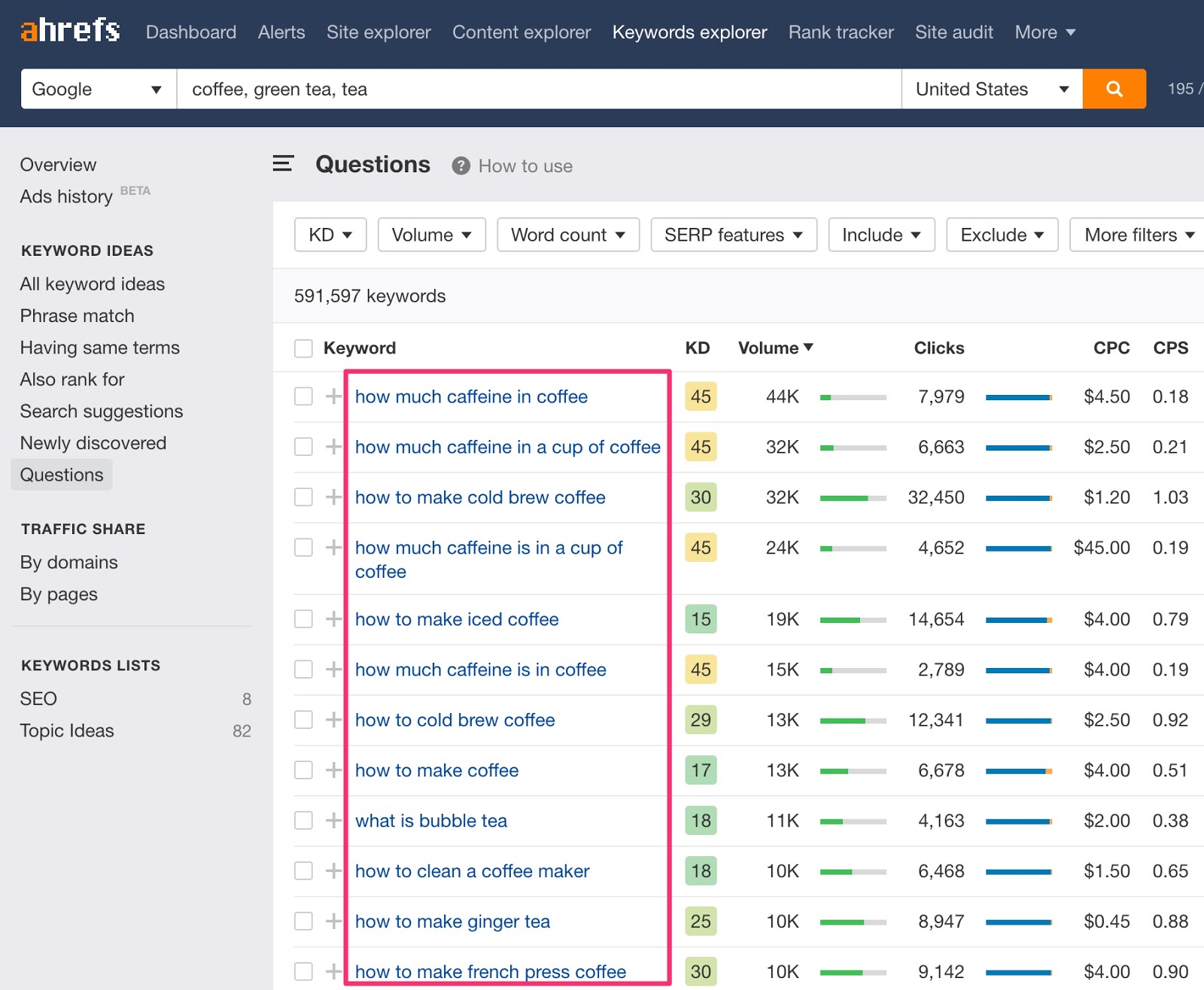

Entrez quelques mots ou expressions pertinents et accédez au rapport «Questions» pour consulter les questions les plus fréquemment posées.

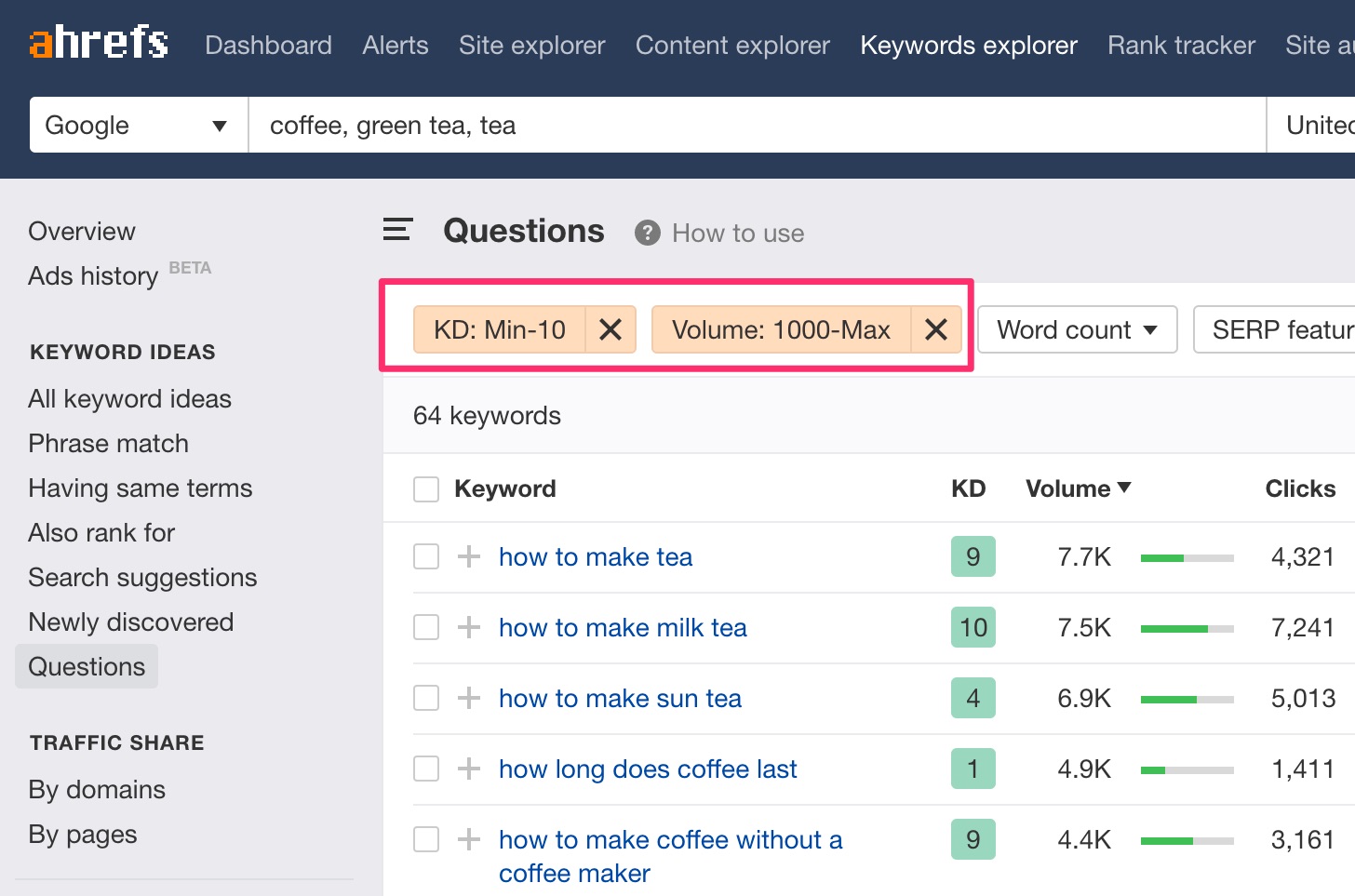

Si vous avez un nouveau blog, vous pouvez vous concentrer sur les mots clés populaires mais potentiellement faciles à classer. Pour ce faire, filtrer pour ceux avec un maximum Difficulté mot-clé (KD) de 10 et un minimum volume de recherche de 1.000.

Parcourez la liste des idées et choisissez celles qui sont pertinentes pour votre blog.

L'intention de recherche est la Pourquoi derrière une requête de recherche.

Pourquoi est-ce important?

Google vise à fournir aux utilisateurs les résultats les plus pertinents pour leurs requêtes. Si vous souhaitez que Google figure en bonne place, vous devez être le résultat le plus pertinent, ce qui signifie créer un contenu conforme à l'objectif de recherche.

Comment déterminez-vous le type de contenu à créer? La réponse est avec Google.

Étant donné que Google fournit déjà le type de contenu que les gens souhaitent consulter, vous pouvez procéder à un reverse engineering de votre intention de recherche en consultant les éléments déjà classés sur la première page.

Prenez, par exemple, la requête «café de la presse française».

La plupart des pages en tête de liste sont des articles pratiques sur la préparation du café dans la presse française. C’est ce que vous devez créer pour avoir une chance de classement pour ce mot clé.

Voici un autre exemple:

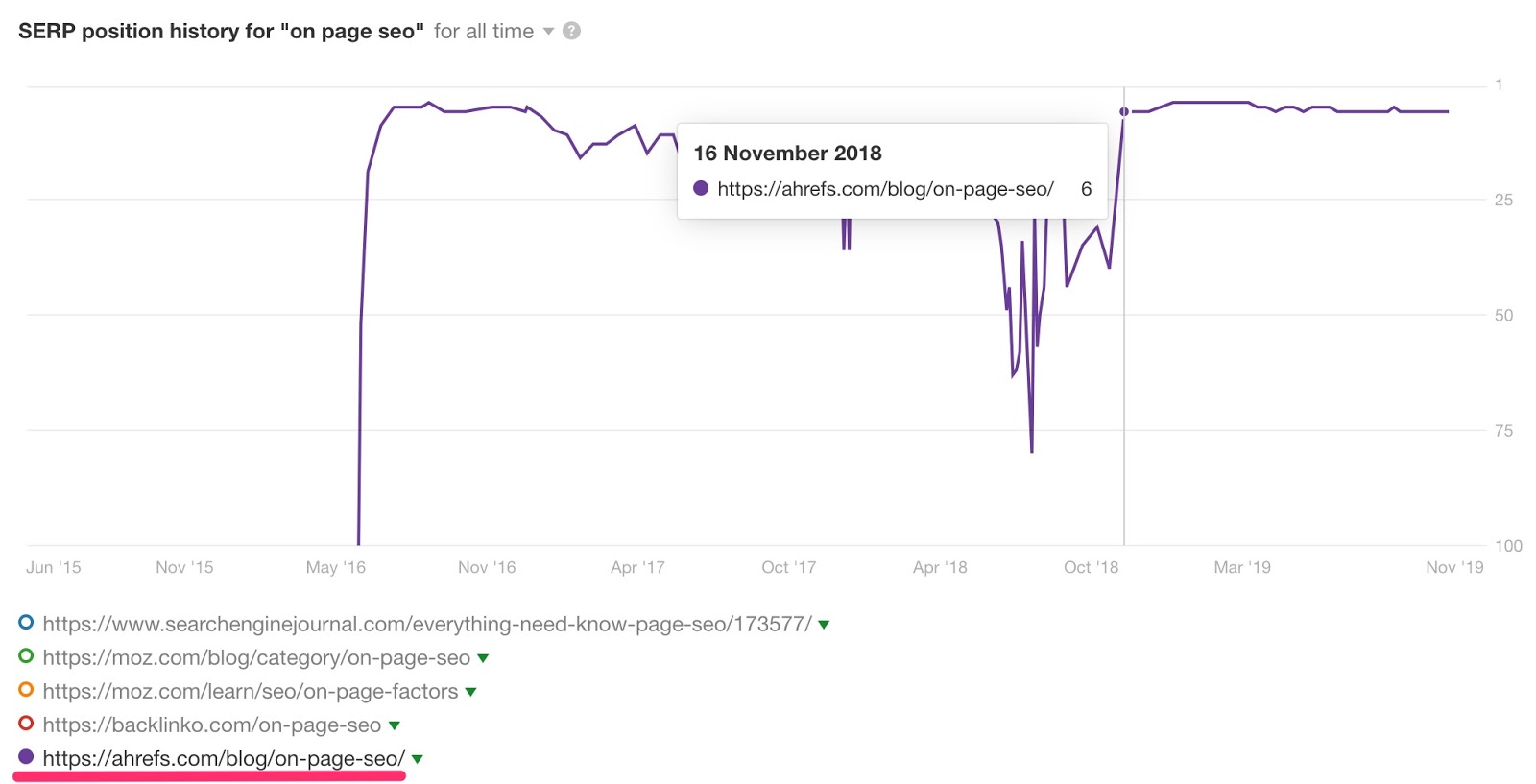

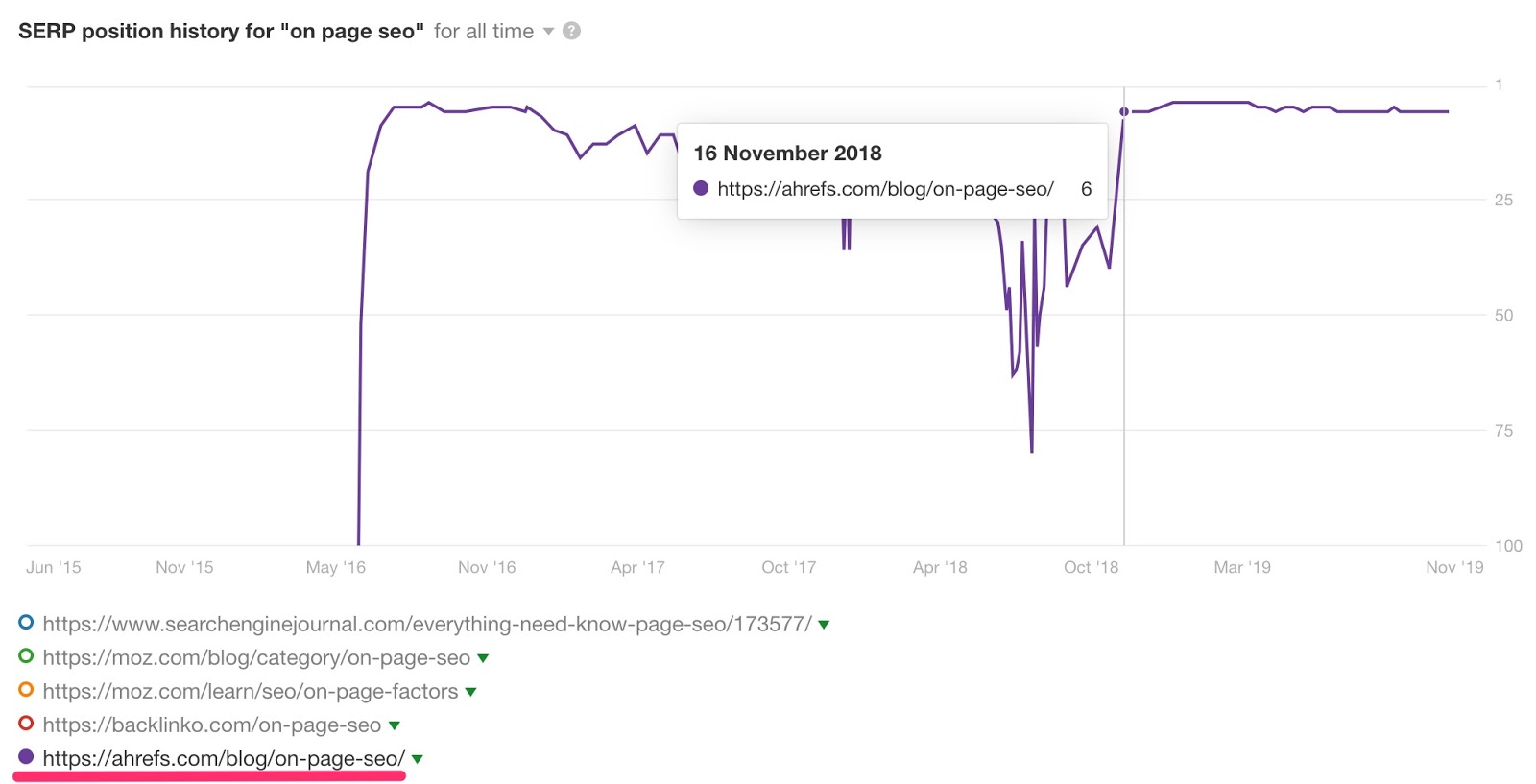

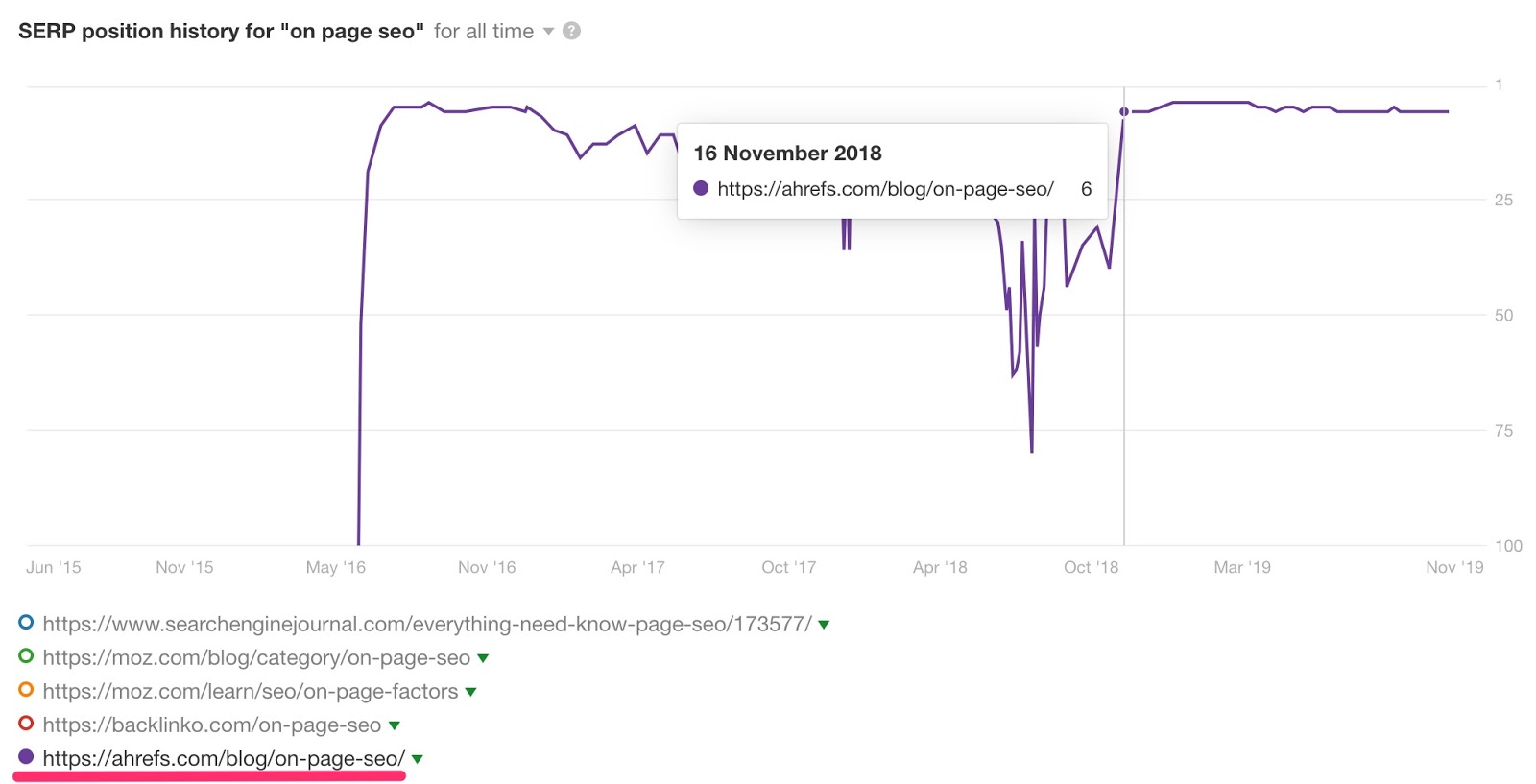

En 2016, nous avons publié une page sur SEO étude. Il s'est bien classé pendant un court instant mais a rapidement disparu de la première page.

Après avoir analysé l’intention de recherche, nous nous sommes rendu compte que les personnes recherchant “sur la page SEO”Ne voulait pas d’étude; ils voulaient un guide simple et utilisable. Alors on réécrit le post avec ça en tête.

En trois jours, il est passé de la position n ° 40 à la position n ° 6.

En savoir plus sur l’intention de recherche dans notre guide du débutant.

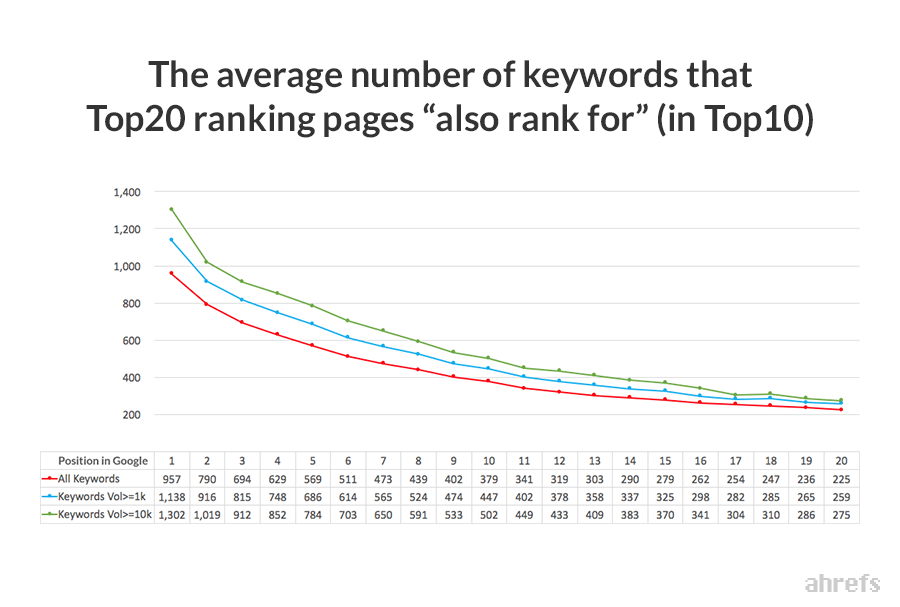

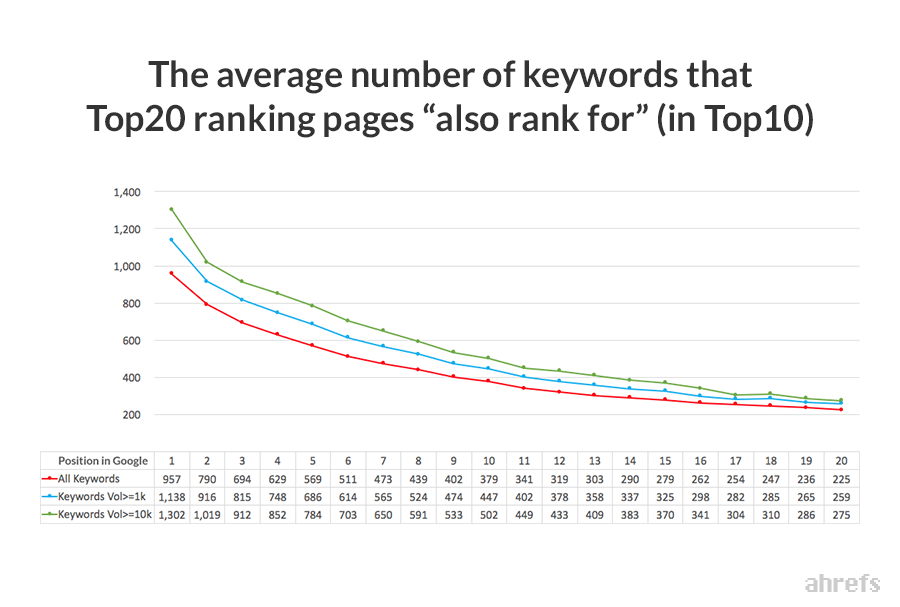

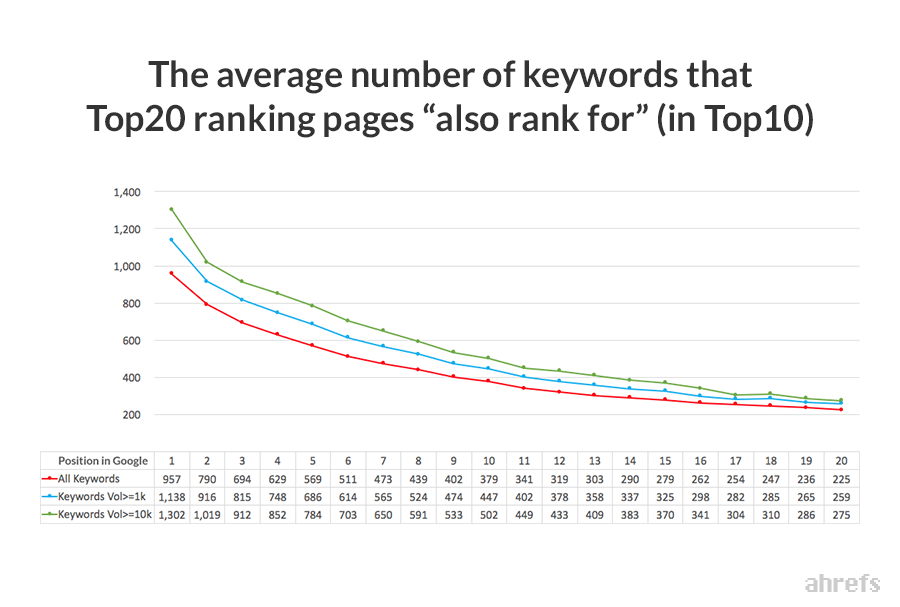

Fait amusant: la moyenne n ° 1 page de classement se classe également dans le top 10 pour près de 1 000 autres mots clés.

Cela est dû au fait que Google sait que lorsque les internautes recherchent des variantes du même sujet (par exemple, "comment perdre du poids", "perdre du poids", etc.), ils recherchent tous la même chose.

En conséquence, ils classent souvent les mêmes pages pour de nombreuses requêtes connexes.

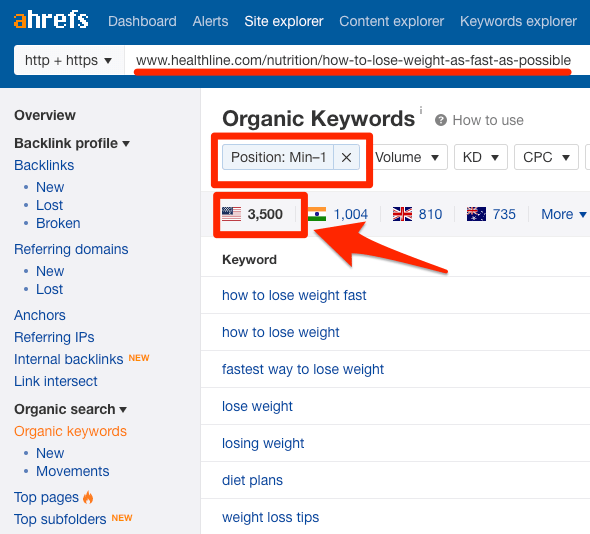

Un article de Healthline classé n ° 1 pour 3500 mots-clés.

Comment pouvez-vous améliorer vos chances de classement pour de nombreuses requêtes de ce type?

Créez du contenu couvrant un sujet avec autant de détails que possible.

Vous avez peut-être remarqué qu'il s'agit de notre stratégie sur le blog Ahrefs. Chaque guide que nous publions est complet et détaillé.

Maintenant, la question clé est la suivante: comment créer du contenu détaillé?

Si vous écrivez à propos de quelque chose que vous connaissez déjà beaucoup, cela devrait être un jeu d'enfant. Mais si vous n'êtes pas un expert en la matière, essayez ceci:

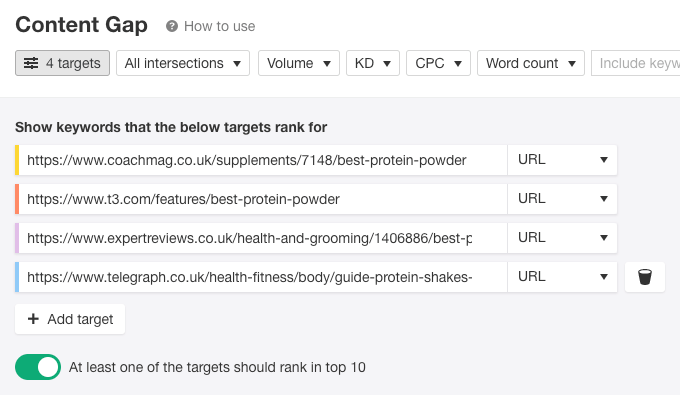

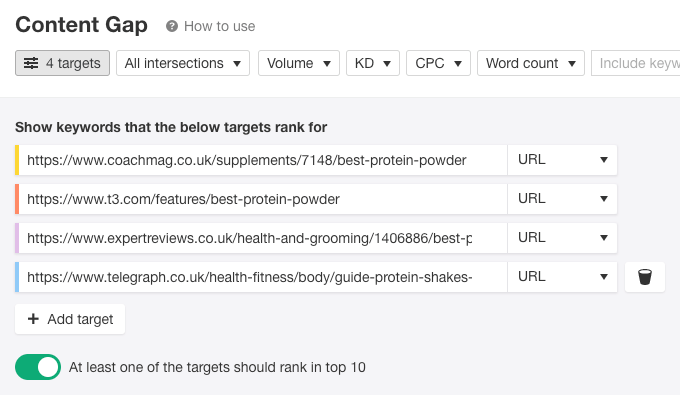

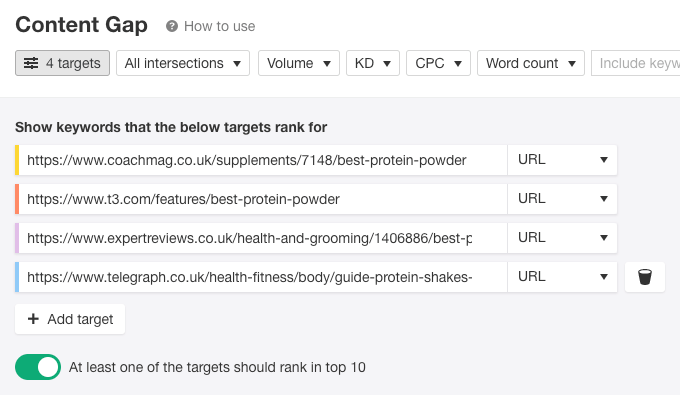

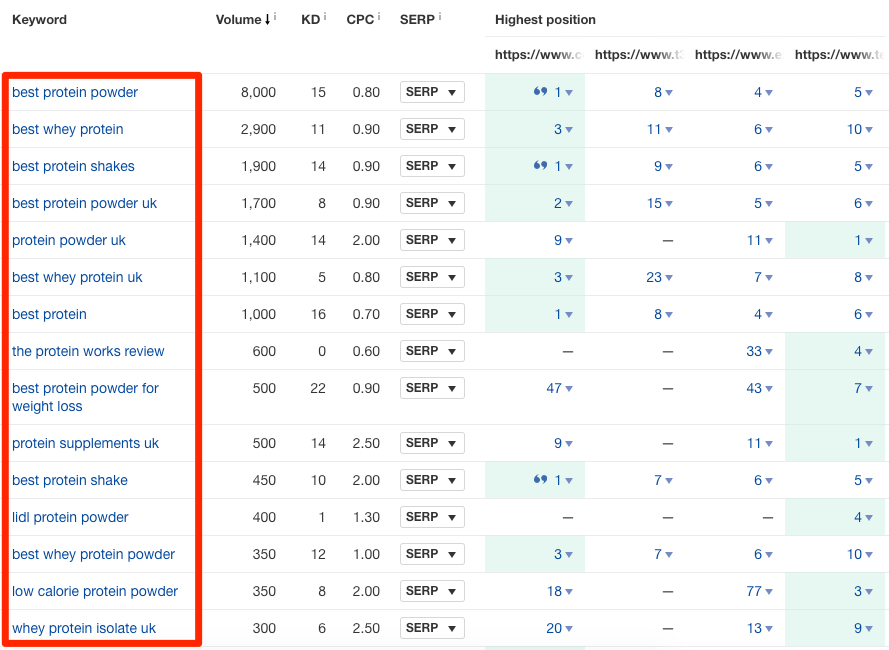

Collez quelques-unes des pages les mieux classées pour votre mot clé cible dans Ahrefs ». Lacune de contenu outil. Choisir la "URL”Mode pour tous.

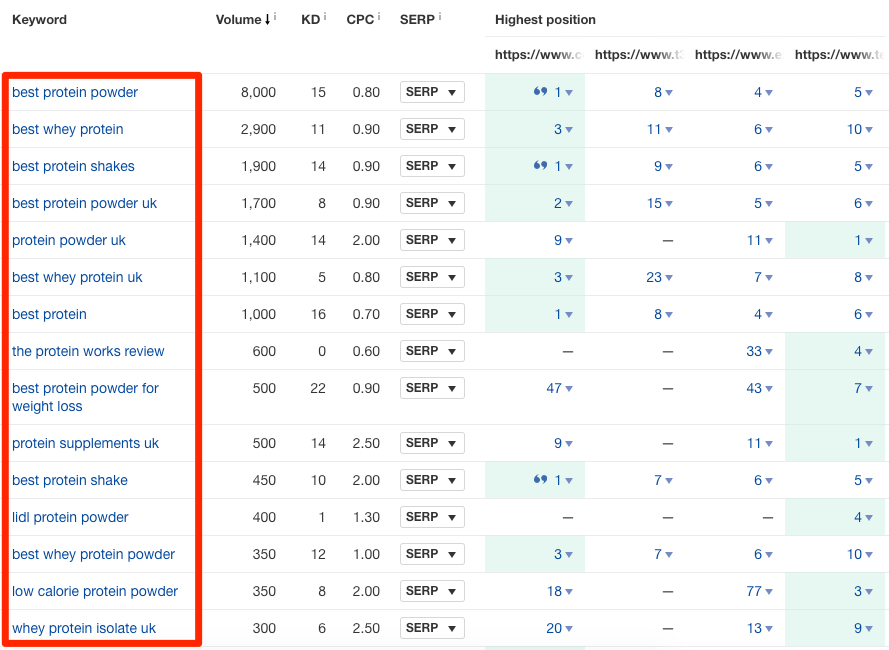

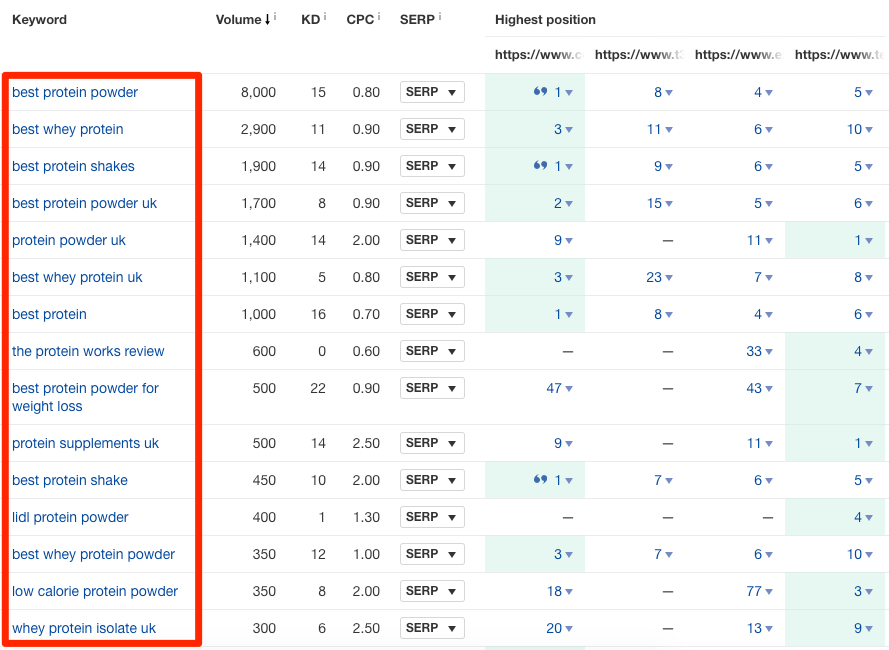

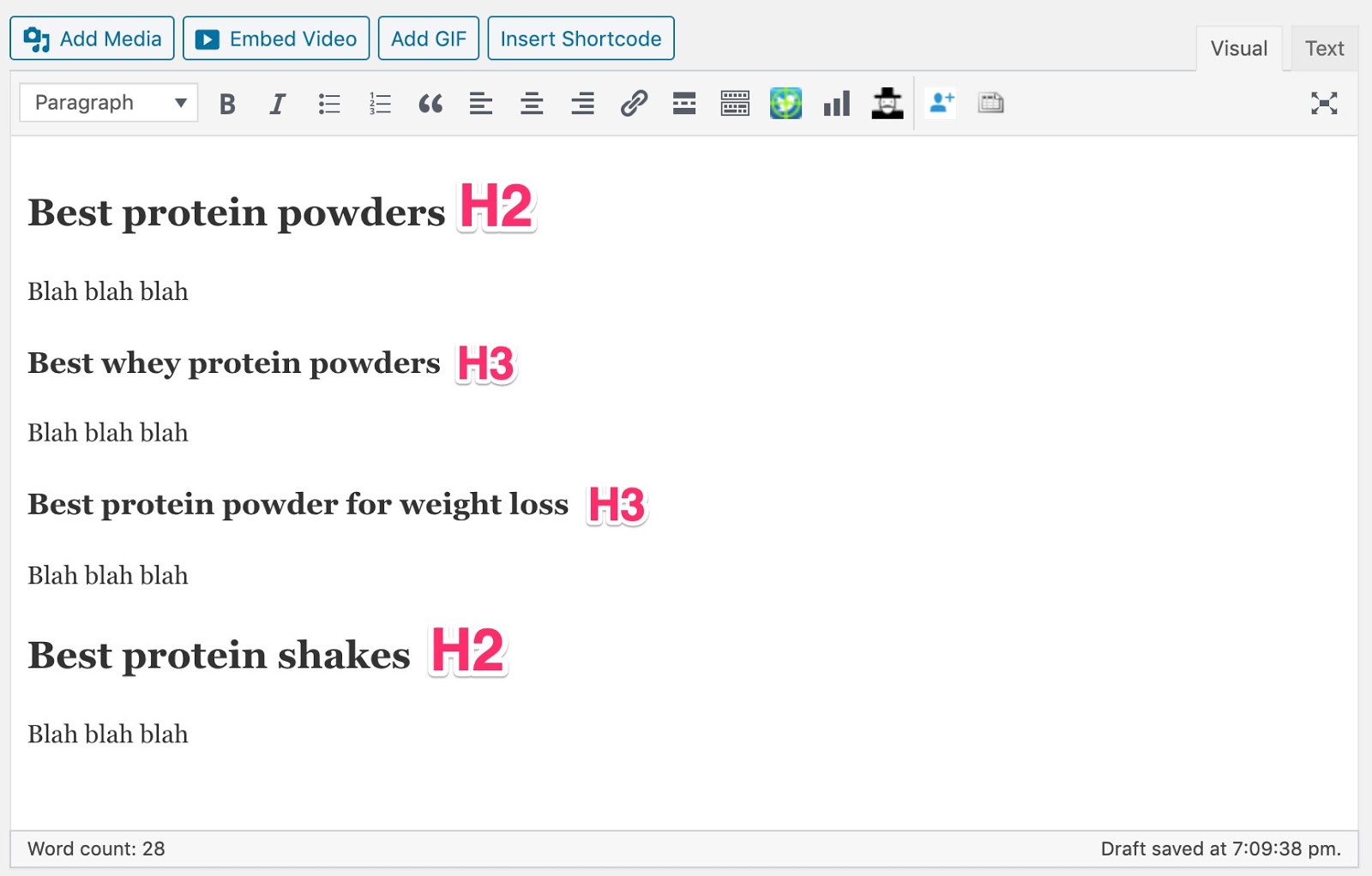

Quelques-unes des pages les mieux classées pour la "meilleure poudre de protéine" dans l’outil de gestion de contenu d’Ahrefs.

Cliquez sur «Afficher les mots-clés» pour voir ceux où une ou plusieurs des pages se classent parmi les 100 meilleurs.

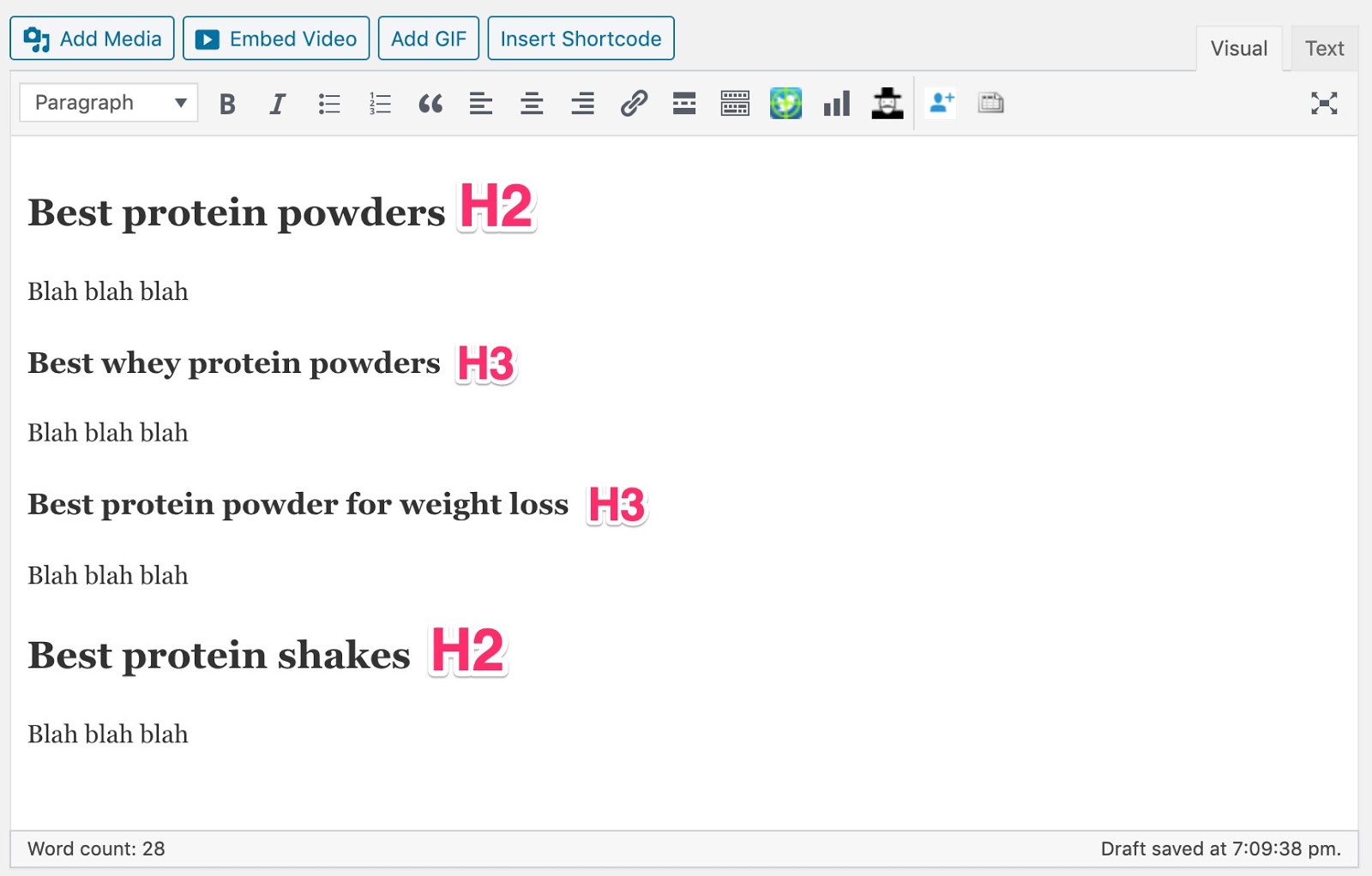

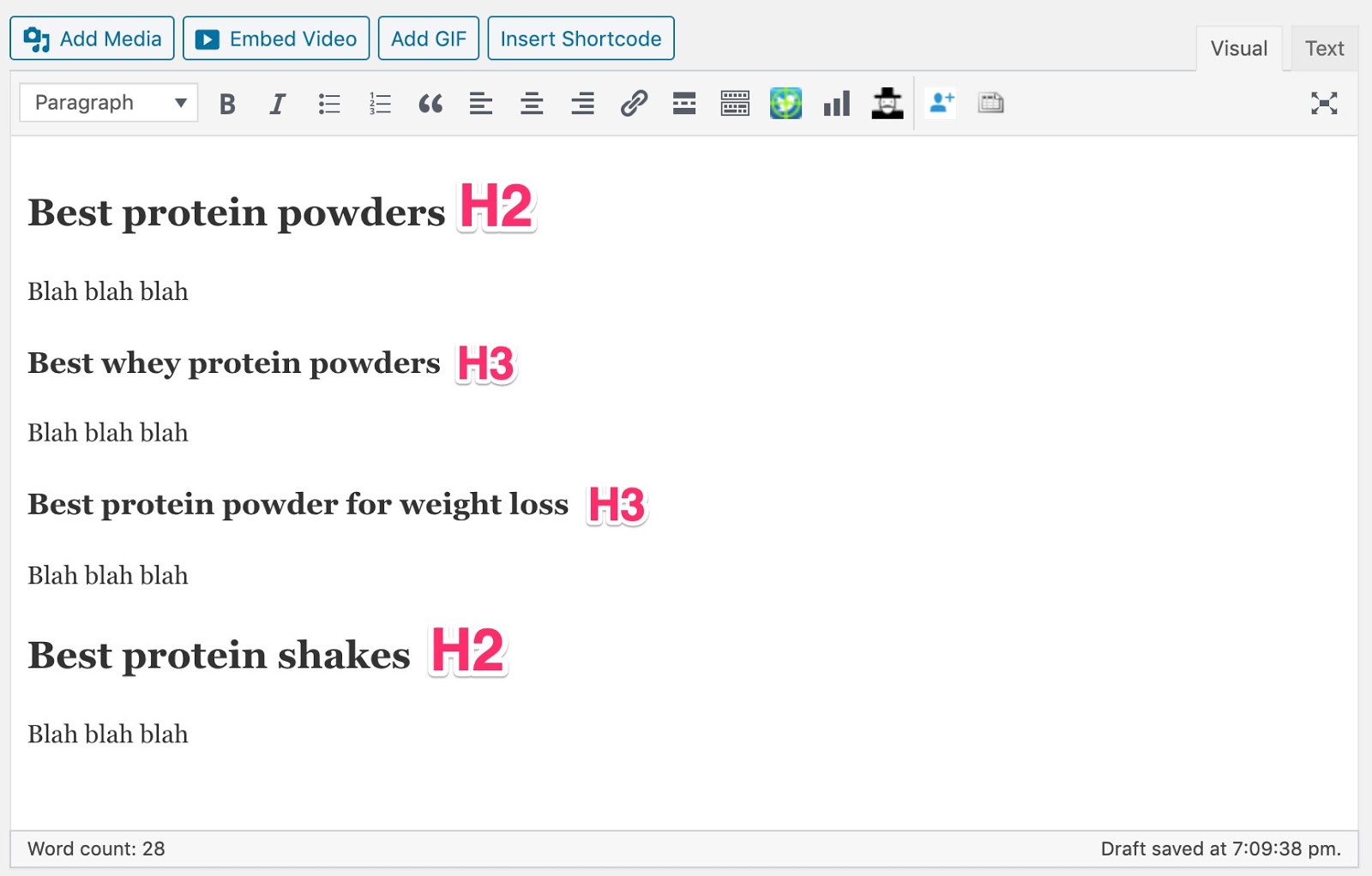

En regardant à travers cette liste, nous pouvons voir des sous-thèmes potentiels que nous devrions couvrir dans un article sur les meilleures poudres de protéines. Par exemple, «meilleure protéine de lactosérum», «meilleure poudre de protéine pour perdre du poids», etc.

Vous pouvez même utiliser cette information pour étoffer votre post.

Chaque fois que nous publions un nouveau message sur notre blog, nous l'envoyons directement à environ 60 000 personnes.

Nous sommes en mesure de le faire car ces personnes se sont abonnées pour entendre parler de chaque nouveau message via des opt-in comme celui-ci:

Pourquoi envoyer un email?

Des plates-formes comme Facebook limitent délibérément votre portée (La portée biologique moyenne sur Facebook est comprise entre 1 et 6%). Avec le courrier électronique, vous pouvez communiquer avec vos fans à tout moment.

Construire une liste ne doit pas être compliqué. À Ahrefs, nous proposons simplement de fournir davantage de contenu que les utilisateurs apprécient directement dans leur boîte de réception.

Si vous voulez être un peu plus «agressif» que nous, essayez d’offrir quelque chose d’utile comme un PDF version de la poste ou un cours gratuit de 7 jours en échange de leur courrier électronique.

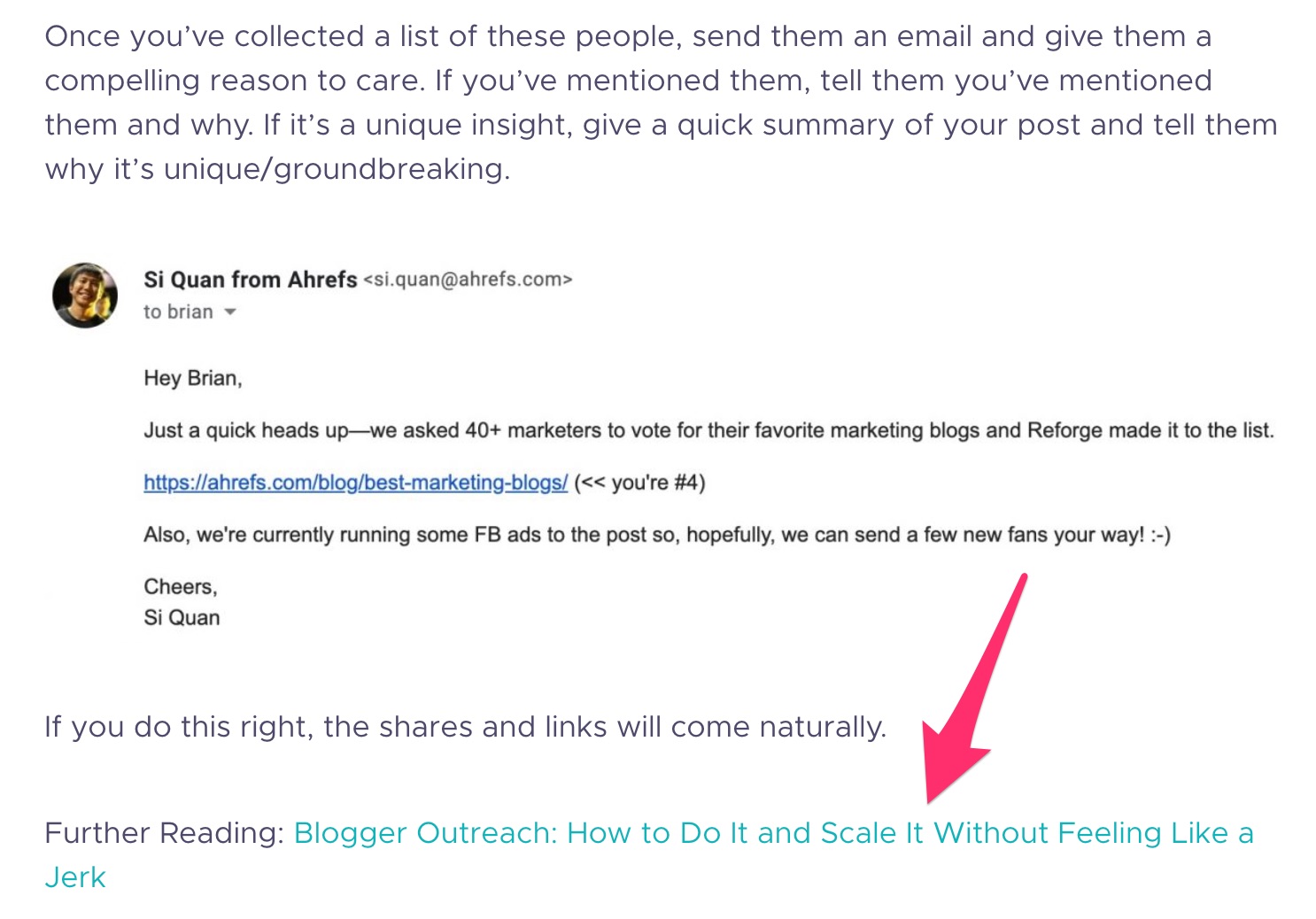

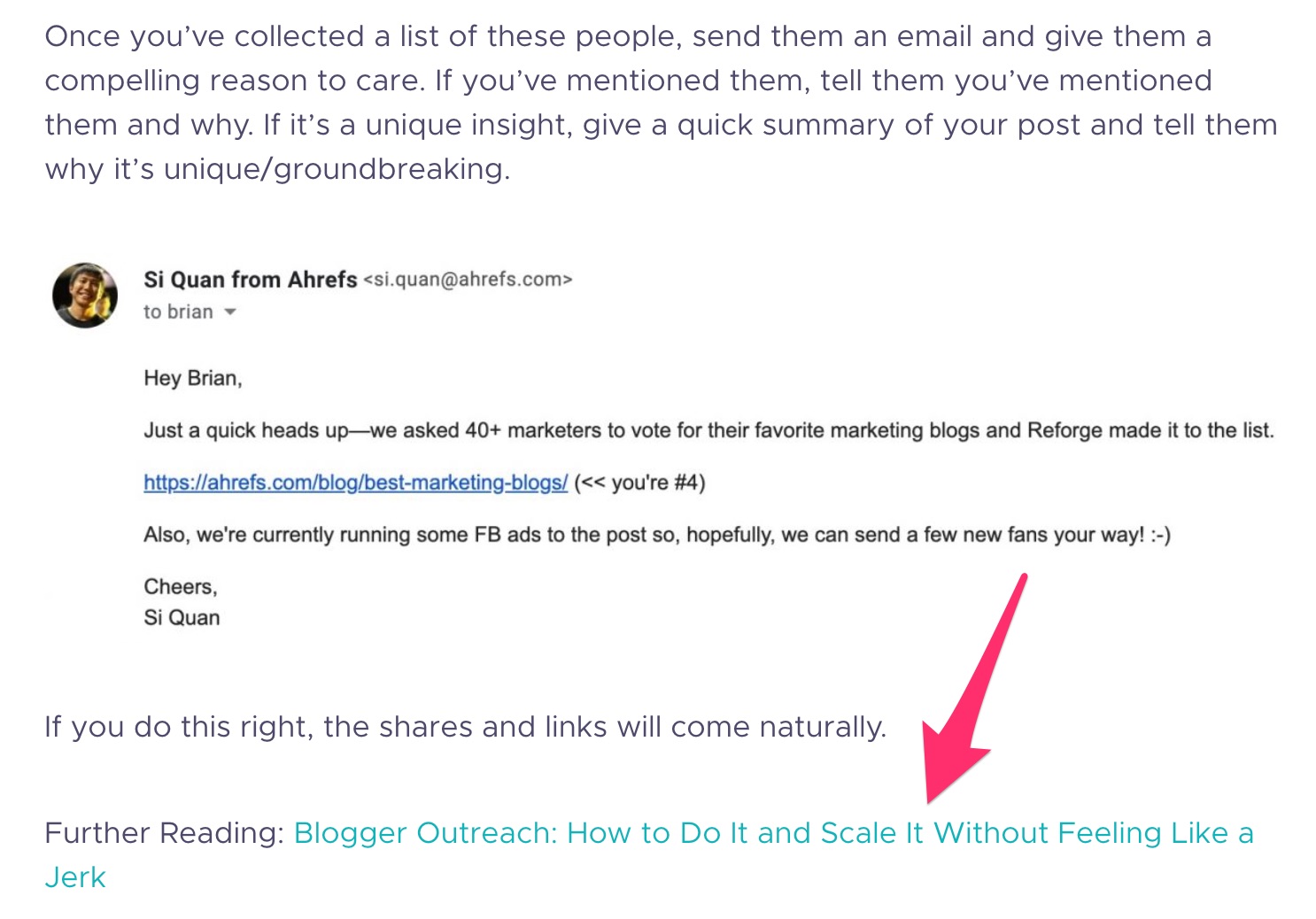

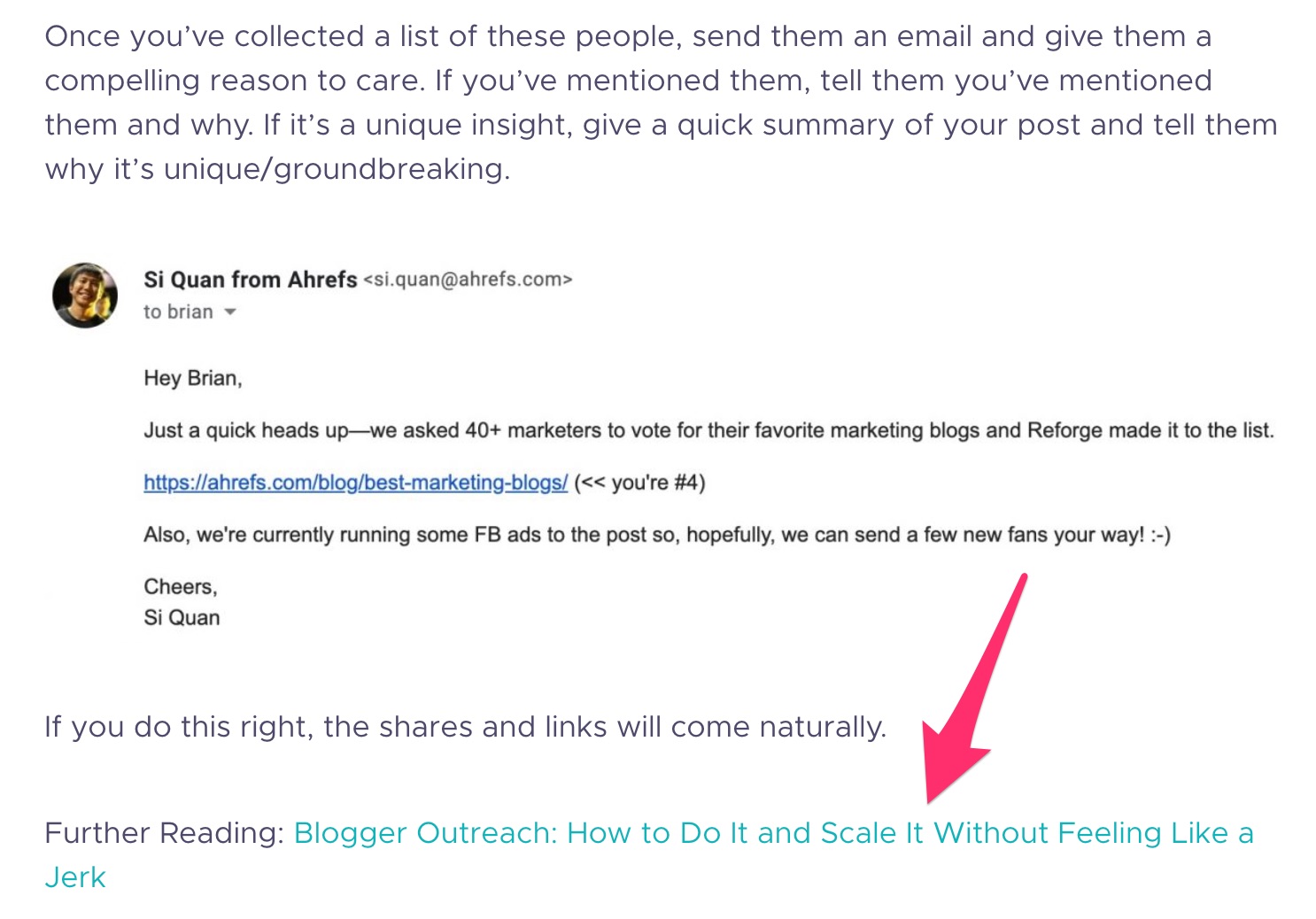

Si vous avez écrit un article de fond, vous avez probablement accès à des ressources utiles d’autres blogueurs. Alors pourquoi ne pas tendre la main et leur faire savoir?

C’est la première chose que je fais quand je publie quelque chose de nouveau.

Si vous êtes chanceux, ils le partageront sur leurs profils sociaux et vous enverront du trafic supplémentaire.

Cela dit, l’objectif principal ici est de tendre la main et de construire une relation. Cela pourrait finir par devenir quelque chose de plus grand: actions, liens, partenariats, etc.

L'exécution est assez simple. Lancez votre blog et recherchez les mentions de blogueurs dans votre espace.

Ensuite, trouver leurs emails et tendre la main pour leur faire savoir.

Bien sûr, les personnes mentionnées dans vos publications ne sont pas les seules auxquelles vous pouvez vous adresser. Beaucoup d'autres personnes pourraient être intéressées par la lecture de votre contenu.

Apprenez à trouver ces personnes dans notre guide complet sur la sensibilisation des blogueurs.

Les liens internes sont des liens d'une page du même site Web à une autre. Et les liens internes sont le secret de la raison pour laquelle vous cliquez sur la page A de Wikipedia, vous vous retrouvez sur la page X de Wikipedia et vous vous demandez où tout le temps a passé.

Si vous pouvez ajouter des liens internes à partir de pages pertinentes de haute autorité à celles qui ont besoin d'un coup de pouce, vous pourrez améliorer leurs performances dans les moteurs de recherche.

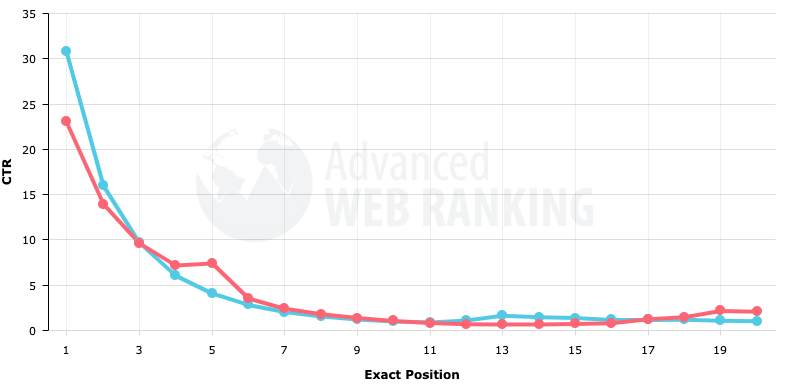

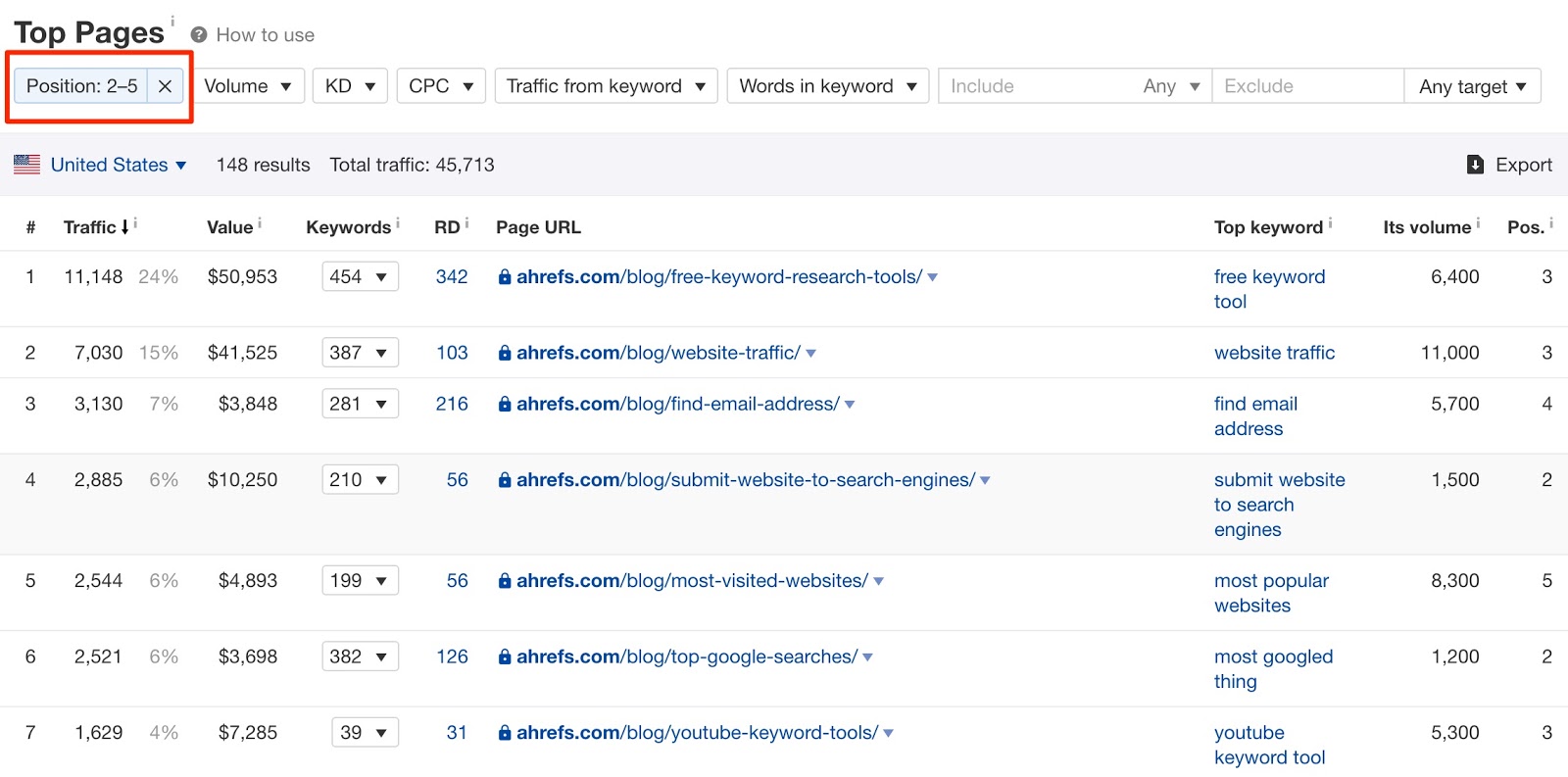

Faire cela est relativement simple. Commencez par rechercher les pages classées aux positions n ° 2 à n ° 5 pour leur mot clé principal. Pour ces pages, quelques liens internes puissants peuvent potentiellement faire une grande différence.

Après tout, environ 70% des clics de première page vont dans les 3 premiers résultats.

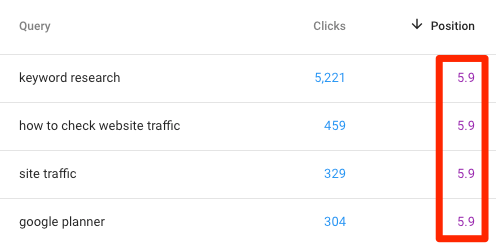

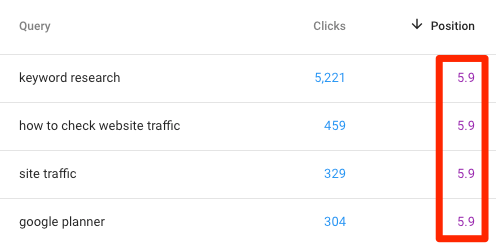

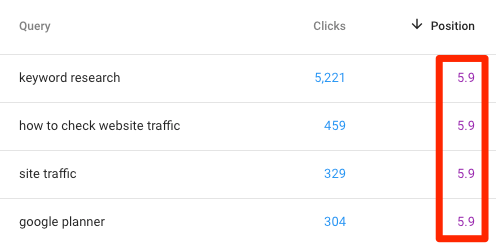

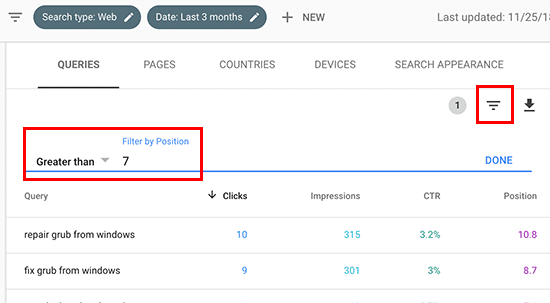

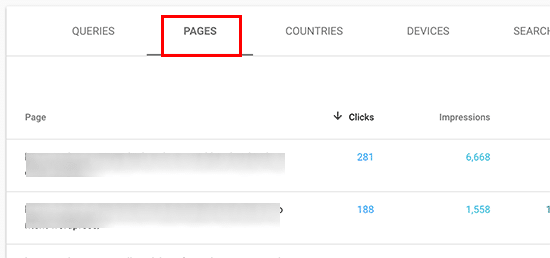

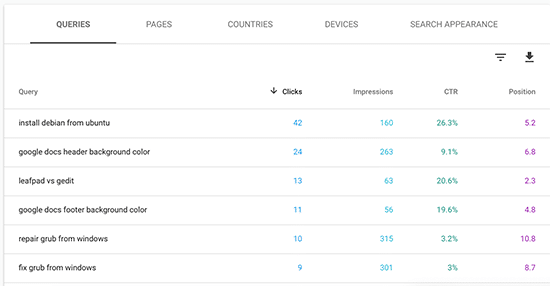

Vous pouvez trouver ces pages à l’aide de la console de recherche Google (ici un guide sur Comment commencer.) Accédez au rapport «Résultats de la recherche» sous «Performances» et définissez un filtre «Positions» pour afficher les pages dont le classement moyen est inférieur à 6.

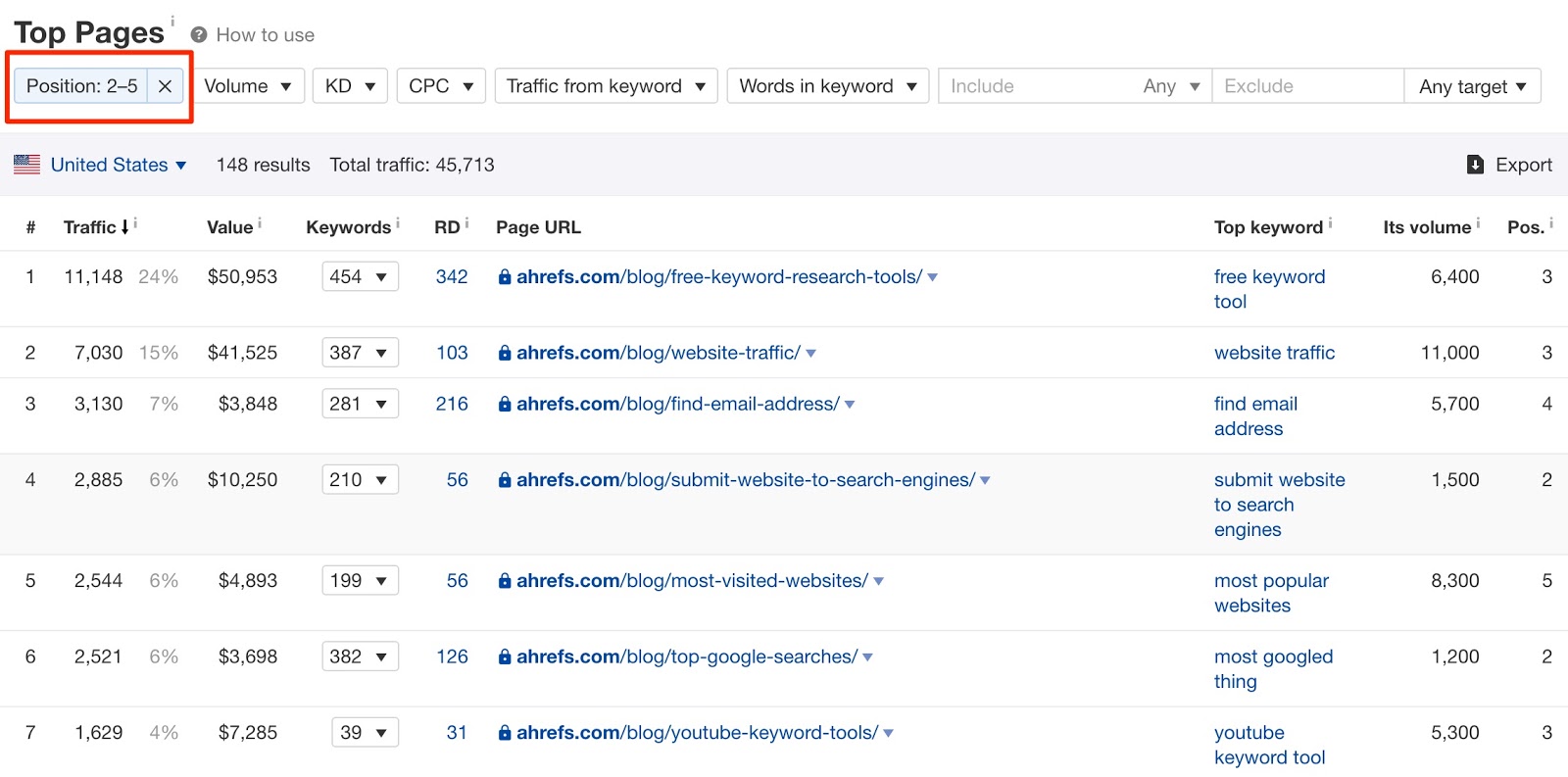

Alternativement, vous pouvez également utiliser Ahrefs ’Site Explorer. Entrez votre domaine, accédez au rapport "Top Pages" et filtrez les positions n ° 2 à n ° 5.

Notez ces pages.

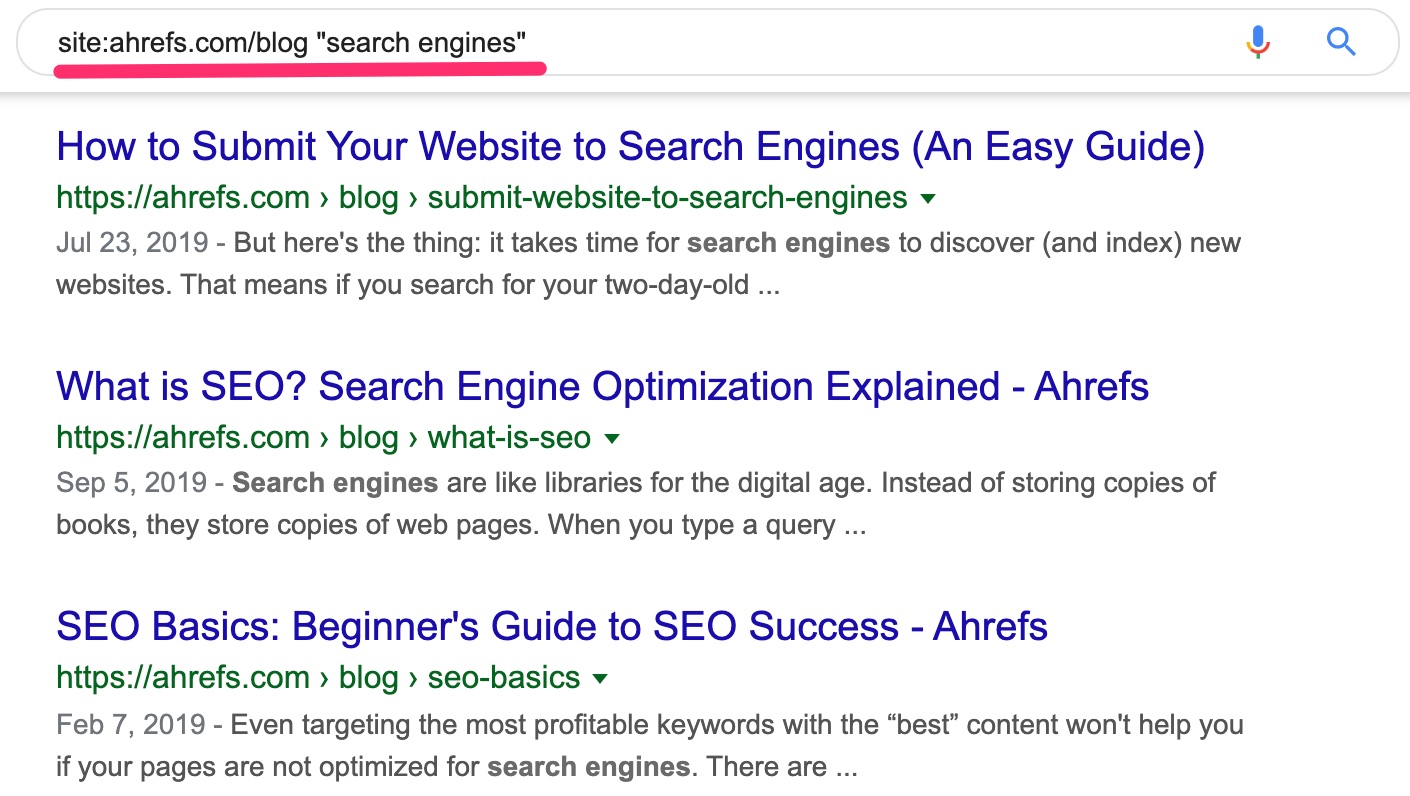

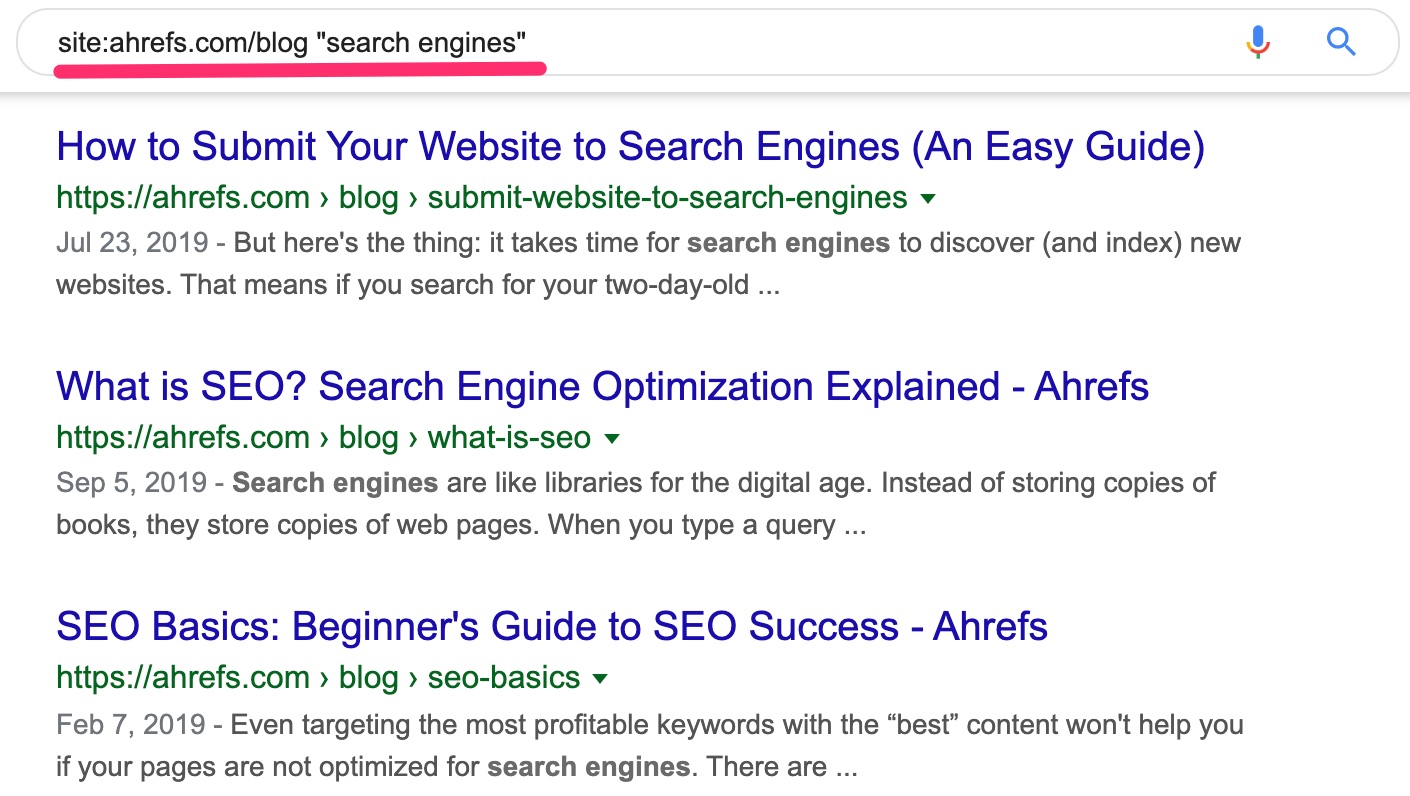

Ensuite, vous aurez besoin de pages pour ajouter des liens internes. Le moyen le plus simple de les trouver est avec le site: opérateur de recherche. Par exemple, si je voulais ajouter des liens internes à notre guide récemment publié sur comment fonctionnent les moteurs de rechercheJe recherche ceci dans Google:

Ensuite, je vais parcourir chacune de ces pages et ajouter des liens internes vers la page cible avec des informations pertinentes. texte d'ancrage. Par exemple, j’ai ajouté un lien interne à partir de “Quel est SEO”Post:

Nous suivons ce processus chaque fois que nous publions un nouveau post sur le blog.

En savoir plus sur liens internes dans notre guide interactif ici.

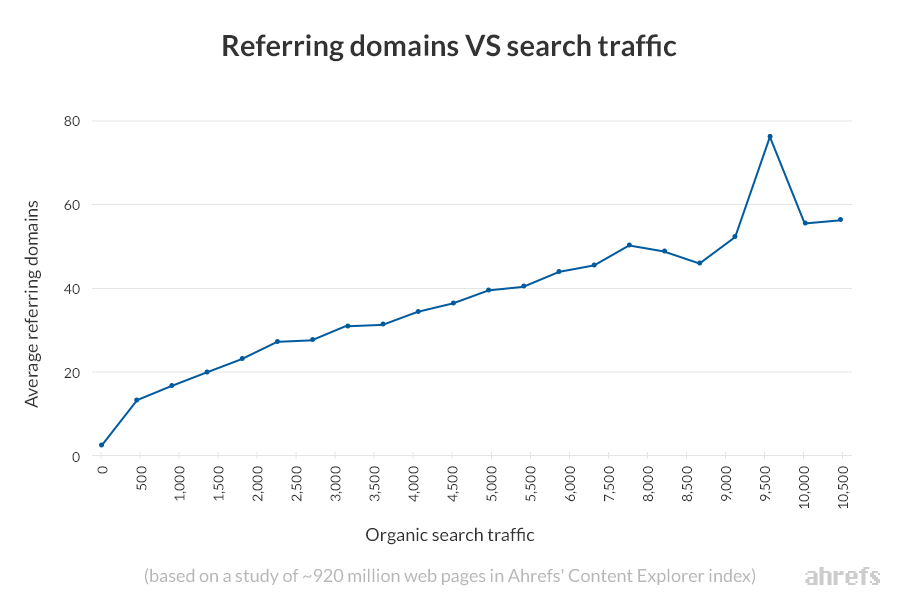

Backlinks sont importants, car ils aident avec les classements. Comment savons nous?

Nous avons étudié les facteurs de classement basés sur les liens à quelques occasions et retrouvent toujours la même chose: le nombre de backlinks provenant de sites Web uniques (domaines de référence) est fortement corrélé au trafic de recherche organique.

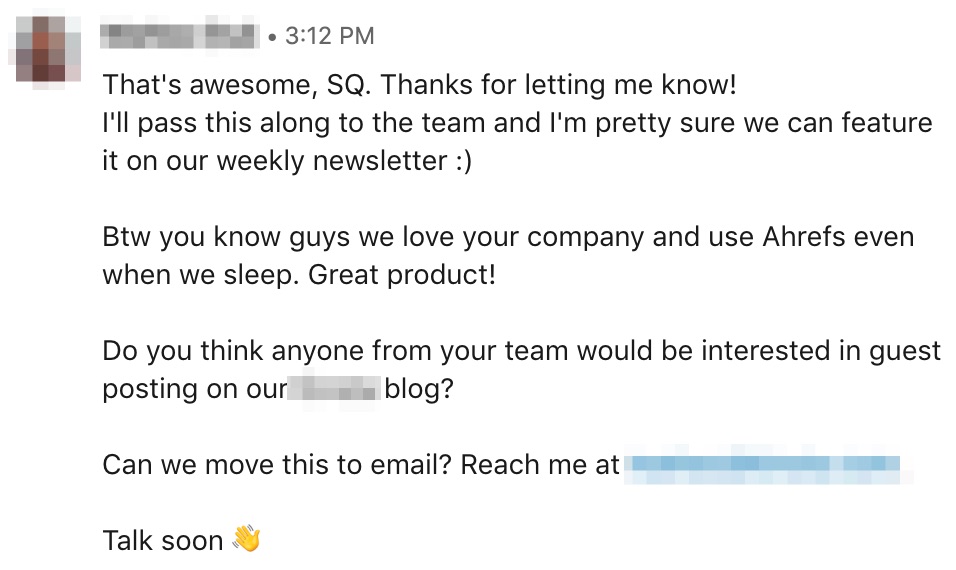

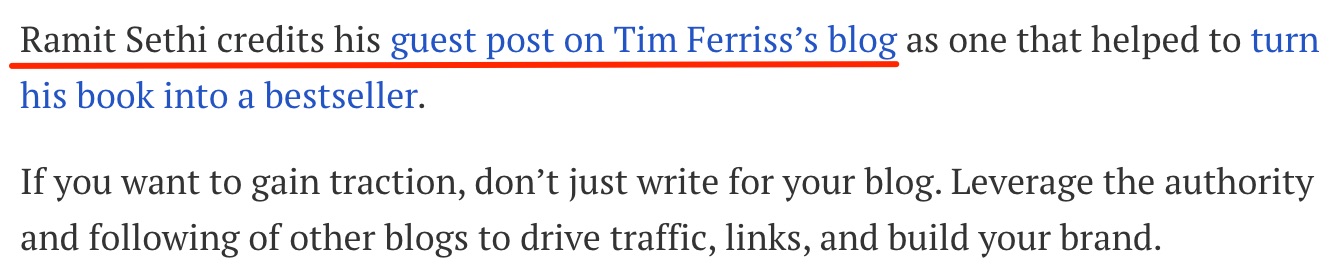

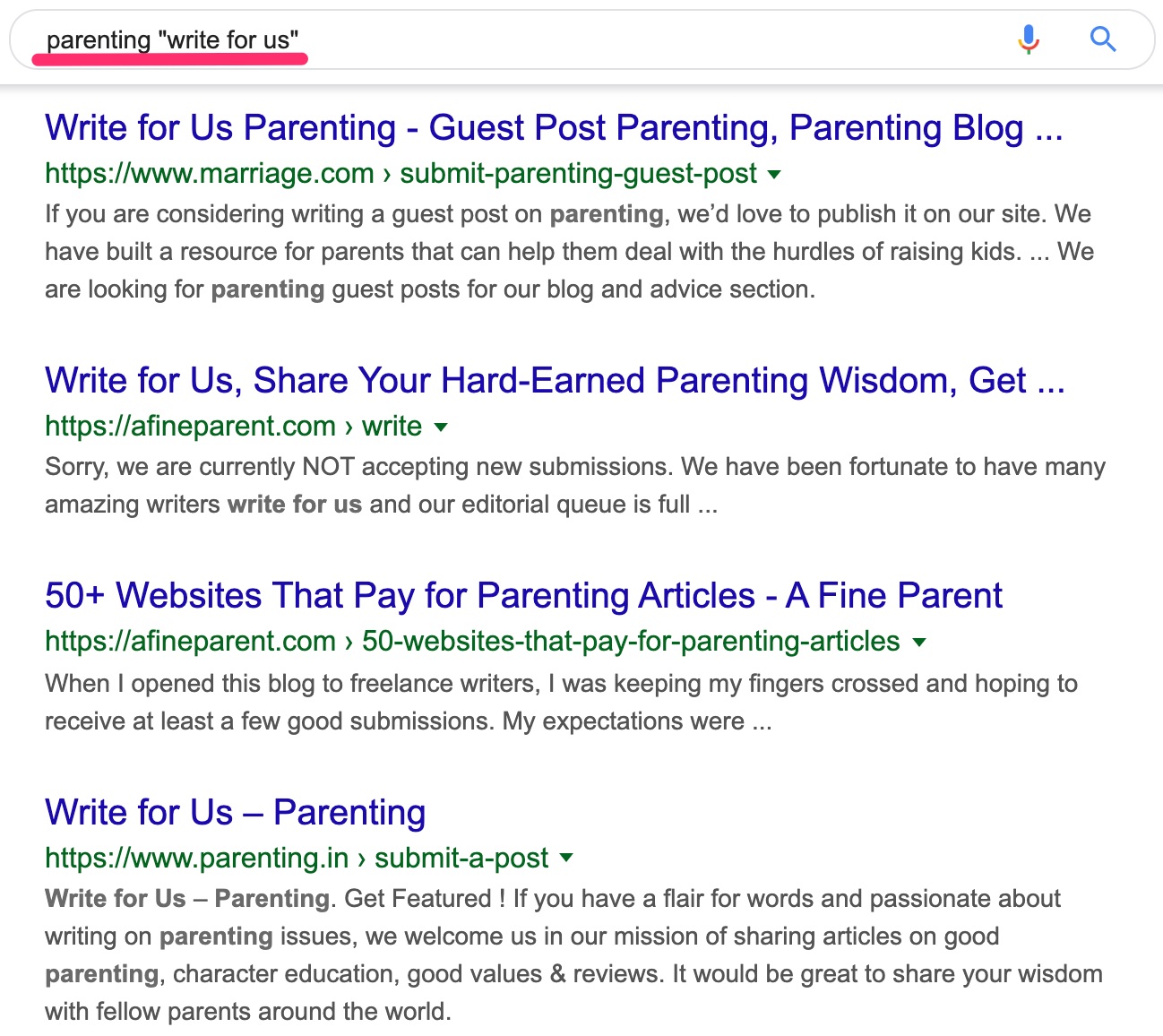

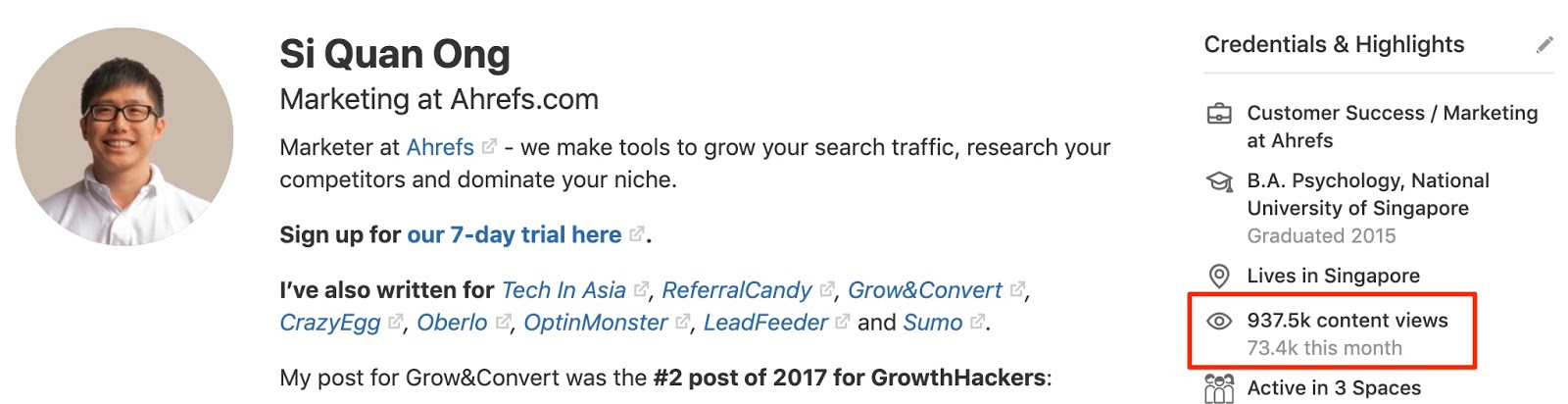

Il y a d'innombrables stratégies de renforcement des liens, mais nous en avons utilisé un bon nombre, c’est le blogage invité:

Lorsque vous écrivez un excellent contenu pour un autre blog, vous avez généralement beaucoup d'occasions de faire un lien vers vos propres articles.

Maintenant, la plupart des gens trouvent des opportunités de blogging en utilisant des opérateurs de recherche avancés comme ceux-ci sur Google:

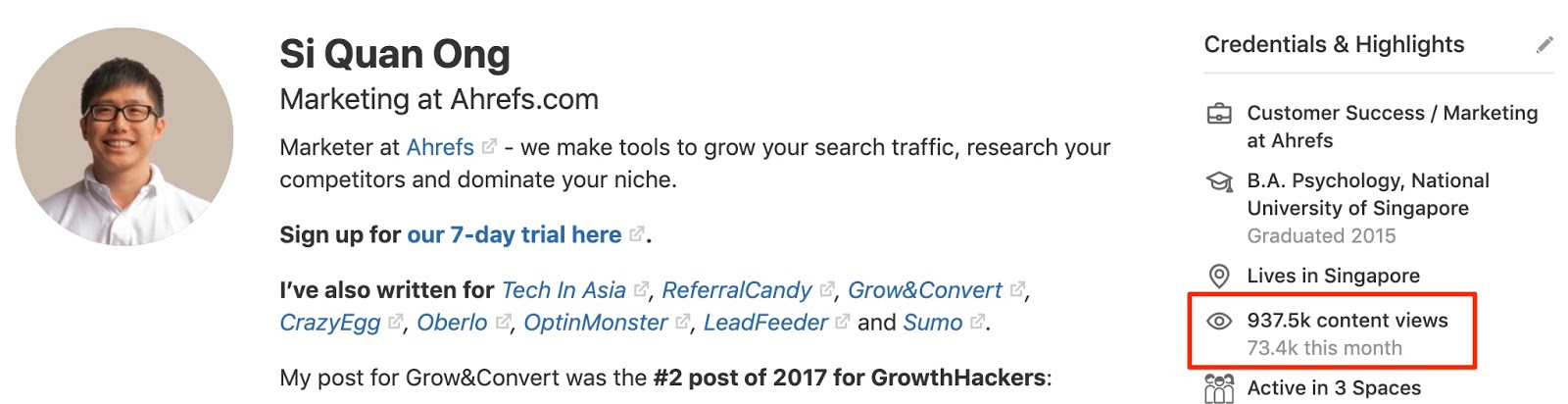

[your_topic] "Écris pour nous"[your_topic] "Poste d'invité"[your_topic] "Article invité"[your_topic] “Devenir un auteur”[your_topic] inurl: contribuer